Hallo zusammen,

ich habe bisher HD Tune Pro genutzt, um den (pseudo) SLC Cache zu bestimmen - via File Benchmark Tab. Allerdings hat HD Tune Pro wohl einen Bug: wenn ich größere MB Werte einstelle (z.B. 500000), die geschrieben werden sollen, erhalte ich die FM "I/O Error - Test aborted". Verringere ich die Werte klappt es irgendwann - vielleicht läuft da eine Variable über?

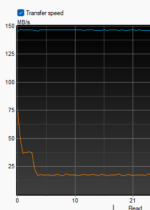

Das Tool ist auch lange nicht mehr gepflegt und daher muss man wohl damit leben. An sich fand ich es aber super, wie es eine schöne Kurve dastellt - so konnte man genau sehen, "wann ein Einbruch" kommt welcher meistens für den pSLC Anteil steht.

Jetzt suche ich eine Alternative, die ebenfalls so eine Schreibkurve darstellt (und eben keine Balken). Oder sonst klar sichtbar auf einen Blick ermittelt, wie groß der pSLC ist.

SSDSlowMark scheint das zu können, sieht aber irgendwie konfus aus und ist Java... würde ich gerne vermeiden, da mein System sonst Java frei ist. Ja, Java ist eine tolle Sprache aber die JRE strotzt nur so vor Sicherheitslücken, die teilweise länger nicht gefixt werden. Aber das ist OT.

Bin gespannt ob es da was gibt. Danke schonmal und einen Guten Rutsch!

UP

PS: falls jemand weiß, wie man das in HD Tune fixt - sehr gerne! Bei meiner Suche bin ich aber nur auf "Bug HD Tune" oder defekte Medien gestoßen...

ich habe bisher HD Tune Pro genutzt, um den (pseudo) SLC Cache zu bestimmen - via File Benchmark Tab. Allerdings hat HD Tune Pro wohl einen Bug: wenn ich größere MB Werte einstelle (z.B. 500000), die geschrieben werden sollen, erhalte ich die FM "I/O Error - Test aborted". Verringere ich die Werte klappt es irgendwann - vielleicht läuft da eine Variable über?

Das Tool ist auch lange nicht mehr gepflegt und daher muss man wohl damit leben. An sich fand ich es aber super, wie es eine schöne Kurve dastellt - so konnte man genau sehen, "wann ein Einbruch" kommt welcher meistens für den pSLC Anteil steht.

Jetzt suche ich eine Alternative, die ebenfalls so eine Schreibkurve darstellt (und eben keine Balken). Oder sonst klar sichtbar auf einen Blick ermittelt, wie groß der pSLC ist.

SSDSlowMark scheint das zu können, sieht aber irgendwie konfus aus und ist Java... würde ich gerne vermeiden, da mein System sonst Java frei ist. Ja, Java ist eine tolle Sprache aber die JRE strotzt nur so vor Sicherheitslücken, die teilweise länger nicht gefixt werden. Aber das ist OT.

Bin gespannt ob es da was gibt. Danke schonmal und einen Guten Rutsch!

UP

PS: falls jemand weiß, wie man das in HD Tune fixt - sehr gerne! Bei meiner Suche bin ich aber nur auf "Bug HD Tune" oder defekte Medien gestoßen...