h00bi

Fleet Admiral

- Registriert

- Aug. 2006

- Beiträge

- 24.239

Hallo zusammen,

habe eine W10 22H2 VM auf Nutanix AHV am laufen.

Früher mit 2 vCPUs, jetzt erhöht auf 4 vCPUs wegen höherem Lesitungsbedarf.

VM runtergefahren, vCPUs erhöht, VM hochgefahren.

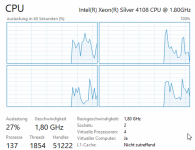

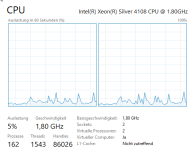

Der Taskmanager zeigt aber weiterhin nur 2 vCPUs/Logische Prozessoren an.

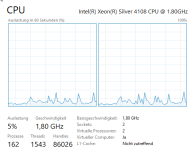

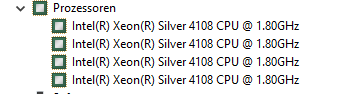

Der Gerätemanager listet aber korrekt 4 "Prozessoren"

an der msconfig wurde nicht gefummelt, sie würde aber ebenfalls nur ein 2er Limit anbieten.

VM wurde mehrfach neu gestartet, keine Änderung.

Wie kann ich W10 erklären, dass es gefälligst die Cores nochmal durchzählt?

habe eine W10 22H2 VM auf Nutanix AHV am laufen.

Früher mit 2 vCPUs, jetzt erhöht auf 4 vCPUs wegen höherem Lesitungsbedarf.

VM runtergefahren, vCPUs erhöht, VM hochgefahren.

Der Taskmanager zeigt aber weiterhin nur 2 vCPUs/Logische Prozessoren an.

Der Gerätemanager listet aber korrekt 4 "Prozessoren"

an der msconfig wurde nicht gefummelt, sie würde aber ebenfalls nur ein 2er Limit anbieten.

VM wurde mehrfach neu gestartet, keine Änderung.

Wie kann ich W10 erklären, dass es gefälligst die Cores nochmal durchzählt?