- Registriert

- Mai 2009

- Beiträge

- 3.766

@BeBur Der Tweet hat in der Szene für große Diskussionen gesorgt und wurde von Tamay Besiroglu untermauert.

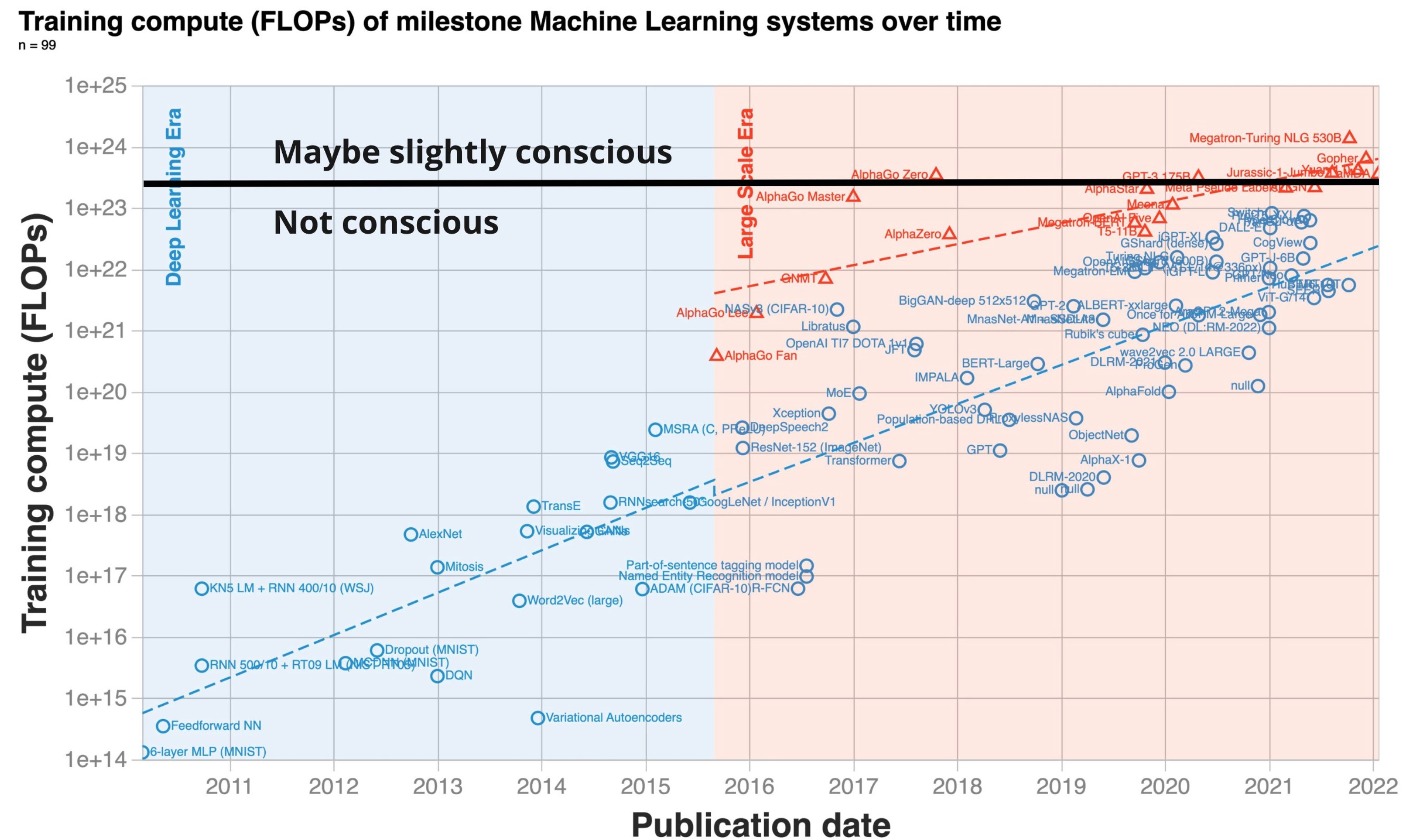

Seit dem Aufkommen von Deep Learning in den frühen 2010er Jahren hat sich die Skalierung der Trainingsberechnung beschleunigt und verdoppelt sich etwa alle 6 Monate. Vorher bis 2010 wuchs die Rechenleistung für das Training im Einklang mit dem Mooreschen Gesetz und verdoppelte sich etwa alle 20 Monate.

https://arxiv.org/pdf/2202.05924v1.pdf

Seit dem Aufkommen von Deep Learning in den frühen 2010er Jahren hat sich die Skalierung der Trainingsberechnung beschleunigt und verdoppelt sich etwa alle 6 Monate. Vorher bis 2010 wuchs die Rechenleistung für das Training im Einklang mit dem Mooreschen Gesetz und verdoppelte sich etwa alle 20 Monate.

https://arxiv.org/pdf/2202.05924v1.pdf