Der Host Memory Buffer ist ein paar MB groß.Yosup schrieb:Ich hätte keinen Bock, dass die SSD über HBM mal eben 1 oder 2 GB von meinen 16 GB RAM abknappst.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

News WD Blue SN580 SSD: Nachfolger der beliebten SN570 wechselt auf PCIe 4.0

- Ersteller MichaG

- Erstellt am

- Zur News: WD Blue SN580 SSD: Nachfolger der beliebten SN570 wechselt auf PCIe 4.0

Yosup

Lt. Junior Grade

- Registriert

- Nov. 2022

- Beiträge

- 346

Vielleicht, wenn die SSD noch jungfräulich und die Tabelle entsprechend klein ist.TomH22 schrieb:Der Host Memory Buffer ist ein paar MB groß.

Der DRAM auf SSDs ist typischerweise 1 GB pro 1 TB Flash gross. Und mit diesem WorstCase ist zu rechnen.

Wenn ein paar MB HMB reichen würden, dann könnte man auch gleich ein paar MB DRAM nehmen, das wäre dann auch kein Kostenfaktor mehr.

Der HMB hat eine fixe Größe, der wird nicht dynamisch vergrößert. Er hat auch nicht exakt die gleichen Aufgaben wie der DRAM Cache. SSDs mit DRAM Cache sind auch definitiv leistungsfähiger als welche ohne, allerdings nicht nur wegen des Caches, sondern oft auch weil sie generell leistungsfähiger sind.Yosup schrieb:Wenn ein paar MB HMB reichen würden, dann könnte man auch gleich ein paar MB DRAM nehmen, das wäre dann auch kein Kostenfaktor mehr.

Nur sind diese Leistungsunterschiede in vielen Szenarien für den Benutzer nicht spürbar.

Die Kosten für den DRAM Cache entstehen nicht nur wegen des DRAM Chips, sondern auch weil der Controller und das PCB aufwändiger sind. Controller Hersteller lassen sich das Feature auch bezahlen.

“Ein paar MB DRAM“ geht schon deswegen nicht, da es entsprechend kleine DRAMs mit DDR Interface garnicht gibt. Die kleinsten gängigen Chips haben 256Mbyte. Üblicherweise sind die übrigens 16 Bit breit, bei immer schnelleren SSDs muss man mehrere Chips parallel einsetzen, damit das DRAM nicht zur Bremse wird. Das treibt die oben genannten Kosten weiter in die Höhe. Daher wage ich zu behaupten, dass DRAM Cache immer weiter in das obere Preissegment wandert, und aus dem OEM Bereich ganz verschwindet.

Macht auch keine SSD. HMB genehmigt sich Speicher ist im niedrigen MB Bereich, ein typsicher Wert ist z.B. 64 MB.Yosup schrieb:Ich hätte keinen Bock, dass die SSD über HBM mal eben 1 oder 2 GB von meinen 16 GB RAM abknappst.

Yosup

Lt. Junior Grade

- Registriert

- Nov. 2022

- Beiträge

- 346

Ich nahm - anscheinend fälschlicherweise - an, dass HMB den DRAM ersetzt. Oft war auch zu lesen, dass "seit HMB ist das DRAM-Thema obsolet!", was das ja suggeriert. Aber das stimmt ja anscheinend nicht, denn dann müsste der HMB ja zumindest in ähnlichen Grössenordnungen liegen.

Für mich gerade irgendwie noch mehr ein Argument pro DRAM.

Für mich gerade irgendwie noch mehr ein Argument pro DRAM.

Es gibt verschiedene Möglichkeiten den Flash Translation Layer zu realisieren. Es ist durchaus möglich, dass eine Implementierung mit dem HMB mit viel weniger Speicher annähernd die gleiche Leistung bringt, wie eine andere mit einem großen DRAM Cache. Heutige SSDs simulieren für das Betriebssystem eine HDD mit LBA. D.h. der Datenträger besteht aus einer großen Anzahl an kleinen Blöcken, die beliebig adressierbar sind und wahlfrei gelesen und geschrieben werden können.

Flash Speicher funktioniert aber nicht so, daher gibt es den FTL. Dieser benötigt unter anderem eine Mapping Tabelle, um die LBA Blöcke auf tatsächliche Flash-Blöcke zu mappen. Diese Tabelle ist recht groß, und wird bei entsprechenden SSDs im DRAM Cache gehalten.

Jetzt ist es aber so, dass bei den meisten Workloads immer nur ein sehr kleiner Teil der Mapping Tabelle aktiv genutzt wird. HMB macht sich das zu nutze, und hält nur diesen kleinen Teil im RAM.

WD hat ein ganz gutes Whitepaper, dass dies erklärt. Und sie sagen auch ganz klar, dass SSDs mit DRAM schon leistungsfähiger sind, aber dieser Unterschied bei vielen Anwendungsfällen nicht zum tragen kommt.

Aus meiner persönlichen Erfahrung kann ich das bestätigen. Ich habe beide SSD Typen im Einsatz, teilweise im selben Rechner. Spürbare Unterschiede gibt es nicht, und selbst messbar gibt es kein einheitliches Bild.

Da bei SSDs die größeren Modelle einer Serie oft schneller sind, als die kleineren, macht es bei gegebenen Budget unter Umständen mehr Sinn, eher in die Kapazität als eine „höherwertige“ SSD mit DRAM Cache zu investieren.

Flash Speicher funktioniert aber nicht so, daher gibt es den FTL. Dieser benötigt unter anderem eine Mapping Tabelle, um die LBA Blöcke auf tatsächliche Flash-Blöcke zu mappen. Diese Tabelle ist recht groß, und wird bei entsprechenden SSDs im DRAM Cache gehalten.

Jetzt ist es aber so, dass bei den meisten Workloads immer nur ein sehr kleiner Teil der Mapping Tabelle aktiv genutzt wird. HMB macht sich das zu nutze, und hält nur diesen kleinen Teil im RAM.

WD hat ein ganz gutes Whitepaper, dass dies erklärt. Und sie sagen auch ganz klar, dass SSDs mit DRAM schon leistungsfähiger sind, aber dieser Unterschied bei vielen Anwendungsfällen nicht zum tragen kommt.

Aus meiner persönlichen Erfahrung kann ich das bestätigen. Ich habe beide SSD Typen im Einsatz, teilweise im selben Rechner. Spürbare Unterschiede gibt es nicht, und selbst messbar gibt es kein einheitliches Bild.

Da bei SSDs die größeren Modelle einer Serie oft schneller sind, als die kleineren, macht es bei gegebenen Budget unter Umständen mehr Sinn, eher in die Kapazität als eine „höherwertige“ SSD mit DRAM Cache zu investieren.

Yosup

Lt. Junior Grade

- Registriert

- Nov. 2022

- Beiträge

- 346

Ok, da Du offensichtlich mehr Ahnung und Erfahrung damit hast habe ich folgende drei Fragen:

Wie verwendet eine SSD mit eigenem DRAM diesen? Irgend einen Mehrwert müssen die Hersteller ja darin sehen, beispielsweise die 4TB-Version dann mit einem 4GB-DRAM auszustatten und nicht die ganze Serie von 1 bis 4 TB mit bspw. einem 1-GB-DRAM auszustatten (was ja immernoch grosszügig dimensioniert wäre, wenn man es mit 64 MB HMB vergleicht.) Ist das dann wirklich Cache für die Nutzdaten oder doch für die Verwaltung vorgesehen?

Wie wirkt sich die Umstellung auf von 512B-Blöcken auf 4096B-Blöcke, die manche NVMe-SSDs ja bieten, aus? Vor allem mit Hinblick auf das Mapping?

HMB steht nicht garantiert zur Verfügung, bspw in externen USB-Gehäusen. Für wie nachteilig erachtest Du das?

Wie verwendet eine SSD mit eigenem DRAM diesen? Irgend einen Mehrwert müssen die Hersteller ja darin sehen, beispielsweise die 4TB-Version dann mit einem 4GB-DRAM auszustatten und nicht die ganze Serie von 1 bis 4 TB mit bspw. einem 1-GB-DRAM auszustatten (was ja immernoch grosszügig dimensioniert wäre, wenn man es mit 64 MB HMB vergleicht.) Ist das dann wirklich Cache für die Nutzdaten oder doch für die Verwaltung vorgesehen?

Wie wirkt sich die Umstellung auf von 512B-Blöcken auf 4096B-Blöcke, die manche NVMe-SSDs ja bieten, aus? Vor allem mit Hinblick auf das Mapping?

HMB steht nicht garantiert zur Verfügung, bspw in externen USB-Gehäusen. Für wie nachteilig erachtest Du das?

Deinorius

Commander

- Registriert

- Juni 2005

- Beiträge

- 2.326

Nun, das beste Argument gegen SSDs ohne DRAM ist ja immer noch der Preis. Ich bin immer noch dagegen diese Varianten gleich von Anfang an zu verdammen, aber da der Unterschied nur bei ein paar € liegt, bin ich selber auch wenig geneigt, die günstigere zu kaufen. Und vor dem Preissturz war das auch nicht allzu viel anders.

Ähnlich gilt das erst recht bei SSDs mit QLC NAND.

Ähnlich gilt das erst recht bei SSDs mit QLC NAND.

Zuletzt bearbeitet:

Das kann Dir letztendlich nur der Hersteller sagen, die Firmware ist ja nicht open source, etc.Yosup schrieb:Wie verwendet eine SSD mit eigenem DRAM diesen?

Man kann natürlich nach White Papern und Presentation von Herstellern suchen. manche Websites wie Toms Hardware oder in der Vergangenheit Anandtech haben manchmal Insider Infos, die sie in Testberichten veröffentlichen.

Auch dafür kann es verschiedene Gründe geben. Ein Grund könnte sein, das ja NAND Flash auch immer schneller wird, vor allem die Interfaces. Wie ich schon schrieb, sind die DRAM Chips meist nur 16 Bit breit. Mit einem Chip könnte es sein, dass das DRAM zu langsam ist und am Ende bremst. Aber das ist wirklich Spekulation meinerseits. In jedem Fall ist das DRAM des Hosts deutlich schneller als die internen RAMs auf der SSD.Yosup schrieb:Irgend einen Mehrwert müssen die Hersteller ja darin sehen, beispielsweise die 4TB-Version dann mit einem 4GB-DRAM auszustatten und nicht die ganze Serie von 1 bis 4 TB mit bspw. einem 1-GB-DRAM auszustatten

Größere Blöcke bedeuten in jedem Fall kleinere Mapping Tabelle. Ob das wirklich Auswirkungen hat, ist eine andere Frage. In jedem Fall bedeuten größere Blöcke immer weniger Verwaltungsoverhead im Verhältnis zu den Nutzdaten.Yosup schrieb:Wie wirkt sich die Umstellung auf von 512B-Blöcken auf 4096B-Blöcke, die manche NVMe-SSDs ja bieten, aus? Vor allem mit Hinblick auf das Mapping?

Aber auch 4096 Bytes sind „klein“ im Verhältnis zu den Blöcken des Flash Speichers. Man muss dabei immer zwischen Erase Blocks und Write Blocks unterscheiden. Flash Speicher wird immer in zwei Schritten beschrieben: Erst löschen (dabei werden alle Bits auf einen Wert gesetzt, meist 1), dann schreiben.

Löschen ist das, was am meisten Zeit kostet, und auch das was den Speicher abnutzt. Außerdem geht es nur in recht großen Einheiten, z.B. 64 oder 256Kbyte.

Das auf die LBA Logik umzusetzen ist recht aufwändig. Langfristig wäre die bessere Lösung neue Filesysteme, die direkt für Flash ausgelegt sind, und der Verzicht auf den FTL. Bei Mobilgeräten mit eMMC Speicher wird das teilweise schon gemacht.

Ergänzung ()

Bei SSDs im 50 EUR Bereich ist das logisch. Eine SSD, die 50 EUR inkl. Mwst für den Endverbraucher kostet, hat Materialkosten von höchstens 10 bis 15 EUR - eher weniger. D.h. eine Veränderung der Materialkosten um 50% hat für den Endkunden bestenfalls einen Effekt von 10% - falls der Hersteller sie zu 100% weitergibt, was er sicher nicht tut.Deinorius schrieb:aber der Unterschied nur bei ein paar € liegt, bin ich selber auch wenig geneigt, die günstigere zu kaufen. Und vor dem Preissturz war das auch nicht allzu viel anders.

Ähnlich gilt das erst recht bei SSDs mit QLC NAND.

Das es zur Zeit noch 1TB SSDs mit DRAM gibt, liegt vermutlich nur an Überproduktion aus der Vergangenheit. Es macht eigentlich überhaupt keinen Sinn für die Hersteller in dieser Preisklasse SSDs mit DRAM anzubieten.

Ich glaube wir werden das demnächst nur noch bei Premium SSDs sehen, wie z.B der neuen Seagate Firecuda 540

https://www.computerbase.de/2023-06/firecuda-540-haendler-verraten-seagates-erste-pcie-5-0-ssd/

wo dann eben die 1TB wieder deutlich über 100 EUR kosten wird.

Bei QLC ist es ähnlich, bei Größen < 4TB hilft es nur dem Hersteller Geld zu sparen, das davon was beim Endkunden ankommt, klappt nur bei Größen wo der Flash Speicher ein relevanter Teil der Kosten ist.

Im übrigen ist QLC kein Problem, wenn der TLC Cache groß genug ist.

Zuletzt bearbeitet:

Deinorius

Commander

- Registriert

- Juni 2005

- Beiträge

- 2.326

Kann nur zustimmen. So lange die Preise nicht wieder exorbitant nach oben gehen (wer weiß schon...), wird sich das definitiv stärker differenzieren. Dann wird sich auch weisen, wie lange man noch PCIe 3.0 SSDs anbieten wird, oder ob QLC überhaupt Sinn machen, wenn die Layer mit TLC weiter ansteigen.

Wobei ich z.B. gerade in einem NAS kein Problem mit großen QLC-SSD ohne DRAM Cache hätte, so lange der Preis stimmt.

Wobei ich z.B. gerade in einem NAS kein Problem mit großen QLC-SSD ohne DRAM Cache hätte, so lange der Preis stimmt.

Araska

Lt. Commander

- Registriert

- März 2023

- Beiträge

- 1.148

TomH22 schrieb:Im übrigen ist QLC kein Problem, wenn der TLC Cache groß genug ist.

TLC-Cache? Oder meintest du den Pseudo-SLC-Cache?

...wobei ich eigentlich TLC-SSDs bevorzuge, schon allein der Haltbarkeit wegen.

Am Besten sind TLC-SSDs, die keinen Pseudo-SLC-Cache nötig haben... aber leider geht das mit M.2 aus Platzgründen nicht.

Die sind schon tot, das sind nur noch Abverkäufe. Die Hersteller können nun mit PCIe 4.0 werben, vermutlich kosten die Controller das gleiche wie ihre 3.0 Vorgänger.Deinorius schrieb:Dann wird sich auch weisen, wie lange man noch PCIe 3.0 SSDs anbieten wird,

Die aktuelle Generation der Flash Chips kann man mit SLC, TLC und QLC beschreiben. Vermutlich wird es in Zukunft eine reine Firmware Konfiguration sein, ob die gleiche Hardware als QLC oder TLC läuft, mit entsprechend unterschiedlicher Kapazität.Araska schrieb:TLC-Cache? Oder meintest du den Pseudo-SLC-Cache?

Yosup

Lt. Junior Grade

- Registriert

- Nov. 2022

- Beiträge

- 346

Erstmal Danke für die Antworten, Tom. Zu DRAM-less@USB hast Du keine Erfahrungen?

Abschliessend - ich geb es ja zu, dass ich wohl zu denen gehöre die für ne gute SSD gern ein wenig mehr hinlegen. Sicherlich habe ich dadurch nicht die ökonomischsten SSDs verbaut.

Für manche scheint es ja auch vertretbar zu sein, einfach mal 1800€ für ne neue Graka hinzulegen, da kann ich mir auch mal für 180€ ne 2TB-SSD der Spitzenklasse gönnen und dann eben auch Wert auf TLC, DRAM und Endurance legen... es fühlt sich für mich einfach richtig so an.

Abschliessend - ich geb es ja zu, dass ich wohl zu denen gehöre die für ne gute SSD gern ein wenig mehr hinlegen. Sicherlich habe ich dadurch nicht die ökonomischsten SSDs verbaut.

Für manche scheint es ja auch vertretbar zu sein, einfach mal 1800€ für ne neue Graka hinzulegen, da kann ich mir auch mal für 180€ ne 2TB-SSD der Spitzenklasse gönnen und dann eben auch Wert auf TLC, DRAM und Endurance legen... es fühlt sich für mich einfach richtig so an.

Sorry ich hatte da vergessen zu antworten. Nein habe ich nicht. Bei USB geht aber sowieso sehr viel Leistung verloren, die USB nach NVMe Wandler Chips sind vor allem preisoptimiert. Auch mit UASP Support wird USB bei IOPS, etc. nicht an natives NVMe heranreichen. Generell hat der DRAM Cache eher Einfluss auf random Zugriffe wie auf sequentielles Lesen/Schreiben. Externe SSDs wrrden aber eher für sequentielle Workloads eingesetzt.Yosup schrieb:Zu DRAM-less@USB hast Du keine Erfahrungen?

Ich finde der Selbstbau von USB SSDs aus SATA oder NVMe Teilen lohnt sich heutzutage nur noch begrenzt. Lieber ein fertiges Produkt einsetzen.

Wenn Du Dich damit wohlfühlst, kannst Du das ja machen.Yosup schrieb:Für manche scheint es ja auch vertretbar zu sein, einfach mal 1800€ für ne neue Graka hinzulegen, da kann ich mir auch mal für 180€ ne 2TB-SSD der Spitzenklasse gönnen und dann eben auch Wert auf TLC, DRAM und Endurance legen

Ich habe bisher noch nie eine „Spitzenklasse“ SSD gekauft.

Ich hatte nur 2020 ein interessantes Erlebnis:

Ich habe mir im April 2020 einen PC zusammengebaut, und dort die seinerzeit u.A. von Anandtech gehypte SX8200P eingebaut. Allerdings nur 512GB, damals zu Beginn der Pandemie gab es Lieferengpässe bei den SSDs.

Soweit so gut, die SSD war auch ok, wenn auch bei Benchmarks langsamer als in den Tests.

Im August 2020 erreichte dann die WD SN550 (DRAM less) in 1TB die 100 EUR Marke und ich schlug zu. Ich baute sie in den zweiten mit nur 2 Lanes angebunden M2 Slot meines Mainboards ein. Natürlich war dadurch die Datenrate auf 1400Mbyte/sec nur halb so schnell wie bei der ADATA. Zu meiner Verwunderung war aber die WD in der Praxis bei vielen Operationen spürbar schneller, insbesondere das Suspend/Restore von VM in VMware Workstation ging fast doppelt so schnell.

Jetzt ist vermutlich die SX8200P keine besonders gute SSD, die haben vermutlich das Produkt einfach benchmarkoptimiert. Seitdem sehe ich aber SSD Benchmarks, Testberichte und ähnliches mit kritischem Auge.

Das ist auch der Unterschied zu den Grafikkarten: Die GPU operiert in vielen Fällen wirklich an der Leistungsgrenze und ein paar Milisekunden Verzögerung macht sich sofort in Rucklern bemerkbar. Aber ob das Laden des nächsten Levels nun 9,8 oder 8,5 Sekunden dauert, merkst Du nicht, wenn Du nicht mit der Stoppuhr nachmisst.

Ja, wenn Dein Geld für eine Spitzen Graka und eine Spitzen SSD reicht, dann kauf beides. Hast Du aber ein festes Budget, spar bei der SSD und stecke die Ersparnis woanders rein.

Yosup

Lt. Junior Grade

- Registriert

- Nov. 2022

- Beiträge

- 346

Also, ich hab gar keine GPU, nur iGPU von intel... Daher vielleicht auch das Budget für Oberklasse-SSDsTomH22 schrieb:Ja, wenn Dein Geld für eine Spitzen Graka und eine Spitzen SSD reicht, dann kauf beides. Hast Du aber ein festes Budget, spar bei der SSD und stecke die Ersparnis woanders rein

Ob ich Deinen obigen Rat aber so unterschreiben würde weiss ich nicht.

50 € machen bei einer SSD oft den Unterschied zwischen Einsteiger- und Oberklasse, während man bei Grakas, CPUs und mittlerweile auch Mainboards gleich ganz andere Summen für einen "Klassenaufstieg" hinlegen muss. Dabei sind gerade das Komponenten, die man nicht ganz so lange nutzt wie eine gute SSD.

Zur USB Thematik: Ja, USB wird natürlich nie so schnell wie PCIe/NVMe sein, mir ging es bei der Frage eher darum, ob DRAM-lose Designs dann im USB-Gehäuse vor echte Probleme gestellt werden, vielleicht, weil die Firmware dann abspackt, wenn sie weder DRAM noch HMB vorfindet.

Deinorius

Commander

- Registriert

- Juni 2005

- Beiträge

- 2.326

SATA kann man grundsätzlich vergessen.TomH22 schrieb:Ich finde der Selbstbau von USB SSDs aus SATA oder NVMe Teilen lohnt sich heutzutage nur noch begrenzt. Lieber ein fertiges Produkt einsetzen.

Aber der Selbtbau ist nicht so sinnlos, wie man denken mag. Wenn ich mir die Preise ansehe, ist der Unterschied kaum da. Da wäre man mit Selbstbau sogar besser dran, weil man besser weiß, was für eine SSD man bekommt. Leistungsdaten bei fertigen ext.SSDs sind sehr rar. Mehr als 1 GB/s braucht man eh nicht erwarten, außer man nimmt die SanDisk Extreme Pro oder wirklich schnelle ext. Gehäuse. Aber mit der Selbstbau Methode könnte man flexibler sein.

Dafür gefällt mir die sehr kompakte Bauweise der Samsung T7 oder SanDisk Portable. Ich sehe auf beiden Seiten Vor- und Nachteile.

- Registriert

- Juli 2010

- Beiträge

- 12.935

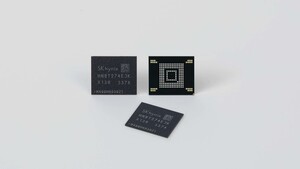

Artikel-Update: Jetzt startet die WD Blue SN580 offiziell

Western Digital stellt die WD Blue SN580 mit PCIe 4.0 jetzt offiziell vor. Gegenüber der SN570 steigt der maximale Durchsatz von 3.500 MB/s auf nun 4.150 MB/s, was einer Steigerung um 19 Prozent entspricht. Die maximalen IOPS beim wahlfreien Lesen/Schreiben steigen auf 600.000/750.000 an. Die Werte gelten für die Modelle mit 1 TB und 2 TB Speichervolumen.

Die Varianten mit 250 GB und 500 GB sind langsamer, da weniger Speicherchips für weniger parallele Zugriffe sorgen. Im direkten Vergleich mit dem Vorgänger legt die 250-GB-Version mit 21 Prozent Plus beim Lesen und 66 Prozent Plus beim Schreiben deutlicher zu. Die genauen Eckdaten je Modell sind der Tabelle am Ende der Meldung zu entnehmen.

Mit BiCS 5 TLC und ohne DRAM

Genaue Angaben zum eingesetzten Controller macht Western Digital keine. Dieser unterstützt aber PCIe 4.0 x4 und NVMe 1.4b. Schreibzugriffe auf den ebenso nicht näher spezifizierten TLC-NAND werden wie üblich durch den SLC-Modus beschleunigt. Hier spricht der Hersteller von „nCache 4.0“. Auf Nachfrage verriet Western Digital aber, dass es sich um 112-Layer-TLC-NAND der Generation BiCS 5 handelt.

Wie bei den Vorgängern WD Blue SN550 und WD Blue SN570 gibt es keinen DRAM-Baustein auf der SSD. Stattdessen kann via NVMe-Funktion Host Memory Buffer (HMB) ein kleiner Teil des System-RAMs als Zwischenspeicher genutzt werden. Im Alltag genügt dies in der Regel um den fehlenden DRAM-Cache zu kaschieren. Enthusiasten werden diesen zwar vermissen, doch handelt es sich um ein Produkt für das Mainstream-Segment und nicht die Oberklasse.

Abgesehen von der Schnittstelle und den Leistungswerten tritt die SN580 exakt in die Fußstapfen der SN570. Im gleichen M.2-2280-Format bleibt auch die Optik nahezu unverändert.

Die Preise stimmen noch nicht

Ob das Leistungsplus einen Aufpreis bedeutet, ist aber noch unklar. Glaubwürdige Preisangaben liegen nämlich noch nicht vor. Dass die SN580 fast durchweg doppelt so teuer wie die SN570 ist, wie es die derzeitigen Angaben im Hersteller-Shop suggerieren, glaubt die Redaktion nämlich nicht. Zwischen 57 Euro (250 GB) und 216 Euro (2 TB) würde Western Digital für die SN580 demnach verlangen. Die SN570 gibt es an gleicher Stelle für 31 Euro (250 GB) bis 103 Euro (2 TB). Die SN580 wäre damit sogar teurer als das Flaggschiff SN850X – dass es sich um einen Fehler handeln muss, liegt daher auf der Hand.

ComputerBase hat Western Digital darauf hingewiesen und wird die richtigen Preise nachreichen, sobald diese vorliegen.

Western Digital stellt die WD Blue SN580 mit PCIe 4.0 jetzt offiziell vor. Gegenüber der SN570 steigt der maximale Durchsatz von 3.500 MB/s auf nun 4.150 MB/s, was einer Steigerung um 19 Prozent entspricht. Die maximalen IOPS beim wahlfreien Lesen/Schreiben steigen auf 600.000/750.000 an. Die Werte gelten für die Modelle mit 1 TB und 2 TB Speichervolumen.

[Tabelle: Zum Betrachten bitte den Artikel aufrufen.]

Die Varianten mit 250 GB und 500 GB sind langsamer, da weniger Speicherchips für weniger parallele Zugriffe sorgen. Im direkten Vergleich mit dem Vorgänger legt die 250-GB-Version mit 21 Prozent Plus beim Lesen und 66 Prozent Plus beim Schreiben deutlicher zu. Die genauen Eckdaten je Modell sind der Tabelle am Ende der Meldung zu entnehmen.

Mit BiCS 5 TLC und ohne DRAM

Genaue Angaben zum eingesetzten Controller macht Western Digital keine. Dieser unterstützt aber PCIe 4.0 x4 und NVMe 1.4b. Schreibzugriffe auf den ebenso nicht näher spezifizierten TLC-NAND werden wie üblich durch den SLC-Modus beschleunigt. Hier spricht der Hersteller von „nCache 4.0“. Auf Nachfrage verriet Western Digital aber, dass es sich um 112-Layer-TLC-NAND der Generation BiCS 5 handelt.

Wie bei den Vorgängern WD Blue SN550 und WD Blue SN570 gibt es keinen DRAM-Baustein auf der SSD. Stattdessen kann via NVMe-Funktion Host Memory Buffer (HMB) ein kleiner Teil des System-RAMs als Zwischenspeicher genutzt werden. Im Alltag genügt dies in der Regel um den fehlenden DRAM-Cache zu kaschieren. Enthusiasten werden diesen zwar vermissen, doch handelt es sich um ein Produkt für das Mainstream-Segment und nicht die Oberklasse.

[Bilder: Zum Betrachten bitte den Artikel aufrufen.]

Abgesehen von der Schnittstelle und den Leistungswerten tritt die SN580 exakt in die Fußstapfen der SN570. Im gleichen M.2-2280-Format bleibt auch die Optik nahezu unverändert.

Die Preise stimmen noch nicht

Ob das Leistungsplus einen Aufpreis bedeutet, ist aber noch unklar. Glaubwürdige Preisangaben liegen nämlich noch nicht vor. Dass die SN580 fast durchweg doppelt so teuer wie die SN570 ist, wie es die derzeitigen Angaben im Hersteller-Shop suggerieren, glaubt die Redaktion nämlich nicht. Zwischen 57 Euro (250 GB) und 216 Euro (2 TB) würde Western Digital für die SN580 demnach verlangen. Die SN570 gibt es an gleicher Stelle für 31 Euro (250 GB) bis 103 Euro (2 TB). Die SN580 wäre damit sogar teurer als das Flaggschiff SN850X – dass es sich um einen Fehler handeln muss, liegt daher auf der Hand.

ComputerBase hat Western Digital darauf hingewiesen und wird die richtigen Preise nachreichen, sobald diese vorliegen.

[Produktdaten: Zum Betrachten bitte den Artikel aufrufen.]

Tenferenzu

Banned

- Registriert

- Okt. 2017

- Beiträge

- 6.473

Jo und wenn dein RAM OC via XMP nicht ganz stabil ist hast du dann auch gleich Fehler auf der Festplatte? (oder halt dein RAM nicht Fehlerfrei läuft?)Miuwa schrieb:Ich dachte der wäre bei M2 SSDs sowieso nicht so relevant wegen Host Memory Dingsi Bumsi (sorry, mir fällt der Name Grad nicht ein).

Ähnliche Themen

- Antworten

- 104

- Aufrufe

- 13.918

- Antworten

- 10

- Aufrufe

- 903

- Antworten

- 6

- Aufrufe

- 770

- Antworten

- 5

- Aufrufe

- 1.017

- Antworten

- 26

- Aufrufe

- 1.776