.Sentinel. schrieb:

Dann dann mal raus mit den Beweisen und Fakten! Und natürlich der offiziellen Stellungnahme von NVIDIA dazu wo sie reumütig zu ihren Missetaten stehen.

die stellungnahme von nvidia gibts natürlich nicht. hier der rest:

https://www.techpowerup.com/105329/hack-released-to-enable-physx-on-windows-7-with-ati-gpu-present

techpowerup artikel über die geknackte nvidia softwaresperre um mit einer radeonkarte wieder eine gtx karte als physX karte nutzen zu können - ging vorher, ging ab treiber xy nicht mehr. ab da nur noch gpu beschleunigtes physx ohne radeon im PC - da gibts wenn überhaupt den software/cpu fallback.

hier noch der fall assassins creed dx 10.1:

https://techreport.com/news/ubisoft-comments-on-assassins-creed-dx10-1-controversy-updated/

https://www.anandtech.com/show/2536/6

anandtech schreibt:

Reading between the lines, it seems clear that NVIDIA and Ubisoft reached some sort of agreement where DirectX 10.1 support was pulled with the patch. ATI obviously can't come out and rip on Ubisoft for this decision, because they need to maintain their business relationship. We on the other hand have no such qualms. Money might not have changed hands directly, but as part of NVIDIA's "The Way It's Meant to Be Played" program, it's a safe bet that NVIDIA wasn't happy about seeing DirectX 10.1 support in the game -- particularly when that support caused ATI's hardware to significantly outperform NVIDIA's hardware in certain situations.

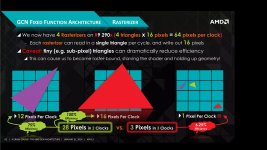

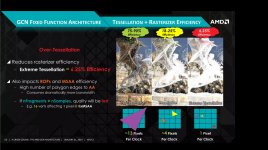

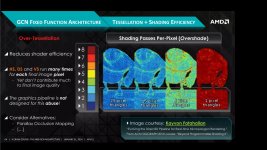

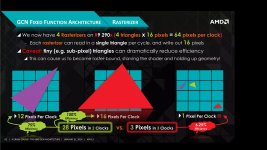

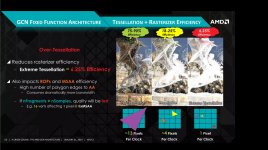

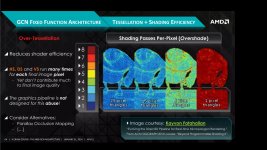

hier ein paper von amd/laylah mah zur GCN architektur - interessant seite 60-63

http://laylamah.com/wp/?page_id=134

TLDR: sub pixel tessellation, also tessellation mit polygonen, die kleiner als ein pixel sind, verstopft bei GCN die render-pipeline, was zu einem extremen leistungseinbruch führt. sub pixel tessellation bringt auch optisch überhauptkeinen nutzen mehr - das ist einfach nur unnötige geometrielast.

hier ein artikel über crysis 2 - teil von nvidias TWIMTBP programm:

https://hothardware.com/news/indept...-shows-highly-questionable-tessellation-usage

hier ein hardwareluxx artikel über tressFX vs hairworks (tessellation, faktor 64 als standard) in witcher 3 vs tombraider:

https://www.hardwareluxx.de/index.p...d-tressfx-und-nvidia-hairworks-im-detail.html

nvidia schreibt über die gtx580:

Für DirectX 11 entwickelt

GeForce GTX 580 liefert massive DirextX 11 Tesselation-Leistung für extrem realistische Spiele mit verblüffend detaillierten Umgebungen und Charakteren.

https://www.nvidia.de/content/EMEAI/newsletters/nov10/DE/corporate-de-09112010.html

die strategie für nvidia ist klar: eigene gpus auf tessellation optimieren und spiele aus partnerprogrammen (gameworks und TWIMTBP) mit tessellation überschwemmen. die gameworks toolbox besteht hauptsächlich aus tessellationsbasierten effekten, bspw. hairworks.

wenn jetzt gleich der einwurf kommt "radeons konnten einfach keine tessellation" kommen jetzt direkt 2 gegenbeispiele:

https://www.pcgameshardware.de/Snip...ecials/Technikanalyse-und-Benchmarks-1127251/

hier schlägt die r9 290X sogar die titan.

und hier das erste spiel mit tessellation überhaupt und die radeons sind vorne:

https://www.tomshardware.com/reviews/aliens-vs-predator-directx-11-benchmark,2606-6.html

alle folgenden titel im gameworks oder TWIMTBP programm werden allerdings auf radeons unterdurchschnittlich laufen, wie bspw. ghost recon wildlands, batman arkham city - alle tessellationsverseucht.

das zieht sich durch wie ein roter faden.

gleichzeitig hat nvidia sich bei EPIC in die unreal engine eingekauft und das ding quasi zur hausengine gemacht. ergebnis heute ist, dass reviewer, bspw. steve von hardware unboxed, bei unreal engine spielen erst einmal grundsätzlich von einer schlechten radeon performance ausgeht, was in 9 von 10 fällen dann auch so eintritt. es gibt spiele in der unreal engine, die auf radeons auch gut laufen, aber in der regel ist unreal engine pro nvidia - wo das herkommt, kann sich ja jeder selber denken.

hier noch ne präsentation von nvidia aus 2011 zur unreal engine kooperation mit EPIC - das wort "tessellation" fällt hier das erste mal direkt in der ersten zeile der ersten liste auf seite 2.

https://www.nvidia.com/content/pdf/gdc2011/gdc2011epicnvidiacomposite.pdf

mit turing bringt nvidia aus dem nichts das thema raytracing auf den tisch und richtet ab da die eigenen gpus strikt auf raytracing aus, inkl. dedizierter hardwareeinheiten speziell für raytracing und pusht auf softwareseite rt-core/cuda beschleunigtes raytracing und AI. wo haben wir dedizierte hardwareeinheiten für eine spezielle rendertechnik schon mal gesehen? achja stimmt, bei der gtx580 mit extra einheiten für die tessellation.