GerryB

Rear Admiral

- Registriert

- Sep. 2016

- Beiträge

- 5.139

Drop: 300x 6900XT, 95x 6800XT, 75x 6800XT Midnight Black, 250x 6800, 300x 6700XT

Manchmal besser, wenn man sich net auf eine Marke festlegt und halt auch bei der Anderen schaut.

btw.

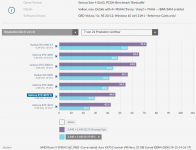

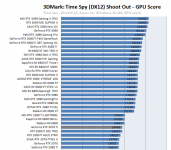

Und mal ein Blick auf UWQHD-RT=off hilft auch bei der Entscheidung.

(ist mir realistischer als 4k, wo zu sehr das PL+Vram reinfunkt)

Manchmal besser, wenn man sich net auf eine Marke festlegt und halt auch bei der Anderen schaut.

btw.

Und mal ein Blick auf UWQHD-RT=off hilft auch bei der Entscheidung.

(ist mir realistischer als 4k, wo zu sehr das PL+Vram reinfunkt)

Anhänge

Zuletzt bearbeitet: