Wer das nicht alles lesen will: Ja, die Grafikkarte ist nicht stark genug. Aber das geht in Ordnung.

R1c3 schrieb:

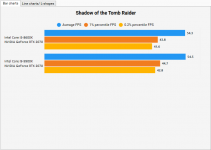

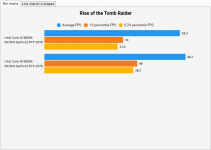

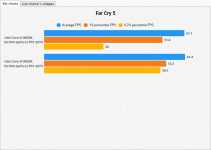

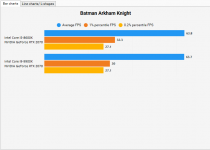

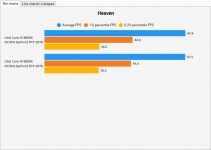

Naja sie ist schwach genug dass du quasi permanent im GPU Limit hängst und nur Far Cry 5 von deutlich besseren min. FPS profitiert. Ist ja an sich auch erstmal kein Drama, irgendwas muss sowieso immer limitieren, aber du darfst halt keine große Leistungssteigerung von der neuen CPU erwarten wenn die Graka bereits vorher der limitierende Faktor war.

Gut beobachtet mit FC5. Das ist allerdings ein einzelner und so großer Ausreißer, dass ich Fremdeinfluss beim Messen nicht ausschließe. Hab auch nur je einen Run gemacht, so was ist immer fehleranfällig.

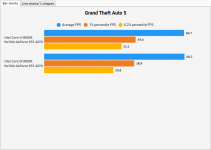

Von "großer Leistungssteigerung" war nicht die Rede. Ich dachte, ich gewinne ein, zwei FPS und etwas mehr bei den Perzentilen. Ansatzweise ist das ja auch zu sehen, nur nicht durchgängig. Wie ausgerechnet das prozessormordende GTA5 mit dem 8600K besser performen kann, ist mir wirklich schleierhaft.

Dass die RTX 2070 jetzt die relativ schwächste Komponente ist, wird nicht bestritten. Aber mit Verlaub, ich

will im GPU-Limit hängen. Wenn die GPU-Auslastung im OSD nicht knapp 100% zeigt, erhöhe ich schon seit jeher die Grafikdetails, bis sie es tut. (Dass ich derzeit kein größeres Problem mit vollständiger GPU-Auslastung habe, liegt ja auf der Hand.

)

Mit der neuen Auflösung von 5120 x 1440 hat die 2070 zu kämpfen, keine Frage. War auch keine Überraschung, denn im Großen und Ganzen weiß ich schon, was ich tue, wenn ich Hardware auswähle. Side fact: Das 49"-Vorgängermodell des Samsung-Monitors mit 3840 x 1080 px war bereits bestellt, um genau den Grafik-Engpass zu umschiffen, der jetzt hier adressiert wird. Im letzten Moment vor dem Versand besann ich mich eines Besseren, widerrrief und bestellte das aktuelle Modell mit der zeitgemäßeren Auflösung. Gute Entscheidung, denn sonst hätte ich mich bald über das grob aufgelöste Bild geärgert. Nun ist es halt erst mal etwas eng mit den FPS.

Es gibt trotzdem kein Problem:

- Ich bin es von meinem alten 60 Hz-TN-Triple-Screen-Setup gewohnt, mit 50-60 FPS zu spielen.

- Mit G-Sync statt Ingame-V-Sync ist das Bild jederzeit flüssig, mit allen hier anliegenden FPS.

- Mit G-Sync ist auch in tiefen FPS-Regionen noch flüssig spielbar, was mit V-Sync schon ruckelig war.

- Das Bild ist soo viel besser (Farben, Kontrast, Schwarzwert, Schärfe, Blickwinkel) als vorher.

- Hab nun eine einzige breite Fläche, es gibt keine Monitorrahmen mehr im Blickfeld.

- Ich spiele auch ältere Spiele, die oben nicht genannt wurden, aber von den 120 statt vorher 60 Hz profitieren, und zwar vollends.

Und jetzt kommen noch - sorry - RAM und CPU-Kerne! Die helfen richtig, wenn es viel davon gibt und wenn sie schnell sind. Ich rede nicht nur von Frametime-Spikes, die nicht mehr auftreten, geschenkt. Ruckler in GTA hab ich schon lange nicht mehr, seit ich von 16 auf 32 GB gepimpten RAM gegangen bin. Aber mit Frametimes "wie ein Strich" kann ich mit 45 FPS ein ruhigeres Spielgefühl haben als mit zittrigen 60. Solche Frametimes hab ich bisher schon meistens. Und ab sofort noch öfter.

Der schnelle RAM und die schnelle CPU sind nicht "zu schnell" für die Grafikkarte, es wäre Unsinn, das zu behaupten. Sie helfen ihr und unterstützen sie. Das gleiche gilt für den Monitor, der durch sein technisch aktuelles Niveau in der Lage ist, ordentlich mit der Grafikkarte zu kommunizieren.

All das steht nicht im Widerspruch zu den Dingen, die du und

@0ssi anführen. Aber es erklärt vielleicht, warum ich hier sitze und sage: "Boah, ist das geil", während ihr von außen die Komponenten gegeneinander abwägt und mir eine "viel zu schwache" Grafikkarte attestiert.

Dass diese gerade mal eineinhalb Generationen alt und schon wieder die älteste Hauptkomponente im Rechner ist, zeigt, mit welcher Inbrunst wir dieses Hobby betreiben. Aber das nur am Rande.

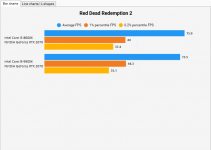

Noch was hab ich gelernt: Zehn Jahre lang galt hier der "Ultra-Imperativ": Die Grafikkarte sollte immer stark genug sein, um 60 FPS bei Ultra-Einstellungen aktueller AAA-Spiele liefern zu können. Derzeit lerne ich aber eine neue Bescheidenheit: RDR2 sieht auch auf mittleren Einstellungen fantastisch aus. Zumindest hier.

P.S. Wenn ich irgendwann eine 3080 oder Nachfolgerin habe, geht mich mein dummes Geschwätz von gestern natürlich nichts mehr an. Aber bis dahin gilt das heute Gesagte!

Gute N8.