- Registriert

- März 2006

- Beiträge

- 11.350

Die IOPS (Input/Output Operations Per Second) sagen aus, wieviele angefragte Aktionen pro Sekunde ausgeführt werden.

Ein Beispiel (stark vereinfacht):

Das Programm Firefox fragt nach einer Datei mit einer Größe von 10KB (=1 IO) und das Programm Skype fragt nach einer 100 KB Datei (=1 IO). Nehmen wir an, dass die Bearbeitung der beiden Anfragen genau eine Sekunde dauert. Dann hätten wir eine Leistung von 2 IOPS.

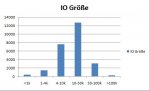

Wie Eggcake schon erwähnt hat, hängen die IOPS also sehr stark von der Dateigröße ab. Im Anhang sieht man z.B. die von mir gemessenen IO-Größen beim Bootvorgang mit anschließendem Start mehrerer Anwendungen. Davon sind etwa 90 Prozent Reads. Im Kaufberatungsthread war ich auch noch darauf eingegangen wie die Outstanding IOs aussahen.

Das die SSDs so hohe IOPS erreichen, hat einen simplen Grund: Latenz. Wenn mehrere Anwendungen Dateien anfragen und das suchen der Datei jedes mal 10ms dauert (HDD), dauert die gesamte IO natürlich viel länger als bei einer SSD.

Die Argumentation zum Kopieren hat mich überzeugt nicht die Dummy-Dateien zu nehmen.

Ein Beispiel (stark vereinfacht):

Das Programm Firefox fragt nach einer Datei mit einer Größe von 10KB (=1 IO) und das Programm Skype fragt nach einer 100 KB Datei (=1 IO). Nehmen wir an, dass die Bearbeitung der beiden Anfragen genau eine Sekunde dauert. Dann hätten wir eine Leistung von 2 IOPS.

Wie Eggcake schon erwähnt hat, hängen die IOPS also sehr stark von der Dateigröße ab. Im Anhang sieht man z.B. die von mir gemessenen IO-Größen beim Bootvorgang mit anschließendem Start mehrerer Anwendungen. Davon sind etwa 90 Prozent Reads. Im Kaufberatungsthread war ich auch noch darauf eingegangen wie die Outstanding IOs aussahen.

Das die SSDs so hohe IOPS erreichen, hat einen simplen Grund: Latenz. Wenn mehrere Anwendungen Dateien anfragen und das suchen der Datei jedes mal 10ms dauert (HDD), dauert die gesamte IO natürlich viel länger als bei einer SSD.

Die Argumentation zum Kopieren hat mich überzeugt nicht die Dummy-Dateien zu nehmen.