danyundsahne

Commodore

- Registriert

- Okt. 2007

- Beiträge

- 4.931

Ging ja auch nur um diese 2 Bsp Games....die Behauptung "deutlich" geschlagen von einer 5080 ist halt Murks.AfFelix schrieb:@danyundsahne DLSS ist etwas rechenintesiver als XESS auf AMD und es war nur ne Beta. Da würde ich wirklich abwarten auf einen Test ohne DLSS und vom fertigen Spiel. nach Day 1 Patch.

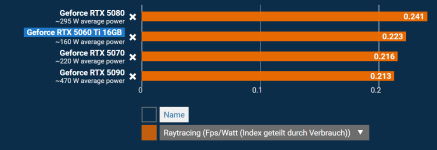

Insofern etwas verzerrt aber ja P/L mäßig ist das gar keine Frage. Die 5080 ist in 4k RT zirka 25-30% schneller und kostet 50-60% mehr

Stimmt natürlich in anderen PT Benchmarks. Da ist NV nach wie vor Platzhirsch.

Aber im RR und RT ist AMD NV doch sehr dicht auf den Fersen mit ihrer 650€ Karte....egal ob es eine 5070Ti ist oder teilweise eben auch einer 1000€ 5080. Man kann sehr gut konkurrieren für dieses Geld.

Dass man in PT auf Niveau einer 500€ 5060ti 16GB ist mit einer 650€ Karte, ist das eine. Hier ist man auch Preislich sehr nah beieinander. Aber dass man auch auf anderer Seite im Raster immer wieder mal auf ein 1000€+ 5080 Niveau kommt (wohlgemerkt in nagelneuen UE5 Titeln, welche aktuell ja das Non-Plus-Ultra der Game Engines ist), ist dennoch sehr beachtlich für AMD.

Und eine 5070ti und 5080 sind preislich deutlich zu weit auseinander für das was die 5080 mehr leistet. Daher kommt eben eine 9070XT automatisch sehr nah von ihrer eigentlichen Konkurrentin 5070ti an eine 5080 ran. Isso

Ergänzung ()

Und in 4k sinds 13% AVG. Und in den noch wichtigeren 1% Lows sind es nur noch magere 11% Vorsprung, schon klar.Taxxor schrieb:Schalte mal auf UWQHD, dann werden aus +7% schon +18%, in 4K dann wieder nur +13%

Insgesamt komisches Verhalten

Was möchtest mir jetzt damit sagen?

Was kostet ne 5080 nochmal Aufpreis?

Aber ich bin jetzt wieder ruhig. Ich wollte nur @LikeHike 's Aussage dahingehend korrigieren, dass in den beiden Games eine 9070XT alles andere als deutlich geschlagen wird.

Zuletzt bearbeitet: