Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Notiz GPU-Gerüchte: Navi 24 „Beige Goby“ kommt als Radeon RX 6500/6400

- Ersteller SVΞN

- Erstellt am

- Zur Notiz: GPU-Gerüchte: Navi 24 „Beige Goby“ kommt als Radeon RX 6500/6400

Ich hoffe auch auf eine (wenn mgl. sogar passive) 8GB Version.

Meine Rx 460 und 580 sind leider beide als Garantiefälle zurückgegangen, weswegen ich übergansgeweise auf einer 650ti bzw. igpu zocke. Die 580 jetzt in passiv, meinetwegen auch mit etwas weniger Leistung, wäre schon atraktiv.

Meine Rx 460 und 580 sind leider beide als Garantiefälle zurückgegangen, weswegen ich übergansgeweise auf einer 650ti bzw. igpu zocke. Die 580 jetzt in passiv, meinetwegen auch mit etwas weniger Leistung, wäre schon atraktiv.

Freue mich definitiv auf die 3 Serien (6600 XT - 6400), habe aktuell eine Sapphire Pulse Radeon RX 550 4GB, eine 6500 XT als Sapphire Pulse in ITX Größe wäre vermutlich ein nices Upgrade für mich. Mit etwas Einstellung laufen die meisten Games die ich so spiele in der Freesync Range von 48-75 Hz bei 720p - 1080p, lediglich Genshin Impact mag nicht wirklich butterweich laufen. Daher bin ich sehr gespannt wozu die kleinen RDNA2 Karten im Stande sein werden und über welche Anschlüsse sie verfügen, ich hoffe auf mindestens 2 besser 3x DP 1.4a (DP 2.0 wird man ja frühestens mit der nächsten Gen. sehen.) und 1x HDMI 2.1 evtl. 2x je nachdem wie die Boardpartner sie auslegen.

Auch bin gespannt wie der neue Hardware Encoder performt, während ReCentral FHD@60fps bei 50 MBit/s H265 encoden kann, fängt OBS da selbst bei H264 an zu struggeln. Hoffe das das mit RDNA2 besser funktioniert. Bin mir aber nicht sicher ob das am Encoder oder an OBS liegt.🤔

Auch bin gespannt wie der neue Hardware Encoder performt, während ReCentral FHD@60fps bei 50 MBit/s H265 encoden kann, fängt OBS da selbst bei H264 an zu struggeln. Hoffe das das mit RDNA2 besser funktioniert. Bin mir aber nicht sicher ob das am Encoder oder an OBS liegt.🤔

Ich denke schon dass sich diese GPUs signifikant von iGPUs absetzen können. Bei AMDs APUs ist man noch nicht bei RDNA angekommen und Intel ist auf dem Papier zwar gleich weit, beschneidet die iGPUs der normalen CPUs aber extrem sodass es wieder nur beim Display Anschluss bleibt.

Hinzu kommt die Sache mit dem Speicher

Hinzu kommt die Sache mit dem Speicher

Solange AMD keine vernünftige APUs mit RDNA2 anzubieten hat, wird son winziger Chip mit aktueller Architektur Sinn machen. Und die 4GB sind für die Leistung, die wahrscheinlich in vielen aktuellen Spielen keine 60 fps bei hohen Einstellungen in 1080p schafft, ausreichend.

Man muss halt bedenken, das Dingen hat halb so viele Schader wie Navi23, was knapp die 5700XT schlagen wird.

Je nach Power Limit rechne ich im besten Fall mit der Leistung einer RX 580. Eine HTPC GPU für Gelegenheitszocker, für 89€.

Man muss halt bedenken, das Dingen hat halb so viele Schader wie Navi23, was knapp die 5700XT schlagen wird.

Je nach Power Limit rechne ich im besten Fall mit der Leistung einer RX 580. Eine HTPC GPU für Gelegenheitszocker, für 89€.

Haha der war gut oder, 89€

F

franzerich

Gast

Danke für die Hinweise bezüglich "Infinity Cache". Obwohl ich das schon mal gehört habe, habe ich das erstmals nur als "irgendein weiterer irrelevanter Marketing-Slogan" abgetan (das kommt davon, weil man ständig neue Schlagwörter hört, hinter denen sich schätzungsweise 80% komplett banales Zeug vebirgt). In diesem Fall habe ich mich allerdings geirrt und es ist tatsächlich wichtig:

Der erste Link in der Google Suche fasst es gut zusammen: "it lets AMD double the memory bandwidth, while using a narrower -bit interface."

Damit stehen die 64-bit in der Speicherbandbreite den 128-bit von Nvidia vermutlich in Nichts nach, und die 6500 ist vermutlich doch der direkte Konkurrent zur rtx 3050.

Der erste Link in der Google Suche fasst es gut zusammen: "it lets AMD double the memory bandwidth, while using a narrower -bit interface."

Damit stehen die 64-bit in der Speicherbandbreite den 128-bit von Nvidia vermutlich in Nichts nach, und die 6500 ist vermutlich doch der direkte Konkurrent zur rtx 3050.

Zuletzt bearbeitet von einem Moderator:

@deo sie verbessern sich ständig. Aber wird noch ein zwei Generationen Dauern bis man da gleich auf sein kann.

Radeon Pro ist halt nochmal ein ganz anderes Thema im Bereich zu den normalen. Sie haben ihre Stärken. Aber stand jetzt sind es im Vergleich zu Nvidia nur wenige.

Navi 21-24 lassen jedenfalls viele schöne Radeon Pro Karten zu wie damals bei GCN4.0

Bin dennoch gespannt, für mich persönlich ist Nvidia da komplett uninteressant da viel zu teuer. CUDA brauch ich auch nicht in meinen Programmen und da stört mich das nicht. Dieser vermeintliche Nachteil ist für mich keiner

Radeon Pro ist halt nochmal ein ganz anderes Thema im Bereich zu den normalen. Sie haben ihre Stärken. Aber stand jetzt sind es im Vergleich zu Nvidia nur wenige.

Navi 21-24 lassen jedenfalls viele schöne Radeon Pro Karten zu wie damals bei GCN4.0

Bin dennoch gespannt, für mich persönlich ist Nvidia da komplett uninteressant da viel zu teuer. CUDA brauch ich auch nicht in meinen Programmen und da stört mich das nicht. Dieser vermeintliche Nachteil ist für mich keiner

en. Goby -> deu: Grundel --> FischD0m1n4t0r schrieb:Nach "Beige Gobi" kommen als nächste CPU Bezeichnungen dann "Black Matter", "White Power", "Yellow Threat" und "Red Homeland" auf den Markt.

deine Vorschläge: keine Fische !

Wenn man die Nomenklatur der RDNA2 Chips noch nicht verstanden hat, dann vielleicht einfach mal nicht krampfhaft versuchen lustig zu sein.

Marflowah

Banned

- Registriert

- März 2018

- Beiträge

- 1.708

Beim dem von dir verlinkten Artikel im Abschnitt die fps sind aussen vor etwas weiter unten bei dem von den Spielen angeforderten VRAM sieht man, dass der VRAM-Bedarf in die Höhe schnellt, wenn man den Detailgrad mehrerer Spiele bspw. von "Hoch" auf "Sehr hoch" stellt.Palomino schrieb:Es reichen ja schon 4,x GB aus um die Karte zu überfordern. Das wurde bereits vor 5 Jahren mit Full HD geschafft. Den VRAM Bedarf hat CB ja schon öfter getestet.

Ich bezweifle aber, dass man auf "Sehr Hoch" Spiele mit einer Einstiegs-Grafikkarte genießen könnte, selbst wenn sie 16 GB VRAM hätte - eben weil die GPU schwach ist. Das wollte ich nur feststellen.

Ja, so eine Karte mit passivem Kuehler zu einem Preis <EUR100 koennte endlich meine 10 Jahre alte 6770 abloesen; ob der Cache gross genug ist, wird spannend zu sehen.

Was die angebliche Einsteigerkarte 5500XT angeht, bei Preisen ab EUR 200 kann man nicht von Einsteigerkarte reden. Vor ca. 15 Jahren habe ich eine 850XT (damals high end, immerhin 256bit Speicherinterface) um ca. EUR 150 gekauft, ein paar Jahre spaeter die Mittelklassekarte 4670 (128-bit-Specher) um EUR 60.

Was die angebliche Einsteigerkarte 5500XT angeht, bei Preisen ab EUR 200 kann man nicht von Einsteigerkarte reden. Vor ca. 15 Jahren habe ich eine 850XT (damals high end, immerhin 256bit Speicherinterface) um ca. EUR 150 gekauft, ein paar Jahre spaeter die Mittelklassekarte 4670 (128-bit-Specher) um EUR 60.

D0m1n4t0r

Rear Admiral

- Registriert

- Jan. 2014

- Beiträge

- 5.590

Wenn man das machen würde dann könnte man keine low- und midrange grafikkarten mehr verkaufen. Und bei midrange ist für gewöhnlich am meisten Marge zu holen.

PC Markt sähe dann so aus, dass Highend/Enthusiast Nutzer die dickste CPU und ne fette Grafikkarte haben und alle darunter nurnoch eine APU.

Langfristig wird es vermutlich eh auf nurnoch APUs hinauslaufen oder auf kleine Clients zuhause und gestreamte Rechenleistung aus der Cloud.

Aber mit Infnity Cache bei APUs würde AMD sich aktuell selbst ins Bein schiessen.

PC Markt sähe dann so aus, dass Highend/Enthusiast Nutzer die dickste CPU und ne fette Grafikkarte haben und alle darunter nurnoch eine APU.

Langfristig wird es vermutlich eh auf nurnoch APUs hinauslaufen oder auf kleine Clients zuhause und gestreamte Rechenleistung aus der Cloud.

Aber mit Infnity Cache bei APUs würde AMD sich aktuell selbst ins Bein schiessen.

D0m1n4t0r schrieb:Wenn man das machen würde dann könnte man keine low- und midrange grafikkarten mehr verkaufen.

AMD verkauft eh keine low-end Grafikkarten mehr. Die R5 230, die wir vor einem Jahr noch in Ryzen-Maschinen eingebaut haben, gibt es nicht mehr, wir mussten zur GT710 greifen.

Fuer Mid-Range sehe ich keine Gefahr, denn auch mit Infinity Cache brauchen die Grafikkarten doch gut Speicherbanbreite (wenn auch weniger also ohne), und auf den APUs ist die halt nicht so gross.

PC Markt sähe dann so aus, dass Highend/Enthusiast Nutzer die dickste CPU und ne fette Grafikkarte haben und alle darunter nurnoch eine APU.

Schlecht? Das Problem, was ich dabei eher sehe, ist, dass die Kunden nicht bereit sind, fuer APUs entsprechend mehr zu zahlen als fuer CPUs, um die Mehrkosten fuer einen Chip mit z.B. 32MB Infinity Cache und 16 CUs fuer AMD lohnend zu machen; die sind ja von Intel dran gewoehnt worden, dass die Grafik eine Gratisbeigabe ist (naja, seit den F-Prozessoren wissen wir, dass Intel die Grafik mit $25 bewertet). Und in den Foren wird sicher selbst, wenn es so eine APU gaebe, davon abgeraten, weil die meisten zu einer dicken Grafikkarte raten.

Aber mit Infnity Cache bei APUs würde AMD sich aktuell selbst ins Bein schiessen.

Glaube ich nicht. Einmal ganz abgesehen davon, dass AMD aktuell ohne Probleme jede GPU verkauft, die sie produzieren koennen, wuerden sie im Erfolgsfall vor allem Nvidia in's Bein schiessen, denn die meisten kombinieren einen Ryzen mit einer Nvidia-Grafikkarte. Und wenn Sie mit der APU z.B. $50 Mehrumsatz machen und dafuer in 30% der Faelle eine $50-GPU weniger verkaufen, haben sie pro APU im Durchschnitt $35 Mehrumsatz gemacht. Wenn die Kunden sich dann fuer eine AMD-APU statt einer Intel-CPU + GPU (von wem auch immer) entscheiden, ist das auch ein Mehrumsatz fuer AMD.

Zwiebelsoße

Banned

- Registriert

- Dez. 2020

- Beiträge

- 479

4GB V-ram ist für die Leistung einer RX 580/RX 590 viel zu wenig.

Die 6600XT landet leicht über einer 5700XT, da sind 8GB schon relativ knapp.

Die 6600XT landet leicht über einer 5700XT, da sind 8GB schon relativ knapp.

- Registriert

- Apr. 2011

- Beiträge

- 3.179

Weil sich hier einige wegen den 4GB aufregen und sich fragen ob vielleicht auch 8GB möglich sind, hier mal ein paar Hintergründe:

Zuerst einmal finde ich nicht dass Phoronix hier als Quelle genannt werden sollte, @SV3N .

Phoronix zeigte zwar auf, dass Code zu Navi24 im Linux-Patch zu finden ist;

Die Spezifikationen hat jedoch @Locuza extrahiert und veröffentlicht. Dort ist aber noch nicht von 4GB Vram die Rede.

Diese kommen erst, als 3DCenter diesen Tweet auf Basis von Locuzas Informationen geteilt hatte.

https://twitter.com/3DCenter_org/status/1392750962696204297

Woher kommen also die 4GB von 3DCenter? Dies ist eine Schlussfolgerung aus dem 64-bit Speicherinterface.

Die Gesamtgröße eines GDDR6-Speicherinterface eines Chips ergibt sich aus der Anzahl der PHYs.

Jedes PHY hat 32bit bzw, genau genommen 2*16bit. Der Navi22 Chip der 6700XT hat zB 6 Stück

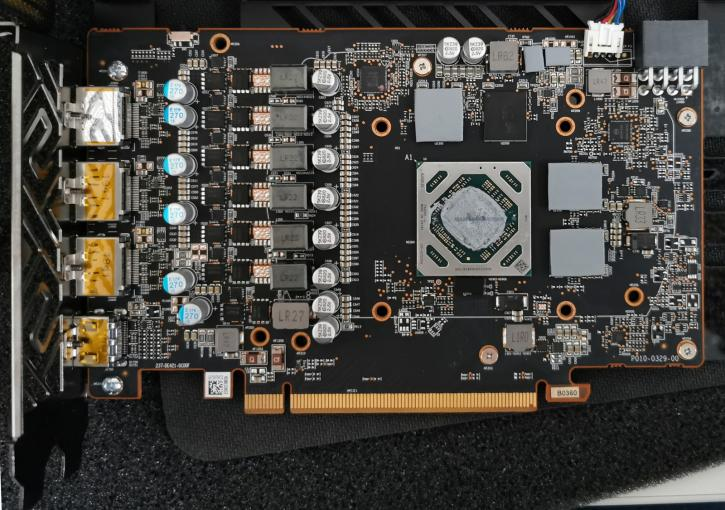

![951-block-diagram[1].jpg 951-block-diagram[1].jpg](https://www.computerbase.de/forum/attachments/951-block-diagram-1-jpg.1079789/)

(auch nochmal danke an @Locuza für die Grafik) von diesen, also hat der Chip insgesamt ein Speicherinterface von 192-bit.

Aus diesen Spezifikationen ergeben sich wiederum die Anzahl der GDDR6-Chips. Jedes PHY bedient grob gesagt einen GDDR6-Chip, da jeder Speicherchip ebenfalls mit der besagten 2*16bit Interfacegröße arbeitet.

Und logischerweise ergeben sich aus der Anzahl der GDDR6-Chips die Gesamtkapazität des VRams der Grafikkarte. Jetzt haben die 5700XT und 6800XT aber zB beide ein 256bit Speicherinterface und 8 Speicherchips auf dem PCB, aber die 5700XT nur 8GB VRam und die 6800XT 16GB. Das liegt einfach an der Kapazität der Chips selbst:

GDDR6-Speicherchips gibt es mit einer Kapazität von 8 Gigabit, also 1 GigaByte und 16 Gigabit (2GB).

https://www.micron.com/products/ultra-bandwidth-solutions/gddr6/part-catalog

Nach JEDEC sind auch 32 Gigabit möglich, aber aktuell gibt es weder von Micron, noch SK Hynix noch Samsung ein derartiges Produkt.

Was heisst das für Navi24? Nun ja, das PCB wird extrem schmal, da es nur 2 Speicherchips geben wird.

Kleiner als das einer 5500, hier mal als Vergleich:

Aber: Damit sind auch nur maximal 4 GigaByte-Karten möglich, da es wie gesagt noch keinen 32Gigabit-GDDR6-Speicher gibt. 8 Gigabyte sind aktuell nicht möglich!

Zusätzliche Spekulation meinerseits: Die XT-Variante schätze ich so bei 90Watt TBP ein (0,4*6700XT), und Leistungsmäßig bei einer 5500XT, in Fällen in denen der VRAM mal nicht limitiert. Die Variante darunter dürfte ohne Stromanschluss mit 70 Watt daherkommen und knapp über einer RX 570 liegen.

Sollte man drei Varianten nutzen, kann ich mir noch eine 2GB-passiv-Version für OEMs vorstellen, wo man die absoluten Schrottchips verwertet.

(Edit):Sparfüchse werden wohl enttäuscht werden. Spekuliere auf ne Chipgröße von 150mm² und damit ungefähr auf einem Niveau wie Navi 14 (160mm²), dessen Versionen für 180 respektive 210 EUR verkauft wurden.

Daher gehe ich davon aus, dass die kleine Variante 120 EUR und die Große bei 150-170 EUR landen wird. UVP natürlich

Zuerst einmal finde ich nicht dass Phoronix hier als Quelle genannt werden sollte, @SV3N .

Phoronix zeigte zwar auf, dass Code zu Navi24 im Linux-Patch zu finden ist;

Die Spezifikationen hat jedoch @Locuza extrahiert und veröffentlicht. Dort ist aber noch nicht von 4GB Vram die Rede.

Diese kommen erst, als 3DCenter diesen Tweet auf Basis von Locuzas Informationen geteilt hatte.

https://twitter.com/3DCenter_org/status/1392750962696204297

Woher kommen also die 4GB von 3DCenter? Dies ist eine Schlussfolgerung aus dem 64-bit Speicherinterface.

Die Gesamtgröße eines GDDR6-Speicherinterface eines Chips ergibt sich aus der Anzahl der PHYs.

Jedes PHY hat 32bit bzw, genau genommen 2*16bit. Der Navi22 Chip der 6700XT hat zB 6 Stück

(auch nochmal danke an @Locuza für die Grafik) von diesen, also hat der Chip insgesamt ein Speicherinterface von 192-bit.

Aus diesen Spezifikationen ergeben sich wiederum die Anzahl der GDDR6-Chips. Jedes PHY bedient grob gesagt einen GDDR6-Chip, da jeder Speicherchip ebenfalls mit der besagten 2*16bit Interfacegröße arbeitet.

Und logischerweise ergeben sich aus der Anzahl der GDDR6-Chips die Gesamtkapazität des VRams der Grafikkarte. Jetzt haben die 5700XT und 6800XT aber zB beide ein 256bit Speicherinterface und 8 Speicherchips auf dem PCB, aber die 5700XT nur 8GB VRam und die 6800XT 16GB. Das liegt einfach an der Kapazität der Chips selbst:

GDDR6-Speicherchips gibt es mit einer Kapazität von 8 Gigabit, also 1 GigaByte und 16 Gigabit (2GB).

https://www.micron.com/products/ultra-bandwidth-solutions/gddr6/part-catalog

Nach JEDEC sind auch 32 Gigabit möglich, aber aktuell gibt es weder von Micron, noch SK Hynix noch Samsung ein derartiges Produkt.

Was heisst das für Navi24? Nun ja, das PCB wird extrem schmal, da es nur 2 Speicherchips geben wird.

Kleiner als das einer 5500, hier mal als Vergleich:

Aber: Damit sind auch nur maximal 4 GigaByte-Karten möglich, da es wie gesagt noch keinen 32Gigabit-GDDR6-Speicher gibt. 8 Gigabyte sind aktuell nicht möglich!

Zusätzliche Spekulation meinerseits: Die XT-Variante schätze ich so bei 90Watt TBP ein (0,4*6700XT), und Leistungsmäßig bei einer 5500XT, in Fällen in denen der VRAM mal nicht limitiert. Die Variante darunter dürfte ohne Stromanschluss mit 70 Watt daherkommen und knapp über einer RX 570 liegen.

Sollte man drei Varianten nutzen, kann ich mir noch eine 2GB-passiv-Version für OEMs vorstellen, wo man die absoluten Schrottchips verwertet.

(Edit):Sparfüchse werden wohl enttäuscht werden. Spekuliere auf ne Chipgröße von 150mm² und damit ungefähr auf einem Niveau wie Navi 14 (160mm²), dessen Versionen für 180 respektive 210 EUR verkauft wurden.

Daher gehe ich davon aus, dass die kleine Variante 120 EUR und die Große bei 150-170 EUR landen wird. UVP natürlich

Zuletzt bearbeitet:

Ähnliche Themen

- Antworten

- 179

- Aufrufe

- 33.729

- Antworten

- 160

- Aufrufe

- 39.217

- Antworten

- 97

- Aufrufe

- 16.555

- Antworten

- 120

- Aufrufe

- 26.735

- Antworten

- 9

- Aufrufe

- 2.293