TechFA

Lt. Commander

- Registriert

- Okt. 2018

- Beiträge

- 1.029

Also nach allem was man nun weiß über DG1 (Danke Dir Igor! @FormatC), Tom'sHardware hat die Karte ja mittlerweile auch getestet (Intel Xe DG1 im Benchmark: Kampf der Schwächlinge unter den GPUs) und ihr Fazit war doch sehr, sehr ernüchternd;

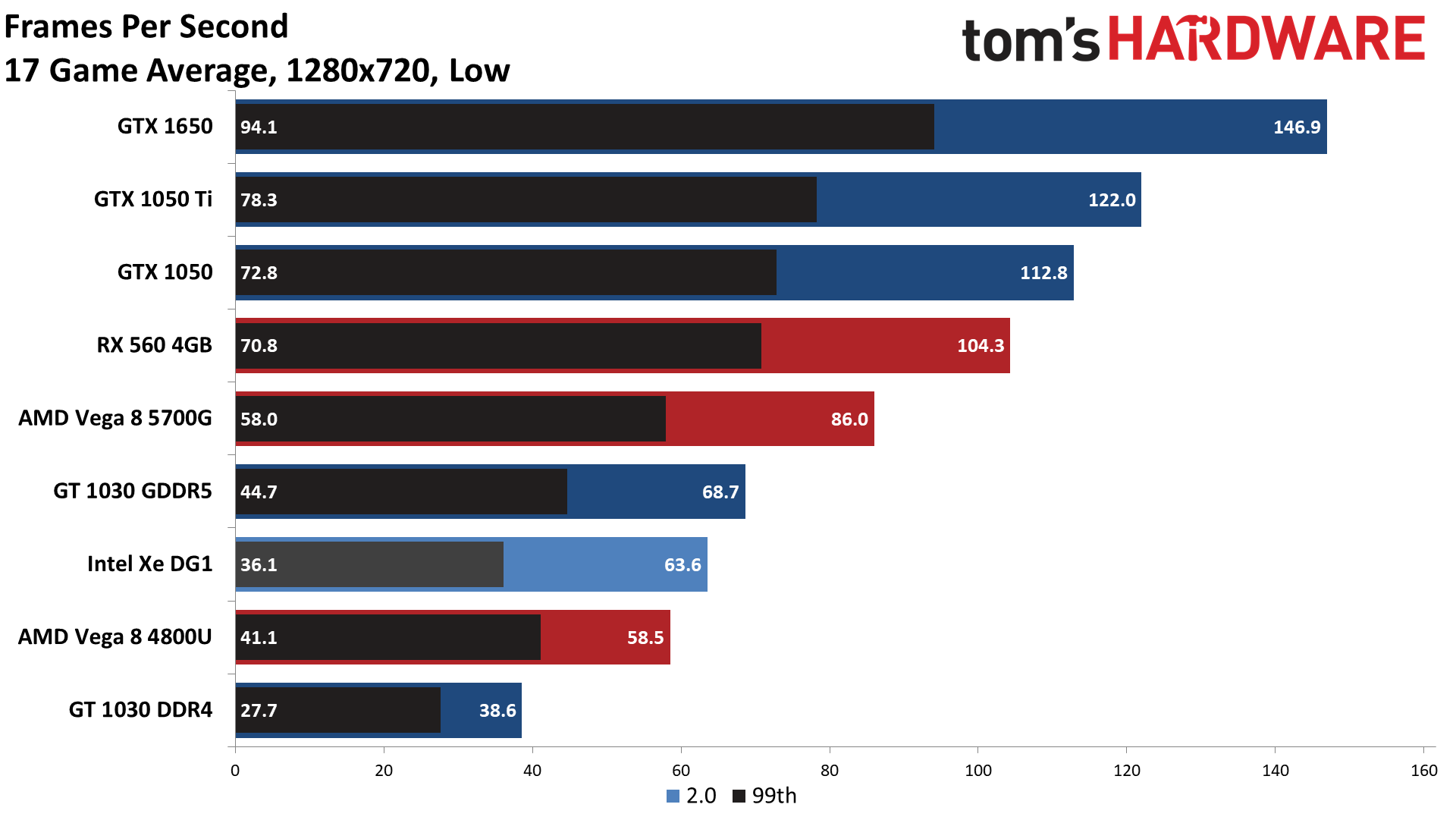

Sie kann also kaum mit einer GT 1030 konkurrieren (die sogar auf einer älteren und damit größeren Node gefertigt wird, 14nm vs Intels 10nm!) bei der gleichen TDP. Währenddessen braucht die DG1 die doppelte Leistungsaufnahme, um mit einer Vega 8 bei 15W mithalten zu können (die sogar ihre TDP mit den CPU-Kernen teilen muss)! In Summe im Vergleich zu einer Vega 8 ist AMD 4× so effizient.

Alles in allem haben sie Ewigkeiten gebraucht, um ihre iGPU auf ein PCB zu pflanzen. Das ist alles, was sie in all der Zeit zustande gebracht haben mit Raja; Im Endeffekt ihre Uralt-iGPU auf eine Platine, und das wars.

Nach Jahren der Intel-typischen Hinhalte-Taktiken mit Render-Bildchen (aus der Community von arg geblendeten Intel-Fans), hat sich also wieder mal bestätigt, was die ganzen angeblichen Pessimisten, Neider und Miesepeter schon immer wussten;

Intel kann einfach keine Grafik-Hardware noch Treiber, und das wird sehr wahrscheinlich auch in Zukunft so bleiben.

Es gab von Anfang an Gerüchte, dass ihre so hochgelobte Xe Graphics im Kern bloß ihre Uralt-iGPU wäre. Genau das hat Intel dann auch irgendwann zugegeben. Natürlich nicht öffentlich, aber hinter verschlossenen Türen (Shareholder darf man ja schließlich nicht unmittelbar anlügen, weil sonst wirds teuer).

Dann gabs plötzlich Insider (schon 2019!), die meinten, selbst bei den anvisierten 25W TDP würde das Ding nix reissen können. Intel DG1, its first GPU, performs below expectations and its TDP would be high.

Lustig ist auch (gerade erst gesehen!), im Reddit-Thread schreib jemand Namens "Smartcom5". Obs derselbe ist wie hier @Smartcom5, weis ich nicht bestimmt. Ist seitdem jedenfalls Ende 2019 kaum mehr hier gesehen, möglich wärs bestimmt!

Der Benutzer schrieb seinerzeit davon, dass der Grund, weswegen die Intel-Graphics DG1 so schlecht abschneidet, in Intels berühmten 10nm zu suchen sind (Leckstrom zu hoch wenn über bestimmten Takt). Scheint, als hätte er Recht gehabt. Und unter anderem schrieb er/sie das;

Jemand anderes meinte/schrieb;

Vielleicht wars sogar der Themenersteller selbst bloss mit zweitaccount als Sockenpuppe!?

Auch gab es seinerzeit schon Ende 2019 ziemlich viele Gerüchte, dass ihre erste dedizierte Grafikkarte DG1 ein kapitaler Reinfall werden würde. Bestritten hats Intel immer vehement.

Gerüchte mutmassten, dass wenn ihre Grafik so schlecht wäre, würde die eh Keiner kaufen, weil;

Wie immer bei Intel und so typisch: Entweder total überteuert für das Gebotene, oder aber derart wettbewerbsunfähig, dass Keiner mit Verstand zulangt.

Viele unkten damals, dass wahrscheinlich die Einzigen, die das Ding überhaupt verbauen würden, wären OEMs (weil sie auch die Einzigen wären, die Intel dafür bezahlen würde können, eben genau das zu tun).

Und natürlich, es kam was kommen musste: Bestätigung der gerüchtenweisen Unkerufe hatten wir, als es hiess, dass Intel DG1 nur OEMs zur Verfügung stellen würde. Tada! Wieder mal.

AnandTech.com: Intel’s DG1 GPU Coming to Discrete Desktop Cards Next Year; OEM-Only

Im Grossen und Ganzen haben sich im Grunde praktisch fast alle Gerüchte als wahr herausgestellt. Weil, nach all der Propaganda und dem FUD und trotz all des versenkten Geldes, kann Intel mal wieder nicht liefern -- und das ist am Ende des Tages das Einzige was zählt. Traurig, weil wahr!

…weiß TechFA

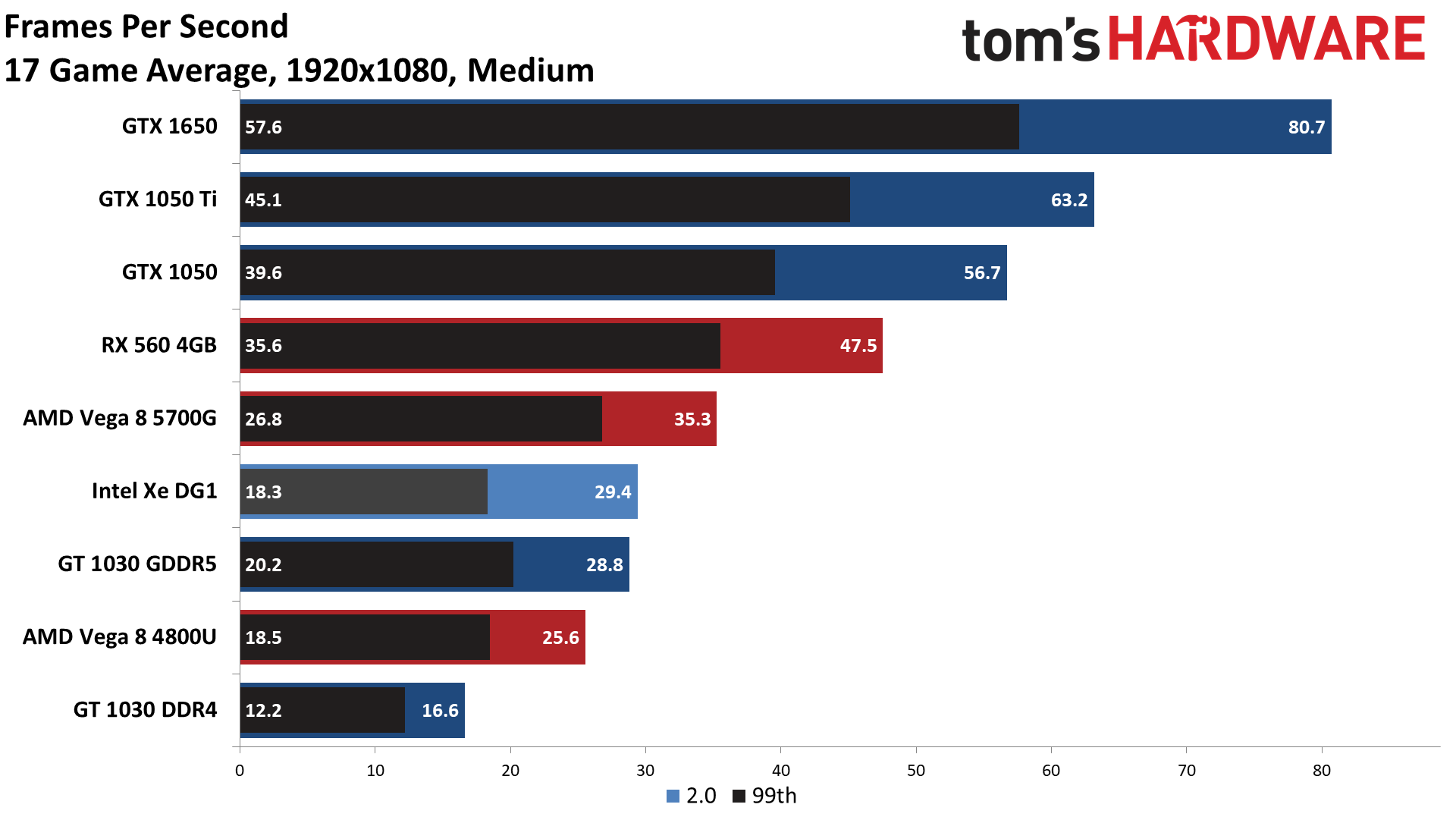

The GT 1030 GDDR5 came in 8% faster in average fps and 24% faster in 'minimum' fps, and that's by no means a fast graphics card. You can see AMD's Vega 8 in the 5700G easily beats the 1030 GDDR5, and the other higher performance dedicated graphics cards are anywhere from 35% faster (RX 560) to 130% faster (GTX 1650). It's not just about pure performance, though. As noted above, compatibility with a large number of games is also critical for Intel.

[...]

[...]

Let's be blunt: For a budget GPU, GTX 1650 levels of performance are the minimum we'd like to see, and the GTX 1650 is currently 175% faster than the DG1 across our test suite. And that's looking at the vanilla GTX 1650; the GTX 1650 Super nominally costs $10–$20 more than the vanilla model and boasts about 30% higher performance, which would make it more than triple the performance of the DG1. Drivers can certainly improve compatibility and performance in the future, but Intel needs more than that.

Tom'sHardware.com: Intel Xe DG1 Benchmarked: Battle of the Weakling GPUs

Sie kann also kaum mit einer GT 1030 konkurrieren (die sogar auf einer älteren und damit größeren Node gefertigt wird, 14nm vs Intels 10nm!) bei der gleichen TDP. Währenddessen braucht die DG1 die doppelte Leistungsaufnahme, um mit einer Vega 8 bei 15W mithalten zu können (die sogar ihre TDP mit den CPU-Kernen teilen muss)! In Summe im Vergleich zu einer Vega 8 ist AMD 4× so effizient.

Alles in allem haben sie Ewigkeiten gebraucht, um ihre iGPU auf ein PCB zu pflanzen. Das ist alles, was sie in all der Zeit zustande gebracht haben mit Raja; Im Endeffekt ihre Uralt-iGPU auf eine Platine, und das wars.

Nach Jahren der Intel-typischen Hinhalte-Taktiken mit Render-Bildchen (aus der Community von arg geblendeten Intel-Fans), hat sich also wieder mal bestätigt, was die ganzen angeblichen Pessimisten, Neider und Miesepeter schon immer wussten;

Intel kann einfach keine Grafik-Hardware noch Treiber, und das wird sehr wahrscheinlich auch in Zukunft so bleiben.

Es gab von Anfang an Gerüchte, dass ihre so hochgelobte Xe Graphics im Kern bloß ihre Uralt-iGPU wäre. Genau das hat Intel dann auch irgendwann zugegeben. Natürlich nicht öffentlich, aber hinter verschlossenen Türen (Shareholder darf man ja schließlich nicht unmittelbar anlügen, weil sonst wirds teuer).

Dann gabs plötzlich Insider (schon 2019!), die meinten, selbst bei den anvisierten 25W TDP würde das Ding nix reissen können. Intel DG1, its first GPU, performs below expectations and its TDP would be high.

Das Resultat dessen, sieht man jetzt eindrucksvoll (oder eher nicht) bei den finalen Tests..New news from Intel insiders this weekend. DG1 is not developing very well.

In terms of performance, the DG1 graphics endowment is around 23% more powerful than the Tiger Lake iGPU.

The consumptions / power seem to be grim as Raja Koduri is having a hard time setting a TDP for his DG1 GPU. Anyone who has followed his GPU designs knows that this has always been his downfall.

Intel has a couple of wins in laptop design, but they explained to me that these were deals to give the Koduri program a bit of legitimacy, rather than translate them into sales / profit. It was claimed that Intel would "give these things away" if necessary.

The real question now is: should we expect Raja Koduri to continue working for Intel after Q2020 2? If not, you can hope that we will never see a DGXNUMX reach a retail product.

The idea that Intel is a player of the stature of AMD and NVIDIA in the world of GPUs is slowly fading.

Quelle: Reddit-Thread

Lustig ist auch (gerade erst gesehen!), im Reddit-Thread schreib jemand Namens "Smartcom5". Obs derselbe ist wie hier @Smartcom5, weis ich nicht bestimmt. Ist seitdem jedenfalls Ende 2019 kaum mehr hier gesehen, möglich wärs bestimmt!

Der Benutzer schrieb seinerzeit davon, dass der Grund, weswegen die Intel-Graphics DG1 so schlecht abschneidet, in Intels berühmten 10nm zu suchen sind (Leckstrom zu hoch wenn über bestimmten Takt). Scheint, als hätte er Recht gehabt. Und unter anderem schrieb er/sie das;

Scheint als hatte Derjenige damals schon mehr Insider-Wissen und tiefere Einblicke, als manch anderer hier.It's a long, long way from Intel's iGPU towards some RX 470/570/480/580 in terms of performance, like really. It even is from AMD's APUs all the way up to a RX 570/580.

So just the next product which doesn't earn any greater profit but which Intel needs to subsidise instead again by maintaining a price structure below the competition's products (which are often even superior performance-wise), to even sell their heavily subsidised stuff in the first place?Anderer Benutzer: Anyway, DG1 doesn't need to look good for consumers, as they'll hardly see it, it needs to look good to OEMs. And almost nothing looks better than a virtually free GPU.

Is it just me or does Intel in fact just fails since quite a while to bring any greater competitive product?

Honest question though! Since it just looks like that since ages …

Their Atoms were subsidized with billions, and still got refused by the market – as they were just subpar and underperforming. Their modems were served the same fate, heavily subsidized to the point that they even had to sold them at a loss to even flog them at all – as they were also just subpar and underperforming. Optane is the same, over-promising and underperforming and way too excessively outpriced – they changed it after no-one at their server-space felt for their claims, that's why they heavily subsidise it again to pressure it into the OEM-market towards the largely clueless consumer.

They always failed on graphics too with their first dedicated graphics i740, then with LArrabee again, and with Xeon Phi too. Why again? As those parts were again just subpar and underperforming. Yet, their last attempt on graphics, their iGPU, would've been granted the identical fate, if they wouldn't've had come up with the clever move to force-bundle them with their CPUs – since suprise, suprise, those were also just subpar and underperforming again.

What Intel needs, is some competitive product for once – and not just the next product they have to subsidize heavily and with that being artificially maintained into life like most of their other products since ages (since they're mostly just subpar and straight-out uncompetitive).

That being said, if DG1 turns out shaping the way it's foreshadowed and rumoured here, their fifth attempt on graphics is doomed to fail again (at least from a business-standpoint), that's it.

Jemand anderes meinte/schrieb;

Antwort von Smartcom5;This lines up more or less with what I have heard and reported on, but I'm not sure if this information is legitimate or not, especially about the DG1 getting wins in notebooks. Why make DG1 laptops when Tiger Lake is about the same performance, for less power, with a CPU, and in a single package?

Er/sie schrieb das schon im Dezember 2019, in der Vergangenheitsform bitteschön!!It was actually, all of what you heard.

Vielleicht wars sogar der Themenersteller selbst bloss mit zweitaccount als Sockenpuppe!?

Auch gab es seinerzeit schon Ende 2019 ziemlich viele Gerüchte, dass ihre erste dedizierte Grafikkarte DG1 ein kapitaler Reinfall werden würde. Bestritten hats Intel immer vehement.

Gerüchte mutmassten, dass wenn ihre Grafik so schlecht wäre, würde die eh Keiner kaufen, weil;

Wie immer bei Intel und so typisch: Entweder total überteuert für das Gebotene, oder aber derart wettbewerbsunfähig, dass Keiner mit Verstand zulangt.

Viele unkten damals, dass wahrscheinlich die Einzigen, die das Ding überhaupt verbauen würden, wären OEMs (weil sie auch die Einzigen wären, die Intel dafür bezahlen würde können, eben genau das zu tun).

Und natürlich, es kam was kommen musste: Bestätigung der gerüchtenweisen Unkerufe hatten wir, als es hiess, dass Intel DG1 nur OEMs zur Verfügung stellen würde. Tada! Wieder mal.

AnandTech.com: Intel’s DG1 GPU Coming to Discrete Desktop Cards Next Year; OEM-Only

Im Grossen und Ganzen haben sich im Grunde praktisch fast alle Gerüchte als wahr herausgestellt. Weil, nach all der Propaganda und dem FUD und trotz all des versenkten Geldes, kann Intel mal wieder nicht liefern -- und das ist am Ende des Tages das Einzige was zählt. Traurig, weil wahr!

…weiß TechFA