Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

News Diskrete Intel-Grafik DG1: Iris Xe Max mit 96 EUs und 4 GByte LPDDR4X bei 25 Watt

Kenshin_01

Commander

- Registriert

- Okt. 2006

- Beiträge

- 2.134

Sollte das nicht Zweikampf heißen? Hier klopfen sich doch derzeit nur NV und AMD...oder hab' ich was anner Brille?IM Erika schrieb:Intel greift in den Dreikampf ein, jetzt wirds spannend!

noxcivi

Lieutenant

- Registriert

- Juni 2007

- Beiträge

- 765

Es ist ein eigens erstelltes Stück Silizium. Doch du hast schon recht, dass Intel sicherlich einfach die unnützen Funktionseinheiten von Tiger Lage (CPU-Kerne und Perepherie-I/O) weggelassen und den Rest per copy+paste zusammengesetzt hat. Beide haben einen L3-Cache, Speichercontroller, Encoder, Decoder, Displaycontroller und PCIe-4.0-Controller (und die eigentlichen Xe-Grafikkerne ^^).pipip schrieb:Kurze Frage. Aber ist das nicht einfach nur ein Tiger Lake auf einem PCB, LPDDR4 Speicher und deaktiverter CPU?

Oder sprechen wir da wirklich von eine reinen GPU Chip?

USB-Kabeljau

Banned

- Registriert

- Aug. 2018

- Beiträge

- 3.285

Hab ich jetzt auch nicht verstanden.Klassikfan schrieb:Eine diskrete Grafik auf dem Niveau der integrierten Grafik von Intel für das Notebooksegment, wo eh eine iGPU drin ist?

Und dann hat man außerdem wieder den Nachteil, dass man keinen Shared Memory hat.

Wozu soll das gut sein?

AlphaKaninchen

Captain Pro

- Registriert

- Mai 2018

- Beiträge

- 3.679

Das finde ich interessant... Und steigert nur die Hoffnung auf eine richtige Monster APU* bzw SoC, @Apple @AMD @intel @QualcomDoch nicht immer ist die diskrete GPU dabei von Vorteil, aufgrund von Latenzen und anderen Umständen kann die integrierte Einheit schneller sein.

*Der Chip der Xbox Series X wäre für mich die Untergrenze aber haben will ich eigentlich 12 Zen 2 Kerne, 80 RDNA 2 Kerne, 32GB Unified HBM 2 RAM / L4 Cache oder etwas leistungsmässig vergleichbares, halt ein Chip der alles Zersägt. Mit Chiplets muss das doch machbar sein.

mgutt

Commander

- Registriert

- März 2009

- Beiträge

- 2.074

Draco Nobilis schrieb:Also Intel 25W CPU/GPU + Intel 25W ded GPU schaffen es Nvidia zu besiegen?

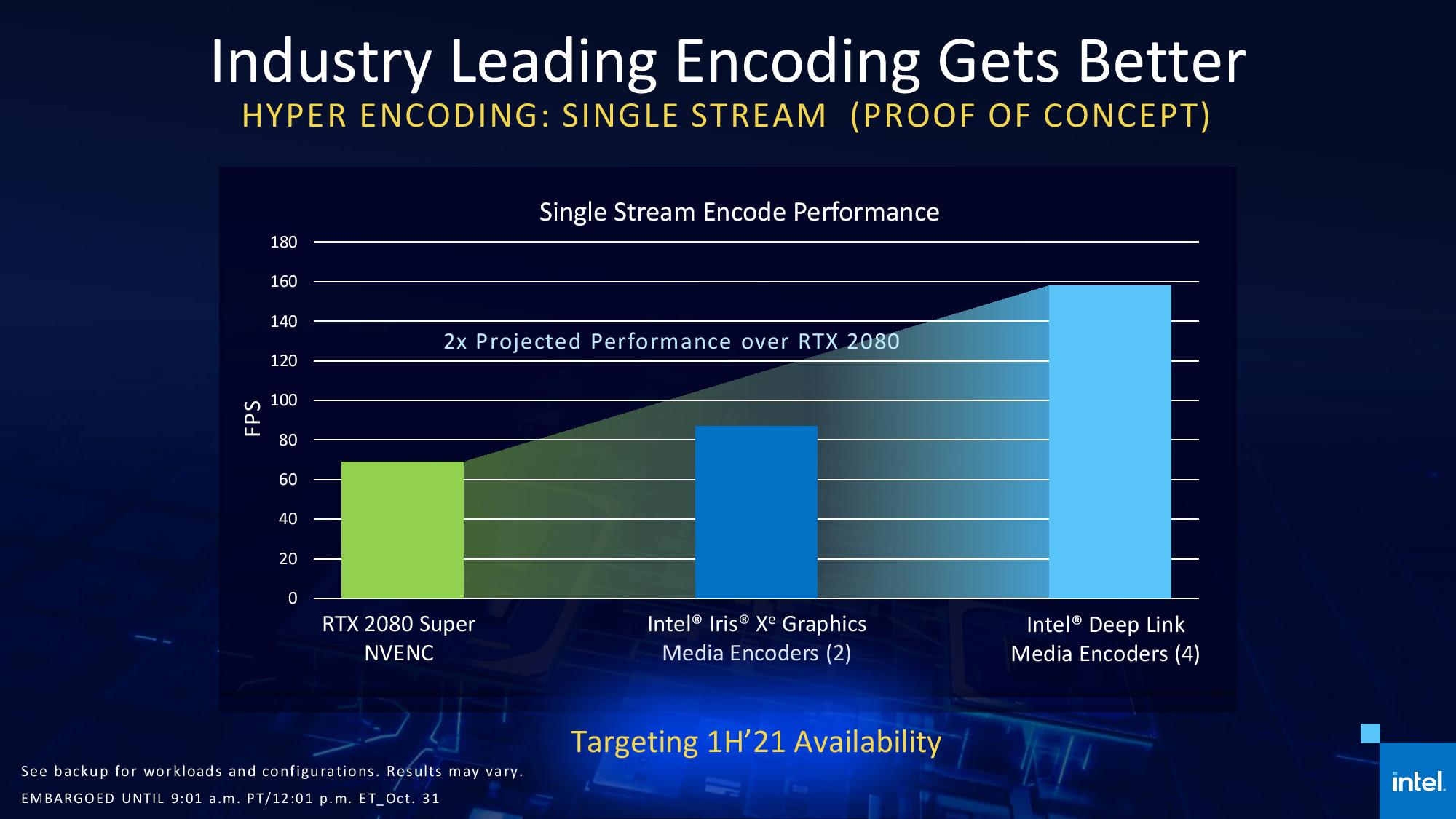

Nein, nur die einzelne dGPU "besiegt" Nvidia, da die iGPU beim Spielen ja gar nicht verwendet wird. Und beim Videorendering oder ähnlichen latenz-unkritischen Prozessen können sogar beide Intel GPUs benutzt werden und in der Disziplin dürfte das so einige Nvidia Modelle ausstechen.

Schade, dass man iGPU und dGPU nicht so verbinden kann, dass man beide zum Spielen verwenden kann. Oder gibt es heute bereits Spiele, die eine Nvidia dGPU und eine Intel iGPU nutzen? Vielleicht für eine "Nebenaufgabe" wie das Berechnen von Menüs und Karten oder so?!

Nö, jetzt wird noch gar nix spannend. Aber wenn Intel am Ball bleibt, könnte es mittelfristig spannend werden.IM Erika schrieb:Intel greift in den Dreikampf ein, jetzt wirds spannend!

Chismon

Fleet Admiral

- Registriert

- Mai 2015

- Beiträge

- 10.167

So eine gegenseitige (propriertaere) Verknuepfung von GPU mit CPU zwecks Leistungsoptimierung scheint nach der AMD/RTG RDNA2 Big Navi21 Vorstellung (mit dem Smart Access Leistungsbonus im Falle von ebenso genutzten Zen3 Vermeer Desktop-Prozessoren oder spaeteren Zen-Reihen Desktop-Prozessoren) wohl jetzt auch mit der Iris Xe Max bei Intel zu etablieren im Zusammenspiel mit Tiger Lake (nur im Notebook-/Mobil-GPU-Bereich vorerst).

Daraus koennte man ableiten, dass die Idee schon vor Raja Koduris Weggang von der RTG AMDs zu Intel existiert haben koennte und er eben fuer die Konkurrenz jetzt die Idee ebenso umsetzt.

Die einzigen, die mangels X86 Lizenz da vermutlich aussen vor bleiben sind nVidia und wie relevant/leistungstraechtig so eine Verknuepfung von CPU und GPU in Zukunft wird, wird man abwarten muessen.

Die Media-Encoder Leistung dieser Tiger Lake Iris Xe Max Combo-Loesung als auch der Deep Link Loesung (letztere deutlich eine RTX 2080 "Super" mit gerne gehyptem NVENC abhaengend) waere jedenfalls schon sehr beachtlich bis beeindruckend.

Da wird man bei nVidia dann wohl jetzt auch schauen, dass man die GPU-Technik besser/proprietaer mit der ARM-CPU-Architektur verknuepfen wird (wie Apple das vermutlich auch schon tun wird), zumindest ist das anzunehmen, denn die MX 350 GPU hat sowieso jetzt ausgedient (auch wenn es weiterhin Modelle damit und von Nachfolgemodellen geben wird, die i.d.R. aber eher wenig sinnvoll sind im sich immer mehr vergoldenen Zeitalter von APUs und nun auch solchen verknuepften propriertaeren Loesungen).

Daraus koennte man ableiten, dass die Idee schon vor Raja Koduris Weggang von der RTG AMDs zu Intel existiert haben koennte und er eben fuer die Konkurrenz jetzt die Idee ebenso umsetzt.

Die einzigen, die mangels X86 Lizenz da vermutlich aussen vor bleiben sind nVidia und wie relevant/leistungstraechtig so eine Verknuepfung von CPU und GPU in Zukunft wird, wird man abwarten muessen.

Die Media-Encoder Leistung dieser Tiger Lake Iris Xe Max Combo-Loesung als auch der Deep Link Loesung (letztere deutlich eine RTX 2080 "Super" mit gerne gehyptem NVENC abhaengend) waere jedenfalls schon sehr beachtlich bis beeindruckend.

Da wird man bei nVidia dann wohl jetzt auch schauen, dass man die GPU-Technik besser/proprietaer mit der ARM-CPU-Architektur verknuepfen wird (wie Apple das vermutlich auch schon tun wird), zumindest ist das anzunehmen, denn die MX 350 GPU hat sowieso jetzt ausgedient (auch wenn es weiterhin Modelle damit und von Nachfolgemodellen geben wird, die i.d.R. aber eher wenig sinnvoll sind im sich immer mehr vergoldenen Zeitalter von APUs und nun auch solchen verknuepften propriertaeren Loesungen).

Zuletzt bearbeitet:

borizb

Rear Admiral

- Registriert

- Nov. 2011

- Beiträge

- 5.187

Nvidia bietet ja den Xavier an mit 15-30W inklusive ARM CPU und 1,4 Tflops an Leistung, ermöglichtv_ossi schrieb:Ist fraglich, ob sich das für NVidia noch lohnt. Intel und AMD haben jetzt beide recht potente iGPUs im Angebot. Zudem wird Intel das auch finanziell attraktiv gestalten.

Kann mir durchaus vorstellen, dass man zukünftig nur noch das margenreichere High End Segment bedient.

durch eine schmale Volta GPU: https://en.wikipedia.org/wiki/Tegra#Xavier . So eine Mini Volta o.ä scheint

sich integriert oder dediziert zu einer Intel CPU nicht zu lohnen. Man erinnere sich mit Entsetzen an

diese unheilige Intel APU Kaby Lake-G 8706G von damals 🤢 Mit Tegra oder Xavier SoCs verdienen die

nicht nur besser, sondern Sie können das Produkt ohne Einschränkung nach eigenem Wunsch designen.

Intel scheint hier gezielt Boden gut machen zu wollen im Marktsegment, das Apple mit seinem Macbook

(Pro) bedient. Vermutlich war eine solche CPU/GPU Kombi ursprünglich für diese Geräte geplant, ist aber

zu spät fertig geworden. Erst CPUs mit bigLITTLE und jetzt GPUs mit Render-exklusivem-SLI. Wohin führts?

Opa Hermie schrieb:Diskrete GPU? Kann man damit endlich anonym verbotene Videos streamen?

Ich fand diese Beschreibung früher auch sehr seltsam bis ich rausfand dass es vom Lateinischem "trennen" kommt

und nicht von der französischen Ableitung ("verschwiegen/unauffällig").

Ergänzung ()

Wieso? Die meistverbreitetesten Gaming-GPUs haben doch auch Cloudzugriff(Geforce Experience)?firejohn schrieb:„Cloud-Zugriff“ mööp

Ghostshield

Lt. Junior Grade

- Registriert

- Apr. 2012

- Beiträge

- 481

Jetzt kommt Intel mit einer Art SLI / Hybrid Crossfire was die beiden anderen Parteien aufgegeben haben, weil es Schrott ist und bleibt.

- Registriert

- Jan. 2018

- Beiträge

- 20.631

AlphaKaninchen schrieb:... haben will ich eigentlich 12 Zen 2 Kerne, 80 RDNA 2 Kerne, 32GB Unified HBM 2 RAM / L4 Cache oder etwas leistungsmässig vergleichbares...

Und dann 500 Watt TDP auf engstem Raum?

Ergänzung ()

Ghostshield schrieb:... mit einer Art SLI / Hybrid Crossfire...

Aber anscheinend nicht im Gaming Bereich

Inxession

Captain

- Registriert

- Sep. 2008

- Beiträge

- 3.701

daivdon schrieb:Wieso? Die meistverbreitetesten Gaming-GPUs haben doch auch Cloudzugriff(Geforce Experience)?

Nicht jeder GeForce Besitzer installiert/nutzt Experience.

Wenn es sich vermeiden lässt, verzichte ich gutmöglichst auf Cloud Dienste.

Dieses Always Online ist meiner Meinung nach nichts positives.

Hat generell auch LAN Partys getötet..

Volkimann

Captain

- Registriert

- Jan. 2014

- Beiträge

- 3.077

Das wird für nvidia evtl eine Recht schmerzhafte Sache, sollte Intel entsprechend wieder Rabatte geben beim Kauf von CPU + diskr. GPU. Ob und was die Wettbewerbswächter da machen, sei dahingestellt.

AMD tangiert das eher überhaupt nicht, weil sie zwar im Notebook Markt im kommen sind, aber ihre APUs entweder solo lassen oder ihre eigenen GPUs holen und nvidia evtl den Herstellern die diskr. GPU preislich schmackhafter machen muss.

Verlierer ist in dem Fall mit Sicherheit nvidia im Notebook Bereich, abgesehen von sündhaft teuren Gaming Laptops.

AMD tangiert das eher überhaupt nicht, weil sie zwar im Notebook Markt im kommen sind, aber ihre APUs entweder solo lassen oder ihre eigenen GPUs holen und nvidia evtl den Herstellern die diskr. GPU preislich schmackhafter machen muss.

Verlierer ist in dem Fall mit Sicherheit nvidia im Notebook Bereich, abgesehen von sündhaft teuren Gaming Laptops.

Zero Cool

Captain

- Registriert

- März 2006

- Beiträge

- 3.581

Makso schrieb:Bis jetzt nur Papier Lakes nicht mehr nicht weniger. Ich/wir brauchen jetzt nicht das AMD & Intel dessen Positionen tauschen. 50% 50% Marktanteil wäre super.

Ich wünsche mir das AMD und Intel sich gegenseitig puschen und anspornen besseres zu erfinden. Momentan sieht es aus das Intel den Anschluß verloren hat und AMD denen gewaltig in den Arsch tritt. Meiner Meinung nach war das schon lange fällig.

Zuletzt bearbeitet:

Ähnliche Themen

- Antworten

- 256

- Aufrufe

- 34.654

K

- Antworten

- 19

- Aufrufe

- 4.035

- Antworten

- 42

- Aufrufe

- 14.006