Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Test Nvidia GeForce RTX 5090 im Test: DLSS 4 MFG trifft 575 Watt im 2-Slot-Format

Die wird es nicht geben, weil der Vollausbau bei den Profikarten landen wird und dort deutlich teurer verkauft werden kann.lord_mogul schrieb:Warten wir mal auf die 5090 Ti, die kann dann UE5 auch in UHD in vollen 3840x2160 mit 60 FPS schaffen.

syfsyn

Admiral

- Registriert

- Nov. 2010

- Beiträge

- 8.901

nvidia kümmert den consumer markt gar nicht mehr

Die hauen da die Schlechtesten gb202 gb203 gb205 raus um alle guten im profi segment zu verkaufen darum die arg schlechte Verfügbarkeit.

ein gb202 hat physisch 192sm 180sm sind nutzbar die werden sicher zur quadro (180$ chip)

ein gb203 hat 128sm nutzbar 112sm (80$ chip)

ein gb205 hat 80sm nutzbar 70sm (60$ chip)

ein gb206 hat 48sm nutzbar 42sm (36$ chip)

ein gb207 ist ein chip mit 32sm nutzbar 30sm und die gehen komplett an laptops (24$ chip )

und ja es gibt keinen chip mit 4 gpc das sind alles Rechtecke abseits von gb202 und gb203

Diese gen ist auf maximalen profit ausgelegt. Was normal ist aber schlampiges pcb design Streichen von features die in hardware funktionieren würden und irre tbp mit zu schlechten chips Sprich den Abfall vom wafer für maximalen preis.

Das muss mit ignorieren belohnt werden

ada war schon an die grenze dessen was als sku planen konnte insbesondere vram und aktive sm

blackfail is ne ohrfeige an die Spieler.

Die hauen da die Schlechtesten gb202 gb203 gb205 raus um alle guten im profi segment zu verkaufen darum die arg schlechte Verfügbarkeit.

ein gb202 hat physisch 192sm 180sm sind nutzbar die werden sicher zur quadro (180$ chip)

ein gb203 hat 128sm nutzbar 112sm (80$ chip)

ein gb205 hat 80sm nutzbar 70sm (60$ chip)

ein gb206 hat 48sm nutzbar 42sm (36$ chip)

ein gb207 ist ein chip mit 32sm nutzbar 30sm und die gehen komplett an laptops (24$ chip )

und ja es gibt keinen chip mit 4 gpc das sind alles Rechtecke abseits von gb202 und gb203

Diese gen ist auf maximalen profit ausgelegt. Was normal ist aber schlampiges pcb design Streichen von features die in hardware funktionieren würden und irre tbp mit zu schlechten chips Sprich den Abfall vom wafer für maximalen preis.

Das muss mit ignorieren belohnt werden

ada war schon an die grenze dessen was als sku planen konnte insbesondere vram und aktive sm

blackfail is ne ohrfeige an die Spieler.

DerRico

Lt. Commander

- Registriert

- Nov. 2022

- Beiträge

- 1.985

Hat jetzt lange gedauert, bis gestern endlich meine kam. Kein Wunschmodell die phantom, aber erstaunlich leise. Für die 4090 habe ich 1900 bekommen, die 5090 kostet 2.400. 500 Wertverlust in 2 Jahren (natürlich Kapitalkosten nicht berechnet), dafür immer die schnellste Karte, finde ich voll okay.

Der Stillstand hat einen Vorteil - die Karten sind wahnsinnig preisstabil.

Die Karte ist tatsächlich auch besser, als sie hier im ersten Test wegkam: Undervolten führt zu noch einmal besseren Ergebnissen, nur das Powerlimit senken lässt gute 30W weniger Verbrauch bei gleicher Leistung liegen.

Insofern ist sie eben doch auch effizient und auf knapp unter 400W im echten spielbetrieb pfeilschnell und gut kühlbar.

Ob man das braucht ist eine andere Frage, aber die mehr-FPS zur 7900xtx spürt man in 4k deutlich. Hoffe, AMD zieht ggf. doch nach.

Halten bis zur 6090 werde ich die Karte nicht: die nächsten Karten kommen in 2N statt 5N - das sind 3 Nodes, das wird ein brutaler Fortschritt in jeder Hinsicht, wie bei 3090 zu 4090.

Der Stillstand hat einen Vorteil - die Karten sind wahnsinnig preisstabil.

Die Karte ist tatsächlich auch besser, als sie hier im ersten Test wegkam: Undervolten führt zu noch einmal besseren Ergebnissen, nur das Powerlimit senken lässt gute 30W weniger Verbrauch bei gleicher Leistung liegen.

Insofern ist sie eben doch auch effizient und auf knapp unter 400W im echten spielbetrieb pfeilschnell und gut kühlbar.

Ob man das braucht ist eine andere Frage, aber die mehr-FPS zur 7900xtx spürt man in 4k deutlich. Hoffe, AMD zieht ggf. doch nach.

Halten bis zur 6090 werde ich die Karte nicht: die nächsten Karten kommen in 2N statt 5N - das sind 3 Nodes, das wird ein brutaler Fortschritt in jeder Hinsicht, wie bei 3090 zu 4090.

Glückwunsch zur Karte, da bist du ja in der Relation preislich noch gut bei weggekommen.DerRico schrieb:Halten bis zur 6090 werde ich die Karte nicht: die nächsten Karten kommen in 2N statt 5N - das sind 3 Nodes, das wird ein brutaler Fortschritt in jeder Hinsicht, wie bei 3090 zu 4090.

Ich bin tatsächlich gespannt, ob der Sprung zu 2nm wirklich erfolgt. Die Anbieter (hoffentlich bietet nicht nur TSMC hier ein gutes Produkt) werden sich die umfängliche Forschungsarbeit gut bezahlen lassen. Bei Nvidia geht es ja auch immer um Kapazitäten. Gibt es da abseits der Gerüchte um 18a/Samsung irgendwelche belastbaren Aussagen seitens Nvidia?

Sollte es so kommen, werden die Preise auf jeden Fall explodieren.

DerRico schrieb:Halten bis zur 6090 werde ich die Karte nicht: die nächsten Karten kommen in 2N statt 5N - das sind 3 Nodes, das wird ein brutaler Fortschritt in jeder Hinsicht, wie bei 3090 zu 4090.

Neben Mehrleistung auch TDP-Klassen wieder runter. Das ist doch absurd, wenn Grafikkarten ~500W schlucken und so riesige Kühler brauchen, sodass einem die Montage und Demontage nervt, weil man schlecht rankommt. Vorallem der Stromverbrauch und die abzuführende Abwärme bitte runter.

Zuletzt bearbeitet:

DerRico

Lt. Commander

- Registriert

- Nov. 2022

- Beiträge

- 1.985

Es ist für mich vor allem eine Frage der Effizienz - Ich hatte - als die Specs mal klar waren - auf 30-40% Mehrleistung bei gleichem Verbrauch gehofft.Banger schrieb:Neben Mehrleistung auch TDP-Klassen wieder runter. Das ist doch absurd, wenn Grafikkarten ~500W schlucken

Meine 4090 hat mit meinem UV in Games zwischen 220 und 290W gebraucht (spiele kein Metro ;-). Dafür gab es Frames satt. Die 7900xtx kriege ich nicht auf das Niveau. Bei der 5090 muss ich noch fummeln, aber unter 300W geht bisher gar nichts. Sie ist aber weniger schlecht, als im Test, wo einfach nur begrenzt wurde, wenn man die Spannung der GPU anpasst.

Ich kann mir nichts anderes vorstellen. Es sind 2 Jahre Zeit und der (die?) Node wird ja erfolgreich gerade ausgerollt. 5N ist einfach am Ende - sieht man ja schon beim Vergleich zur RX9070. Schon der "echte" 4N bringt fast 1/4 mehr Packdichte und vor allem deutliche mehr Takt und Effizienz. Daher ist AMD auch wieder dran. Ist wie bei RDNA2. Da hatte AMD natürlich auch den damals revolutionären Riesencache "erfunden" und ein gutes Design, aber die Fertigung bei TSMC war halt auch viel besser als die von NV beim Samsung.Neubauten schrieb:Ich bin tatsächlich gespannt, ob der Sprung zu 2nm wirklich erfolgt.

Billig wird das natürlich nicht. Ggf. muss man halt das Lineup aufsplitten: 2N für die Grossen Karten, 3N für die kleinen. Auch AMD mischt ja schon z.B. bei den Prozessoren munter durch.

Von der Verfügbarkeit sehe ich kein Problem: Aktuell wird eine Fab nach der anderen hochgezogen, die Zahl der Wafer steigt und steigt. Da fallen die paar Consumer-GPUs kaum noch ins Gewicht.

syfsyn

Admiral

- Registriert

- Nov. 2010

- Beiträge

- 8.901

Für ne effizientere sku hätte nvidia ein neuen Node benötigt der ist da

n3 war wohl ursprünglich geplant gewesen anders lassen sich pcb und schiere Größe des chips nicht erklären

Wenn man den n3 node durchplant kommt man auf grob 622mnm² Statt den 756mm² das wäre deutlich mehr chips gewesen. 87 vs 66

Der chip wäre nur als sku bis maxed 415w gekommen dann würden die ganzen Probleme die es derzeit mit gb202 gibt nicht geben und man hätte auf 3,00ghz gehen können.

preise sind zugegeben etwas höher aber man hätte weniger Kapazitätsprobleme da n3 ausgebaut wird wo n5 langsam abgebaut wird womit wafer schwierig sind zu bekommen darum die Knappheit derzeit

Man sieht an amd n4 node der derzeit auch ausgebaut wird das es da keine Kapazitätsprobleme gibt darum macht die Entscheidung für n5 auch keinen Sinn außer dem ceo ist es völlig egal da der Fokus auf ai liegt und alles was an n4 bekommen kann auf n4 ai Beschleuniger produziert wird.

Sprich dgx und hpc chips wie den gb200

Das dies aber ne Blase ist weis er selber darum noch schnell alles herausholen was geht und mit dem refresh auf n4 die rtx50 Serie als rtx60 nochmal 2026 bringen und als blackfail fixed kommt.

Während man noch stillheimlich samsung sf4 für ga107 chips als physx Beschleuniger akä entry gpu verkauft

Mit dem node Wechsel fixed man die meisten Probleme.

gb302 450w +-5% 90class 170sm 2,6ghz 36gb

gb303 250w +- 5% 80class 90sm 24gb

gb305 200w +-5% 70class 56sm 18gb

gb306 100w +-5% 60class 42sm 12gb

ga107 85w +16% akä equal rtx3060 name vermutlich rt6010 150€ 24sm 8gb

Darauf also 2028 mit feynman sich dann ganz aus dem Desktop verschwindet und voll auf ai pc mit dgx x86 pc am markt aufstellt und ja auch mit nenn pcie slot für die rt6010 x4 angebunden

feynman wird vermutlich mit a16 produziert und als apu kommen auf intel foveros packaging mit ner intel x86 dann beast lake cpu haben

Das gute das Verspricht ordentlichen Schub und dank bspd auch skaliert bis zum doppelten von heute bei halben verbrauch.

quasi apu system mit 450w doppelte rtx5090 perf. 3000$

apu system mit 250w und rtx5090 perf. 2000$

Darunter die entry modelle bis 150w xbox pc kompatibel 800$

ich vermute das nvidia den aib dann als mainboard brand dann Komplettsystem Lizenzen gibt quasi mit dem ga107 inklusive und leichte tbp Spielraum bis +40% für die zusätzliche gpu auf dem board die verlötet ist

Mit dieser Strategie könnte man die ai blase weiter melken und zugleich ne basis haben für Konsolen fähigen pc und quasi den aib die pc preise diktieren da man komplette pc verkauft und es damit keinen Handel mehr gibt.

Das macht mehr Sinn als wenn man den Aktionären die schwachen rückläufigen gewinne bei den desktop gpu verkünden müsste.

n3 war wohl ursprünglich geplant gewesen anders lassen sich pcb und schiere Größe des chips nicht erklären

Wenn man den n3 node durchplant kommt man auf grob 622mnm² Statt den 756mm² das wäre deutlich mehr chips gewesen. 87 vs 66

Der chip wäre nur als sku bis maxed 415w gekommen dann würden die ganzen Probleme die es derzeit mit gb202 gibt nicht geben und man hätte auf 3,00ghz gehen können.

preise sind zugegeben etwas höher aber man hätte weniger Kapazitätsprobleme da n3 ausgebaut wird wo n5 langsam abgebaut wird womit wafer schwierig sind zu bekommen darum die Knappheit derzeit

Man sieht an amd n4 node der derzeit auch ausgebaut wird das es da keine Kapazitätsprobleme gibt darum macht die Entscheidung für n5 auch keinen Sinn außer dem ceo ist es völlig egal da der Fokus auf ai liegt und alles was an n4 bekommen kann auf n4 ai Beschleuniger produziert wird.

Sprich dgx und hpc chips wie den gb200

Das dies aber ne Blase ist weis er selber darum noch schnell alles herausholen was geht und mit dem refresh auf n4 die rtx50 Serie als rtx60 nochmal 2026 bringen und als blackfail fixed kommt.

Während man noch stillheimlich samsung sf4 für ga107 chips als physx Beschleuniger akä entry gpu verkauft

Mit dem node Wechsel fixed man die meisten Probleme.

gb302 450w +-5% 90class 170sm 2,6ghz 36gb

gb303 250w +- 5% 80class 90sm 24gb

gb305 200w +-5% 70class 56sm 18gb

gb306 100w +-5% 60class 42sm 12gb

ga107 85w +16% akä equal rtx3060 name vermutlich rt6010 150€ 24sm 8gb

Darauf also 2028 mit feynman sich dann ganz aus dem Desktop verschwindet und voll auf ai pc mit dgx x86 pc am markt aufstellt und ja auch mit nenn pcie slot für die rt6010 x4 angebunden

feynman wird vermutlich mit a16 produziert und als apu kommen auf intel foveros packaging mit ner intel x86 dann beast lake cpu haben

Das gute das Verspricht ordentlichen Schub und dank bspd auch skaliert bis zum doppelten von heute bei halben verbrauch.

quasi apu system mit 450w doppelte rtx5090 perf. 3000$

apu system mit 250w und rtx5090 perf. 2000$

Darunter die entry modelle bis 150w xbox pc kompatibel 800$

ich vermute das nvidia den aib dann als mainboard brand dann Komplettsystem Lizenzen gibt quasi mit dem ga107 inklusive und leichte tbp Spielraum bis +40% für die zusätzliche gpu auf dem board die verlötet ist

Mit dieser Strategie könnte man die ai blase weiter melken und zugleich ne basis haben für Konsolen fähigen pc und quasi den aib die pc preise diktieren da man komplette pc verkauft und es damit keinen Handel mehr gibt.

Das macht mehr Sinn als wenn man den Aktionären die schwachen rückläufigen gewinne bei den desktop gpu verkünden müsste.

Seit ein paar Wochen beobachte ich eine 5090 bei Alternate und seit 1 Woche ist diese durchgehend auf Lager / bestellbar

die Verfügbarkeit hat sich anscheinend eingependelt, allerdings sinken die Preise bisher nicht

3200 Euro sind mir zu viel für die geringe Mehrleistung

die Verfügbarkeit hat sich anscheinend eingependelt, allerdings sinken die Preise bisher nicht

3200 Euro sind mir zu viel für die geringe Mehrleistung

Entrovis

Ensign

- Registriert

- März 2025

- Beiträge

- 236

könnte einer hier mal jemand ausrechnen, was 3nm anstatt 4nm bewirken könnten (insofern überhaupt möglich)? Also wie viel Fläche und gegebenfalls TDP könnten eingespart werden?

Ich weiß wirklich nicht was Nvidia hier geritten hat - möglich wäre es bestimmt gewesen in 3nm zu fertigen.

Das einzig plausible: Die gleichen chips in 1-2 Jahren im neuesten Fertigungsprozess als RTX6000 veröffentlichen - das würde auch den Stark beschnittenen GB202 erklären. Mehr Takt und Vollausbau wäre eine perfekte RTX6090 für 3000-3500€ 😞

Ich weiß wirklich nicht was Nvidia hier geritten hat - möglich wäre es bestimmt gewesen in 3nm zu fertigen.

Das einzig plausible: Die gleichen chips in 1-2 Jahren im neuesten Fertigungsprozess als RTX6000 veröffentlichen - das würde auch den Stark beschnittenen GB202 erklären. Mehr Takt und Vollausbau wäre eine perfekte RTX6090 für 3000-3500€ 😞

Zuletzt bearbeitet:

syfsyn

Admiral

- Registriert

- Nov. 2010

- Beiträge

- 8.901

-40% chipfläche bei den alu derzeit sind das 44% chipfläche

-0% bei sram und si derzeit 31% sram 10% si 5% displayengine und en und decoder

Die folge dadurch sinkt die chipfläche der alu auf nur noch 26%

man wäre gezwungen gewesen den sram zu verkleinern und das Si zu verkleinern

am ende wären es bei 384bit und 64mb L2 dann 411mm² chip geworden

Der Takt wäre bei 3,1ghz gewesen bei nur 480w tbp

Blackwell wurde mit Fokus auf ai workloads designt der L2 läuft ins leere und die software exkludiert 32bit cuda was zur folge hat das nur der kompa Modus für directx legacy Modus greift in dx11 und früher

Und nur Spiele mit dem wrapper für dx12 ft 11 bis 9 dann die Vorteile von blackwell nutzen kann.

dx12 nativ sowie vulkan hat zudem das problem das dies nur mit rbar und hags funktioniert ansonsten greift der kompa Modus für dx11 in dx12 was die alu Auslastung auf 80 fp32 per sm reduziert von 128fp32 nativ schafft blackwell 96fp32 in dx12 mit hags und rbar

Das greift nicht immer.

Ogl ist schon seit ampere rtx30 auf 64fp32 per sm begrenzt

Die Architektur ist ein kompletter fail

Und das liegt primär am node der sram Größe und Software Beschneidung

Den die hardware kann es.

Ai ist ne fette blase und nützt dem Spieler nur mit den verbesserten algos fürs upscaling das braucht den dicken sram gar nicht.

Da wo es Sinn macht bei quadros ist es ein Segen den es hilft stark bei ai arbeiten in content creation und denoising. Also alles was post process läuft und ne fette Latenz hat.

Spiele sind Echtzeit Anwendungen daher kommt es da auf jede ms an

Wieso es keine extra gaming chips gibt nun das lohnt sich für nvidia nicht extra gaming chips zu designen

Ein wafer und chipdesign kosten Millionen und man braucht einige um nenn chip zu designen

Zwar wird viel emuliert aber man braucht echte chips um Gegenzuprüfen ob der plan aufgeht

Die Norm sind grob 3 Jahre für ein Endprodukt.

Daher weis ich das nach blackwell nix mehr kommt. Unklar ist was feynman wird ich tippe auf ne apu

Normalerweise wären schon erste Gerüchte zu design von rubin da aber da hört man nix nur ai und workstation hpc zeug

Und feynman wurde angekündigt womit erste gerüchte zu den apu mit der dritten dgx Serie kommen werden. release vermutlich 2028 rum

Dazwischen wird es blackwell refresh geben mit n4 node leichter Energieeinsparung mit noch mehr ai fokus. Und mehr vram verbaut dank 24gbit chips. Darauf kommt nix mehr.

Der Weg ist leider fix mir wäre ein ada design mit reduzierten sram mehr Takt und mehr vram lieber gewesen.

Das ist ein unrühmliches ende des desktop pc so wie wir ihn kennen jetzt kann man noch bis zu win 12 +- 2027 rum beruhigt den pc genießen danach wird alles zur quasi Konsole.

Ändern kann der Weg sich nur wenn die Industrie merkt das Ai grenzen hat. Die sind absehbar

-0% bei sram und si derzeit 31% sram 10% si 5% displayengine und en und decoder

Die folge dadurch sinkt die chipfläche der alu auf nur noch 26%

man wäre gezwungen gewesen den sram zu verkleinern und das Si zu verkleinern

am ende wären es bei 384bit und 64mb L2 dann 411mm² chip geworden

Der Takt wäre bei 3,1ghz gewesen bei nur 480w tbp

Blackwell wurde mit Fokus auf ai workloads designt der L2 läuft ins leere und die software exkludiert 32bit cuda was zur folge hat das nur der kompa Modus für directx legacy Modus greift in dx11 und früher

Und nur Spiele mit dem wrapper für dx12 ft 11 bis 9 dann die Vorteile von blackwell nutzen kann.

dx12 nativ sowie vulkan hat zudem das problem das dies nur mit rbar und hags funktioniert ansonsten greift der kompa Modus für dx11 in dx12 was die alu Auslastung auf 80 fp32 per sm reduziert von 128fp32 nativ schafft blackwell 96fp32 in dx12 mit hags und rbar

Das greift nicht immer.

Ogl ist schon seit ampere rtx30 auf 64fp32 per sm begrenzt

Die Architektur ist ein kompletter fail

Und das liegt primär am node der sram Größe und Software Beschneidung

Den die hardware kann es.

Ai ist ne fette blase und nützt dem Spieler nur mit den verbesserten algos fürs upscaling das braucht den dicken sram gar nicht.

Da wo es Sinn macht bei quadros ist es ein Segen den es hilft stark bei ai arbeiten in content creation und denoising. Also alles was post process läuft und ne fette Latenz hat.

Spiele sind Echtzeit Anwendungen daher kommt es da auf jede ms an

Wieso es keine extra gaming chips gibt nun das lohnt sich für nvidia nicht extra gaming chips zu designen

Ein wafer und chipdesign kosten Millionen und man braucht einige um nenn chip zu designen

Zwar wird viel emuliert aber man braucht echte chips um Gegenzuprüfen ob der plan aufgeht

Die Norm sind grob 3 Jahre für ein Endprodukt.

Daher weis ich das nach blackwell nix mehr kommt. Unklar ist was feynman wird ich tippe auf ne apu

Normalerweise wären schon erste Gerüchte zu design von rubin da aber da hört man nix nur ai und workstation hpc zeug

Und feynman wurde angekündigt womit erste gerüchte zu den apu mit der dritten dgx Serie kommen werden. release vermutlich 2028 rum

Dazwischen wird es blackwell refresh geben mit n4 node leichter Energieeinsparung mit noch mehr ai fokus. Und mehr vram verbaut dank 24gbit chips. Darauf kommt nix mehr.

Der Weg ist leider fix mir wäre ein ada design mit reduzierten sram mehr Takt und mehr vram lieber gewesen.

Das ist ein unrühmliches ende des desktop pc so wie wir ihn kennen jetzt kann man noch bis zu win 12 +- 2027 rum beruhigt den pc genießen danach wird alles zur quasi Konsole.

Ändern kann der Weg sich nur wenn die Industrie merkt das Ai grenzen hat. Die sind absehbar

Verak Drezzt

Fleet Admiral

- Registriert

- Jan. 2020

- Beiträge

- 11.189

Langfristig wird da sicherlich viel Potential stecken, insbesondere verbunden mit Robotics.

Die Kombination von beidem wird aber langfristig vermutlich auch für viel Ungemach bei Beschäftigungen, Einkommen durch Arbeit etc. und in der Folge auch für Staatseinnahmen haben.

Aber zunächst wird sich damit eine Menge Geld verdienen lassen. Nur nicht ohne gesellschaftliche Folgen.

Die Kombination von beidem wird aber langfristig vermutlich auch für viel Ungemach bei Beschäftigungen, Einkommen durch Arbeit etc. und in der Folge auch für Staatseinnahmen haben.

Aber zunächst wird sich damit eine Menge Geld verdienen lassen. Nur nicht ohne gesellschaftliche Folgen.

Northstar2710

Admiral

- Registriert

- Aug. 2019

- Beiträge

- 9.950

AthlonXP

Captain

- Registriert

- Apr. 2003

- Beiträge

- 3.291

Nvidia 5090 RTX FE 2099€

https://marketplace.nvidia.com/de-de/consumer/graphics-cards/

https://marketplace.nvidia.com/de-de/consumer/graphics-cards/

Robman86

Lt. Junior Grade

- Registriert

- Sep. 2012

- Beiträge

- 451

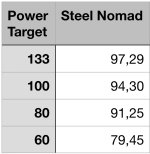

Schon krass was man in manchen Games an Leistung verliert. Eben jene, die das Powerlimit ausschöpfen oder wo es, wie z.B. bei Speed Way (Custom Explorer Mode @ UHD ohne Bewegen) bei weitem nicht für den vollen Takt (normal ja bis zu 2,7-2,8 GHz) ausreicht:

Mir ist klar, dass man das Powerlimit auch exakt auf einen Wert einstellen kann (nvidia-smi.exe). Da die meisten aber sicher nur die Powerlimit-Regler-Möglichkeit in der Nvidia App oder bei MSI Afterburner kennen, hab ich es eben auch so gemacht.

Ich nutze mal 500 oder 400 W. Kann mich bisher nicht so recht entscheiden.

Bei so einer insgesamt hohen Leistungsaufnahme finde ich selbst bis zu 75 W weniger Leistungsaufnahme nicht nichts. Und wie man oben sieht kaum fps-Verlust.

Die bis zu ~75 W ist i.d.R. schon das, was ein 9800X3D beim Zocken in aller Regel verbraucht.

Abwärme, Lüfter-rpm und auch der Anschluss sowie das Kabel zum Board werden positiv beeinflusst.

Da ich mit fps-limiter spiele (inkl. entsprechender Ingame-Konfiguration), und die meisten Spiele ja generell deutlich weniger das Powerlimit ausschöpfen (bei den Computerbase-Spielen waren es ja @UHD ohne fps-limiter 480 W im Durchschnitt), sehe ich meistens unter 400 W. Kommt natürlich auf die Spiele und deren Settings an.

In brenzligen Situationen (fps-limiter wird annähernd erreicht oder bereits erreicht) darf meine 5090 eben bis zu knapp 500 W erreichen und bricht fps-technisch kaum / deutlich weniger in dem Moment weg.

Ich kann mir vorstellen, dass es mittlerweile und zukünftig mehr Spiele geben wird, die in UHD mit RT 500+ W anlegen werden, sprich der Schnitt wäre vielleicht gar nicht mehr bei 480 W bzw. es kommt eh drauf an, welche und wie viele Spiele man in den Parkour aufnimmt.

- 100% PL (~575 W): ~2,48 GHz @ ~98 fps

- 90% PL (~517 W): ~2,25 GHz @ ~92 fps (ca. -10% W bei -6% fps)

- 87% PL (~500 W): ~2,19 GHz @ ~90 fps (ca. -13% W bei -8% fps)

- 78% PL (~450 W): ~1,93 GHz @ ~83 fps (ca. -21% W bei -15% fps)

- 70% PL (~400 W): ~1,72 GHz @ ~77 fps (ca. -30% W bei -21% fps)

Mir ist klar, dass man das Powerlimit auch exakt auf einen Wert einstellen kann (nvidia-smi.exe). Da die meisten aber sicher nur die Powerlimit-Regler-Möglichkeit in der Nvidia App oder bei MSI Afterburner kennen, hab ich es eben auch so gemacht.

Ich nutze mal 500 oder 400 W. Kann mich bisher nicht so recht entscheiden.

Bei so einer insgesamt hohen Leistungsaufnahme finde ich selbst bis zu 75 W weniger Leistungsaufnahme nicht nichts. Und wie man oben sieht kaum fps-Verlust.

Die bis zu ~75 W ist i.d.R. schon das, was ein 9800X3D beim Zocken in aller Regel verbraucht.

Abwärme, Lüfter-rpm und auch der Anschluss sowie das Kabel zum Board werden positiv beeinflusst.

Da ich mit fps-limiter spiele (inkl. entsprechender Ingame-Konfiguration), und die meisten Spiele ja generell deutlich weniger das Powerlimit ausschöpfen (bei den Computerbase-Spielen waren es ja @UHD ohne fps-limiter 480 W im Durchschnitt), sehe ich meistens unter 400 W. Kommt natürlich auf die Spiele und deren Settings an.

In brenzligen Situationen (fps-limiter wird annähernd erreicht oder bereits erreicht) darf meine 5090 eben bis zu knapp 500 W erreichen und bricht fps-technisch kaum / deutlich weniger in dem Moment weg.

Ich kann mir vorstellen, dass es mittlerweile und zukünftig mehr Spiele geben wird, die in UHD mit RT 500+ W anlegen werden, sprich der Schnitt wäre vielleicht gar nicht mehr bei 480 W bzw. es kommt eh drauf an, welche und wie viele Spiele man in den Parkour aufnimmt.

Zuletzt bearbeitet:

Ähnliche Themen

- Antworten

- 959

- Aufrufe

- 97.541

- Antworten

- 652

- Aufrufe

- 76.763

- Antworten

- 532

- Aufrufe

- 45.054

- Antworten

- 115

- Aufrufe

- 10.049

- Antworten

- 441

- Aufrufe

- 46.818