menace_one schrieb:

HDR in der Fotografie != HDR bei TV

Nein, eben genau nicht!

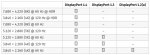

HDR in der Fotografie ist der Versuch, Motive mit sehr hohem Kontrastumfang, z.B. 1000:1 oder mehr, auf Medien darzustellen, die dazu aufgrund ihrer Beschränkungen gar nicht in der Lage sind. Diese Beschränkungen können einerseits physikalischer Natur sein, wie etwa die maximalen Kontraste, die LCDs darstellen können, andererseits aber auch in den verwendeten Datenformaten begründet sein. So hat JPG oder auch "normales" (herkömmliches) Video nur eine Farbtiefe von 8 bit, womit sich maximal 256 verschiedene Helligkeitsabstufungen pro Grundfarbe darstellen lassen. Mit sowas kann, vereinfacht gesagt, ein Kontrastumfang von mehr als 256:1 nicht sinnvoll dargestellt werden. Sonst ergibt sich in Flächen mit gleichmäßigen Farb- und / oder Helligkeitsverläufen unschönes Banding.

HDR in der Fotografie ist somit eine Dynamikkompression. Entsprechend flau sehen HDR-Fotos auch manchmal aus.

HDR für Video / TV, bisher auch Deep Color genannt, was ich eigentlich besser finde, ist genau der Versuch, diese Beschränkungen aufzuheben bzw. die Grenzen zu erweitern, so dass keine oder keine so starke Dynamikkompression nötig ist. Inzwischen gibt es ja Displaytechnologien die Kontraste bis deutlich über 1000:1 darstellen können.

Wobei die momentane Ausprägung mit anscheinend 10 bit Farbtiefe - gerade mal 2 bit mehr als bisher - wieder ganz typische Salamitaktik sind. Wenn schon, dann sollte man gleich auf 16 bit gehen, zumindest für das Datenformat. Das wäre dann echt zukunftssicher. So wie jetzt ist klar dass bestimmt schon nächstes Jahr, und damit wieder bevor auch nur die ersten Geräte mit DP 1.4 rausgekommen sind, die nächste Version nachgeschoben wird. Immer schön scheibchenweise...

koffeinjunkie schrieb:

Bevor das eine da ist, kommt das andere. Ich finde das mittlerweile einfach so hirnverbrannt bescheuert, dass mir echt die Worte fehlen. Nirgendwo Absprachen, nirgendwo was das richtig genormt ist und jeder will aber keiner macht so richtig. Statt gleich einen Sprung zu machen und einen Standard zu halten bis sich der Markt darauf einstellt, folge eine Ankündigung der nächsten.

Genau das ist das Problem... da kann einem total die Lust vergehen, weil man zu keinem Zeitpunkt mehr ein Gerät kaufen kann, das auch nur dem aktuellen Stand der Normung - soweit man hier überhaupt noch von Normung sprechen kann - entspricht, von Zukunftssicherheit ganz zu schweigen.

Ich werde wohl warten bis...

- die Displays wenigstens 12 bit Farbtiefe und Kontraste deutlich über 1000:1 - und zwar nicht nur auf Achse, sondern auch aus deutlich seitlicher Richtung - darstellen können, und das auch in nicht abgedunkelten Räumen. Die UHD Premium Vorgabe zur Spitzenhelligkeit - es müssen, zumindest örtlich - 1000 cd/m2 erreicht werden, und ganzflächig 540 - ist da in meinen Augen ein sehr wichtiger Schritt in die richtige Richtung,

- es ein Display gibt das gleichermaßen gut als TV und als Monitor taugt

- es ein Display gibt das alle sinnvollen Framerates verarbeitet, wohl etwa 15 bis 144 Hz, und das auch bei 3D Darstellung, und selbstverständlich unabhängig vom Hersteller der GraKa

- nicht nur alle (besseren, dann aktuellen) GraKas in der Lage sind, mindestens mit 12 bit Farbtiefe auszugeben, sondern auch

- alle gängige Bild- und Videobearbeitungs- und Darstellungssoftware,

- sich entsprechende Datenformate, die dafür Voraussetzung sind, etabliert haben

- das alles zu bezahlbaren Preisen erhältlich ist.

core2e6300 schrieb:

Die Komprimierung bei der Videoübertragung halte ich für eine schlechte Lösung. Dabei muss ja garantiert werden, dass die maximale Bandbreite der Schnittstelle nicht überschritten wird. D. h. im Notfall wird die Komprimierung hochgeschraubt (passiert natürlich alles im Hintergrund). Nicht, dass dann noch Artefakte entstehen.

Wenn es stimmt, dass nur maximal 3:1 komprimiert wird - und das erscheint aufgrund der Zahlen glaubwürdig - dann kannst Du das getrost vergessen.

Das bisschen Kompression ist völlig irrelevant im Vergleich zur Kompression der gängigen Video-Codecs, H264 und H265 / HEVC. Die liegt, grob gesagt, ums 100-fache höher! Und im TV-Bereich wird aufgrund der Kanalbandbreiten mit nochmals deutlich höheren Kompressionsraten gearbeitet. Solange der Wahnsinn mit 100en von Kanälen so weitergeht wird sich daran auch nichts ändern, die Distributionsbandbreite ist nun mal begrenzt. Ich fürchte daher dass wir im Fernsehen auch dann, wenn tatsächlich mal irgendwo in UHD und HDR / Deep Color und in HEVC ausgestrahlt wird weiterhin das beliebte Banding sehen werden, das mir schon heute, bei nur 720p, den Filmspaß verdirbt.