kugelwasser

Lieutenant

- Registriert

- Aug. 2012

- Beiträge

- 1.020

Ich versteh das irgendwie überhaupt nicht. Wenn man mal Counterstrike Go als Beispiel nehmen auf einem 60Hz Monitor:

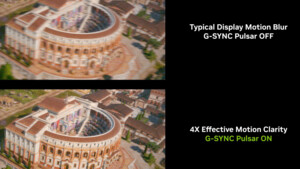

Dort ist es ohne Vsync ja erst richtig flüssig wenn man so ca. 100fps hat, und mit 60fps ohne vsync ist es hingegen ziemlich unflüssig. Aber das macht doch gar kein Sinn, denn der Monitor kann doch nur 60fps darstellen, also ist es doch egal ob die GPU 60fps darstellt oder 100fps. 100fps müssten doch dann sinnlos sein, weil davon nur 60fps verwendet werden können. Wo bleiben dann also die 40fps?

Danke schonmal.

Dort ist es ohne Vsync ja erst richtig flüssig wenn man so ca. 100fps hat, und mit 60fps ohne vsync ist es hingegen ziemlich unflüssig. Aber das macht doch gar kein Sinn, denn der Monitor kann doch nur 60fps darstellen, also ist es doch egal ob die GPU 60fps darstellt oder 100fps. 100fps müssten doch dann sinnlos sein, weil davon nur 60fps verwendet werden können. Wo bleiben dann also die 40fps?

Danke schonmal.

Zuletzt bearbeitet: