Spiele schreiben verschwindend wenig Daten. Lesen tun manche Spiele mehr. Aber dabei brechen SSDs nicht ein.Highspeed Opi schrieb:Wenn man permanent Daten schreibt und liest, also bei Spielen, ist ein Arbeitsspeicher nach wie vor deutlich überlegen.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

News Apex Storage X21: Adapterkarte vereint 21 M.2-SSDs zu 168 TB und 100 GB/s

- Ersteller MichaG

- Erstellt am

- Zur News: Apex Storage X21: Adapterkarte vereint 21 M.2-SSDs zu 168 TB und 100 GB/s

AndroidNougat7

Lt. Junior Grade

- Registriert

- Sep. 2020

- Beiträge

- 330

gehen da nd die Laufwerksbuchstaben (Windows) bzw. die Einhängepunkte (Unix/Linux) aus bei 21 zusätzlichen Laufwerken?

PS: bei meiner Steambibliothek könnte ich diese Adapterkarte und die vielen SSDs dazu gut gebrauchen

PS: bei meiner Steambibliothek könnte ich diese Adapterkarte und die vielen SSDs dazu gut gebrauchen

D

DieRenteEnte

Gast

Rehtsch schrieb:16 oder 32 GB RAM in Zeiten von Windows XP und Gothic 3 ?

Was entgeht mir hier ?

Gothic 3 gehörte zu den Spielen, die so schlecht programmiert wurden, dass tatsächlich die Festplatte (HDD) ans Limit kam und Mikroruckler verursachte und das außerdem sehr lange Ladezeiten in Spielen hatte.

Eine RAM-Disk war die ultimative Lösung für alles, solange es auf die 16-32 GB passte.

Abgesehen von Spielen, war das Rendern von Bildern oder Videos extrem schnell.

Dann kamen SSDs mit brauchbarer Kapazität für annehmbare Preise.

Die meisten (jungen) PC-Nutzer heute haben gar keinen Vergleich mehr.

Man kann einfach seine Spiele auf eine HDD installieren und die Unterschiede zu einer SSD vergleichen.

Je nach Spiel wird man direkt Mikroruckler bei Bewegungen/Drehungen oder enorm lange Ladezeiten feststellen.

Die Performance auf SSDs ist völlig ausreichend, dennoch kann man noch sichtbar mehr mit RAM-Disks herauskitzeln. Kommt wie erwähnt stark auf das Spiel an. (natürlich kein League of Legends, Minecraft oder irgendwelche Indie-Spiele)

Zuletzt bearbeitet von einem Moderator:

D

DieRenteEnte

Gast

Es ging zu der Zeit um HDDs vs RAM, nicht SSD vs RAM.Qarrr³ schrieb:Spiele schreiben verschwindend wenig Daten. Lesen tun manche Spiele mehr. Aber dabei brechen SSDs nicht ein.

Und dabei primär um die Zugriffszeiten und nicht Schreib- und Leseraten.

Und bis heute ist der RAM um Welten schneller als eine SSD, ganz besonders bei permanenter Belastung.

Die Lese- und Schreibraten spielten schon immer eine untergeordnete Rolle.

Außer im Marketing oder für Backups großer Dateien.

Zuletzt bearbeitet von einem Moderator:

Stahlseele

Vice Admiral

- Registriert

- Feb. 2009

- Beiträge

- 6.398

Wie viel soll so ein Ding kosten?

Wenn das tatsächlich nur ein Bifurcation Board ist, dann sollte es für um die 100 bis 200e machbar sein.

Und da würden mir auch 4 M.2 Slots reichen, weil damit eh der x16 am Board ausgelastet wird.

Und 4x2TB M.2 SSD kostet bei weitem weniger als eine 8TB . .

Wenn das tatsächlich nur ein Bifurcation Board ist, dann sollte es für um die 100 bis 200e machbar sein.

Und da würden mir auch 4 M.2 Slots reichen, weil damit eh der x16 am Board ausgelastet wird.

Und 4x2TB M.2 SSD kostet bei weitem weniger als eine 8TB . .

yetisports

Lieutenant

- Registriert

- Juli 2008

- Beiträge

- 779

Das klingt nach einem neuen "Holy sh*t" Video von Linus Tech Tips

Crass Spektakel

Lieutenant

- Registriert

- Juli 2015

- Beiträge

- 991

Das eigentliche Ärgernis an aktuellen Rechnern ist der Mangel an PCIE-Leitungen.

Ich kann in jedem Drecks-PC vier bis 20 SATA-Laufwerke ohne Leistungseinbrüche anschliessen.

Bei M.2 ist meistens schon die zweite SSD stark eingeschränkt und wer eine Mehrfachkarte einbauen will der darf die GPU opfern. Das alles wäre nicht so schlimm wenn es noch interessante HEDT-Plattformen gäbe (Threadripper, Xeon 3647) - aber gerade die sind ja auch gerade weggefallen.

Ich kann in jedem Drecks-PC vier bis 20 SATA-Laufwerke ohne Leistungseinbrüche anschliessen.

Bei M.2 ist meistens schon die zweite SSD stark eingeschränkt und wer eine Mehrfachkarte einbauen will der darf die GPU opfern. Das alles wäre nicht so schlimm wenn es noch interessante HEDT-Plattformen gäbe (Threadripper, Xeon 3647) - aber gerade die sind ja auch gerade weggefallen.

0x8100

Fleet Admiral

- Registriert

- Okt. 2015

- Beiträge

- 11.191

zum einen steht im artikel, dass ein pcie-switch verwendet wird (und mit dem kühlkörper schwer zu übersehen) und andererseits ist es gar nicht möglich mit bifurcation 21 devices an einem slot zu betreiben.Stahlseele schrieb:Wenn das tatsächlich nur ein Bifurcation Board ist, dann sollte es für um die 100 bis 200e machbar sein.

Telechinese

Lt. Commander

- Registriert

- Okt. 2022

- Beiträge

- 1.156

WA...

Ein unraid-NAS mit 168TB auf Briefkuvert-Größe! Sehr goil 🤣

Ein unraid-NAS mit 168TB auf Briefkuvert-Größe! Sehr goil 🤣

NOTAUS

Banned

- Registriert

- Juli 2014

- Beiträge

- 4.452

Aber dann wenigstens einen Supraleiter...DerBandi schrieb:32GB/s, da braucht man eigentlich kein RAM mehr. 😆

Hier muss man fairerweise sagen, dass sowohl AMD als auch Intel da nicht komplett dran vorbei entwicklen.Crass Spektakel schrieb:Das eigentliche Ärgernis an aktuellen Rechnern ist der Mangel an PCIE-Leitungen.

AMD:

AM5 hat 28 PCIe Lanes gegenüber AM4 mit 24 PCIe Lanes, die zusätzlichen 4 Lanes sind frei verwendbar, z.B. für einen weiteren an CPU angebundenen m.2 Slot.

Ärgerlich ist hier, dass das Chipset nur mit PCIe 4.0 x4 angebunden ist. Da hätte AMD auf PCIe 5.0 x4 setzen müssen um Bottlenecks zu vermeiden. Eventuell wäre das aber auch zu hitzig und energiehungrig gewesen.

Intel:

Die CPU bietet zwar weiterhin nur 20 PCIe Lanes, aber das versteckt, dass das Chipset mit 'DMI 4.0 x8', also vergleichbar zu PCIe 4.0 x8 angebunden ist. Wenn man die zählen würde, sind das auch 28 Lanes...

Das Z790 Chipset kann daraus nochmal 20 PCIe 4.0 und 8 PCIe 3.0 Lanes machen, das dürfte für die meisten Home-User erstmal genügend PCIe sein...

Boards mit 4 m.2 Slots sind teuer, aber verfügbar. Auf Intel Seite gibt es sogar ein paar Boards mit 5 m.2 Slots. Wir sind schon weit weg von den Zeiten mit Boards, die einen, vielleicht mal zwei m.2 Slots hatten...

Würde da der PCIe Switch das nicht völlig ausbremsen?Tada100 schrieb:Also mit 21 x 64 GB Optane SSD, könnte das ganze (je nach Anwendungsfall) interessant sein, mal unabhängig vom Preis.

Ich finde es schade, dass selbst Add-in Karten mit einem relativ kleinen PCIe Switch stark überteuert sind.

Beispiel: ASM2824; bietet 24 PCIe 3.0 Lanes, wahlweise mit 4x oder 8x Interface zum Host. Adapterkarten, die diesen nutzen, um mehr SSDs ohne Bifurcation an einem Slot anzuschließen, kosten 300-500€. Asmedia selbst bewirbt den Chip übrigens als "low-cost", gefertigt wird er wahrscheinlich in 28nm.

Beispiel: ASM2824; bietet 24 PCIe 3.0 Lanes, wahlweise mit 4x oder 8x Interface zum Host. Adapterkarten, die diesen nutzen, um mehr SSDs ohne Bifurcation an einem Slot anzuschließen, kosten 300-500€. Asmedia selbst bewirbt den Chip übrigens als "low-cost", gefertigt wird er wahrscheinlich in 28nm.

Mich würde eher interessieren in welchem Verbund die M2´s dann laufen.

Raid (x)? Jbod? Single Laufwerke?

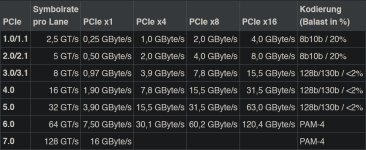

Und 107 GB/s über nur einen Pcie x16 Slot?

ist das nicht erst in gen 6 möglich? (derzeit haben wir 5 (max 63,0 GByte/s)

Bei mir wären mit Pcie 4 ja max. 31,5 GByte/s möglich, egal was die karte selber kann....

Raid (x)? Jbod? Single Laufwerke?

Und 107 GB/s über nur einen Pcie x16 Slot?

ist das nicht erst in gen 6 möglich? (derzeit haben wir 5 (max 63,0 GByte/s)

Bei mir wären mit Pcie 4 ja max. 31,5 GByte/s möglich, egal was die karte selber kann....

Anhänge

Lan_Party94

Commander Pro

- Registriert

- Jan. 2013

- Beiträge

- 2.992

LinkFliz schrieb:Das Teil wäre doch gar nicht notwendig, wenns endlich mal größerer M2 als 4 TB geben würde..

Gibt's doch schon.

Würde mich mal interessieren ob es da nicht evtl. eher zu Einbußen der Geschwindigkeit kommt als einzeln auf einem Mobo - schätze die werden ziemlich warm. 🤔

- Registriert

- Dez. 2010

- Beiträge

- 1.289

Die Frage von @Rehtsch lautet, wie Du unter Windows XP auf eine nutzbare RAM-Größe von 16-32 GB kommen willst. Windows XP (32 Bit) hat max. 4 GB unterstützt, wenn nicht auf PAE oder die 64 Bit-Variante zurückgegriffen wurde. Zumal auch die gängigen PC-Plattformen damals auch keine 16-32 GB unterstützt haben.Highspeed Opi schrieb:Eine RAM-Disk war die ultimative Lösung für alles, solange es auf die 16-32 GB passte.

Abgesehen von Spielen, war das Rendern von Bildern oder Videos extrem schnell.

SSDs kamen zu Zeiten von Windows 7... so ab 2008/2009 für die Masse in "bezahlbaren" GrößenHighspeed Opi schrieb:Dann kamen SSDs mit brauchbarer Kapazität für annehmbare Preise.

Vielleicht liegt es auch an den Märchen, die hier teilweise erzählt werden.Highspeed Opi schrieb:Die meisten (jungen) PC-Nutzer heute haben gar keinen Vergleich mehr.

Ich bestreite hier keinesfalls die Wirksamkeit vom RAM Disks oder entsprechenden Caches. Aber Deine Schilderung passt so nicht.

Grüße,

Christian (Ruckler bei Spielen von Doublespeed CD-Laufwerken erlebt habend)

- Registriert

- Aug. 2004

- Beiträge

- 26.043

Die 107GB/s sind Augenwischerei wenn ich nicht drankomme oder sie nutzen kann. Selbst wenn man von 2 separaten Arrays auf der Karte Daten verschiebt müssen die durch den PCIe Slot. Ergo man ist immer bei PCIe 4.0 x16 limitiert.

Ähnliche Themen

- Antworten

- 43

- Aufrufe

- 3.917

- Antworten

- 30

- Aufrufe

- 11.247

- Antworten

- 48

- Aufrufe

- 8.517

- Antworten

- 65

- Aufrufe

- 16.828

- Antworten

- 38

- Aufrufe

- 11.203