Erste Erkenntnisse auf die Frage, ob man Energie sparen kann, wenn man die Spannungswandler(VRM) auf dem Mainbaord besser kühlt....

Wenn ich das richtig interpretiert habe, ist der Bereich links von der CPU die VCore Versorgung und oberhalb die SOC Versorgung für Ramcontroller und iGPU....beides sind ungekühlte Mosfets.

Da Computerchips(CPU/GPU/DRAM) bei weniger Betriebstemperatur effizienter laufen, dachte ich mir, dass das auch für diese Mosfets gelten könnte.

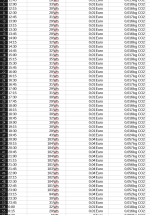

Also habe ich einen Test bei Cinebench R23 im 30Min Stresstest genutzt und 3DMark Timespy im Stresstest(

die 20 loops dauern grob 18 Min).

Dann habe ich passive Kühlkörper aufgebracht und den Test wiederholt.

Als das wenig eindeutig war, habe ich noch zusätzlich den Lüfter der Wraith Prism Kühlers(

100% rpm) über den CPU/SOC-VRMs positioniert.

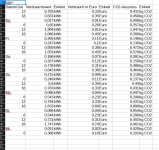

Da mein Infrarotthermometer die Temperaturen von so kleinen Bauteilen nicht zuverlässig messen kann, habe ich damit zumindest nach Hotspots gesucht und daraufhin zwei Temperaturfühler mit Wärmeleitpaste an einen high- und einen lowside Mosfet der SOC-VRMs befestigt.

Somit habe ich keine Informationen, ob die VCore-VRMs nach aufbringen der kleinen Kühlkörper wirklich kühler liefen...theoretisch sind Wärmekapazität und Oberfläche vergrößert.

Der SOC Bereich wird besser gekühlt, hier ist der Kühlkörper jedoch auch deutlich größer.

Die CPU wurde um 200MHz übertaktet...ihr PPT auf 120W erhöht und die iGPU von 1900 auf 2300 bei 1130mV übertaktet...der RAM lief bei 3666 Cl18 20 @1,45V.

Der Wraith Prism wurde seines Lüfters beraubt und ein bequiet 75mm Lüfter mit maximal 1900 rpm hat ihn ersetzt.

Ich zeige hier den Durchschnitt aus beiden Temperatursensoren.....im zweiten Diagramm habe ich mit dem Heatsink kurz danach einen weiteren Test angeworfen, weil ich mir unsicher war, ob der Kühler schon gesättigt war...das war er aber nahezu.

Die Raumtemperatur war in den letzten Tagen sehr konstant bei ca 22-22,5°C.

Das Infrarotthermomenter hatte ohne Kühlkörper für den CPU Bereich als Hotspot ca 60°C gefunden und im SOC Bereich ca. 65°C...der Temperatursensor am Highside Mosfet hatte maximal 67,7°C angezeigt und der am lowside Mosfet 66,7....das passt zusammen.

Also auch ohne Kühlkörper werden keine kritischen Temperaturen erreicht, was mich sehr überrascht hat.

Ich war davon ausgegangen, dass dieses Billigboard drosseln müsste, aber das war nicht der Fall.

ca. 55 statt 67°C am SOC sind ein gutes Ergebnis für den Heatsink, aber kein so großer Unterschied, dass ich große Effizienzvorteile erwarten würde.

...der Lüfter Drückt die gemessene Temperatur auf unter 34°C, was dann schon ein großer Unterschied ist.

Für die no Heatsink Variante habe ich leider nur eine Messreihe....für die anderen beiden sind es je drei, die ich gemittelt habe.

Mit viel Wohlwollen kann man in den Daten einen Trend erkennen....demnach sind die Vorteile am SOC völlig unbedeutend und am VCore Bereich werden ca 1,1% an Energie eingespart, solange der Lüfter verwendet wird....Der Prism Lüfter den ich hier verwendet habe brüllt jedoch vor sich hin und braucht grob 5W an Energie...diese sind in der Messung nicht enthalten, da ich ihn von einem anderen Rechner aus befeuert habe.

Der Heatsink macht also nichts aus...und der Lüfter verbraucht mehr, als man mit Effizienzverbesserung einspart.

Für Timespy sieht man übrigens auch keinen Trend in dem Vergleich von zwei Messungen:

Da sieht man nur statistische Schwankungen und ab und zu einen Lastpeak.

Anders bei den Cinebench Messungen:

Hier sieht man durchaus deutlicher einen Unterschied zwischen den Messungen mit und ohne Lüfter.

Auch fängt der Unterschied klein an, und wird mit der Dauer der Belastung größer.

Betrachte ich nicht die ganze Messung, sondern beispielhaft die Werte von 1446-1601 s dann sind es mit Lüfter trotzdem nur 1,3W weniger.

Also ich denke schon, dass sich hier ein echter Unterschied außerhalb der Messungenauigkeit zeigt, jedoch ist der Effekt so klein, dass man ihn ignorieren kann.

Performance Unterschiede

Einen Einfluss auf die Leistung gab es in Timespy nicht...die iGPU hat ihren Takt von 2300Mhz dauerhaft gehalten und die CPU hat sich gelangweilt.

Die FPS waren laut den Ergebnissen für alle 20 Durchläufe im Bereich von 10,71 bis 10,72 FPS...kein Trend...einfach konstant.

In Cinebench gibt es einen Abwärtstrend zu beobachten, da die CPU Temperatur leicht steigt und damit der Takt immer weiter sinkt:

Ein Verlust von bis zu 80 Punkten sind jedoch nur 0,7% und damit aus meiner Sicht vernachlässigbar.

Somit sind auch die Unterschiede bei der VRM Kühlung vernachlässigbar....die Unterschiede scheinen aber außerhalb der Fehlertolleranz zu liegen.

Wie man sieht startet der Verlauf mit Lüfter am stärksten und endet auf einem Level mit dem Verlauf ohne Heatsink.

Ich denke dass hier nicht die VRM Temperatur, sondern der Einfluss des Zusatzlüfters auf den CPU Kühler ausschlaggebend ist....da der Prism Kühler seine Luft entweder Richtung RAM oder Richtung Vcore-VRM auslässt, ist ein hoher Luftruck durch den Extralüfter über dem VCore-VRMs im Idle erstmal gut, da der ganze Bereich niedriger heruntergekühlt wurd(VRM Lüfter 3000 rpm..CPU Lüfter 960 rpm).

Wenn der Test startet, kann der erste Durchlauf noch davon profitieren, aber dann pustet der CPU Lüfter mit 1900 rpm gegen den VRM Lüfter an.

Mit Heatsinks aber ohne Lüfter war es im Ram minimal kühler....daher vermutlich der minimal höhere Verlauf und nicht wegen der VRM Kühlung....

Fazit zur VRM Kühlung

....Zumindest in diesem Fall kann man sich das sparen!

Es scheint einen Einfluss zu geben und bei 200W CPUs und 500W GPUs wird dieser voraussichtlich auch mehr Watt sparen können, aber ohne extra Turbo-Lüfter ist der Unterschied praktisch Messungenauigkeit ..... und der Lüfter braucht in diesem Fall deutlich mehr Energie als er einspart.

Dabei hätte ich gedacht, dass ich hier mit wenigen ungekühlten VRM-Phasen den Optimalfall für Optimierungen vorliegen hätte.

Ich werde die Kühlkörper natürlich trotzdem drauf lassen....etwas niedrigere Temperaturen können nicht schaden und ich brauche sie für nix anderes...der Lüfter kommt natürlich wieder weg....bis ich ihn auf den Chipsatzkühler halte.

Nächstes Projekt....SSD Verbrauch und kann man beim B350 Chipsatz durch eine bessere Kühlung doch etwas verbessern?