S.Kara schrieb:

Meint du ihre iGPUs? Da waren sie wohl nie wirklich hinterher was Treiber angeht.

Denen hat auch einfach die Power gefehlt.

Sogar 30 Jahre.

Es steht übrigens genau das gleiche Schauspiel an.

Die i740 als Steckkarte hatte gegen die direkt folgende Konkurrenzneuauflage absolut Null Chance und war auch mal eben über 50% langsamer.

Dazu dann noch die üblichen Treiberprobleme, was wir auch hier bisher sehen dürfen.

Es sollte die modernste Karte sein, die den AGP-Slot als einzigste Karte auch wirklich sinnvoll nutzt.

Tatsächlich war der Chip für verwöhnte Spieler vergleichsweise nur Kacke und AGP konnte mit der Bandbreite auch nichts retten, wo nichts ist.

Und es hat sich zwischenzeitlich ja nie etwas geändert.

Das ist das, was ich der Weltfirma anprangere.

Da hilft der Suppenkasper Koduri auch nicht bei, der hat AMD auch nur mehr geschadet als geholfen.

Ihr erinnert euch?

"Poor Volta" wurde zu einer heißen Vega, wo man ein Feature sogar ganz deaktivieren musste, wodurch man nur mit roher Gewalt gerade so die 1080 halten konnte.

Es gab ja aber noch eine Ti und Titan, die mal eben 35% mehr raus hauten.

Das passiert, wenn Management und Marketing anfangen zu trommeln, wenn das Produkt noch nicht einmal steht.

Und genau das macht man nun auch bei Intel seit gefühlt 3 Jahren.

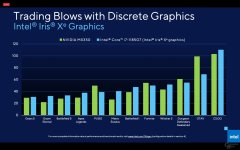

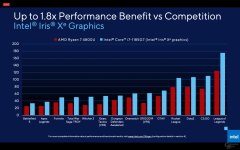

Z.B. 20x iGP Leistung wird uns versprochen.

Koduri, im Video. Jeder hats gesehen?

Ihr dürft schon mal die Steine rausholen, das wird lustig.

"Ist Weibsvolk anwesend?" "Nein, nein, nein" ^^ ;-P