Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

News Intel Arc Pro B60 & B50: Die Dual-GPU-Grafikkarte mit 2×24 GB VRAM ist Wirklichkeit

- Registriert

- Juli 2021

- Beiträge

- 1.395

Sorry aber Intel ist für mich nur noch "Entel" 🦆

Kein FP4?

Und Kan jemand sagen wie relevant das ist?

Die neue AMD haben FP4 aber bis jets wird das Woll nicht genutzt oder? Den in AI image-generation benchmarks sind sie nicht besser als die altere generation versteh ich. Oder ist es das VRAM das dort nicht mitmacht?

Und Kan jemand sagen wie relevant das ist?

Die neue AMD haben FP4 aber bis jets wird das Woll nicht genutzt oder? Den in AI image-generation benchmarks sind sie nicht besser als die altere generation versteh ich. Oder ist es das VRAM das dort nicht mitmacht?

therealcola

Commander

- Registriert

- Sep. 2020

- Beiträge

- 2.219

Wwhat schrieb:Die neue AMD haben FP4 aber bis jets wird das Woll nicht genutzt oder? Den in AI image-generation benchmarks sind sie nicht besser als die altere generation versteh ich. Oder ist es das VRAM das dort nicht mitmacht?

Welche Benchmarks wurden den getestet?

https://www.amuse-ai.com

sollte speziell für AMD optimiert sein.

Nach meinen tests bringt das AI gedönns von den neusten 9xxx sehr wohl was.

aber 16gb vram karten sind meh.

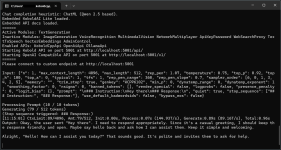

hier so nen bild dauert etwa 37 sekunden

oder

Zuletzt bearbeitet:

SweetOhm

Commander

- Registriert

- Juli 2023

- Beiträge

- 2.602

So wie die Deinige/n ...MalWiederIch schrieb:aber deine Markenaffinität ist hier ja bekannt, das bei dir übliche inhaltslose Bashing auch bereits in 2 Kommentaren auf der ersten Seite vertreten

fox40phil

Vice Admiral

- Registriert

- Okt. 2008

- Beiträge

- 6.496

Die Dual GPU wird also auch als zwei GPUs gehandhabt? Die sind nicht connected?

Ansonsten: sehr cool, dass Intel hier seinen eigenen Weg versucht zu gehen! Ich hoffe es bewirkt etwas!

Eine KI Beschleunigerkarte wäre auch klasse.... wenn sie z.B. KI Entrauschen und Entfernen in Lightroom heftigst beschleunigen würde! (10x Leistungssprung wären mir 300€ als reine KI-Karte wert)

Ansonsten: sehr cool, dass Intel hier seinen eigenen Weg versucht zu gehen! Ich hoffe es bewirkt etwas!

Eine KI Beschleunigerkarte wäre auch klasse.... wenn sie z.B. KI Entrauschen und Entfernen in Lightroom heftigst beschleunigen würde! (10x Leistungssprung wären mir 300€ als reine KI-Karte wert)

Stahlseele

Vice Admiral

- Registriert

- Feb. 2009

- Beiträge

- 6.388

@fox40phil

Jap, das ist also wirklich nichts zum spielen, sondern nur für AI und wo man noch mehr als eine GPU nutzen kann.

Jap, das ist also wirklich nichts zum spielen, sondern nur für AI und wo man noch mehr als eine GPU nutzen kann.

Chaosbreed

Lt. Junior Grade

- Registriert

- Mai 2022

- Beiträge

- 461

Ist nett, ohne CUDA bleibt es leider auch nur Nett. Für einige könnte es aber eine Günstige alternative sein und INTEL helfen zur Konkurrenz zu werden. 24 GB auf Consumerhardware ist erstmal eine Ansage, vielleicht kommt ja auch die 32 GB AMD Karte für einen Ansprechenden Preis. Dann brauchen wir nur noch eine breit genutzte AI/ML-API zur CUDA.

Die API muss ja auch nicht schnell sein nur halt die Sachen alle unterschützen, von Bild, Video, Musik und LLM's das kann ja nicht so schwer sein. Selbst wenn man auf 30 % Leistung verzichten muss.

Wenn die Hardware nur 1/3 kostet muss es auch nicht schnell sein.

Die API muss ja auch nicht schnell sein nur halt die Sachen alle unterschützen, von Bild, Video, Musik und LLM's das kann ja nicht so schwer sein. Selbst wenn man auf 30 % Leistung verzichten muss.

Wenn die Hardware nur 1/3 kostet muss es auch nicht schnell sein.

dgschrei

Lt. Commander

- Registriert

- März 2009

- Beiträge

- 1.688

Ich hab's schon in den Kommentaren zu dem LTT Video geschrieben.

Das Ganze kann von Intel eigentlich nur als schlechter Witz gedacht sein. 197 INT8 TOPS als "PRO Grafikkarte".

Selbst wenn man den Nvidia/CUDA Elefanten im Raum mal ignoriert und sich andere Lösungen anschaut, wüsste ich nicht, warum sich irgendjemand im professionellen Umfeld finden sollte, der sich diese Krücken antut.

197 TOPS sind halt nur grob ein Viertel der Leistung die man aus einer RX 9070 XT rauskriegt. Nur mit dem Unterschied dass man mit den Radeon Karten wenigstens auf halbwegs brauchbare Unterstützung durch PyTorch und Konsorten hoffen kann, während es bei Arc nur beten und hoffen ist, dass da was kommt.

Sprich Intel müsste die Karten schon mit einem ordentlichen Abschlag zu den Radeon Pendants auf den Markt werfen damit überhaupt jemand einen zweiten Blick drauf wirft.

Wenn man die B60 aber für weniger als ein Viertel des Preises einer 9070 XT anbieten muss, wird es ganz schnell unmöglich damit überhaupt in die Gewinnzone zu kommen, weil man ja trotzdem die zusätzlichen Kosten für 24GB VRAM + das dadurch komplexere PCB hat. Außerdem ist Arc was Leistung/mm² angeht sowieso schon extrem ineffizient was die Kosten noch zusätzlich hoch schraubt.

Die Arc Karten sind und bleiben Verschwendung von TSMC Kapazität. Die armen Wafer hätten stattdessen auch für konkurrenzfähige Produkte verwendet werden können.

Irgendwie fühle ich mich mit den Dual-GPU Karten an die letzten verzweifelten Zuckungen von Voodoo erinnert wo man zum Schluss auch der Meinung war man löst den technischen Rückstand einfach indem man 4 Chips auf die Karte klatscht.

Das Ganze kann von Intel eigentlich nur als schlechter Witz gedacht sein. 197 INT8 TOPS als "PRO Grafikkarte".

Selbst wenn man den Nvidia/CUDA Elefanten im Raum mal ignoriert und sich andere Lösungen anschaut, wüsste ich nicht, warum sich irgendjemand im professionellen Umfeld finden sollte, der sich diese Krücken antut.

197 TOPS sind halt nur grob ein Viertel der Leistung die man aus einer RX 9070 XT rauskriegt. Nur mit dem Unterschied dass man mit den Radeon Karten wenigstens auf halbwegs brauchbare Unterstützung durch PyTorch und Konsorten hoffen kann, während es bei Arc nur beten und hoffen ist, dass da was kommt.

Sprich Intel müsste die Karten schon mit einem ordentlichen Abschlag zu den Radeon Pendants auf den Markt werfen damit überhaupt jemand einen zweiten Blick drauf wirft.

Wenn man die B60 aber für weniger als ein Viertel des Preises einer 9070 XT anbieten muss, wird es ganz schnell unmöglich damit überhaupt in die Gewinnzone zu kommen, weil man ja trotzdem die zusätzlichen Kosten für 24GB VRAM + das dadurch komplexere PCB hat. Außerdem ist Arc was Leistung/mm² angeht sowieso schon extrem ineffizient was die Kosten noch zusätzlich hoch schraubt.

Die Arc Karten sind und bleiben Verschwendung von TSMC Kapazität. Die armen Wafer hätten stattdessen auch für konkurrenzfähige Produkte verwendet werden können.

Irgendwie fühle ich mich mit den Dual-GPU Karten an die letzten verzweifelten Zuckungen von Voodoo erinnert wo man zum Schluss auch der Meinung war man löst den technischen Rückstand einfach indem man 4 Chips auf die Karte klatscht.

Zuletzt bearbeitet:

dgschrei

Lt. Commander

- Registriert

- März 2009

- Beiträge

- 1.688

Ein aktuelles Reasoning Modell generiert pro Query so viele Tokens, dass Token/s ganz schnell eine relevante Größe wird. Qwen3-30b-A3b braucht selbst in 3 bit Quantisierung (damit es in 24GB passt) auf meiner 4090 ~15 Sekunden um eine Anfrage zu beantworten.

Gerade im professionellen Umfeld ist Zeit Geld. Recht viel langsamer als 15 Sekunden response time sollte es da schon nicht werden damit das überhaupt nutzbar ist. Von daher verstehe ich nicht wo jetzt auf einmal dieses ganze Copium herkommt, dass man ja nur genug VRAM braucht und die Rechenleistung egal wäre.

Gerade im professionellen Umfeld ist Zeit Geld. Recht viel langsamer als 15 Sekunden response time sollte es da schon nicht werden damit das überhaupt nutzbar ist. Von daher verstehe ich nicht wo jetzt auf einmal dieses ganze Copium herkommt, dass man ja nur genug VRAM braucht und die Rechenleistung egal wäre.

Dann würde ich mein Setup überprüfen, das sollte definitiv nicht sein.dgschrei schrieb:Qwen3-30b-A3b braucht selbst in 3 bit Quantisierung (damit es in 24GB passt) auf meiner 4090 ~15 Sekunden um eine Anfrage zu beantworten.

Gerade Qwen3-30b-A3b rennt sogar halbwegs brauchbar auf CPUs.

Und nein Rechenleistung ist nicht "egal", aber zweitrangig.

Teropet

Lt. Commander

- Registriert

- Jan. 2005

- Beiträge

- 1.515

Habe das Q5 hier und es ist wesentlich schneller als bei dir, da muss was nicht hinhauen.dgschrei schrieb:Ein aktuelles Reasoning Modell generiert pro Query so viele Tokens, dass Token/s ganz schnell eine relevante Größe wird. Qwen3-30b-A3b braucht selbst in 3 bit Quantisierung (damit es in 24GB passt) auf meiner 4090 ~15 Sekunden um eine

Ich freue mich auf die Karten, alleine für LLMs ein wahrer Segen und hoffentlich beginnt da endlich mal ein Preiskampf in diesem Segment. Der Preis von VRAM ist nicht das Problem, sondern nvidia und ihr Produktsortiment.

GDDR 6 ist völlig ausreichend und man kann sich da was schoenes zusammenbauen, ohne den Preis eines Kleinwagens zu zahlen.

Anhänge

dgschrei

Lt. Commander

- Registriert

- März 2009

- Beiträge

- 1.688

Ja klar, wenn ich dem Model eine simple Frage stelle für die die Antwort nur ein paar Token lang ist, dann kriege ich auch quasi sofort eine Antwort. Wenn ich ihm aber tatsächlich eine Aufgabe gebe für die es ordentlich "überlegen" und dann auch einiges an Output genrieren muss, dann dauert das schon.

In meinem konkreten Fall war das, was ich anstellen muss, wenn ich im Code für eine Browser Extension etwas bestimmtes erreichen will. Natürlich im "Think" Modus.

In meinem konkreten Fall war das, was ich anstellen muss, wenn ich im Code für eine Browser Extension etwas bestimmtes erreichen will. Natürlich im "Think" Modus.

LeckerRK

Lt. Junior Grade

- Registriert

- Aug. 2009

- Beiträge

- 478

Die Idee hatte ich schon vor 15 Jahren ist aber absolut nicht zeitgemäß.denn Slide oder Crossfire funktioniert nicht einwandfrei dazu kommt das eine GPU reicht und man viel mehr Videoram benutzen kann für eine GPU.Dazu sollte Intel mich einstellen mit einem Bonus von 50 Millionen Euro auf meinem Konto,denn dann könnte ich mich bereit erklären für Intel zu arbeiten und den gesamten PC Markt zu revolutionieren ( Made by Intel )

Ergänzung ()

Da gebe ich Dir Recht aber nicht mit dieser Methode das geht viel besser auf eine GPU mit noch mehr Videospeicher.shysdrag schrieb:Endlich mal ein Grafikkartenhersteller der auf Produktsegmentierungen zum HPC/Hyperscaler Geschäft pfeifft. Es wäre durchaus gut wenn das Intels GPU Sparte ordentlich auf die Sprünge hilft.

Zuletzt bearbeitet:

Ich hoffe der Fokus ist tatsächlich mehr "Workstation" (sprich SR-IOV) und weniger "AI". Das wäre beim B50 für 299$ das absolute Alleinstellungsmerkmal; weder AMD, noch Nvidia reden in dem Preissegment mit. Bei AMD funktioniert SR-IOV grundsätzlich nur bei ausgewählten Modellen, die schwer zu bekommen und/oder steinalt sind. Und bei Nvidia ist vGPU auch nicht flächendeckend verfügbar - unter 3000€ braucht man da i.d.R. auch nicht gucken.

Der Preis ist sehr bodenständig, sehr lobenswert. Es geht jetzt aber erst einmal um Mindshare/Marketshare, die man sich nun mühselig, langsam und über mehrere Generationen hinweg aufbauen muss.

Hauptsache, sie beißen sich nicht ausschließlich bei "AI" fest - das Feld gehört nahezu exklusiv Nvidia/CUDA und das wird sich in absehbarer Zeit auch erstmal nicht großartig ändern. Dafür müsste man schon quasi VRAM verscherbeln, um die Leute von Nvidia wegzubekommen.

Der Preis ist sehr bodenständig, sehr lobenswert. Es geht jetzt aber erst einmal um Mindshare/Marketshare, die man sich nun mühselig, langsam und über mehrere Generationen hinweg aufbauen muss.

Hauptsache, sie beißen sich nicht ausschließlich bei "AI" fest - das Feld gehört nahezu exklusiv Nvidia/CUDA und das wird sich in absehbarer Zeit auch erstmal nicht großartig ändern. Dafür müsste man schon quasi VRAM verscherbeln, um die Leute von Nvidia wegzubekommen.

Also ich habe einen Heimserver auf dem Proxmox läuft. Da hätte ich gerne eine GPU für um ein bissel transcoding, ein bissel LLM und ein bissel Grafikbeschleunigung in den VMs machen zu können. Die Karte darf nicht allzu groß oder allzu stromfressend sein. Vorrausgesetzt SR-IOV kommt wie geplant Ende des Jahres ist die Karte perfekt dafür, oder sehe ich das falsch?

Bei NVIDIA würde die Alternative 4000 Euro kosten. Mit dem Angebot von AMD kenne ich mich nicht so gut aus, aber wäre mir neu, dass die irgendwas mit ähnlich viel VRAM und Inference speed für unter 500 Euro haben. Außerdem: transcoding und virtualization. Hat AMD jetzt überhaupt schon AV1-Support?

@Jan Laut specs haben die Karten PCIE 5.0, in deiner Tabelle steht 4.0

Bei NVIDIA würde die Alternative 4000 Euro kosten. Mit dem Angebot von AMD kenne ich mich nicht so gut aus, aber wäre mir neu, dass die irgendwas mit ähnlich viel VRAM und Inference speed für unter 500 Euro haben. Außerdem: transcoding und virtualization. Hat AMD jetzt überhaupt schon AV1-Support?

@Jan Laut specs haben die Karten PCIE 5.0, in deiner Tabelle steht 4.0

TechFA

Lt. Commander

- Registriert

- Okt. 2018

- Beiträge

- 1.037

Weil die Offerten von Intel leider nicht selten gar keine Konkurrenz im eigentlichen Sinne sind, sondern Intel in der Vergangenheit oftmals nur kaum bis gar nicht wettbewerbsfähige Produkte am normalen Kunden-Verlangen eines freien Marktes vorbei durch die OEMs in die Distributionskanäle gedrückt hat.scryed schrieb:Hm wie kann da soviel negatives gegen mehr Konkurrenz geben....

Intel war es immer schon vollkommen gleichgültig, ob der Kunde das Produkt überhaupt haben wollte.

Dem Kunden wird durch die Intel'schen Praktiken oft einfach gar keine freie Wahl gelassen, sondern er muß es kaufen, weil es nichts anderes gibt, da Intel den Markt an der Wurzel bei den OEMs umgeht.

Wie schon erwähnt, das sind jetzt einfach Bastelprojekte, die als vollwertige Produkte an nichtsahnende Unternehmenskunden verkauft werden sollen, um noch ein wenig Profit zu machen.scryed schrieb:Und gibt es nicht den Spruch RAM kann man nicht genug haben?

Hast Du von der Meldung überhaupt mehr als die Überschrift gelesen?!

Intel sagt doch selber, daß das Produkt als solches noch gar nicht fertig und die Software noch überhaupt nicht vorhanden ist und sogar noch einige Monate auf sich warten lassen dürfte. Das ist kein vollwertiges Produkt, sondern einfach schlichtes Kalkül seitens Intel, daß genug Chaoten auf den Nepp hereinfallen.

Siehe oben. Das Problem von Intel war bei allem abseits ihrer CPUs immer das Selbe:scryed schrieb:Und ohne Hardware keine Software....

Hardware mag technisch halbwegs ausgereift sein, aber es wird erstmal wieder ohne Software auf den Markt geschmissen, in der hehren Hoffnung, daß genug Kunden überhaupt darauf einsteigen, um die Entwicklungskosten der Software-Unterstützung überhaupt erst rechtfertigen zu können.

Bist Du so kurzsichtig, oder tust Du bloß so?! Auf welche von einem Treiber oder entsprechender Software zur Verfügung gestellten Software-Schnittstelle (API) hin, soll ein Drittanbieter denn überhaupt eine Unterstützung gewährleisten, wenn die Software-API von Intel selbst für entsprechende Kunde (Drittanbieter) noch gar nicht existent geschweige denn fertig ist?! Es gibt die API doch noch gar nicht.scryed schrieb:Und der Software hersteller sollte doch keine Probleme haben wenn er schon nvidia und oder AMD unterstützt auch noch Intel hinzuzufügen.....

Nein, daß ist kein Hass, sondern einfach nur dilettantisch und Flickschusterei von Intel, wenn wieder mal halbgarer Mist mit geldwerter Gewalt in den Markt gedrückt wird, welcher noch nicht einmal zu ende entwickelt ist. Es ist das nächste Projekt, was Unsummen kostet und sich wahrscheinlich nicht rentiert.scryed schrieb:Immer das vorab gehasse nur weil es Intel ist.....

Das Traurige ist, daß es leider trotzdem wieder Abnehmer finden wird, weil Intel …

Millennial_24K

Lt. Commander

- Registriert

- Dez. 2021

- Beiträge

- 1.636

Das hört sich recht vielversprechend an - zumindest auf dem ersten Blick. Mal sehen wie sich die Pro-Modelle (inkl. dazugehöriger Software) später im Einsatz schlagen werden. Und wieviele Abnehmer es für den neuen Mitbewerber in diesem Markt geben wird. Ich hoffe auf einen (kleinen) Erfolg für Intel, denn mir persönlich gefällt das gezeigte Produktportfolio.

Ähnliche Themen

- Antworten

- 27

- Aufrufe

- 3.599

- Antworten

- 23

- Aufrufe

- 2.632

- Antworten

- 98

- Aufrufe

- 16.003

- Antworten

- 50

- Aufrufe

- 6.337