Die AMD DualKarte wird wohl leicht schneller werden, AMD hat momentan einfach ein eiffezienteres Design, und da hier nunmal die leistungsaufnahme an der grenze ist, kann Nvidia nicht durch die leistung punkten, sondern muss im bereich von zwei 8Pin bleiben...jaja, damit hat man nun endlich bei AMD auch genug power für 3Monitore à 1920x1200

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

News Nvidia GeForce GTX 590 als „Antilles“-Konter in Kürze?

- Ersteller Volker

- Erstellt am

- Zur News: Nvidia GeForce GTX 590 als „Antilles“-Konter in Kürze?

Kasmopaya

Banned

- Registriert

- Mai 2007

- Beiträge

- 12.285

Also ein lupenreiner Vram Krüppel ist es nicht. 2x 1,5GB brechen zwar auch ein, aber nicht so heftig wie 2x1GB das auch hätte kommen können.(immer noch möglich mit der HD 6990, aber eher unwahrscheinlich) 2x3GB ist der Absolute Wahnsinn, da wäre dann der Preis Richtung 1000€-1500€ gegangen.3GB or GTFO. Wie kann man solch einem Monster nur 1,5GB Vram spendieren?

Die einzige logische und sinnvolle Alternative ist 2x GF114 zu verwenden und damit weniger Kernschmelz Probleme, besserer Preis und optimale 2x2GB Vram. Da Fragt man sich echt was die Hersteller so rauchen, wie kann man nur auf die Idee kommen hier 2x GF110 rein quetschen zu wollen? Solche Wahnsinns Karten sind nur was wie Karten ala Asus Mars.

Aber wenn AMD tatsächlich die µRuckler angegangen hat, wird das tatsächlich ein spannender Februar. Vor allem hoffe ich ja noch auf den Preisrutsch bei der GTX 580 durch die beiden dual-GPU Monster. Gogogo AMD die Zeit drängt.

Zuletzt bearbeitet:

Tamahagane

Vice Admiral

- Registriert

- Jan. 2008

- Beiträge

- 6.627

l1n00x schrieb:Weiß auch nicht, wer sowas machen sollte. Nvidia spendiert jedoch 2x1,5GB=3GB!

Also effektiv 1,5GB, und darauf wollte er hinaus

Kasmopaya schrieb:Aber wenn AMD tatsächlich die µRuckler angegangen ist, wird das tatsächlich ien spannender Februar.

Wär schön, aber ich fürchte nicht.

CD

Rear Admiral

- Registriert

- Mai 2010

- Beiträge

- 5.742

RiseAgainstx schrieb:so viel power braucht echt keine Sau ^^

aber mal interessant das rating zu sehn

Dann spiel mal auf 3x26" in 6048x1200

Lord Horu$

Commander

- Registriert

- Mai 2008

- Beiträge

- 2.176

Nitschi66 schrieb:Die AMD DualKarte wird wohl leicht schneller werden, AMD hat momentan einfach ein eiffezienteres Design

Effizient? Hast du dir mal den Test der HD 6970 angeschaut? Effizient ist das nicht. Klar sie verbraucht weniger, als eine 580, aber bringt im gleichen Zug das was sie weniger verbraucht auch weniger an Leistung. Hätte AMD Cayman gen GTX 580 gejagt, dann wär die 6970 nicht sehr viel sparsamer.

Leistungstechnisch liegt sie ja ungefähr auf der Ebene einer GTX 570. Sie is n Tick schneller (Nicht der Rede wert) und n Tick sparsamer (In dem Bereich: ebenfalls nicht der Rede wert!). Oben drauf kommt, zumindest in der Referenz, ein katastrophales Kühlsystem IMHO. Ich hab sie gehabt. Ich konnte mich nicht zwischen GTX 570 und 6970 entscheiden. Ich hatte bis dato immer ne ATI/AMD-Karte, aber die 6970 hat mich 0 überzeugt. Texturflimmern in HL². Das hatte selbst meine alte HD 4890 nicht. Die GTX 570 wird zwar recht warm (70°C was noch vollkommen okay ist), aber der Lüfter agiert wenigstens leise. Ich darf beaupten eine Recht gute Gehäusebelüftung zu haben. Der 6970 war es egal, die hat geröhrt, wie n Raketenauto.

Die 6950 is als einzige Karte recht venünftig nur daraus ne DGPU-Karte zu machen is schwachsinnig. Dann wär man nich viel besser als eine 5970!

Die Leistungen der AMD-Karten überschneiden sich IMHO schon stark. zwischen der 6950 und der 6870 ist der Unterschied schon arg gering.

yama03061989

Lt. Commander

- Registriert

- Feb. 2008

- Beiträge

- 1.367

Ich glaube nicht das eine Dual GPU von Nvidia demnächst kommt.

Bis zum 4. Quartal 2011 wo die ersten 28nm GPU's geplant sind wird das Thema erstmal ziehmlich ausgelutscht sein. SLI Option besteht weiterhin für jeden.

Bis zum 4. Quartal 2011 wo die ersten 28nm GPU's geplant sind wird das Thema erstmal ziehmlich ausgelutscht sein. SLI Option besteht weiterhin für jeden.

L

ltkrass

Gast

Ich denke auch das eine 28/32nm Version der Dual GPU Karten wesentlich mehr sinn machen würde. Eine GF 9800GTX+ GX2 wird doch heute von jeder GTX560 abgehängt, da kann man auch einfach warten

Also eiffizienter ist AMD seit der HD6970 nicht mehr. Diese Stromfressenden Lärmmonster würden beide die Spezifikationen von der PEG überschreiten - und zwar schon unter Spielelast. Ebenso ist eine GTX 560 Ti an der Grenze.

Unter Furmark wären für HD6950 und GTX 560 nichtmal mehr 2*8Pin ausreichend!

Daran sieht man dass etwas passieren muss - das Wettrüsten muss ein Ende haben, viel mehr sollte der Fokus auf Effizienteren Designs liegen. Kan doch nicht sein dass so manche Grafikkarte mehr Strom braucht als mein Rechner, mit dem ich zum Beispiel BFBC2 auf Maximum in 1920*1200 flüssig spielen kann! Und auch etwa das gleiche Geld kostet... was ich damit sagen will: eine GTX 560 ist mehr Grafikkarte als man derzeit sinnvoll nutzen kann. Für die Idiothasten, die sich einbilden sie müssen jetzt mit Texturmods auf drei Bildschirmen und alles auf max. Zocken, gibts eh SLI / CF.

Von daher ist mir diese Dual-Karte, wie auch immer sie aussehen mag: Schnuppe!

mfg

Unter Furmark wären für HD6950 und GTX 560 nichtmal mehr 2*8Pin ausreichend!

Daran sieht man dass etwas passieren muss - das Wettrüsten muss ein Ende haben, viel mehr sollte der Fokus auf Effizienteren Designs liegen. Kan doch nicht sein dass so manche Grafikkarte mehr Strom braucht als mein Rechner, mit dem ich zum Beispiel BFBC2 auf Maximum in 1920*1200 flüssig spielen kann! Und auch etwa das gleiche Geld kostet... was ich damit sagen will: eine GTX 560 ist mehr Grafikkarte als man derzeit sinnvoll nutzen kann. Für die Idiothasten, die sich einbilden sie müssen jetzt mit Texturmods auf drei Bildschirmen und alles auf max. Zocken, gibts eh SLI / CF.

Von daher ist mir diese Dual-Karte, wie auch immer sie aussehen mag: Schnuppe!

mfg

Kasmopaya

Banned

- Registriert

- Mai 2007

- Beiträge

- 12.285

Die Preise rutschen schon, 525€ für eine GTX 580 3GB -> Schnäppchen:  http://geizhals.at/deutschland/a609907.html

http://geizhals.at/deutschland/a609907.html

AMD setzt mit großer Wahrscheinlichkeit auch auf 2x HD 6950(Performance per Watt König), 2 volle 6970er Chips saufen zu viel. Vor allem hat ja die HD 5970 schon ein bisschen zurück geschraubt.

AMD setzt mit großer Wahrscheinlichkeit auch auf 2x HD 6950(Performance per Watt König), 2 volle 6970er Chips saufen zu viel. Vor allem hat ja die HD 5970 schon ein bisschen zurück geschraubt.

Tinpoint

Fleet Admiral

- Registriert

- Okt. 2007

- Beiträge

- 10.045

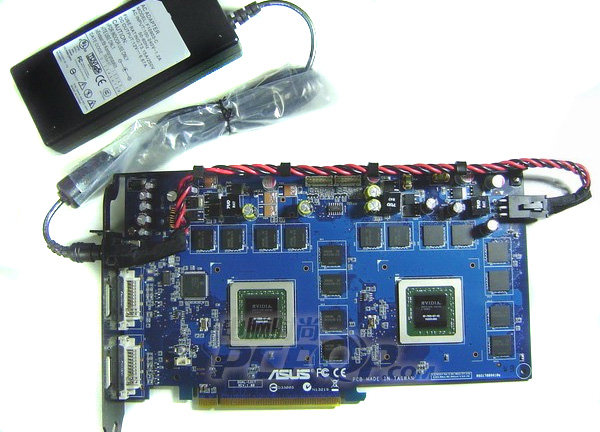

dayo81 schrieb:Genau - ein externer Stromanschluss muss her:

wozu, gibt doch genug 700, 850 & 1kW Netzteile!

the_ButcheR

Vice Admiral

- Registriert

- Mai 2010

- Beiträge

- 6.985

Zwei GF110? Das glaube ich erst wenn es verkauft wird...

Eine GTX 580 verbraucht min. 40W mehr als eine HD 6970, das wird doch selbst mit 2*8pin eng?

MfG

Eine GTX 580 verbraucht min. 40W mehr als eine HD 6970, das wird doch selbst mit 2*8pin eng?

MfG

Genoo

Captain

- Registriert

- Okt. 2006

- Beiträge

- 3.136

Diese Karten sind nicht mehr als reines Marketing, zwei einzelne Karten in Crossfire oder SLI zu verbinden ist immernoch viel sinnvoller, teilweise sogar preislich attraktiver, bessere Temperaturen, weniger Lärm (anderer Kühler meißtens vorrausgesetzt) und was wichtiger ist, deutlich bessere Leistung da OC Potential gegeben bzw höher ist

Solche Dual-GPU Karten dienen einzig und allein dem Zweck um sagen zu können "Seht her, wir haben die schnellste Grafikkarte auf dem Markt"

Wer sich eine derartige Karte kauft würde auch Hundekot kaufen wenn dieser ansprechend beworben werden würde

Solche Dual-GPU Karten dienen einzig und allein dem Zweck um sagen zu können "Seht her, wir haben die schnellste Grafikkarte auf dem Markt"

Wer sich eine derartige Karte kauft würde auch Hundekot kaufen wenn dieser ansprechend beworben werden würde

Buki80

Lieutenant

- Registriert

- Dez. 2009

- Beiträge

- 845

Für mich wäre die 6990 "ideal" ,,, habe Eyefinity mit 3x22" und ein Motherboard mit leider nur einem Pcie16 Steckplatz, aktuell werkelt eine 6970 welche aber ab und zu schon mal an ihre Grenzen stößt, dank der hohen Auflösung. Hoffe der Preis pendelt sich so bei 500-550€ ein...aber so wie es aussieht wird sie nicht in mein Case passen, shit

gruß

gruß

Thomson1981

Lt. Commander

- Registriert

- Sep. 2008

- Beiträge

- 1.254

Ehrlich gesagt stelle ich mir für solche Dual GPU Monster ala GTX 590 / AMD 6990 nur einen einzigen Verwendungszweck vor:

Leute,die nur ein Mainboard mit 1x 16x PCI-E 2.0 Anschluß besitzen,welche aber trotzdem absolute Grafikkiller ala Crysis,Crysis Warhead,ARMA 2 + Add'on,Metro 2033 und vor allen Dingen Crysis 2 auf 1920x1200 Auflösung oder höher spielen wollen,mit maximalen Grafikeinstellungen + 4-8x AA/SSAA und 16x High Quality AF.

Diese Menschen sind dann einfach auf eine High End Dual GPU Karte angewiesen,weil Sie ein SLI/Crossfire System mit 2 Grafikkarten,aufgrund von Platzmangel im HTPC LAN Rechner, oder kompakten Mainboard mit nur 1x PCI-E 2.0 16x einfach nicht realisieren können.

Wahre Enthusiasten besitzen meistens sowieso einen großzügig dimensionierten Big Tower,daß passende High End Mainboard mit 4x PCI-E 2.0 16x oder mehr und bauen sich gleich ein 3x SLI System oder 3x Crossfire X System zusammen,welches jeder Dual GPU Karte dank höherer Taktraten,besserer Kühlung und daraus resultierenden zusätzlichen Übertaktungsmöglichkeiuten den Rang ablaufen wird und diese sowas von zersägt.

Und für 4x SLI / 4x Crossfire X Systeme braucht man solche Karten auch nicht mehr,seit es Mainboards mit 4x PCI-E 2.0 16x gibt,auf welchen man dann auch wieder auf die leistungsstärkeren 4x Single GPU SLI/Crossfire X Konfigurationen zurückgreifen kann.

Wobei sowas sowieso schwachsinnig ist,da so gut wie kein Spiel von 4x SLI / 4x Crossfire X profitieren kann.

Sowas ist dann wirklich nur noch was für Benchmarkjäger oder für wissenschaftliche Berechnungen im GPGPU Bereich.

Leute,die nur ein Mainboard mit 1x 16x PCI-E 2.0 Anschluß besitzen,welche aber trotzdem absolute Grafikkiller ala Crysis,Crysis Warhead,ARMA 2 + Add'on,Metro 2033 und vor allen Dingen Crysis 2 auf 1920x1200 Auflösung oder höher spielen wollen,mit maximalen Grafikeinstellungen + 4-8x AA/SSAA und 16x High Quality AF.

Diese Menschen sind dann einfach auf eine High End Dual GPU Karte angewiesen,weil Sie ein SLI/Crossfire System mit 2 Grafikkarten,aufgrund von Platzmangel im HTPC LAN Rechner, oder kompakten Mainboard mit nur 1x PCI-E 2.0 16x einfach nicht realisieren können.

Wahre Enthusiasten besitzen meistens sowieso einen großzügig dimensionierten Big Tower,daß passende High End Mainboard mit 4x PCI-E 2.0 16x oder mehr und bauen sich gleich ein 3x SLI System oder 3x Crossfire X System zusammen,welches jeder Dual GPU Karte dank höherer Taktraten,besserer Kühlung und daraus resultierenden zusätzlichen Übertaktungsmöglichkeiuten den Rang ablaufen wird und diese sowas von zersägt.

Und für 4x SLI / 4x Crossfire X Systeme braucht man solche Karten auch nicht mehr,seit es Mainboards mit 4x PCI-E 2.0 16x gibt,auf welchen man dann auch wieder auf die leistungsstärkeren 4x Single GPU SLI/Crossfire X Konfigurationen zurückgreifen kann.

Wobei sowas sowieso schwachsinnig ist,da so gut wie kein Spiel von 4x SLI / 4x Crossfire X profitieren kann.

Sowas ist dann wirklich nur noch was für Benchmarkjäger oder für wissenschaftliche Berechnungen im GPGPU Bereich.

Zuletzt bearbeitet:

Ich denk mal von den Shadern und Taktraten wird es 2x GTX570 werden, nur eben mit nem 512bit SI.

Mehr ist bei den 375W einfach nicht machbar.

Selbst diese Konfiguration würde im Furmark deutlich mehr verbraten, aber dafür gibts doch neuerdings diese schönen TDP-Begrenzungen.

Die Lautstärke will ich bei ner 2 Slot-Kühlung gar nicht wissen. Der Thron der GTX480 wackelt.

Mehr ist bei den 375W einfach nicht machbar.

Selbst diese Konfiguration würde im Furmark deutlich mehr verbraten, aber dafür gibts doch neuerdings diese schönen TDP-Begrenzungen.

Die Lautstärke will ich bei ner 2 Slot-Kühlung gar nicht wissen. Der Thron der GTX480 wackelt.

Nova_Prospekt

Captain

- Registriert

- Dez. 2007

- Beiträge

- 3.206

Na da nimmt man doch lieber 2 GTX580 mit 3GB Speicher. Die werden wahrscheinlich schneller sein und denen wird der Speicher nicht ausgehen.

Ähnliche Themen

- Antworten

- 92

- Aufrufe

- 13.448

- Antworten

- 41

- Aufrufe

- 7.034