Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

News PCIe 8.0: Erster Entwurf für die 1 TB/s schnelle Schnittstelle steht

- Ersteller MichaG

- Erstellt am

- Zur News: PCIe 8.0: Erster Entwurf für die 1 TB/s schnelle Schnittstelle steht

- Registriert

- Feb. 2012

- Beiträge

- 6.835

nur das der Entwurf der PCI-SIG weit detaillierter als so eine Werbefolie ist. Nur um das zu lesen, musst Du bezahlen.EspE schrieb:Ich habe auch ein Entwurf für PCIe 9

Einfach wieder zurück zu ISA und für Grafikkarten dann wieder den VLB (Vesa Local Bus).Wolfgang.R-357: schrieb:Natürlich will ich das, ich fordere sogar den Rückschritt, warum, wegen DIR!

- Registriert

- Feb. 2012

- Beiträge

- 6.835

VLB..war n netter Gedanke aber ein unglaubliches Gefummel bis irgendwas lief, weil nichts wirklich miteinander kompatibel war

Piktogramm

Fleet Admiral

- Registriert

- Okt. 2008

- Beiträge

- 10.121

Die PHYs für PCIe ziehen bei den kleinen Desktoplösungen unter voller Last mittlerweile mehrere Watt.DragonScience schrieb:Das sich auf längere Strecken Glasfaser lohnt ist unumstritten, aber ob die Umwandlung in einem Rechner schon so gut ist, das sich 20-30cm Glasfaser besser performen als reine Kupferleitungen mit direkten Verbindungen bin ich mir jetzt nicht sicher.

Die PCIe Spec sieht dabei Leitungslängen zwischen Geräten von 18" (~46cm)[1] vor mit Abweichungen je nach Güte der Verbindung (CPU-Sockel, PCIe-Slot), Leitungen. Bei längeren Verbindungen muss man damit rechnen Retimer zu brauchen und die Lösung von Broadcomm für 8x PCIe6 nennt 8W als TDP[2].

Wer auch immer Silicon Photonics mit gescheitem Verbindungssystem und <10W für die PHY + Logik anbieten kann wird viele, zahlungskräftige Freunde finden.

[1] https://semiengineering.com/using-a-retimer-to-extend-reach-for-pcie-6-0-designs/

[2] https://www.broadcom.com/products/pcie-switches-retimers/expressfabric/gen6/bcm85668

Können ja alternativ auch wieder AGP nehmen. Wobei da musste man teilweise auch drauf achten, ob die Karte bzw. der Steckplatz AGP 3.3V oder AGP 1,5V waren. Fein raus war man bei AGP Universal.TorenAltair schrieb:VLB..war n netter Gedanke aber ein unglaubliches Gefummel bis irgendwas lief, weil nichts wirklich miteinander kompatibel war

Das hat sich bei Gaming GPUs in den letzten Jahren nicht geändert und wieso sollte es in Zukunft mehr werden?RedPanda05 schrieb:Ich kann aber auch nicht abschätzen, welche Anbindungen eine GPU in 10 - 15 Jahren gerne hätte.

Falls sich WorkGraphs etabliert könnte der Bandbreitebedarf sogar sinken, da weniger Komunikation zwischen CPU und GPU stattfindet.

Den zweiten Teil deines Satzes zweifle ich mal an... auch optische Übertragungen sind nicht verlustfrei.Steven Coolmay schrieb:Du hast immer Leitungsverluste, bei Optisch nicht.

Steven Coolmay

Ensign

- Registriert

- März 2020

- Beiträge

- 197

Das Einkoppeln von optischen Signalen ist nun Mal aufwändig. Deshalb verwendet man optische Datenübertragung nur wenn es nicht anders geht.Piktogramm schrieb:Wer auch immer Silicon Photonics mit gescheitem Verbindungssystem und <10W für die PHY + Logik anbieten kann wird viele, zahlungskräftige Freunde finden.

Bei den AI-Servern ist der Zeitpunkt sehr nahe. Das Zauberwort heißt Co-Packaged Optics. Die optische Datenübertragung bringt nur dann etwas sie im Package der GPU beginnt.

Den Energieverbrauch bei der Datenübertragung gibt man üblicherweise in pJ/bit an,

SweetOhm

Commander

- Registriert

- Juli 2023

- Beiträge

- 2.618

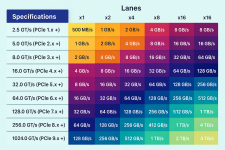

Es sind auch zwei x16 Spalten ...EspE schrieb:Ich habe auch ein Entwurf für PCIe 9 & 10, leider hat chatGPT 10 vergessen und ist am ende mit den TB etwas durcheinander gekommen 🤣

Chismon

Fleet Admiral

- Registriert

- Mai 2015

- Beiträge

- 10.211

Eventuell optische PCIe Verbindungen, ohjee, das dürfte dann Mainboards weiter deutlich verteuern.

Also ich gehe bei der nächsten Desktop PC Aufrüstung von PCIe 6.0 als nächstes aus (PCIe 5.0 werde ich wohl überspringen) für ca. 2028/2029, also erst wenn DDR6 etabliert und halbwegs verbreitet/erschwinglich ist und RTPT bei über 60fps in 4K/UHD bei Oberklasse-dGPUs durch die Bank erreicht wird und auf mindestens 150% Rasterizerzuwachs (also etwas mehr als RTX 5090 Leistung) bei Verbrauch unter 350W hoffe ich dann zudem.

Also ich gehe bei der nächsten Desktop PC Aufrüstung von PCIe 6.0 als nächstes aus (PCIe 5.0 werde ich wohl überspringen) für ca. 2028/2029, also erst wenn DDR6 etabliert und halbwegs verbreitet/erschwinglich ist und RTPT bei über 60fps in 4K/UHD bei Oberklasse-dGPUs durch die Bank erreicht wird und auf mindestens 150% Rasterizerzuwachs (also etwas mehr als RTX 5090 Leistung) bei Verbrauch unter 350W hoffe ich dann zudem.

Zuletzt bearbeitet:

Wäre wünschenswert, dass dann auch endlich auf die optische Datenübertragung gesetzt wird. Ich fürchte, dass es mit elektrischer Übertragung bald noch teurere Boards brauchen wird. Von Problemen beim Einsatz von Riser Kabeln gar nicht erst reden.

Und PCIe 5 war schon vor zig Jahren final definiert. Das ist der normale Gang der Dinge. Es wird auch noch viele Jahre dauern, bis wir überhaupt irgendwo PCIe 8 sehen werden im Consumer-Bereich.

Außerdem interessiert der Consumer-Markt eh nicht. Relevanz besteht ausschließlich für den Server-/Enterprise-Markt. Von dort tröpfelt neue Technik über die Jahre dann auch in den Consumer-Bereich.

Darfst Du auch, der Q9650 erschien 2008. Das ist 17 Jahre her. Nächstes Jahr darf er sogar schon harten Alkohol trinken

SweetOhm schrieb:Nur "gut", dass sich PCIe 5.0 noch nicht mal zur Gänze etabliert hat ...

Und PCIe 5 war schon vor zig Jahren final definiert. Das ist der normale Gang der Dinge. Es wird auch noch viele Jahre dauern, bis wir überhaupt irgendwo PCIe 8 sehen werden im Consumer-Bereich.

Außerdem interessiert der Consumer-Markt eh nicht. Relevanz besteht ausschließlich für den Server-/Enterprise-Markt. Von dort tröpfelt neue Technik über die Jahre dann auch in den Consumer-Bereich.

Anoubis schrieb:Fühle mich alt mit meiner PCIe 3.0 Plattform 😅

Darfst Du auch, der Q9650 erschien 2008. Das ist 17 Jahre her. Nächstes Jahr darf er sogar schon harten Alkohol trinken

Dafür gibt es Wandlungsverluste. Schau dir mal an was die Transceiver verbraten.Steven Coolmay schrieb:@DragonScience

Klar lohnt sich das. Du hast immer Leitungsverluste, bei Optisch nicht. Und es wird einiges an Energie gespart was wieder zu weniger Hitze führt.

Es ist eher die Signalqualität denn der Stromverbrauch. Bei PCIe 6.0 sind es schon nur noch 7 cm ohne Retimer. Aber wenn dann Co-packaged auf dem CoWoS-R/L Substrat. Sonst hat das wenig Sinn.

Ergänzung ()

Nvidia verkabelt das ganze NVL72 mit Kupfer. Ich meine sogar Inter-Rack die ganze zweite Ebene bei NVL576 ist alles Kupfer.ETI1120 schrieb:Es geht um Server und auch um CXL das auf PCIE aufsetzt. Bei den Servern kommen längere Distanzen zusammen. Wenn man den Speicherpool für ein ganzes Rack haben will sind es nicht nur ein paar cm.

Ergänzung ()

Da sieht man mal wie dumm die Chatbots noch sind. Nicht in der Lage mit 2 zu multiplizieren. Das hätte jedes Kind in der zweiten Klasse lösen können.EspE schrieb:Ich habe auch ein Entwurf für PCIe 9 & 10, leider hat chatGPT 10 vergessen und ist am ende mit den TB etwas durcheinander gekommen 🤣

Zuletzt bearbeitet:

Das Forum von Computerbase dürfte anno 2035 nicht unter PCIe 6.0 nutzbar sein - so geht PC Technik.

Wahrscheinlich wird dann sogar DSL-16 zu langsam dafür sein - muss das sein?

Also, da im Marketing die PCIe Version im Massenmarkt egal ist, sieht es schlecht aus für neue Normen, außer keine Mehrkosten für OEMs.

Wahrscheinlich wird dann sogar DSL-16 zu langsam dafür sein - muss das sein?

Also, da im Marketing die PCIe Version im Massenmarkt egal ist, sieht es schlecht aus für neue Normen, außer keine Mehrkosten für OEMs.

Wenn es egal wäre, hätte es nicht so früh breitflächig PCIe 5.0 gegeben. Aber es wird halt nicht um jeden Preis implementiert und es wird immer aufwändiger. Wird also mit jeder neuen Generation zunehmend langsamer bis in den Consumerbereich durchsickern. Als erstes vielleicht nur ein M.2 Slot. Ist am nächsten am CPU Sockel dran. Das geht definitiv noch ohne Retimer (PCIe 6.0). Beim ersten PCIe Slot wird es schon grenzwertig.

Doch das macht den Braten fett. Wenn du dir z.b. Server mit PCIe6 anschaust dann verwenden die alle Kupferkabel die Stecker direkt um die CPU haben mit den PCIe Slots auf daughter Boards zu verbinden. Mit dem Kabel kommt hinten noch ein Signal an. Übers MB nicht... Die Stecker sind nicht ganz billig aber trotzdem noch viel günstiger und einfacher als all die Signale übers Mainboard zu routen.DragonScience schrieb:Die CPU ist ja von den PCIe ja nicht so weit weg, macht des echt den Braten Fett Signale von der CPU auszulesen, Optisch umzuwandeln, 20cm über Glasfaser zu schicken und in eine PCIe Karte wieder zu übersetzen, warscheindlich wieder Elektrisch Digital.

Kann man da Schaltzeitenmäsig irgendwas gewinnen auf dieser kurzen Strecken das sich das umwandeln lohnt ? Oder gibt es bald CPU`s und Graka`s mit direkter Optischer schnittstelle an den Chips, dann könnte es Geil werden.

Das Problem ist halt einfach das FR4 Material dad für Mainboards verwendet wird. Das wird bei so hohen Frequenzen der Signale transparent... Du hast also quasi einen Kurzschluss. Dad Zeug ist aber halt einfach günstig/billig und gut handhabbar. Wenn du was besseres willst wird es schnell sehr teuer. Meines Wissens ist das dann alles quasi keramisch.

Von der Latenz her hilft dir das erstmal gar nichts sondern ist eher noch langsamer als rein elektrisch weil du ja noch das Signal wandeln musst was zeit kostet. Das sind aber einstellige nano Sekunden wenn überhaupt so viel. Also völlig egal auf der Ebene.

Aiehe oben. Es lohnt sich bereits der Einsatz von Kuperkabeln statt übers PCB zu gehen.DragonScience schrieb:Das sich auf längere Strecken Glasfaser lohnt ist unumstritten, aber ob die Umwandlung in einem Rechner schon so gut ist, das sich 20-30cm Glasfaser besser performen als reine Kupferleitungen mit direkten Verbindungen bin ich mir jetzt nicht sicher. Wird interessant wie PCIe 8.0-9.0 dann aussieht aber vorstellen kann ich mir es nicht. Außer die Glasfaser schnittstelle wäre direkt von der CPU raus.

Mal schaun was die Zukunft bringt.

Bei Glasfaser und Kupfer Mischports hast du halt aus energetischer Sicht das Problem, dass der Port für eine gewisse Distanz ausgelegt ist und dafür Energie X braucht. Glasfaser schleppt das als Ballast mit. Selbst wenn die Load die zu treiben ist geringer ist und die PHYs daher etwas weniger ziehen als bei nem langen Kupferkabel. Den vollen Vorteil kannst du aus Glasfaser nur ziehen wenn di den Transciever als Maximallast annimmst und dadurch weniger Stufen beim Ausgangstreiber der Chips brauchst. Da solltest du dann auch in der Lage sein bei sehr kurzen Distanzen Energieeffizienter zu sein als mit Kupfer.

Alles? Ins andere Rack mit through Rack cabling geht schon. Aber ab so 1.5m ist Schluss mit passiven Kupferkabeln und die sind dann daumendick und starr wie Sau....bensen schrieb:Nvidia verkabelt das ganze NVL72 mit Kupfer. Ich meine sogar Inter-Rack die ganze zweite Ebene bei NVL576 ist alles Kupfer.

Man muss da schon aufpassen das man nicht ein AOC Kabel als Kupfer interpretiert. Weil es kein steckbares Kabel gibt.

Bei Privatnutzern!!!SweetOhm schrieb:Nur "gut", dass sich PCIe 5.0 noch nicht mal zur Gänze etabliert hat ...

Ähnliche Themen

- Antworten

- 83

- Aufrufe

- 12.130

- Antworten

- 85

- Aufrufe

- 8.241

- Antworten

- 88

- Aufrufe

- 10.698

- Antworten

- 32

- Aufrufe

- 6.824