Hallo,

nach dem Test der 3050 6GB habe ich mir eine "ASUS Dual GeForce RTX 3050 8G OC" gekauft, vermutlich weil ich doch irgendwie vom Leistungsniveau der 6G enttäuscht war. Die alte Grafikkarte war eine MSI Geforce 1050TI Gaming X

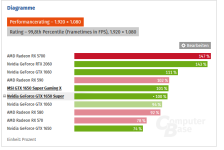

Damit ich ein paar Vergleichsdaten hatte, hab ich mir die 3DMark Benchmarks installiert.

Hier mal die Angaben zu meinem "Testsystem"

CPU: Ryzen 2600

RAM: 32GB DDR4 2933MHz

SSD: Samsung EVO 970

MB: MSI X470 Gaming

Die ASUS lässt dabei nur ein Powerlimit 100W oder -23% über die Software "GPU Tweak III" zu. Was ich natürlich auch mache um die Unterschiede nicht zu groß werden zu lassen. Und ja es sind Unterschiede.

Meine alte Geforce 1050 TI wurde mit Afterburner, vermutlich, in einem Power Target von etwa 70% gehalten.

Habe ein paar Einstellungen getestet, primär Power Target, aber auch die Lüfterkurve. Schade das Asus viel zu früh mit den Umdrehungen anfängt. Das war bei MSI besser.

Testwerte für Asus 3050 in TimeSpy

| DX | GPU / Settings | Timespy | Grafik | CPU | |

| 12 | Asus Silent Mode | 5993 | 6141 | 5274 | 226 |

| 12 | Asus Custom | 5725 | 5832 | 5190 | 210 |

| 12 | Asus Custom 2

GPU Boost max 1700 | 5632 | 5696 | 5297 | 219 |

| 12 | 3050 Custom 3

GPU Boost max 1640

GPU Temp Target 65 | 5564 | 5626 | 5240 | 215 |

| Mittelwert | | 5728,5 | 5823,75 | 5250,25 | 217,5 |

Im Vergleich dazu die MSI 1050TI:

| DX | GPU / Settings | Timespy | Grafik | CPU | Watt max |

| 12 | MSI 1050TI

Power Target 70% | 2557 | 2328 | 5809 | 156 |

| Steigerung | | 124,03% | 150,16% | -9,62% | 39,42% |

Warum die CPU um fast 10% langsamer sein soll, kann ich nicht sagen, geändert hat sich nur die Grafikkarte.

Die Leistung hat sich mehr als verdoppelt, aber leider ist auch der Stromverbrauch gestiegen.

Immerhin konnte ich die neue Karte mit der neuen Lüfterkurve für meine Verhältnisse leise betreiben.

Bei Firestrike, also DX11, war es ähnlich, Stromverbrauch ca. 40% plus auf max. 215. Die Firestrike, bzw. Grafikpunkte wuchsen um ca. 82% (auf 12607) bzw. 91% ( auf 14731), mit der letzten Einstellung (Boost max 1640 und GPU Temp Target 65 )

Der Wechsel kostet mich also max. 70W mehr Strom max, Idle könnten es 10W sein. Im Desktop Betrieb könnten es 15W mehr sein. Hier schwankt der Wert zwischen 75W und 90W. Bei der 1050 war es ähnlich, aber mit weniger Schwankungen.

Alles im allen kann der Rechner so noch mindestens zwei Jahre durchmachen, bevor eine neue CPU und ein neues Mainboard dran ist.

Und ja, ich bin kein professioneller Tester.