Iscaran schrieb:

Das was bei HisN oder bei dir bei dem 720p Test als "CPU"-Limit bezeichnet wird hat eben leider IN DER REGEL nichts mit dem Limit der CPU zu tun...sondern ist meist einfach ein I/O, RAM, HDD, oder simpel, "Coding" limit....

Deswegen hat der 720p Test auch so wenig mehr Aussagekraft wie ein 1080p Test

Das ist aber jetz schon eine totale Spekulation von dir und hat ja wenig technischen Hintergrund.

HDD? In Zeiten von SSDs?, also hier gibt es in Spielen keinen Flaschenhals nicht mal mit lahmen HDD´s und da auch nur sehr selten.

Wenn du in einem harten CPU Bottleneck bist, dann bleiben die FPS in egal ob 1080p oder 720p gleich, oder sogar in 4K, wenn die Grafikkarte stark genug ist. Nehmen wir Assassins Creed in WQHD, ich hab da mit meiner RX580 auf Mittel genausoviel FPS wie in 720p, weil dort der Prozessor limitiert.

Und um zu sehen dass der Prozessor limitiert erhöhst du dann den Takt und wenn die Leistung steigt dann ist der Prozessor das Limit.

Wenn nicht dann ist es eventuell der RAM, aber das mach ja nix, schließlich vergleichst du sowieso Plattform A mit Plattform B außerhalb des Grafikkartenlimits.

Was aber nun genau das Limit darstellt testest du weder mit 1080p noch mit 720p. Einzig und allein muss "sichergestellt" sein dass die GPU nicht annähernd im Limit ist in dem Testsetting. Heutzutage reicht es dazu mit 1080p zu testen (in der Regel) da eine 1080 Ti eben in 1080p schon ziemlich NICHT-limitierend ist.

Man will aber keine Annäherungswerte, sondern Werte ohne Messungenauigkeit, also ohne GPU Einfluss.

Was ist denn daran so schwer zu verstehn? Akzeptier es doch bitte endlich mal dass außerhalb eines GPU Einflusses die Intel Prozessoren halt nach wie vor schneller sind und um die CPU zu testen verringert man eben GPU Einfluss. Ganz einfach.

Musst malt mal deine CPU-Last und GPU-Last mit loggen (wie bei GameGPU) und sehen was passiert CPU-seitig @720p und @1080p...wollen wir wetten dass die CPU-Last in beiden Fällen sich nicht merklich ändert ?

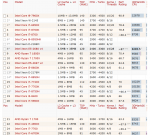

Nimmst du diesen Test her, dann ändert sie sich zu 100% in fast der Hälfte der Spiele, weil die Hälfte in ein Limit rennt, das nicht die CPU´s bilden.

Nach deiner Theorie müsste doch aber die CPU deutlich ausgelasteter sein wenn du in 720p testest als in 1080p (mit einer top-GPU wie einer 1080 Ti). Ist es aber in der Regel nicht.

Beweis durch Behauptung? Wenn die CPU mehr zu arbeiten hat, da sie nicht durch die GPU gebremst wird, wird die Auslastung der einzelnen Threads hochgehen, so einfach und so logisch und so einfach das daheim am eigenen System auszuprobiern, was du ganz bestimmt nie getan hast, weil dus sonst besser wissen würdest.

Und deswegen ist es ein Trugschluss dass du meinst mit 720p irgendeine Aussage über eine vermeintliche CPU-limitierung treffen zu können.

Ich finds schon wahnsinn was man sich alles einreden kann. Verringerte Auflösung 720p dreht in den Fällen wo in 1080p noch die GPU Einfluss auf die FPS hat, den Einfluss deutlich runter, genauso wie eine schnellere Grafikkarte in 1080p dasselbe übernimmt.

Und da die CPU nicht für die Berechnung der Auflösung zuständig is is deine ganz Argumentation Banane.

Und noch viel trügerischer ist es daraus jedwede Prognose für irgendwas abzuleiten für die "Zukunft" oder gar zu verallgemeinern von Game A auf Game B etc.

Noch trügerischer ist es wenn alle CPU´s gleichschnell sind, weil sie durch die GPU limitiert werden.

Du setzt deine Argumente völlig falsch ein und ziehst die falschen Rückschlüsse.

Teste bitte deine CPU´s in 4K, das wäre dann noch untrügerischer, spinnt man deine Theorien weiter.

Pisaro schrieb:

Sind wir erstmal bei einem 4k Standard mit leistungsfähigen Grafikkarten angekommen, reicht vermutlich Full HD generell um den Prozessor zu testen.

Ganz genau, in dem Falle muss man sicher nimmer auf 720p runter.

Iscaran schrieb:

Ja Begrifflichkeiten sind nunmal nicht unwichtig. Es ist halt was fundamental anderes als ein echtes CPU-Limit...sieht man ja gut an der "Auslastung" der CPUs bei 720p...ist mitnichten 100%. Selbst oft nichtmal auf einem Thread

In Spielen hast du oft keine 100% Auslastung auf einem Thread, in Anwendungen übrigens oft auch nicht.

Ist dein Argument gegen 720P Auflösung, dass es kein 100% echtes CPU Limit ist, weil RAM und ne gammlige HDD und vielleicht die API in dem das ganze läuft auch irgendwie mit reinspielt?

Ja dann Welcome to Reality. Die Frage ist nur wieso dein Herumreiten auf diesen Spitzfindigkeiten wichtiger sein soll als die GPU aus der Rechnung zu nehmen, die halt einfach mal in 99,99% der Fälle einen CPU Test stört.

Bei dir liegt ein tiefes Verständnisproblem vor, das wohl niemand so einfach auflösen kann, deswegn geb ichs an dieser Stelle auf.

Du sagst dasselbe wie ZeroZerp aber kommst dann wieso auch immer zu völlig anderen Rückschlüssen.