Hallo liebe AMD-Experten,

nachdem ich es gestern endlich geschafft habe, beide BIOS-Optionen meiner Sapphire Nitro+ RX 570 8GB verwenden zu können, stellt sich mir direkt eine ganze Reihe von neuen Problemen, die vor allem auch das Zusammenspiel mit meinem Monitor (BenQ EW3270U) betreffen. Diese würde ich gerne alle hier in diesem Thread bündeln, damit das ganze (auch für Leute, die später ähnliche Probleme mit dieser Kombination haben) übersichtlicher wird.

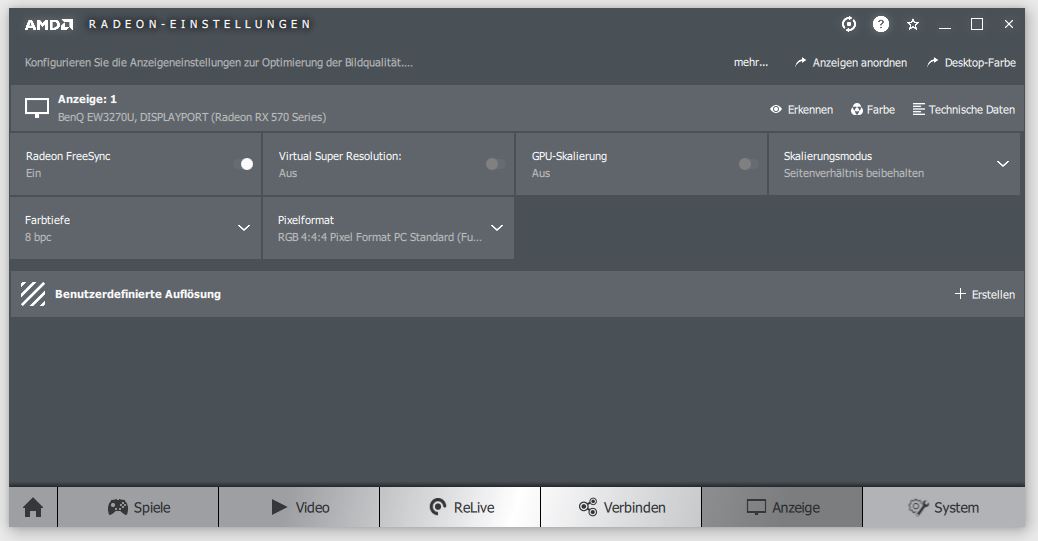

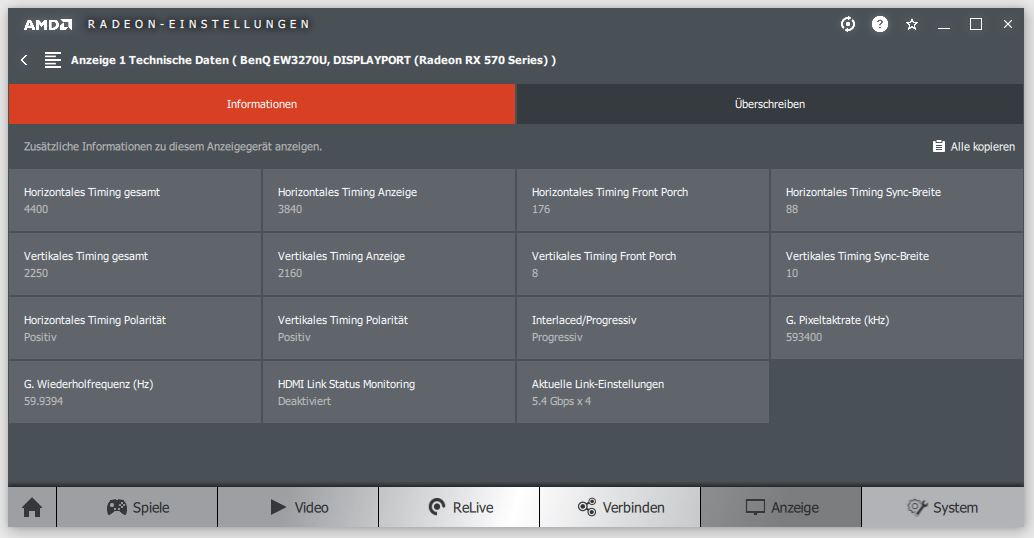

1. Ich kann im Radeon-Treiber als Farbtiefe zwar 10 Bit (RGB 4:4:4) einstellen, die Einstellung springt aber dirket wieder auf 8 Bit zurück, obwohl mein Monitor eigentlich 10 Bit unterstützt und dieser mit einem DisplayPort-Kabel (1.4) von Lindy mit meiner GPU verbunden ist, das diese Einstellungen eigentlich ebenfalls beherrschen sollte. Wenn ich das Pixelformat auf 4:2:2 (YCbCr) ändere, sind zwar 10 Bit dauerhaft möglich, vor allem Schrift und andere feine Konturen sehen dann aber grässlich aus. In meinen Einstellungen sieht es momentan folgendermaßen aus:

Schließt man stattdessen ein HDMI-Kabel (2.0) an, verschwindet die Option für 10 Bit bereits aus der Liste der auswählbaren Farbtiefen. Hier kann man von vorneherein bei RGB 4:4:4 nur 8 Bit auswählen.

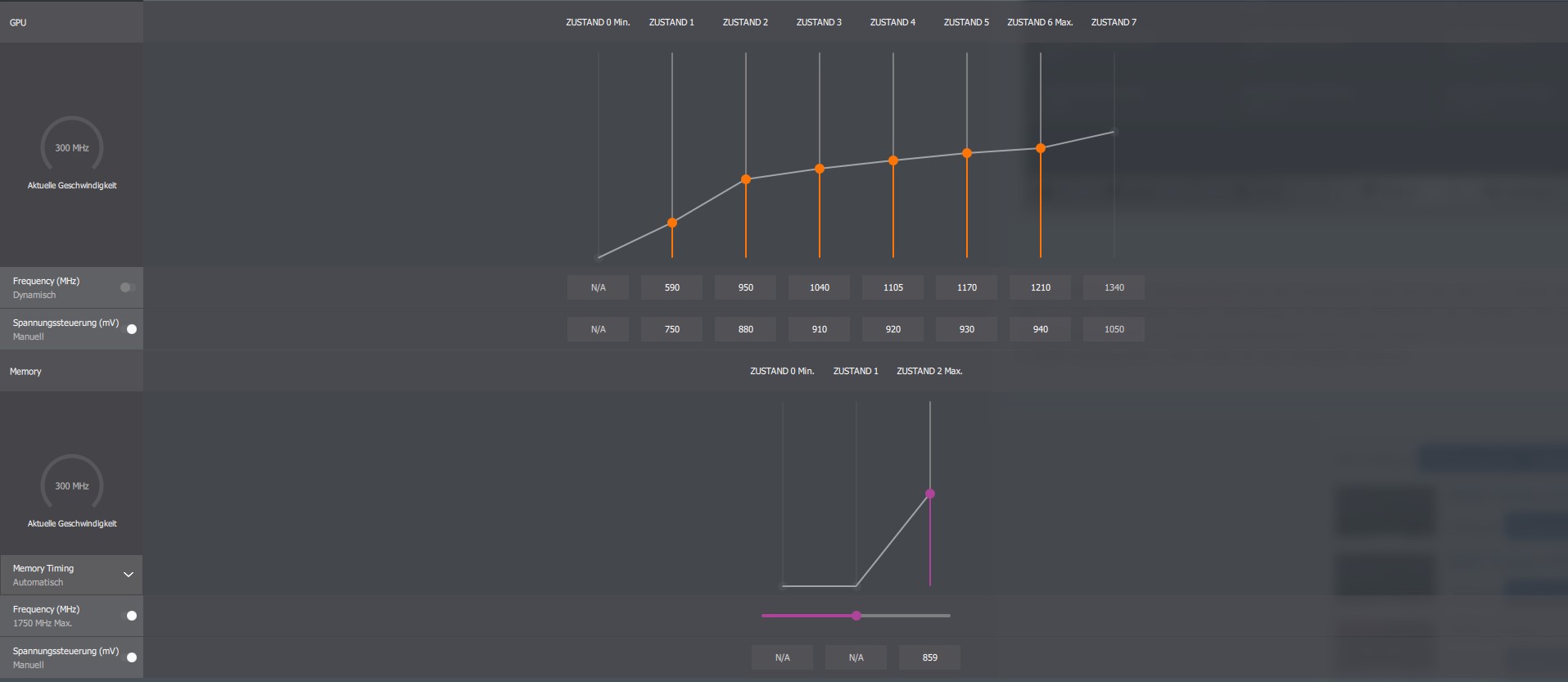

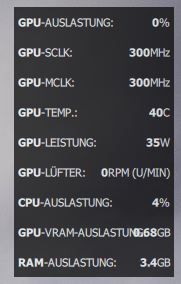

2. Die Grafikkarte ist undervolted und der maximale Takt von mir auf 1210 MHz beschränkt. Unter Volllaust braucht die Karte so ca. 80W, was ich sehr angenehm finde. Allerdings ist der Idle-Verbrauch (ein 4K-Monitor, 0% Auslastung, 300 MHz Core/Memory) mit ca. 33-38W und einer Temperatur von 37-39 Grad unangemessen hoch. Laut einem Test von Golem.de sollte eine RX 570 in diesem Szenario eigentlich nur ca. 14 Watt verbrauchen und nicht mehr als das doppelte hiervon. Beim Anschauen eines Videos auf YouTube steigt der Verbrauch auf ca. 42 Watt an, wobei hier laut der Tabelle eigentlich 21 Watt ein normaler Verbrauch wäre. Am Verbrauch ändert sich nichts, wenn man den Monitor anstelle des DisplayPort-Kabels stattdessen mit einem HDMI-Kabel verbindet.

Habt ihr eine Idee, wie man die oben genannten Probleme lösen könnte? Ich habe den alten Treiber meiner GTX 560 Ti und auch die bisherige Version des AMD-Treibers im abgesicherten Modus mit DDU deinstalliert und die neuste Version der AMD-Software erneut installiert (19.2.2). Dies hat leider nicht bei der Behebung der oben genannten Probleme geholfen. Die Probleme bestanden auch schon mit der vorherigen Version des AMD-Treibers. Der neuste Treiber für den Monitor wurde ebenfalls heruntergeladen und ordnungsgemäß installiert. Ich bin mit meinem Latein leider mittlerweile echt am Ende und hoffe sehr, dass ihr einen Rat für mich habt.

Viele Grüße und vielen Dank schon einmal im Voraus für eure Hilfe

Ic3cube3

nachdem ich es gestern endlich geschafft habe, beide BIOS-Optionen meiner Sapphire Nitro+ RX 570 8GB verwenden zu können, stellt sich mir direkt eine ganze Reihe von neuen Problemen, die vor allem auch das Zusammenspiel mit meinem Monitor (BenQ EW3270U) betreffen. Diese würde ich gerne alle hier in diesem Thread bündeln, damit das ganze (auch für Leute, die später ähnliche Probleme mit dieser Kombination haben) übersichtlicher wird.

1. Ich kann im Radeon-Treiber als Farbtiefe zwar 10 Bit (RGB 4:4:4) einstellen, die Einstellung springt aber dirket wieder auf 8 Bit zurück, obwohl mein Monitor eigentlich 10 Bit unterstützt und dieser mit einem DisplayPort-Kabel (1.4) von Lindy mit meiner GPU verbunden ist, das diese Einstellungen eigentlich ebenfalls beherrschen sollte. Wenn ich das Pixelformat auf 4:2:2 (YCbCr) ändere, sind zwar 10 Bit dauerhaft möglich, vor allem Schrift und andere feine Konturen sehen dann aber grässlich aus. In meinen Einstellungen sieht es momentan folgendermaßen aus:

Schließt man stattdessen ein HDMI-Kabel (2.0) an, verschwindet die Option für 10 Bit bereits aus der Liste der auswählbaren Farbtiefen. Hier kann man von vorneherein bei RGB 4:4:4 nur 8 Bit auswählen.

2. Die Grafikkarte ist undervolted und der maximale Takt von mir auf 1210 MHz beschränkt. Unter Volllaust braucht die Karte so ca. 80W, was ich sehr angenehm finde. Allerdings ist der Idle-Verbrauch (ein 4K-Monitor, 0% Auslastung, 300 MHz Core/Memory) mit ca. 33-38W und einer Temperatur von 37-39 Grad unangemessen hoch. Laut einem Test von Golem.de sollte eine RX 570 in diesem Szenario eigentlich nur ca. 14 Watt verbrauchen und nicht mehr als das doppelte hiervon. Beim Anschauen eines Videos auf YouTube steigt der Verbrauch auf ca. 42 Watt an, wobei hier laut der Tabelle eigentlich 21 Watt ein normaler Verbrauch wäre. Am Verbrauch ändert sich nichts, wenn man den Monitor anstelle des DisplayPort-Kabels stattdessen mit einem HDMI-Kabel verbindet.

Habt ihr eine Idee, wie man die oben genannten Probleme lösen könnte? Ich habe den alten Treiber meiner GTX 560 Ti und auch die bisherige Version des AMD-Treibers im abgesicherten Modus mit DDU deinstalliert und die neuste Version der AMD-Software erneut installiert (19.2.2). Dies hat leider nicht bei der Behebung der oben genannten Probleme geholfen. Die Probleme bestanden auch schon mit der vorherigen Version des AMD-Treibers. Der neuste Treiber für den Monitor wurde ebenfalls heruntergeladen und ordnungsgemäß installiert. Ich bin mit meinem Latein leider mittlerweile echt am Ende und hoffe sehr, dass ihr einen Rat für mich habt.

Viele Grüße und vielen Dank schon einmal im Voraus für eure Hilfe

Ic3cube3

Anhänge

Zuletzt bearbeitet: