ErnstHaft99 schrieb:

Das wird nicht adressiert, weil es auch gar nicht stimmt. Dass der extra Cache bei wenig fps nichts bringt, ist halt nicht so. Warum sollte das auch so sein? Da werden Daten bereitgehalten, ob bei 10 fos oder 500 fps.

Moment, ich habe nie gesagt, dass es "nichts" bringt. Ich sagte, der Vorteil nimmt mit sinkender FPS ab, respektive der Vorteil steigt mit steigender FPS. Was auch technisch völlig logisch ist, wenn du mal etwas genauer darüber nachdenkst.

Es ist technisch so, dass der Weg von CCD zum IO Die und RAM immer gleich lang ist. Ein 5800X hat die effektiv selbe Straflatenz wenn er auf den RAM Zugreifen will/muss wie ein 5800X3D. Ein 7700X zu einem 7800X3D ebenso. Genau so wie von 9700X zu 9800X3D. Mal von winzigen Unterschieden durch vielleicht paar MHz Taktdifferenz abgesehen.

Nun ist es eben aber so, wenn die Latenz statisch hoch ist, dann ist auch der Gewinn statisch hoch, wenn man diese Latenz nicht mehr hat. Sprich ein Cache Hit ggü. dem Zugriff über den IO Die in den RAM bedeutet einen absolut gesehen fixen Wert an Zeiteinsparung.

Technisch wird bei Spielebenchmarks mit FPS Messungen aber die Anzahl der Bilder in einer Sekunde ermittelt (sagt ja der Name schon). Rechne es dir selbst aus. Wenn du deine Beispiel 10 FPS nimmst - dann sind das 100ms pro Bild die der Prozessor arbeitet (absolutes CPU Limit mal angenommen - wir sprechen ja von CPU Benchmarks). Wenn du 500 FPS hast, dann sind das 2ms pro Bild. Was passiert jetzt, wenn du die statisch gleich hohe Straflatenz durch mehr Cache auf einmal nicht mehr hast? Sagen wir angenommen 1ms gespart -> bei 100ms für ein Bild ergibt das 99ms - und auf die Sekunde betrachtet für die FPS Messung wären das 10,1 FPS. (1000ms / 99ms = 10,1 FPS). Bei 500 FPS Basis und 2ms pro Frame sind 1ms gesparte Latenz aber schon 50% der Dauer - das wären dann 1000ms / 1ms = 1000 FPS. Macht doppelte Geschwindigkeit.

Die 1ms in dieser Beispielrechnung ist btw. nur zur Illustration. Real pratisch reden wir da über Nano Sekundenbereiche.

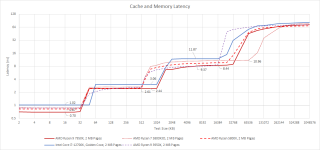

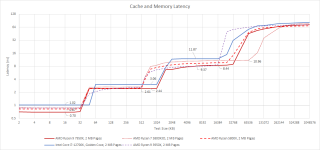

Zur Veranschaulichung, wie der Cache auf die Latenz wirkt:

Das ist jetzt nicht das neueste Modell, aber spielt für das Verständnis keine Rolle. Man erkennt sehr schön, dass die größere Cache Größe des 5800X3D in diesem Bild deutlich länger die niedrigere Latenz aufzeigt beim Datenzugriff wie ein Modell mit niedrigerem Cache. Das Treppenmuster zeigt die Geschwindigkeit der Cache Größen zur jeweiligen Straflatenz. Alles größer dem L3 Cache geht dann in der Messung ungefähr Faktor 5 langsamer.

Wenn du jetzt diese kurze Zusammenfassung nochmal auf diese FPS Messungen drüber legst, müsstest du selbst auch feststellen, dass um so mehr FPS da im Benchmark anliegen, desto mehr wird ein Prozessor mit viel Cache davon auch profitieren ggü. dem quasi gleichen Modell mit weniger Cache. Einfach weil der Latenzvorteil durch den Cache statisch hoch ist und die FPS Messmethode auch immer statisch auf 1000ms betrachtet ist. Simple Mathematik sagt dir dann, dass FPS = Summe aus (Rechendauer + Straflatenz) / 1000ms ergibt. Wenn die Rechendauer fix ist (und das ist sie, ein Zen3/4/5 Core jeweils ist bis auf minimale Taktunterschiede jeweils gleich schnell zum X3D Modell) und die Straflatenz fix ist, dann MUSS am Ende der Vorteil im Verhältnis mehr steigen, wenn die FPS höher wird. Eine andere Komponente gibt es in der Gleichung nicht.

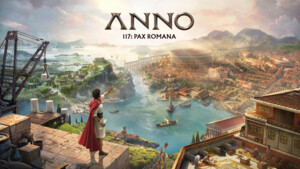

Nicht dass wir uns da falsch verstehen - für den Spieler sind die technischen Details am Ende nicht so wirklich relevant. Aber was der Nutzer am Ende halt sehen wird ist, dass die Modelle, die zu Lebzeiten in den CPU Benchmarks von Games durch Low Res Settings und High FPS sonst wie viel Vorsprung aufzeigen, dieser Vorsprung real praktisch mit steigender Anforderung an die Rechenwerke schwinden wird. Sprich wenn die Basis FPS niedriger wird, wird der Vorteil vom Cache zurück gehen. Exakt das kann man hier mit Anno schon für den AM4 X3D beobachten.

Sun_set_1 schrieb:

Die Hitrate sinkt, nicht aber der Vorsprung gegenüber non X3D. Ganz einfach weil immernoch 96MB primär über den Cache laufen und nicht wie bei Intel 32MB.

In einem reinen CPU Benchmark wäre das so, das stimmt - ihr vergesst hier aber, dass kein Rechenbenchmark bei einer FPS Messung stattfindet, sondern eine reine Durchsatzmessung.

FPS Messungen sind nichts anderes als das quasi immer gleiche Rechenergebnis möglichst oft in einer Sekunde zu erzeugen und zu messen, wie viele durchläufe man schafft.

Das ist ein Himmelweiter Unterschied zu einem regulären Rechenwerk-Benchmark, wo die Rechengeschwindigkeit bestimmt wie viel Leistung bei rum kommt. Bei Games bestimmt nicht primär das Rechenwerk, sondern viel viel Straflatenz in so einem Prozessor existiert, da diese Straflatenz von den fixen 1000ms einer auf eine Sekunde kumulierten Messungen eben dafür sorgt, dass von der Sekunde am Ende weniger Zeit über bleibt für die reine Berechnung.

Technisch kann der Prozessor durchgehend 1000ms lang rechnen und das mit so ziemlich nahezu Null Straflatenz. Simpelstes Numbercrushing mit kleinsten Datenmengen die im L1 Cache gehalten werden können bspw. Dann hat es nahezu keinen Leerlauf in den Rechenwerken. Bei FPS Messungen in Spielen existiert viel Leerlauf in den Rechenwerken, weil für das jeweilige Frame IMMER!! eine recht große Datenmenge verarbeitet werden muss. Um so mehr dieser Daten so nah wie möglich an die Rechenwerke ran kommt, desto weniger muss das Ding pro 1000ms Messzeitraum auch auf Daten warten.

Muss ich einmal am Tag in den Keller rennen, weil ich was holen soll, fällt das sicher nicht ins Gewicht. Wenn ich im Minutentakt aber in den Keller rennen muss, dann spielt es eine große Rolle, wie lange ich dafür brauche. Alle eine Minute in den Keller gehen bei einer Dauer von sagen wir 30 Sekunden bedeutet, dass der halbe Tag mit unnötigen Wegen verplempert wird. Spare ich mir das, dann gewinne ich sehr sehr viel Zeit für andere Dinge.

Starcraftfreak schrieb:

Genau dies wollte ich auch in den Ring werfen.

Am einfachsten wäre es einfach einen non-X3D auf AM5 mit nur Single-Channel laufen zu lassen um den Einfluss des RAM zu sehen.

Das ist nicht so das große Thema. RAM Speed selbst und allein bringt bei AM4 relativ wenig.

Was Punkte gibt ist die IF 1:1 dem RAM zu takten und bei Erhöhung des RAM Speeds diese quasi zu übertakten. Technisch gesehen (das haben nur die aller wenigsten Redaktionen getestet) kannst du aber auch mit arsch langsamen RAM und 3800-4000er IF Takt punkten, weil die IF das Latenzproblem erzeugt, nicht der RAM.

Ggü. DDR5 ist das zudem auch wieder eine andere Thematik - weil DDR4 zwar niedriger taktet und niedrigere Durchsätze schafft, aber viel schärfere Timings zulässt.

3600-4000 mit CL14 ist bei DDR5 schon ne ziemliche Hausnummer das zu toppen. Das wären im Schnitt dann 7200-8000 CL28 um überhaupt erstmal gleich zu ziehen.