neuhier08

Lt. Commander

- Registriert

- Sep. 2008

- Beiträge

- 1.666

Hallo liebes CB-Team,

ich habe zwei kurze Fragen:

1. Nenne uns bitte deine aktuelle Hardware:

(Bitte tatsächlich hier auflisten und nicht auf Signatur verweisen, da diese von einigen nicht gesehen wird und Hardware sich ändert)

2. Beschreibe dein Problem. Je genauer und besser du dein Problem beschreibst, desto besser kann dir geholfen werden (zusätzliche Bilder könnten z. B. hilfreich sein):

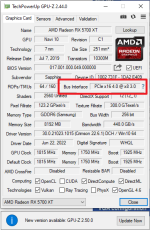

Der folgende CPU-Z Screenshot zeigt beim Bus Interface "PCIe x16 4.0 @x8 3.0".

PCIe 3.0 ist ok, weil das Board nur 3.0 kann. Was ich nicht verstehe, ist der Speed von x8? Ich hätte hier x16 erwartet.

Welchen Effekt hat PCIe 3.0 x16 vs PCIe 3.0 x8 in der Praxis fürs Zocken?

ich habe zwei kurze Fragen:

1. Nenne uns bitte deine aktuelle Hardware:

(Bitte tatsächlich hier auflisten und nicht auf Signatur verweisen, da diese von einigen nicht gesehen wird und Hardware sich ändert)

- Prozessor (CPU): i7-5930k

- Arbeitsspeicher (RAM): 32 GB DDR4 3000

- Mainboard: x99 Deluxe

- Netzteil: Seasonic Prime Platinum 750W

- Gehäuse: -

- Grafikkarte: RX5700XT Nitro

- HDD / SSD: P5 Plus

2. Beschreibe dein Problem. Je genauer und besser du dein Problem beschreibst, desto besser kann dir geholfen werden (zusätzliche Bilder könnten z. B. hilfreich sein):

Der folgende CPU-Z Screenshot zeigt beim Bus Interface "PCIe x16 4.0 @x8 3.0".

PCIe 3.0 ist ok, weil das Board nur 3.0 kann. Was ich nicht verstehe, ist der Speed von x8? Ich hätte hier x16 erwartet.

Welchen Effekt hat PCIe 3.0 x16 vs PCIe 3.0 x8 in der Praxis fürs Zocken?