Dome87 schrieb:

Wenn ein 12900K dann keine "echten" 16 Kerne hat (sich aber dennoch in 50% der Anwendungen vor einen 5950X schiebt) oder ein 5800X3D unantastbar bei der Effizienz ist (dann aber gerne nicht beachtet wird, dass er im IDLE genau die 20-30W mehr braucht als ein Intel, die er beim Gaming spart) weiß man, das man keine auf Fakten basierende Diskussion mehr führen kann.

Was juckt mich, ob die Ryzen CPU 20-30 W im Idle mehr verbraucht, wenn der Gesamtverbrauch aus Board-CPU-Ram bei beiden Herstellern gleiche Werte ausspucken? Es juckt mich als Endanwender nicht, ob bei Intel nun das Board mehr verbraucht, oder die CPU.

Was aus der Steckdose genuckelt wird, ist der interessante Wert und da wurden dir schon dutzend mal die Testergebnisse gepostet, dass ADL und Zen3 sich absolut auf dem gleichen Niveau befinden.

Dadurch verbraucht der Intel eben im Idle nicht weniger, da zu einer CPU auch ein Board und Ram gehört, sonst ist das Teil nur ein besserer Briefbeschwerer.

Dome87 schrieb:

So lange hier immer dieselben User auf dem roten Auge blind sind, lohnt sich die Mühe der ganzen Postings nicht. Und die, die wirklich sachlich und neutral beide Unternehmen ähnlich "symphatisch" finden und sich einfach nur auf die kommende Technik und den Austausch darüber freuen, ja die gehen hier komplett unter.

Solange weiter falsche Behauptungen aufgestellt werden, siehe deinen oberen Teil des Posts, solange wird sich im Forum auch nichts ändern. Wärst du wirklich Technik-Interessiert, wüsstest du, dass der Idle Verbrauch eben nicht so ist, wie du ihn darstellst. Eine CPU alleine funktioniert nunmal nicht.

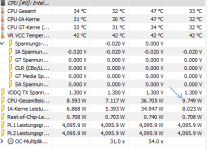

Hier das ganze nochmal zur Verdeutlichung.

Also im Idle zwischen 44 und 46 Watt...das sind bei mir nun keine 20-30 W.

Und gleich kommst du dann wieder mit dem Teillast-Bereich, wo wir beide wissen, dass beide Hersteller nun im Verbrauch peaken um die Tasks schnellstmöglich abzuarbeiten. AMD nennt das Race to sleep, bei Intel ist es halt der Turbo-Boost.