Mein Neo G9 schafft auch den Doppelwumms dass er gleichzeitig die CPU und GPU stets überfordert. Ich glaube nicht dass sich das jemals großartig ändern wird. 4k 240hz displays gibt es ja auch schon in diversen Laboren.Stanzlinger schrieb:Eine 4090 ist für die Auflösung meines Bildschirms mit 5120x2160 leider immer noch viel zu lahm.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Test Nvidia GeForce RTX 4090 im Test: Brachial schnell, auch mit weniger TDP und ohne DLSS 3

Beatmaster A.C.

Commander

- Registriert

- Juli 2008

- Beiträge

- 2.435

@Wolfgang

Ich habe da mal eine (oder ein paar) Frage(n) bezüglich der Leistungsaufnahme.

Kumpel von mir hat sich neulich eine Palit RTX 4090 Gamerock OC (+Ryzen 7800X3D) geholt und bat mich vorbeizukommen zwecks UV. Er hat zwar kein Doom Eternal zum direkten Vergleich, also musste Borderlands 3 und AC Valhalla herhalten.

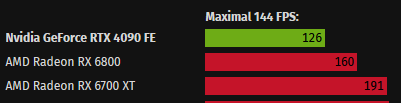

Wir kamen ums verrecken nicht mal annährend an die 126W Verbrauch, bei 1440p, Ultra settings und 144fps Limiter.

Daher die Fragen:

1. Wie wurde der limiter gesetzt? Im Spiel oder vom Treiber aus?

2. ist 126W das Minimum, der Durchschnitt oder der Spitzenverbrauch, an bestimmte Stellen im Spiel?

3. Wurde DLSS/FSR verwendet?

Bei unseren Borderlands 3 Test:

ohne Frame Limiter, Stock Karte, 1440p Ultra settings (+ Reshade):

423W Spitzenwert (wird im Benchmark, 2 mal für knapp ne Sekunde erreicht. Immer an der selben Stelle, also reproduzierbar).

144fps frame Limiter (im Nvidia Treiber), selbe settings:

334W Spitzenwert

144fps + UV (2550Mhz @0.900mV), selbe Settings:

255W Spitzenwert

144fps + UV (2550Mhz @0.900mV), selbe settings, Reshade deaktiviert:

239W Spitzenwert

144fps + UV (2550Mhz @0.900mV), selbe settings, Reshade deaktiviert, sämtliche RGB LEDs von der GPU ausgeschaltet:

229W Spitzenwert

Bei AC Valhalla, sah es etwas besser aus aber immer noch relativ weit weg von den 126W.

144fps + UV (2550Mhz @0.900mV), FSR Qualität, Reshade deaktiviert, sämtliche RGB LEDs von der GPU ausgeschaltet:

143W Spitzenwert

Daher kam ich zu folgenden Theorien:

1. Die Founders Edition ist weitaus sparsamer, wegen den besseren VRMs.

2. Die Treiberversion aus eurem Test, belastete die GPU weniger.

3. die 126W war der Minimum Wert

4. Doom Eternal ist bei weitem nicht so hungrig nach Leistung wie BL3 oder AC Valhalla

5. Eine Kombination aus den obigen Punkten.

Ich habe da mal eine (oder ein paar) Frage(n) bezüglich der Leistungsaufnahme.

Kumpel von mir hat sich neulich eine Palit RTX 4090 Gamerock OC (+Ryzen 7800X3D) geholt und bat mich vorbeizukommen zwecks UV. Er hat zwar kein Doom Eternal zum direkten Vergleich, also musste Borderlands 3 und AC Valhalla herhalten.

Wir kamen ums verrecken nicht mal annährend an die 126W Verbrauch, bei 1440p, Ultra settings und 144fps Limiter.

Daher die Fragen:

1. Wie wurde der limiter gesetzt? Im Spiel oder vom Treiber aus?

2. ist 126W das Minimum, der Durchschnitt oder der Spitzenverbrauch, an bestimmte Stellen im Spiel?

3. Wurde DLSS/FSR verwendet?

Bei unseren Borderlands 3 Test:

ohne Frame Limiter, Stock Karte, 1440p Ultra settings (+ Reshade):

423W Spitzenwert (wird im Benchmark, 2 mal für knapp ne Sekunde erreicht. Immer an der selben Stelle, also reproduzierbar).

144fps frame Limiter (im Nvidia Treiber), selbe settings:

334W Spitzenwert

144fps + UV (2550Mhz @0.900mV), selbe Settings:

255W Spitzenwert

144fps + UV (2550Mhz @0.900mV), selbe settings, Reshade deaktiviert:

239W Spitzenwert

144fps + UV (2550Mhz @0.900mV), selbe settings, Reshade deaktiviert, sämtliche RGB LEDs von der GPU ausgeschaltet:

229W Spitzenwert

Bei AC Valhalla, sah es etwas besser aus aber immer noch relativ weit weg von den 126W.

144fps + UV (2550Mhz @0.900mV), FSR Qualität, Reshade deaktiviert, sämtliche RGB LEDs von der GPU ausgeschaltet:

143W Spitzenwert

Daher kam ich zu folgenden Theorien:

1. Die Founders Edition ist weitaus sparsamer, wegen den besseren VRMs.

2. Die Treiberversion aus eurem Test, belastete die GPU weniger.

3. die 126W war der Minimum Wert

4. Doom Eternal ist bei weitem nicht so hungrig nach Leistung wie BL3 oder AC Valhalla

5. Eine Kombination aus den obigen Punkten.

Zuletzt bearbeitet:

t3chn0

Fleet Admiral

- Registriert

- Okt. 2003

- Beiträge

- 10.973

Ich muss einfach nochmal ein Loblied auf die 4090 singen. Die Karte bereitet mir einfach so viel Spaß wie keine andere Karte zuvor.

4K Extreme Preset in MW3, dazu DLSS3 (ohne Frame Generation). Vsync und Gsync sind aktiviert. Bei meinem 120Hz Monitor setzt er die FPS automatisch dann auf 116 FPS.

Ultra smooth, kein Ruckeln, nichts.

Dank DLSS3 sieht das Bild besser aus als nativ und vor allem schärfer (80% Sharpening).

Die Karte rödelt so mit 50°C und 1099RPM vor sich hin, bei 60-70% Aulastung mit 3Ghz Taktrate und nur 250W Verbrauch.

Komplett verrückt wie gut die Karte ist. Die Kombination aus schnellem RAM und der CPU gibt der Experience den Rest.

Das Bild sieht etwas komisch aus, da es mit HDR aufgenommen wurde.

In Kombination mit dem OLED ist das wirklich fantastisch.

4K Extreme Preset in MW3, dazu DLSS3 (ohne Frame Generation). Vsync und Gsync sind aktiviert. Bei meinem 120Hz Monitor setzt er die FPS automatisch dann auf 116 FPS.

Ultra smooth, kein Ruckeln, nichts.

Dank DLSS3 sieht das Bild besser aus als nativ und vor allem schärfer (80% Sharpening).

Die Karte rödelt so mit 50°C und 1099RPM vor sich hin, bei 60-70% Aulastung mit 3Ghz Taktrate und nur 250W Verbrauch.

Komplett verrückt wie gut die Karte ist. Die Kombination aus schnellem RAM und der CPU gibt der Experience den Rest.

Das Bild sieht etwas komisch aus, da es mit HDR aufgenommen wurde.

In Kombination mit dem OLED ist das wirklich fantastisch.

Anhänge

Aber nur wen Modus für geringe Latenz auf Ultra steht, oder ?t3chn0 schrieb:Bei meinem 120Hz Monitor setzt er die FPS automatisch dann auf 116 FPS.

Natürlich komplett sinnlos wenn man mit Frame Limiter zockt.t3chn0 schrieb:bei 60-70% Aulastung mit 3Ghz Taktrate und nur 250W Verbrauch.

Dann ist ein UV Profil gut weil gleiche FPS und nur ~150 Watt.

Du kannst mehrere Profile speichern und einfach per Schnelltasten zuweisen.

Zuletzt bearbeitet:

Mein Geschmack wäre die starke Überschärfung jetzt nicht. Zu viele Artefakte, bzw. Grain. Aber in der Tat geht kaum etwas über eine schöne Bildruhe und stabile Frametimes.t3chn0 schrieb:In Kombination mit dem OLED ist das wirklich fantastisch.

- Registriert

- Feb. 2019

- Beiträge

- 7.461

0ssi schrieb:Aber nur wen Modus für geringe Latenz auf Ultra steht, oder ?

Nvidia Reflex macht das...

t3chn0

Fleet Admiral

- Registriert

- Okt. 2003

- Beiträge

- 10.973

Also mir gefallen die 80% eigentlich am besten um ehrlich zu sein. Default sind irgendwie 65%. Das ist mir jedoch zu weich.Vigilant schrieb:Mein Geschmack wäre die starke Überschärfung jetzt nicht. Zu viele Artefakte, bzw. Grain. Aber in der Tat geht kaum etwas über eine schöne Bildruhe und stabile Frametimes.

Ich mag die schärferen Konturen ganz gerne. 100% ist mir dann way too much.

Ich glaube im Nvidia Treiber Modus für Geringe Latenz Ultra ist Nvidia Reflex + Boost !?Ayo34 schrieb:Nvidia Reflex macht das...

Funktioniert treiberseitig aber wohl nur in DX12. Für DX11 muss es vom Spiel kommen.

Ohne das gibt es mit G-Sync+V-Sync keinen Frame Limiter unterhalb der maximalen Hz.

Dann muss man zusätzlich noch bei Max.Bildfrequenz auf z.B. 118FPS stellen bei 120Hz.

ThirdLife

Captain

- Registriert

- Aug. 2019

- Beiträge

- 3.966

Eher ne schlechte Idee, denn darunter werden deine Perzentile und Lows leiden. Ist jetzt nicht so als ob die Ersparnis durch Magie generiert wird.0ssi schrieb:Natürlich komplett sinnlos wenn man mit Frame Limiter zockt.

Dann ist ein UV Profil gut weil gleiche FPS und nur ~150 Watt.

Caramelito

Admiral

- Registriert

- Juni 2016

- Beiträge

- 9.111

0ssi schrieb:Ich glaube im Nvidia Treiber Modus für Geringe Latenz Ultra ist Nvidia Reflex + Boost !?

Funktioniert treiberseitig aber wohl nur in DX12. Für DX11 muss es vom Spiel kommen.

Ohne das gibt es mit G-Sync+V-Sync keinen Frame Limiter unterhalb der maximalen Hz.

Dann muss man zusätzlich noch bei Max.Bildfrequenz auf z.B. 118FPS stellen bei 120Hz.

Vsync cappt doch zuverlässlich und man braucht keinen eigenen frame limiter, oder?

Blicke da nicht mehr durch bei den Settings, wusste nur immer Gsync an und frame cap monitor-hz -4hz.

Nun sollte man vsynch aktivieren + reflex (wegen unterer rand tearing?) aber kein fps cap, oder?

und vor allem nicht mehrere fps caps setzen (zB nv panel + rtts + ingame, dann battlen die sich^^)

Dann liegt aber bei maximaler Aktualisierungsrate (Hz) der Input Lag von V-Sync an.Caramelito schrieb:Vsync cappt doch zuverlässlich und man braucht keinen eigenen frame limiter, oder?

Ab 100Hz zwar nicht besonders störend aber trotzdem unnötig also Frame Limit dazu.

Ja, bei 144Hz Frame Limit auf auf z.B. 140FPS aber trotz G-Sync gibt es leichtes Tearing.Caramelito schrieb:Blicke da nicht mehr durch bei den Settings, wusste nur immer Gsync an und frame cap monitor-hz -4hz.

Ja, V-Sync ist trotz G-Sync nötig um Tearing komplett zu vermeiden. Frame Limit bleibt.Caramelito schrieb:Nun sollte man vsynch aktivieren + reflex (wegen unterer rand tearing?) aber kein fps cap, oder?

Modus für Geringe Latenz aka Reflex+Boost setzt (in DX12?) ein eigenes Frame Limit

aber da es nicht in jedem Spiel funktioniert, kann der auch Frame Limiter an bleiben.

Fazit für 144Hz im Treiber:

G-Sync Ein

Max.Bildfrequenz 140FPS

Modus für gering Latenz Ultra

Vertikale Synchronisierung Ein

Das wäre auch jeden Fall noch interessant zu testen ob ingame, Treiber oder RTSS besser ist !?Caramelito schrieb:und vor allem nicht mehrere fps caps setzen (zB nv panel + rtts + ingame, dann battlen die sich^^)

Zum Glück kann man in den meisten Spielen kein vernünftiges Limit setzten also Treiber.

Zuletzt bearbeitet:

t3chn0 schrieb:Ich muss einfach nochmal ein Loblied auf die 4090 singen. Die Karte bereitet mir einfach so viel Spaß wie keine andere Karte zuvor.

T3chn0, die glorreiche PC-Herrenrasse! 💪

Die 4000er-Serie ist schon technisch geil. Wenn ich bei GTA5 GPU-Limit-Settings, also 8xMSAA knalle, läuft die 4080 durchaus mit nur 200W, Spannung von 1,075V auf 0,975V reduziert. Generell sind da 30-60W Ersparnis drin, kommt drauf an, ob das Programm TDP frisst. Der Startbildschirm von RE4 - Chainsaw Demo ist zum Testen das Extrembeispiel. Ohne Limit und ,,ohne" Powertaget 380W und mit UV 320W.

0ssi schrieb:Ich glaube im Nvidia Treiber Modus für Geringe Latenz Ultra ist Nvidia Reflex + Boost !?

Für mich ist das quasi auch nur wie ein Framelimiter, mit den Unterschied, dass Taktreduzierungen trotz Halblast stark eingeschränkt werden und lediglich nur in Menüs kommen, nach meiner Beobachtung.

Ergänzung ()

Smagjus schrieb:Nur ist die Spannungsregulierung mittlerweile so komplex, dass man da mittlerweile performancetechnisch auch etwas kaputtmachen kann.

Reduzierung um 0,1V und 45MHz bringt bei meiner einen Leistungsverlust von 4%.

Zuletzt bearbeitet:

Youngtimer

Lieutenant

- Registriert

- Juni 2017

- Beiträge

- 823

Die 4090 ist meiner Meinung nach gut gealtert. Habe hier eine ASUS TUF Day-1 vom Oktober letzten Jahres. Gerade das Thema DLSS3 und Ray- bzw. Pathtracing hat sich stark entwickelt. CP2077 Phantom Liberty auf einem OLED war eine Offenbarung aber ich mochte das Addon auch inhaltlich sehr.

Mangels einer Ti Version und durch den China-Ban ziehen die gebrauchtwaren Preise aktuell wieder deutlich an. Wertverlust aktuell recht überschaubar.

Mangels einer Ti Version und durch den China-Ban ziehen die gebrauchtwaren Preise aktuell wieder deutlich an. Wertverlust aktuell recht überschaubar.

syfsyn

Admiral

- Registriert

- Nov. 2010

- Beiträge

- 8.905

450w das braucht mancher kompletter Pc nicht daher ist die rtx4090 gut aber viel zu stromhungrig

und wenn in Spiele Test das deutlich weniger ist liegt das nur daran das die gpu nicht ausgelastet wird.

Nix anderes, darum bin ich dafür das man bei spiele test die gpu load und die tbp angibt

Cpu limit greift deutlich öfter zu als man denkt.

Der beste chip der auch perf Watt dasteht wäre der ad104 mit nur 1,05v bei 220w tbp 2,6ghz

Das wäre etwa rtx3090ti perf für 220w vs 450w bei der vorherigen gen

Das nvidia überhaupt auf die Taktschraube ging lag primär an den mcm Gerüchten

quasi sind alle sku bis ans maximum der node Leistung gegangen.

jetzt macht die rtx4070 super auch sinn etwa rtx3090 perf für 220w

und wenn in Spiele Test das deutlich weniger ist liegt das nur daran das die gpu nicht ausgelastet wird.

Nix anderes, darum bin ich dafür das man bei spiele test die gpu load und die tbp angibt

Cpu limit greift deutlich öfter zu als man denkt.

Der beste chip der auch perf Watt dasteht wäre der ad104 mit nur 1,05v bei 220w tbp 2,6ghz

Das wäre etwa rtx3090ti perf für 220w vs 450w bei der vorherigen gen

Das nvidia überhaupt auf die Taktschraube ging lag primär an den mcm Gerüchten

quasi sind alle sku bis ans maximum der node Leistung gegangen.

jetzt macht die rtx4070 super auch sinn etwa rtx3090 perf für 220w

xxMuahdibxx

Fleet Admiral

- Registriert

- Juli 2011

- Beiträge

- 37.747

gut wenn man ein Loblied auf die GPU singt sie aber eigentlich gar nicht nutzt ... denn wenn man nur 60 % Nutze hätte auch eine 4080 gereicht.

- Registriert

- Feb. 2019

- Beiträge

- 7.461

0ssi schrieb:Ich glaube im Nvidia Treiber Modus für Geringe Latenz Ultra ist Nvidia Reflex + Boost !?

Funktioniert treiberseitig aber wohl nur in DX12. Für DX11 muss es vom Spiel kommen.

Ohne das gibt es mit G-Sync+V-Sync keinen Frame Limiter unterhalb der maximalen Hz.

Dann muss man zusätzlich noch bei Max.Bildfrequenz auf z.B. 118FPS stellen bei 120Hz.

Kann man nicht hundertprozentig vergleichen, aber das einfache Reflex im Spiel selbst reicht aus für das Framelimit in Verbindung mit GSync und VSync. Bei 360hz limitiert er automatisch auf 327 Frames.

- Registriert

- Dez. 2020

- Beiträge

- 6.405

Naja. Ich hab mir vor zwei Wochen dann tatsächlich mal Phantom Liberty geholt.xxMuahdibxx schrieb:gut wenn man ein Loblied auf die GPU singt sie aber eigentlich gar nicht nutzt ... denn wenn man nur 60 % Nutze hätte auch eine 4080 gereicht.

Damit schafft man schon gut Last auf der Karte

Auch mit Hogwarts Legacy + den Ultra+ Mod geht das.

Dafür hat man aber auch wirklich eine gute Grafik.

CoD ist da für mich abseits FPS kein Benchmark.

Meine ist mit UV sehr effizent, fiept net und rasselt net.

Dank Wakü schön kühl - den Preis blende ich da einfach mal aus.

Für mich die beste Karte seit meiner Powercolor X1950 Pro.

Ähnliche Themen

- Antworten

- 114

- Aufrufe

- 46.141