Nvidia H100 NVL: Doppel-GPU mit 188 GB HBM3 für Large Language Models

Nvidia hat zur GTC 2023 zwei neue Beschleuniger auf Basis der Hopper- und Ada-Lovelace-Architektur vorgestellt, die für den Einsatz von Large Language Models (LLM) wie GPT-3 und GPT-4 etwa bei ChatGPT oder für Generative AI bei Video und Bildern entwickelt wurden. Die H100 NVL kommt mit ihren zwei GPUs auf 188 GB HBM3.

Die H100 NVL soll in der zweiten Jahreshälfte an den Start gehen, das Inferencing von Large Language Models wie zum Beispiel denen hinter ChatGPT beschleunigen und damit den Rollout entsprechender Technologien am Markt fördern. Betreiber entsprechender Dienste können die H100 NVL in ihren Rechenzentren einsetzen, um mehr Anfragen zu bewältigen oder um noch größere LLMs als derzeit etwa bei GPT-3 und GPT-4 zu beschleunigen, die über eine noch größere Anzahl von Parametern verfügen. Die Technologie hinter ChatGPT, Bing-Chat und Google Bard hat jüngst ein Hintergrundartikel zu LLMs und Chatbots auf ComputerBase erklärt.

Hopper-Architektur statt Ada Lovelace

Nvidia setzt bei der H100 NVL auf die Hopper-Architektur, die zur GTC 2022 vorgestellt und für den Einsatz in Rechenzentren und Supercomputern konzipiert wurde. Anders als Ada Lovelace mit den bekannten RTX-4000-Grafikkarten richtet sich Hopper somit nicht an Spieler oder den klassischen Consumer, wenngleich diese durch die mit Hopper ermöglichten Apps durchaus in Kontakt mit der Architektur kommen.

Mehr als nur eine doppelte H100 PCIe

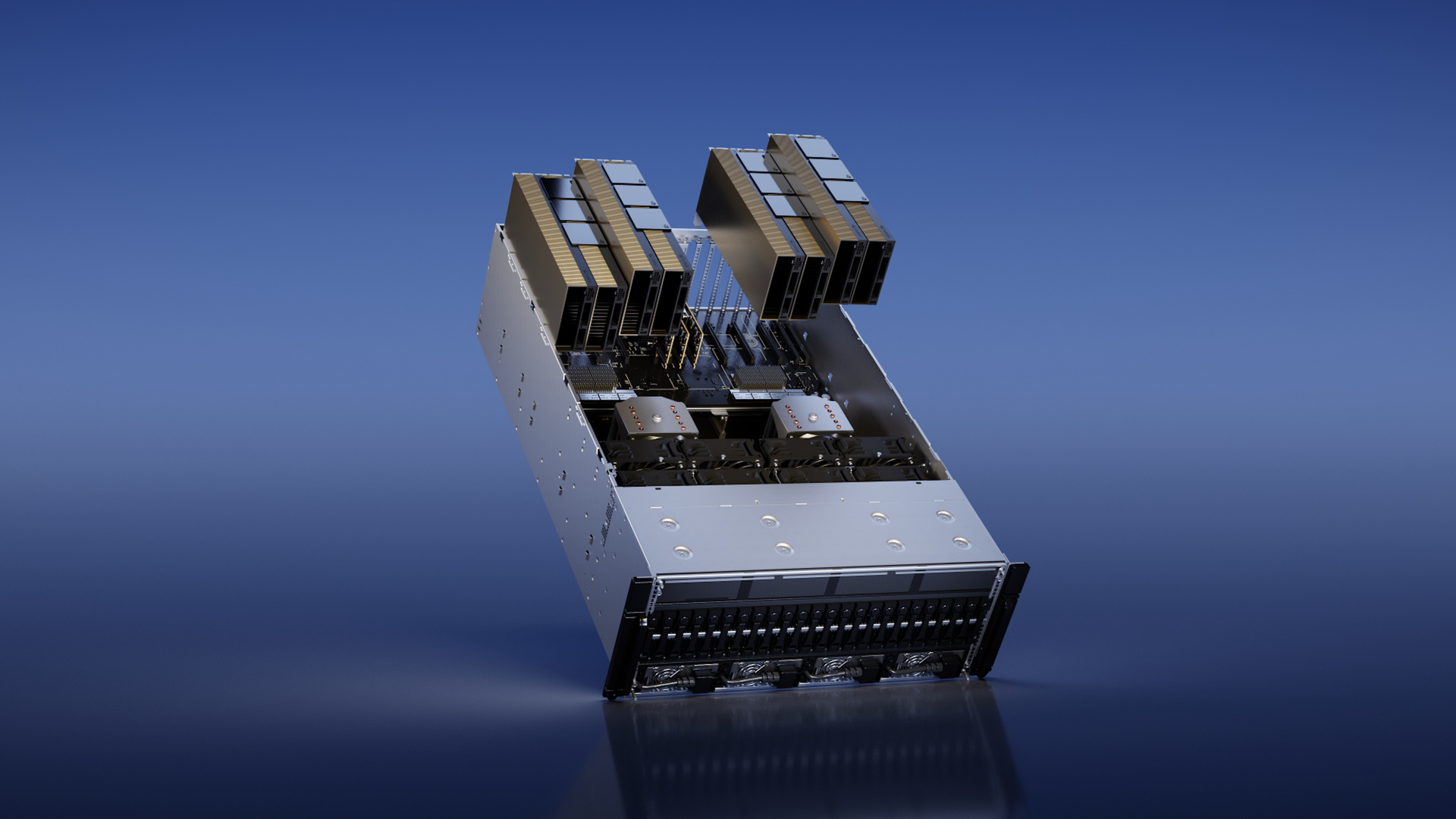

Die neueste Lösung kann als Ausbaustufe der bisherigen H100 PCIe verstanden werden, die letztes Jahr parallel zur H100 SXM5 vorgestellt wurde. Während das SXM5-Modul in den DGX-H100-Systemen von Nvidia zum Einsatz kommt, kann die H100 PCIe als eine Steckkarte oder mehrfach verbaut in klassischen Servern verwendet werden. Unterschiede waren letztes Jahr aber nicht nur im Format zu finden, sondern auch bei der Anzahl der aktiven TPCs und SMs sowie beim genutzten Speicher, der für die PCIe-Karte von 80 GB HBM3 auf 80 GB HBM2 angepasst wurde, was mit einer reduzierten Speicherbandbreite von rund 2 TB/s anstelle von 3,35 TB/s einherging.

SXM5-GPU als PCIe-Karte

Die H100 NVL ist jetzt hingegen praktisch der Chip des SXM5-Moduls auf einer PCIe-Karte und kommt darüber hinaus pro GPU sogar mit mehr Speicher daher. Unterm Strich wird pro einzelner GPU betrachtet vermutlich weiterhin das SXM5-Modul mehr Leistung bieten, weil es dort weniger Einschränkungen bei der TDP gibt. Die H100 NVL soll mit zwei GPUs auf je 350 bis 400 Watt kommen, was ähnlich auch schon bei der H100 PCIe mit 350 Watt für eine GPU der Fall war. Beim SXM5-Modul darf sich hingegen nur eine einzige GPU bis zu 700 Watt gönnen.

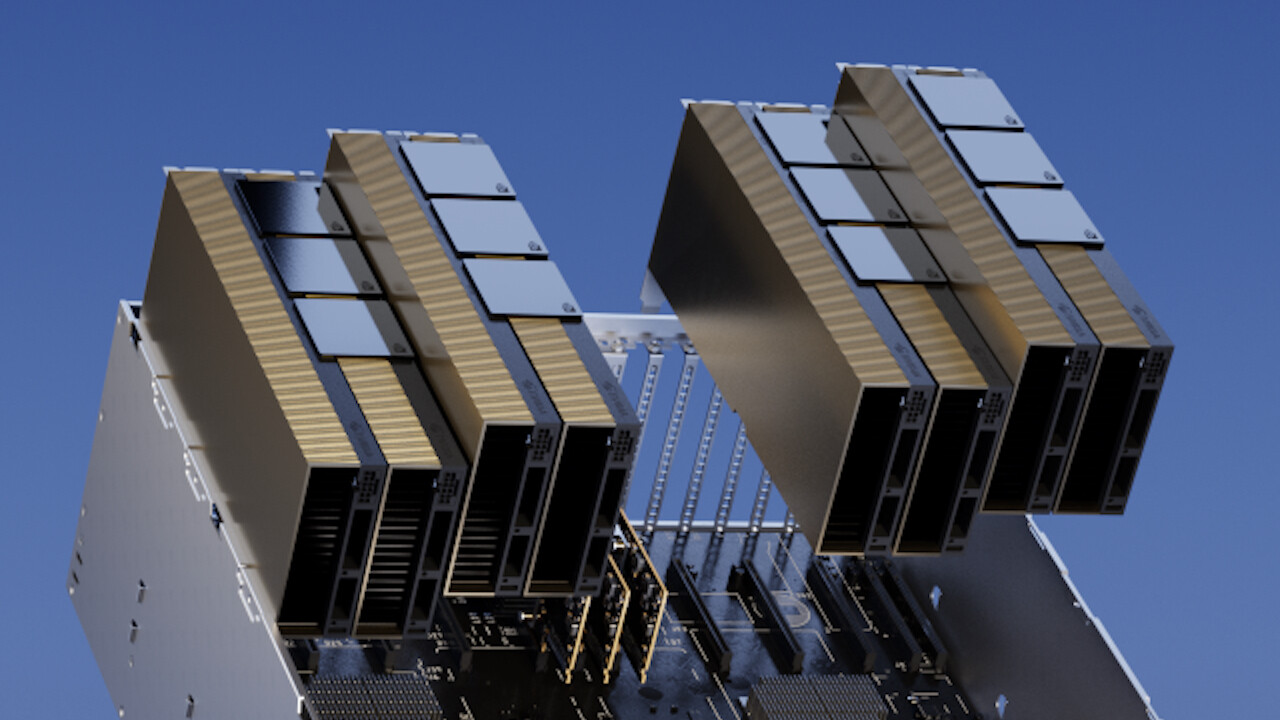

Das „NVL“ im Namen der Karte steht für NVLink oder besser gesagt die neue NVLink Bridge, die mit 600 GB/s beide Karten über eine externe Schnittstelle (Brücke) miteinander verbindet und an einen ehemaligen SLI-Aufbau erinnert. Die H100 NVL packt beide GPUs somit nicht auf ein Board, sondern auf zwei Ebenen. Auch zwei Boards über eine PCIe-Schnittstelle wie anno 2006 bei der GeForce 7950 GX2 sind es nicht, denn die H100 NVL kommt mit zweimal PCIe Gen5. Auch die bisherige H100 PCIe unterstützt NVLink bei 600 GB/s, mit der neuen Lösung bietet Nvidia die GPU aber gleich selbst im Doppelpack an und legt darüber hinaus bei der Leistung nach. Im Server können auch mehrere H100 NVL parallel genutzt werden. Partner- und von Nvidia zertifizierte Systeme sollen mit zwei bis vier Paaren laufen.

Mehr HBM3 als das SXM5-Modul

Erste Leistungsangaben des Herstellers lassen darauf schließen, dass für die Steckkarte jetzt erstmals die gleiche Ableitung des GH100-Vollausbaus wie beim bisherigen SXM5-Modul zum Einsatz kommt. Beim H100 SXM5 bleiben nämlich alle 8 GPCs aktiv, aber es werden über den Chip verteilt 12 von 144 oder 8 Prozent der SMs deaktiviert. Analog fällt die Anzahl der CUDA- und Tensor-Kerne. Für die bisherige H100 PCIe nutzt Nvidia hingegen eine deutlich reduzierte Ausbaustufe, die ganze 20 Prozent weniger Ausführungseinheiten als der Vollausbau GH100 bietet. Jetzt aber kommen die zwei GPUs der H100 NVL exakt auf die doppelten Werte für FP16 und FP8 auf den Tensor Cores wie zwei H100 SXM5. Darüber hinaus ist die H100 NVL mit mehr als zweimal 80 GB HBM3 bestückt, nämlich mit 188 GB und demnach 94 GB pro GPU. Nvidia hat der Redaktion bestätigt, dass jetzt sechs anstelle von fünf aktiven HBM-Stacks zum Einsatz kommen. Die dennoch „nur“ 94 statt 96 GB pro GPU erklärt Nvidia mit „Optimierungen in der Fertigung“, genaue technische Details (deaktivierter Layer?) hierzu fehlen noch.

| H100 NVL | H100 PCIe | H100 SXM5 | |

|---|---|---|---|

| FP64 | 68 TFLOPS | 26 TFLOPS | 34 TFLOPS |

| FP64 Tensor Core | 134 TFLOPS | 51 TFLOPS | 67 TFLOPS |

| FP32 | 134 TFLOPS | 51 TFLOPS | 67 TFLOPS |

| TF32 Tensor Core | 1.979 TFLOPS | 756 TFLOPS | 989 TFLOPS |

| BFLOAT16 Tensor Core | 3.958 TFLOPS | 1.513 TFLOPS | 1.979 TFLOPS |

| FP16 Tensor Core | 3.958 TFLOPS | 1.513 TFLOPS | 1.979 TFLOPS |

| FP8 Tensor Core | 7.916 TFLOPS | 3.026 TFLOPS | 3.958 TFLOPS |

| INT8 Tensor Core | 7.916 TOPS | 3.026 TOPS | 3.958 TOPS |

| Speicher | 188 GB HBM3 | 80 GB HBM2e | 80 GB HBM3 |

| Speicherbandbreite | 7,8 TB/s | 2 TB/s | 3,35 TB/s |

| Decoder | 14 NVDEC 14 JPEG |

7 NVDEC 7 JPEG |

7 NVDEC 7 JPEG |

| TDP | 2 × 350-400 Watt (konfigurierbar) | 300-350 Watt (konfigurierbar) | bis zu 700 Watt (konfigurierbar) |

| Multi-Instance GPUs | bis zu 14 MIGS @ je 12 GB | bis zu 7 MIGS @ je 10 GB | bis zu 7 MIGS @ je 10 GB |

| Formfaktor | 2 × PCIe Dual-Slot | PCIe Dual-Slot | SXM |

| Interconnect | NVLink Bridge 600 GB/s PCIe Gen5 128 GB/s |

NVLink 600 GB/s PCIe Gen5 128 GB/s |

NVLink 900 GB/s PCIe Gen5 128 GB/s |

| Server-Optionen | Partner und Nvidia-zertifizierte Systeme mit 2-4 Paaren | Partner und Nvidia-zertifizierte Systeme mit 1-8 GPUs | Nvidia HGX H100 mit 4 oder 8 GPUs Nvidia DGX H100 mit 8 GPUs |

| Nvidia AI Enterprise | Add-on | Add-on | inkludiert |

Wie Nvidia im Vorfeld auf Nachfrage erklärte, wird die Doppel-GPU-Karte vom Betriebssystem als zwei GPUs erkannt. Somit handelt es sich um eine andere Umsetzung als etwa beim Apple M1 Ultra, der über den eigenen Die-to-Die-Interconnect „UltraFusion“ zwei M1 Max verknüpft, doch macOS und Anwendungen sollen CPU und GPU als jeweils eine Einheit sehen. Nvidia erklärte jedoch, dass ein Auto-Spread-Mechanismus die Last stets über beide GPUs verteilen soll.

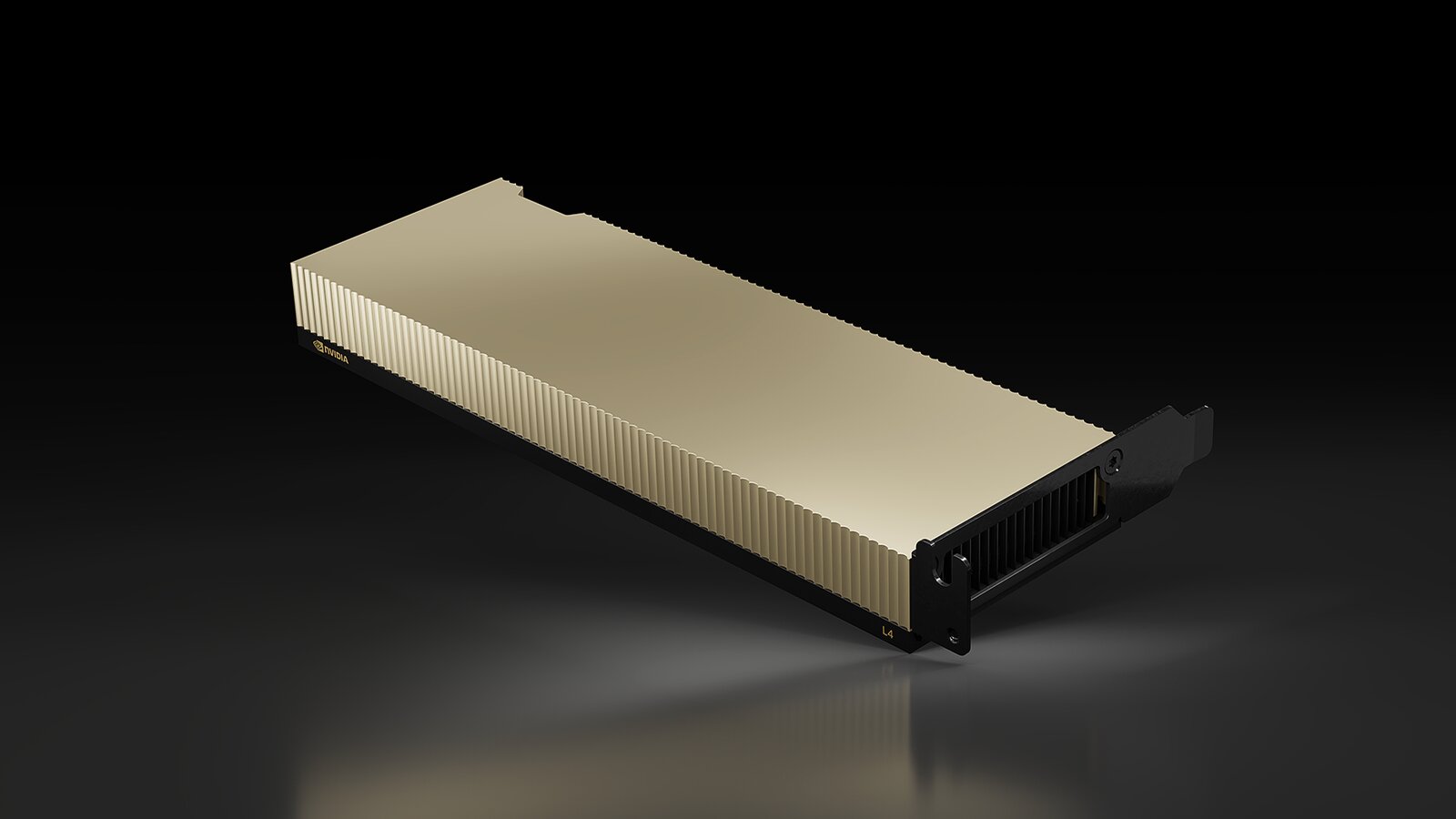

Nvidia L4 für Video, AI und Grafik

Neben der H100 NVL mit Hopper-Architektur hat Nvidia zur Hausmesse auf Basis der Ada-Lovelace-Architektur die L4 für AI Video vorgestellt. Die L4 als Nachfolger der T4 mit Turing-Architektur ist laut Nvidia für die Bereiche Video, AI und Grafik ausgelegt, sie wird aber primär über ihre Eigenschaften im Bereich Video beworben. Die L4 kann ab sofort als private Vorschau in der Google Cloud genutzt werden, soll aber auch bei über 30 PC- und Server-Anbietern an den Start gehen.

Bei Google ist der Einsatz in den neuen virtuellen Maschinen der G2-Klasse vorgesehen. Dort kann die L4 AI-gestützte Tools wie Descript beschleunigen, um Video und Audio in wenigen Schritten zu bearbeiten oder Fehler zu beheben. Bei AI Video komme die L4 laut Nvidia auf eine 120-fache Leistung und 99 Prozent bessere Effizienz als ein reines CPU-System. Der Hersteller hat dabei acht L4 mit zwei Intel Xeon Platinum 8380 verglichen. Wombo nutzt die L4 in Googles Cloud für das Generative-AI-Tool Dream, das aus Texteingaben des Nutzers Bilder generiert. Die L4 kann auch als Decoder für die Verteilung von Videostreams genutzt werden und dabei 1.040 Streams parallel decodieren. Die Karte kommt im Single-Slot-Low-Profile-Format und wird nur über den PCIe-Slot mit Strom versorgt.

ComputerBase hat Informationen zu diesem Artikel von Nvidia unter NDA erhalten. Die einzige Vorgabe war der frühestmögliche Veröffentlichungszeitpunkt.