OpenAI-Chef Sam Altman: Staat muss Entwicklung von ChatGPT und Co. kontrollieren

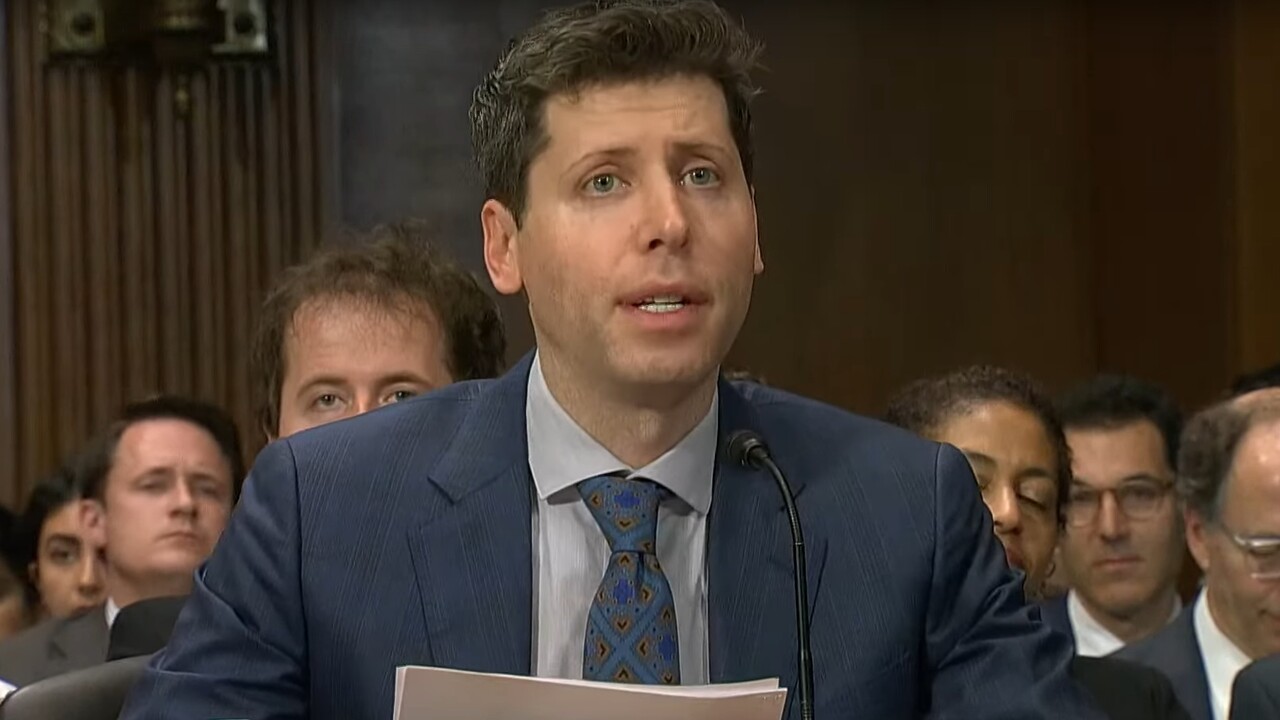

Neben der EU wollen auch die USA die aktuellen KI-Entwicklungen regulieren. Nun intensiviert auch der US-Kongress das Gesetzgebungsverfahren mit einer Reihe von Anhörungen. Bei der ersten Anhörung war OpenAI-Chef Sam Altman vorgeladen, der sich erneut für eine staatliche Regulierung aussprach.

So erklärte Altman bereits in seiner ersten Stellungnahme, dass „ein regulierendes Eingreifen der Regierungen entscheidend sein wird, um die Risiken der immer leistungsfähigeren Modelle zu entschärfen“. Mögliche Ansatzpunkte wären etwa ein Lizenz- und Testverfahren für die Entwicklung und Veröffentlichung von Modellen, die eine bestimmte Größenordnung überschreiten.

Die Anhörung in voller Länge. Ein Transkript findet sich hier.

Veranstaltet wurde die Anhörung vom US-Senat, der sich mit der Aufsicht von Künstlicher Intelligenz und einem Regelwerk befassen will.

Senat: Bei KI-Regulierung nicht dieselben Fehler wie bei Social Media machen

Wenig überraschend nutzte Altman die Gelegenheit, um die Vorteile der KI-Entwicklung zu unterstreichen. Künstliche Intelligenz habe das Potenzial, das Leben in nahezu allen Aspekten zu verbessern und könnte zudem einen Beitrag leisten, um Herausforderungen der Menschheit wie den Klimawandel zu bewältigen. Ernsthafte Risiken würden auch bestehen, so Altman. Entscheidend sei daher die Arbeit im Kongress, um potenzielle Nachteile zu bewältigen und von den „enormen Vorteilen“ profitieren zu können.

Wie Altman vor dem Kongress spricht, war im Kern nicht überraschend. Erstaunlich war vielmehr, wie freundlich die Senatoren waren. „Der Kongress hasst Big Tech, aber scheint weiterhin zuversichtlich bei Künstlicher Intelligenz zu sein“, heißt es etwa bei The Verge. Erkennen lässt sich das bereits in den Auftakt-Stellungnahmen. Der Demokratische Senator Richard Blumenthal nennt Risiken, dazu zählt er Desinformation, Diskriminierung, Belästigungen, Betrug sowie das Klonen von Stimmen und generell Deep Fakes. Nichtsdestotrotz vergleicht er ChatGPT und GPT-4 mit den ersten Mobiltelefonen und bezeichnet die aktuelle Technologie als Start einer neuen Ära.

Wesentlich ungemütlicher verliefen da die Anhörungen von TikTok-CEO Shou Zi Chew oder Meta-Chef Mark Zuckerberg. Beide mussten sich äußerst unangenehme Fragen gefallen lassen und wurden bisweilen vorgeführt. Dass die Social-Media-Plattformen generell keinen guten Ruf bei den Senatoren haben, verdeutlichte auch die Anhörung nochmals. So bezeichnet Blumenthal die KI-Regulierung als Chance, die der Kongress ergreifen müsse. „Wir hatten die gleiche Wahl, als wir mit den sozialen Medien konfrontiert wurden. Wir haben versagt, diesen Moment zu nutzen“, so Blumenthal.

Kritik zwischen Notwendigkeit und Hysterie

Wie genau der US-Kongress nun vorgehen will, lässt sich laut The Verge noch nicht ableiten. In diesem Bereich ist die EU weiter, die Verhandlungen über den KI Act gehen in die Endphase.

Handlungsbedarf sehen viele. Prominente KI-Forscher forderten etwa in einem offenen Brief ein Moratorium für die Entwicklung besonders starker Modelle. Zuletzt sorgte auch Geoffrey Hinton für Aufsehen, der als „Godfather of AI“ bekannte Forscher legte seinen Posten bei Google nieder, um nun offen über KI-Risiken sprechen zu können. Künstliche Intelligenz hält er für eine „dringendere“ Bedrohung als den Klimawandel, sagte er der Nachrichtenagentur Reuters. Den Klimawandel wolle er nicht leugnen, doch für die enorme Herausforderung gebe es Lösungen – bei der KI-Entwicklung sei das nicht klar.

With climate change, it's very easy to recommend what you should do: you just stop burning carbon. If you do that, eventually things will be okay. For this it's not at all clear what you should do.

Geoffrey Hinton

Solche Aussagen werden in der Branche allerdings auch als übertrieben und alarmistisch bezeichnet. Die deutsche Informatikprofessorin Katharina Zweig hält die Angst vor einer starken KI etwa nicht für eine Mehrheitsmeinung im Forschungsfeld.

Nach Altmans Anhörung vor dem US-Senat und diversen Auftritten auf Konferenzen konkretisiert OpenAI die Regulierungsvorschläge nun in einem Blog-Beitrag. Von den Fortschritten bei der Entwicklung in den nächsten zehn Jahren ist das Unternehmen überzeugt. KI-Systeme würden sich in dieser Zeit so sehr verbessern, dass sie „die Fähigkeiten von Experten in den meisten Bereichen übertreffen“.

Nötig seien daher Maßnahmen, um potenzielle Risiken von Künstlichen Intelligenzen – und insbesondere Superintelligenzen (AGI) – einzudämmen. Dazu macht OpenAI drei konkrete Vorschläge:

- Koordination: Führende KI-Entwickler sollen ein Stück weit kooperieren, um bei KI-Systemen die Sicherheit zu gewährleisten und Gesellschaften den Umgang mit der neuen Technologie zu erleichtern. Entsprechende Projekte, die etwa hohe Standards für Unternehmen definieren, könnten von den führenden Staaten ausgehen.

- Aufsicht: Eine internationale Behörde, die sich beispielsweise an der Atomenergie-Organisation IAEA orientiert, könnte weltweit die Einhaltung der Standards überprüfen.

- Forschung: Es müssen noch die technischen Fähigkeiten entwickelt werden, die erforderlich sind, um Superintelligenzen zu kontrollieren.

Verschärfte Regeln sollen laut OpenAI aber erst ab einem bestimmten Leistungsniveau gelten. Entwickeln Firmen oder Open-Source-Projekte KI-Modelle, die festgelegte Schwellenwerte nicht überschreiten, sollen diese mehr Freiheiten haben.