Wun Wun schrieb:

Da stimmt doch was nicht. Wenn die 7900XTX bei 100% Renderauflösung 6% mehr FPS als die 9070XT bei 67% schafft, ist die bei gleicher Renderauflösung doch deutlich schneller?!

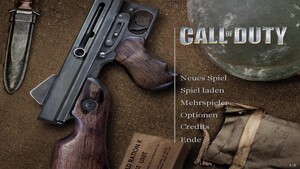

Das ist eine Eigenheit von Call of Duty (schon immer).

Seit dem es Upsampling gibt, bringt das Quality-Preset quasi keine Leistung, egal von DLSS, FSR oder was auch immer. In Black Ops 7 bringt DLSS/FSR Quality zwischen 0 und 5 Prozent mehr Performance, das war es.

Entsprechend steht im Artikel:

Die Call-of-Duty-Spiele haben jedoch traditionell eine Besonderheit, die es sonst so in keinem anderen Spiel gibt: Die Upsampling-Techniken kosten in dem Titel offenbar sehr viel Performance, sodass natives TAA nur geringfügig bis gar nicht langsamer läuft als DLSS 4 und FSR 4 im Quality-Modus. Letztere bieten dabei eine bessere Bildqualität, der Unterschied ist aber nicht riesig.

Sunweb schrieb:

&

Also was nun, reichen einer Nvidia Karte die 8GB oder nicht.

Beide Karten zeigen mit 8GB ein unterschiedliches Ergebnis, werden dann aber im Fazit über einen Kamm geschert?

Bei VRAM-Mangel sollte man nie auf AVG-FPS achten und auch 1 % Perzentil-FPS sind da meistens nicht fein genug. Radeon s mit 8 GB zeigen VRAM-Mangel in den Benchmarks (die man hier in den Messreihen nicht sieht, es hakt einfach), GeForce laufen dagegen noch normal durch (das Spiel spuckt aber schon eine Warnung aus). Erfahrungsgemäß ist es gut möglich, dass die GeForce mit längerer Spielzeit dann auch Probleme bekommt.

Cyron2k schrieb:

kurze ernstgemeinte Frage:

im Test steht was von 1100€ für die Vault-Edition: ist das gedacht mit Micro-Kosten, oder einfach ein Tippfehler?

Die Version kostet 110 Euro und 1.100 Euro sehe ich auch im Artikel nicht. Oder wurde das schon korrigiert?

Eddyloveland schrieb:

🔹Half-Life 2 (2004) – Valve Source Engine

Warum es als Paradebeispiel für Optimierung gilt:

- Läuft butterweich selbst auf schwacher Hardware (damals wie heute) – selbst integrierte GPUs oder schwache Laptops schaffen es in Full HD mit hohen FPS.

Eh, hast du Half-Life 2 damals zum Launch gespielt?

Das lief vieles, aber nicht butterweich.

Im Vergleich zu Black Ops 7 mit Raytracing lief HL2 damals keinen Deut besser, im gegenteil sogar.

Die schnellste Grafikkarte kommt heute in der höchsten, praxisrelevanten Auflösung Ultra HD auf 56 FPS.

Damals lief Half-Life 2 in den ältesten Benchmarks die ich auf CB zum Spiel finden kann auf einer Radeon X850XT-PE in 1600x1200 und damit der damals höchsten relevanten Auflösung mit 49 FPS - also nochmal langsamer als heute BO7 mit der RTX 5090. Und die X850XT-PE gab es zum Release von Half-Life 2 noch nichtmals, die Generation ist erst ein paar Monate nach dem Spiel gelesen.

Half-Life 2 war so gesehen schlechter optimiert als heute Black Ops 7.

https://www.computerbase.de/artikel/grafikkarten/ati-radeon-x1800-x1600-und-x1300-test.495/seite-20

Bitte nicht immer so übertreiben bei Vergleichen mir alten Spielen und wie viel besser damals immer alles gewesen ist. Verklärte Erinnerung und so.