Mordhorst3k

Lieutenant

- Registriert

- Juni 2008

- Beiträge

- 568

Aloha,

ich habe mir vor 3 Monaten einen 5900x geholt mit einem Aorus B550 Pro v2. Bis vor 3 Wochen habe ich HyperX Savage DDR4 2400 CL14 (HX424C14SBK2/32) benutzt. Nun habe ich G.Skill RipJaws V 3600 MHZ CL16 und merke praktisch keinen Performanceunterschied.

Als ich das Ram bekommen habe ich einfache, oder im Fall der Spiele die integrierten Benchmarks laufen lassen, um grob zu vergleichen. Für eine Bechmark Orgie bin ich zu Faul geworden.

Bei FC: P weiß ich allerdings nicht mehr, ob das mit dem HyperX oder G.Skill Ram war. Den Werten nach, dürfte das evtl. (!) G.Skill gewesen sein, hatte das auf einen Zettel geschrieben gehabt, obwohl ich mir eine Tabelle mit Lineal gezeichnet hatte - sehr schlau

Das Endergebnis ist durchaus als nüchtern zu bezeichnen. Daher muss ich mich unweigerlich fragen: Neues Ram einfach "schlecht", oder altes Ram "zu" gut? Zu viel erwartet? Sieht man sich die Werte an, würde ich die unterschiedlichen Werte als Messtoleranz werten. Andere Werte (vor allem die Spikes bei Assassins Creed) sind definitiv merkwürdig, weil sie das Ergebnis verfälschen.

Anmerkung: Spiele waren auf HDD; nicht SSD. Als OS habe ich Win10 laufen, Grafikkarte ist eine Asus GTX 1070 Dual OC.

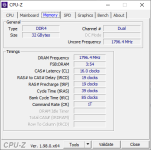

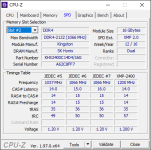

Hier noch 2 Screenshots von CPU-Z vom G.Skill, vom anderen habe ich leider nur einen vom SPD Tab.

ich habe mir vor 3 Monaten einen 5900x geholt mit einem Aorus B550 Pro v2. Bis vor 3 Wochen habe ich HyperX Savage DDR4 2400 CL14 (HX424C14SBK2/32) benutzt. Nun habe ich G.Skill RipJaws V 3600 MHZ CL16 und merke praktisch keinen Performanceunterschied.

Als ich das Ram bekommen habe ich einfache, oder im Fall der Spiele die integrierten Benchmarks laufen lassen, um grob zu vergleichen. Für eine Bechmark Orgie bin ich zu Faul geworden.

Hyper X Savage 2400 CL14 | G.Skill Ripjaws V 3600 Cl16 | |

|---|---|---|

| CPU-Z | ||

| Singlecore | ||

| Run 1 | 656,6 | 654,6 |

| Run 2 | 656,7 | 652,4 |

| Run 3 | 656,6 | 651,2 |

| Mittelwert | 656,6 | 652,7 |

| CPU-Z | ||

| Multicore | ||

| Run 1 | 9.590,8 | 9.504,9 |

| Run 2 | 9.577,9 | 9.509,5 |

| Run 3 | 9.572,9 | 9.420,9 |

| Mittelwert | 9.580,5 | 9.478,4 |

| AIDA 64 Extreme - v6.50.5800 | Takt war nicht fixiert (!) | |

| Speicher lesen (MB/s) | ||

| Run 1 | 37.074,0 | 54.117,0 |

| Run 2 | 37.061,0 | 54.766,0 |

| Run 3 | 37.083,0 | 54.709,0 |

| Mittelwert | 37.072,7 | 54.530,7 |

| Speicher schreiben (MB/s) | ||

| Run 1 | 36.371,0 | 54.206,0 |

| Run 2 | 36.267,0 | 54.059,0 |

| Run 3 | 36.263,0 | 54.110,0 |

| Mittelwert | 36.300,3 | 54.125,0 |

| Speicher kopieren (MB/s) | ||

| Run 1 | 35.596,0 | 51.439,0 |

| Run 2 | 35.596,0 | 51.525,0 |

| Run 3 | 35.615,0 | 51.545,0 |

| Mittelwert | 35.602,3 | 51.503,0 |

| CPU Queen | ||

| Run 1 | 138.170,0 | 137.175,0 |

| Run 2 | 137.485,0 | 136.897,0 |

| Run 3 | 137.819,0 | 137.079,0 |

| Mittelwert | 137.824,7 | 137.050,3 |

| CPU AES | ||

| Run 1 | 214.208,0 | 212.001,0 |

| Run 2 | 214.262,0 | 211.633,0 |

| Run 3 | 213.986,0 | 211.280,0 |

| Mittelwert | 214.152,0 | 211.638,0 |

| CPU SHA3 | ||

| Run 1 | 5.244,0 | 5.228,0 |

| Run 2 | 5.238,0 | 5.217,0 |

| Run 3 | 5.231,0 | 5.215,0 |

| Mittelwert | 5.237,7 | 5.220,0 |

| FPU Mandel | ||

| Run 1 | 84.080,0 | 83.728,0 |

| Run 2 | 83.956,0 | 83.632,0 |

| Run 3 | 83.897,0 | 83.721,0 |

| Mittelwert | 83.977,7 | 83.693,7 |

| Assassins Creed Valhalla | Hyper X Savage 2400 CL14 | G.Skill Ripjaws V 3600 Cl16 | ||||||

|---|---|---|---|---|---|---|---|---|

| FPS | AVG | MIN | MAX | AVG | MIN | MAX | ||

| Run 1 | 64 | 21 | 145 | 64 | 12 | 164 | ||

| Run 2 | 63 | 38 | 132 | 63 | 3 | 160 | ||

| Run 3 | 63 | 36 | 135 | 63 | 37 | 135 | ||

| Run 4 | 63 | 38 | 144 | 64 | 27 | 158 | ||

| Mittelwert | 63,3 | 33,3 | 139 | 63,5 | 19,8 | 154,3 | ||

| CPU | AVG | MIN | MAX | AVG | MIN | MAX | ||

| Run 1 | 16 | 7 | 48 | 16 | 6 | 49 | ||

| Run 2 | 16 | 8 | 26 | 16 | 6 | 338 | <- WTF?? | |

| Run 3 | 16 | 7 | 28 | 16 | 7 | 27 | ||

| Run 4 | 16 | 7 | 26 | 16 | 6 | 37 | ||

| Mittelwert | 16 | 7,3 | 32 | 16 | 6,3 | 112,8 | ||

| GPU | AVG | MIN | MAX | AVG | MIN | MAX | ||

| Run 1 | 15 | 13 | 19 | 15 | 13 | 19 | ||

| Run 2 | 16 | 8 | 26 | 16 | 13 | 19 | ||

| Run 3 | 15 | 13 | 19 | 16 | 13 | 19 | ||

| Run 4 | 15 | 13 | 19 | 15 | 13 | 20 | ||

| Mittelwert | 15,3 | 11,8 | 20,8 | 15,5 | 13 | 19,3 |

| Assassins Creed Origins | Hyper X Savage 2400 CL14 | G.Skill Ripjaws V 3600 Cl16 | ||||||

|---|---|---|---|---|---|---|---|---|

| FPS | AVG | MIN | MAX | AVG | MIN | MAX | ||

| Run 1 | 75 | 3 | 168 | 76 | 9 | 149 | ||

| Run 2 | 75 | 7 | 130 | 76 | 15 | 193 | ||

| Run 3 | 74 | 6 | 134 | 76 | 54 | 92 | ||

| Run 4 | 75 | 54 | 102 | 76 | 55 | 94 | ||

| Mittelwert | 74,8 | 17,5 | 133,5 | 76 | 33,3 | 132 | ||

| CPU | AVG | MIN | MAX | AVG | MIN | MAX | ||

| Run 1 | 6 | 5 | 356 | 5 | 4 | 103 | ||

| Run 2 | 6 | 5 | 179 | 5 | 4 | 67 | ||

| Run 3 | 6 | 5 | 13 | 5 | 9 | 4 | ||

| Run 4 | 6 | 5 | 12 | 5 | 4 | 13 | ||

| Mittelwert | 6 | 5 | 140 | 5 | 5,3 | 46,8 | ||

| GPU | AVG | MIN | MAX | AVG | MIN | MAX | ||

| Run 1 | 13 | 11 | 332 | 13 | 11 | 85 | ||

| Run 2 | 13 | 11 | 164 | 13 | 11 | 41 | ||

| Run 3 | 17 | 13 | 11 | 13 | 15 | 11 | ||

| Run 4 | 13 | 16 | 11 | 13 | 11 | 18 | ||

| Mittelwert | 14,0 | 12,8 | 129,5 | 13,0 | 12,0 | 38,8 |

| FarCry New Dawn (Ultra-Preset) | Hyper X Savage 2400 CL14 | G.Skill Ripjaws V 3600 Cl16 | |||||

|---|---|---|---|---|---|---|---|

| FPS | AVG | MIN | MAX | AVG | MIN | MAX | |

| Run 1 | 65 | 82 | 107 | 82 | 14 | 107 | |

| Run 2 | 66 | 82 | 106 | 85 | 66 | 107 | |

| Run 3 | 65 | 82 | 106 | 85 | 66 | 106 | |

| Run 4 | 65 | 82 | 106 | 85 | 66 | 106 | |

| Mittelwert | 65,3 | 82,0 | 106,3 | 84,3 | 53,0 | 106,5 |

| Far Cry Primal | Ultra-Preset | HD-Texturen aktiv | |

|---|---|---|---|

| FPS | AVG | MIN | MAX |

| Run 1 | 72 | 88 | 106 |

| Run 2 | 71 | 87 | 101 |

| Run 3 | 72 | 88 | 106 |

| Run 4 | 72 | 88 | 105 |

| Mittelwert | 71,8 | 87,8 | 104,5 |

Bei FC: P weiß ich allerdings nicht mehr, ob das mit dem HyperX oder G.Skill Ram war. Den Werten nach, dürfte das evtl. (!) G.Skill gewesen sein, hatte das auf einen Zettel geschrieben gehabt, obwohl ich mir eine Tabelle mit Lineal gezeichnet hatte - sehr schlau

Das Endergebnis ist durchaus als nüchtern zu bezeichnen. Daher muss ich mich unweigerlich fragen: Neues Ram einfach "schlecht", oder altes Ram "zu" gut? Zu viel erwartet? Sieht man sich die Werte an, würde ich die unterschiedlichen Werte als Messtoleranz werten. Andere Werte (vor allem die Spikes bei Assassins Creed) sind definitiv merkwürdig, weil sie das Ergebnis verfälschen.

Anmerkung: Spiele waren auf HDD; nicht SSD. Als OS habe ich Win10 laufen, Grafikkarte ist eine Asus GTX 1070 Dual OC.

Hier noch 2 Screenshots von CPU-Z vom G.Skill, vom anderen habe ich leider nur einen vom SPD Tab.