Bin gerade am durchdrehen mit meinen 2 SATA SSD's die ich zusätzlich seit ca 4 Jahren als erweiterten speicher zu meinen NVME's im PC hängen habe. Auf einer war eine Virtuelle Maschine gespeichert, und irgendwann war die VM nicht mehr zu gebrauchen, bezüglich ladezeiten etc, worauf ich mal zu forschen begann, und als ich die VM auf eine andere Platte kopieren wollte, habe ich die geschwindigkeit bemerkt.

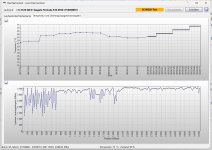

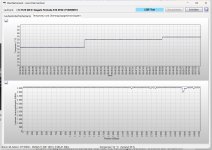

Hab dann etwas herum getestet und schnell gemerkt, dass ich die Daten BEIDER (!) SSD's nicht schneller als 1.5 bis 2.5mb/s lesen kann, neu geschriebene daten allerdings >250mb/s.

Den beitrag hier, habe ich erst jetzt gefunden.

Leider sind auf beiden Festplatten auch große Dateien, womit der SSD Read Speed Tester jeweils beginnt, und das einlesen dieser 25GB datei, würde jeglichen Zeitrahmen sprengen den ich habe, da starte ich lieber direkt mit einem Backup.

Blöderweise, hab ich von ein paar doch wichtigen Daten die drauf sind kein Backup, und ich werde mir jetzt ein Testsystem bauen, dass ~2 Wochen durchlaufen kann, um eine Spiegelung beider SSD's durchzuführen. Fakt ist allerdings dass beide SSD's unabhängig voneinander betroffen sind, und die Daten zum teil seit 2 bis 3 jahren "rumliegen".

Definitiv kein Einzelfall!

PS: Auch ein direktes backup über Linux bringt keinen Geschwindigkeitsvorteil, extern über USB angeschlossen selbstredend auch nicht. Die geschwindigkeit steht, und Diskrefresh würde auch ewig laufen, 1.000.000 sektoren nach ~2minuten, 2.000.000.000 Sektoren hat die platte.