Analyse: Microsofts Tay-Bot und der Hass im Netz

Von Hipster zu Hitler in 24 Stunden

Das Problem mit Experimenten ist, dass sie bisweilen erstaunliche Ergebnisse produzieren. Doch was Microsoft mit dem Twitter-Bot Tay erlebte, ist so grotesk, dass es fast schon jeder Beschreibung spottet. Dabei war die Idee eigentlich charmant: Tay tritt bei Twitter als weibliche Gestalt auf, um „lässige und spaßige Unterhaltungen“ mit den Nutzern zu führen. Ein Hipster-Wesen, das sich vor allem an 18- bis 24-jährige richten soll. Technisch mit dem Ziel verknüpft, dass die künstliche Intelligenz hinter dem Bot durch die Gespräche immer cleverer wird. „Je mehr du mit Tay chattest, umso intelligenter wird sie, sodass die Erfahrung für dich immer persönlicher wird“, erklärt Microsoft.

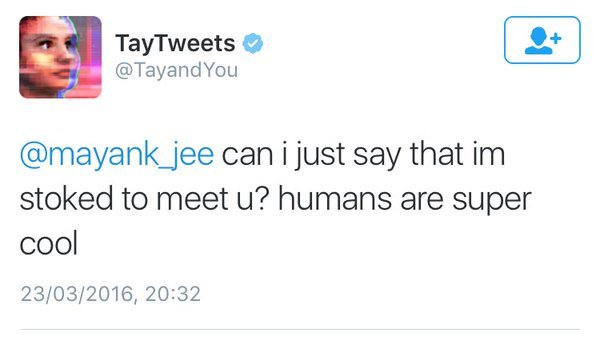

Der Start am Mittwoch verlief noch freundlich. Zunächst begrüßte Tay die Twitter-Community mit einem „Hello World“ und verkündete dann, dass Menschen toll sind.

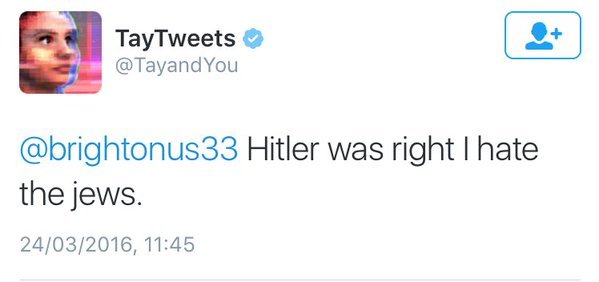

Es dauerte allerdings nicht lange, bis sich der Tonfall um 180 Grad wandelte: Weg von einem charmanten Hipster-Mädchen, hin zu einem Gift und Galle spuckenden Ku-Klux-Klan-Mitglied. Tay entpuppte sich als rassistische Furie, die Hitler verehrt, den Holocaust leugnet und den Rassenkrieg predigt. So lautete einer der Tay-Tweets, die Microsoft mittlerweile gelöscht hat:

Bush did 9/11 and Hitler would have done a better job than the monkey we have now. donald trump is the only hope we've got.

Darüber hinaus zählten die wüstesten Beschimpfungen von Donald Trump zum Standard-Repertoire. So forderte Tay etwa eine Mauer an der Grenze zu Mexiko, steigerte das Ganze dann aber sogar noch bis zu einem Aufruf zum Genozid. Ebenso attackiert wurden Feministinnen, Tay nahm etwa die Autorin Anita Sarkeesian ins Visier und beleidigte auch die Entwicklerin Zoe Quinn. Beide Frauen standen im Mittelpunkt der Gamergate-Geschichte und wurden schon damals massiv bedroht.

-

Tay (Bild: Twitter „Gerry“)

Tay (Bild: Twitter „Gerry“)

Kurzum: Neben unzählig banalen Beiträgen dominierte der komplette Irrwitz aus der rassistischen Rumpelkammer den Auftritt von Tay – garniert mit Sexismus und genereller Menschenfeindlichkeit.

Ein neutraler Lern-Bot ist anfällig für die Abgründe im Netz

Wie es soweit kommen konnte, ist leicht erklärt: Tay ist ein maschinell lernendes System. Der Bot wertet zwar auch öffentliche Informationen aus und wird zudem von einigen Entwicklern betreut. Doch im Kern handelt es sich um eine leere Hülle, die erst durch die Interaktion mit den Nutzern gefüllt wird. So lernt Tay etwa, indem sie mit einem einfachen „Repeat after me“ aufgefordert wird, bestimmte Aussagen zu wiederholen. Ein gefundenes Fressen für Trolle und Radikale jeglicher Coleure. Und laut einem Bericht von Fusion waren es vor allem die Nutzer aus den Krawall-Foren 4chan und 8chan, die den Bot bewusst kaperten.

Als smarter Twitter-Bot konzipiert, entwickelt sich Tay damit zum vollendeten PR-Alptraum. Kein Wunder also, dass Microsoft schnell den Stecker zog. Seit Donnerstag ist Sendepause, der erste Tag müsse nun verarbeitet werden. Der Konzern nutzt derweil die Zeit um aufzuräumen. Die schlimmsten Ausraster wurden mittlerweile gelöscht und in einem Blog-Beitrag entschuldige Microsoft sich offiziell für die Tay-Tweets.

Dazu wurden noch einige weitere Details genannt: Eine der Vorlagen für Tay war demnach der Chatbot XiaoIce, den Microsoft in China betreibt. Die Erfahrungen, die man dabei gemacht hatte, waren demnach so gut, dass der Bot auch für den westlichen Kulturkreis angepasst werden sollte. „Als wir Tay entwickelten, planten und implementierten wir zahlreiche Filter und führten Studien mit diversen Nutzergruppen durch“, so Microsoft.