W

WerbePar

Gast

tl;dr: ich habe bei einem Bild Datenkorruption festgestellt. Wie kann ich sowas in Zukunft einfach verhindern?

Hallo,

ich habe heute das Problem gehabt, dass ich eine mir wichtige private Fotodatei von vor 1,5 Jahren nicht mehr öffnen konnte. Die Datei hatte 0 Byte...ich speichere alle meine Daten auf einer internen 8 TB SSD, wo ich aktiv mit meinen privaten Daten arbeite. Um mich gegen Ransomware, Diebstahl, Hardwareausfall, etc. schütze, habe ich die Daten redundant auf mehreren externen Festplatten. Meine Kopien liegen im Bankschließfach, bei meinen Eltern und in einem Festplattenkoffer in einem Schrank bei mir. Die Backups aktualisiere ich über das Jahr immer wieder.

Ich habe also eine Menge Backups, aber das hilft mir auch nicht, wenn ggf. vor einem Jahr z.B. oben genannte Bilddatei einen Defekt aus irgendeinem Grund erlitten hat. Ich suche also nach einer Lösung, um Vorfälle wie oben zu verhindern für ein Datenvolumen aus derzeit 5 TB, bestehend aus Videos, Fotos, Dokumenten, etc.

Ich habe jetzt viel im Forum quer gelesen. Es gibt vmtl. zwei Wege, um das Thema anzugehen:

Die erste Option sorgt dafür, dass ich überhaupt ein Archiv habe und auch mal auf Daten zugreifen kann, die ich ggf. mal vor 6 Monaten gelöscht habe, in keinem Backup mehr habe und dann auf einmal doch brauche.

Die zweite Option könnte wohl dafür sorgen, dass Bitfehler und ähnliches gar nicht erst auftreten bzw. ich diese merke. Dies sollte man wohl auch machen, wenn man eine SSD als Datenplatte einsetzt, da SSD scheinbar fehleranfälliger sind für Datenkorruption (https://www.computerbase.de/forum/t...rlust-beim-lesen-alter-dateien.2089001/page-2).

Die jährliche Archivierung würde ich wohl so machen, dass ich mir jetzt mehrere externe Festplatten kaufe, die ihr Archiv für ein paar Jahre halten. Wie sollte der Archivierungsvorgang erfolgen? Im einfachsten Fall wähle ich alle Dateien auf der internen SSD aus und mache ein gesplitetes WinRAR-Archiv auf die externen Archiv-Festplatten mit den folgenden Optionen:

Im Forum und auch via ChatGPT wurde ich auf MultiPar hingewiesen. Damit kann ich wohl defekte Dateien reparieren. Als Empfehlung wurde genannt, dass MultiPar 10% an Speicherplatz gewährt werden soll bzw. als Größe für die Wiederherstellungsinfos.

Für das andere Anliegen bzgl. dem täglichen Einsatz von Prüfsummen auf der internen 8 TB SSD weiß ich noch nicht, wie ich das Thema angehen soll. Im Forum habe ich ein paar Beiträge gelesen, dass manche das im Einsatz haben. Bei einem Forenteilnehmer erledigt die Prüfsummengeschichte seine Fotodatenbank und andere haben wohl Windows-Tools im Einsatz.

Das sind soweit meine Gedanken. Ich bin gerne bereit Geld in die Hand zu nehmen, um die Archivfunktion umzusetzen und so die Datenintegrität bewahren zu können. Meine offenen Fragen/Anliegen wären wie folgt:

1. Wie archiviert ihr wichtige Daten? Kopiert ihr einfach die Daten auf externe Festplatten/Bandlaufwerke und verstaut die oder setzt ihr MultiPar oder ähnliches ein, um die Daten zu schützen?

2. Welche Maßnahmen sind alltagstauglich, um Datenkorruption in den alltäglichen Daten zu verhindern? Gibt es eine Möglichkeit, dass ein Programm täglich oder wöchentlich Prüfsummen aller Daten erstellt und bei einem Fehler selbstständig einen Alarm auslöst? Mit Google konnte ich dafür noch keine praktikable Lösung finden.

tl;dr: ich habe bei einem Bild Datenkorruption festgestellt. Wie kann ich sowas in Zukunft einfach verhindern?

Hallo,

ich habe heute das Problem gehabt, dass ich eine mir wichtige private Fotodatei von vor 1,5 Jahren nicht mehr öffnen konnte. Die Datei hatte 0 Byte...ich speichere alle meine Daten auf einer internen 8 TB SSD, wo ich aktiv mit meinen privaten Daten arbeite. Um mich gegen Ransomware, Diebstahl, Hardwareausfall, etc. schütze, habe ich die Daten redundant auf mehreren externen Festplatten. Meine Kopien liegen im Bankschließfach, bei meinen Eltern und in einem Festplattenkoffer in einem Schrank bei mir. Die Backups aktualisiere ich über das Jahr immer wieder.

Ich habe also eine Menge Backups, aber das hilft mir auch nicht, wenn ggf. vor einem Jahr z.B. oben genannte Bilddatei einen Defekt aus irgendeinem Grund erlitten hat. Ich suche also nach einer Lösung, um Vorfälle wie oben zu verhindern für ein Datenvolumen aus derzeit 5 TB, bestehend aus Videos, Fotos, Dokumenten, etc.

Ich habe jetzt viel im Forum quer gelesen. Es gibt vmtl. zwei Wege, um das Thema anzugehen:

- Jährliche Archivierung der Daten mit Prüfsummen und Wiederherstellungsinformationen (um beim Feststellen eines Fehlerfalles Daten aus einem robusten Archiv wiederherstellen zu können)

- Verwendung von Prüfsummen auf meiner internen 8 TB SSD

Die erste Option sorgt dafür, dass ich überhaupt ein Archiv habe und auch mal auf Daten zugreifen kann, die ich ggf. mal vor 6 Monaten gelöscht habe, in keinem Backup mehr habe und dann auf einmal doch brauche.

Die zweite Option könnte wohl dafür sorgen, dass Bitfehler und ähnliches gar nicht erst auftreten bzw. ich diese merke. Dies sollte man wohl auch machen, wenn man eine SSD als Datenplatte einsetzt, da SSD scheinbar fehleranfälliger sind für Datenkorruption (https://www.computerbase.de/forum/t...rlust-beim-lesen-alter-dateien.2089001/page-2).

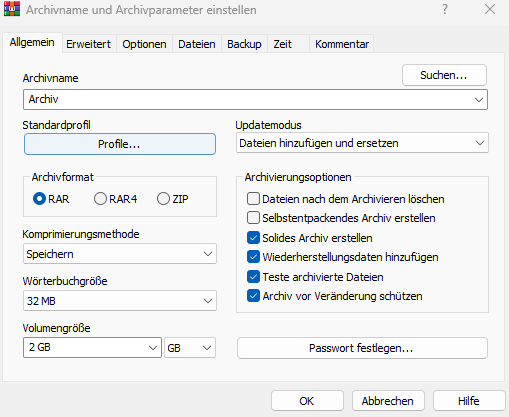

Die jährliche Archivierung würde ich wohl so machen, dass ich mir jetzt mehrere externe Festplatten kaufe, die ihr Archiv für ein paar Jahre halten. Wie sollte der Archivierungsvorgang erfolgen? Im einfachsten Fall wähle ich alle Dateien auf der internen SSD aus und mache ein gesplitetes WinRAR-Archiv auf die externen Archiv-Festplatten mit den folgenden Optionen:

Im Forum und auch via ChatGPT wurde ich auf MultiPar hingewiesen. Damit kann ich wohl defekte Dateien reparieren. Als Empfehlung wurde genannt, dass MultiPar 10% an Speicherplatz gewährt werden soll bzw. als Größe für die Wiederherstellungsinfos.

Für das andere Anliegen bzgl. dem täglichen Einsatz von Prüfsummen auf der internen 8 TB SSD weiß ich noch nicht, wie ich das Thema angehen soll. Im Forum habe ich ein paar Beiträge gelesen, dass manche das im Einsatz haben. Bei einem Forenteilnehmer erledigt die Prüfsummengeschichte seine Fotodatenbank und andere haben wohl Windows-Tools im Einsatz.

Das sind soweit meine Gedanken. Ich bin gerne bereit Geld in die Hand zu nehmen, um die Archivfunktion umzusetzen und so die Datenintegrität bewahren zu können. Meine offenen Fragen/Anliegen wären wie folgt:

1. Wie archiviert ihr wichtige Daten? Kopiert ihr einfach die Daten auf externe Festplatten/Bandlaufwerke und verstaut die oder setzt ihr MultiPar oder ähnliches ein, um die Daten zu schützen?

2. Welche Maßnahmen sind alltagstauglich, um Datenkorruption in den alltäglichen Daten zu verhindern? Gibt es eine Möglichkeit, dass ein Programm täglich oder wöchentlich Prüfsummen aller Daten erstellt und bei einem Fehler selbstständig einen Alarm auslöst? Mit Google konnte ich dafür noch keine praktikable Lösung finden.

tl;dr: ich habe bei einem Bild Datenkorruption festgestellt. Wie kann ich sowas in Zukunft einfach verhindern?

Zuletzt bearbeitet von einem Moderator: