Towatai schrieb:

Ich habe mich ja auch schonmal gefragt, wie ne aufgebohrte AMD K6 CPU aussehen würde, da diese ne extrem kurze (integer) Pipeline (6 Stufen) besitzt.

Die Pipeline war der Grund für den Erfolg der K6-2/III-Reihe (in den damals möglichen Maßen). Allerdings hatte das Design auch Probleme. U.A. wegen der kurzen Pipeline waren mehr als 600MHz nicht drin. Intel hatte ja mit dem P4 das komplette Gegenteil: Lange Pipeline, welche erst mit extrem hohen Taktfrequenzen (man visierte damals wohl 5GHz+ an, bis AMD spätestens mit dem K8 zeigte, wie blöd die Idee ist) sinnvoll einsetzbar war.

Das reine K6-Design "plus aktuelle Befehle" wäre heute nicht mehr konkurrenzfähig.

Generell: Klar kann man sagen, dass Intel quasi seit dem Pentium Pro am gleichen Design rumwerkelt. Viel übrig geblieben ist davon aber nicht. Genauso gut könnte man sagen "boah, die nutzen immernoch Silizium". Klar war der P4 eine Fehlkonstruktion (wie jetzt gleich wieder die Fans jammern werden... ^^ ). Aber Intel konnte sich sowas leisten. Es war ja auch nicht die einzige Fehlentscheidung im Konzern. Erinnert sich noch jemand an die Itanium-Reihe, weswegen Intel - zusammen mit Microsoft - so vehement die AMD64-Prozessorerweiterung torpedierte, bis man einsehen muss, dass auch auf dem Desktop 64 Bit nötig sein werden? Oder Rock Creek (später im Xeon Phi umgesetzt)?

All das hätte sich AMD nie erlauben dürfen. Schon der Faildozer (Bulldozer) war eine Katastrophe. Und der war zwar nicht unbenutzbar, aber eben auch kein großer Wurf.

So gesehen hat Intel durchaus lange gut reagiert. Ab einem gewissen Punkt hatten sie halt den Vorteil, dass sich die Konkurrenz selber zerlegt hat. Und da wurden sie - wohl zum Wohle der Shareholder - lange Zeit träge. (Das rächt sich jetzt, ist aber ne andere Story.)

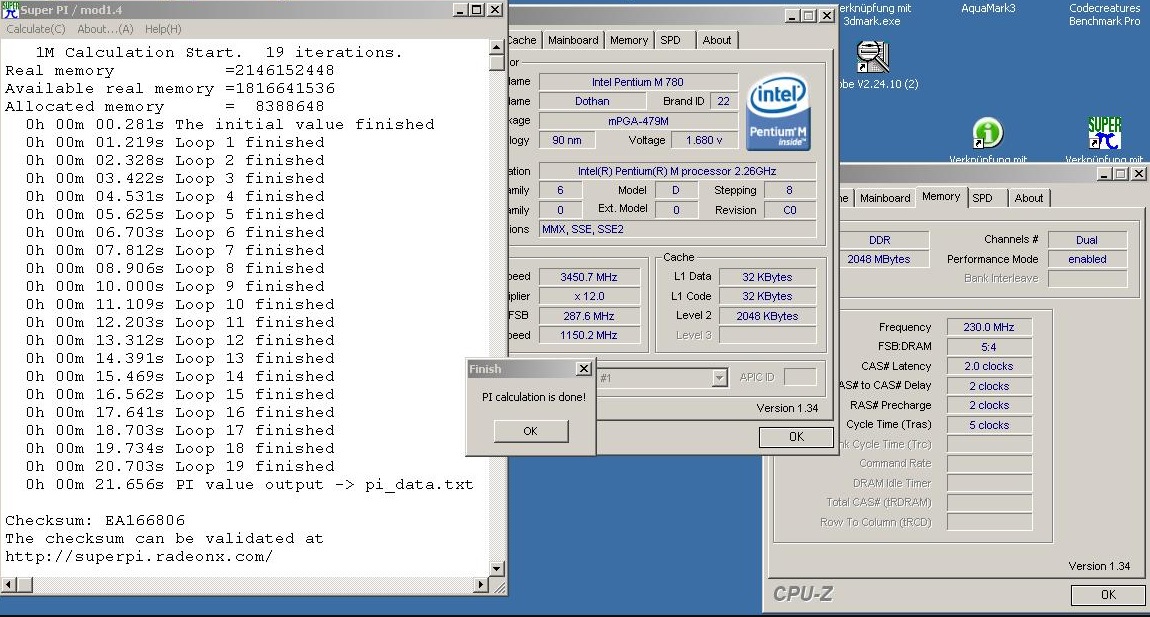

Der Siegeszug des Pentium M war das, was Intel brauchte, um die Realität zu erkennen. Leute bauten Konfigurationen im Desktop zusammen, obwohl das teurer war als was "von der Stange" zu kaufen. Zumal die Konkurrenz schon lange Frequenzen mit nem ganzen Gigahertz weniger nutzten, und trotzdem voraus/ebenbürtig waren.

Die Geburtsstunde der Core M war gekommen. - Respekt an das israelische Team, welches die Entwicklung nicht aufgab.

Regards, Bigfoot29

Nachtrag:

Noch was zu AMDs Geschichte:

AMD hat hier - zwar oft mit Vorausblick, aber eben nicht immer mit Erfolg - oft mit weniger Planung und neuen Architekturen herauskommen müssen. Man musste sich auch wegen des begrenzten Budgets den Problemen der Zeit stellen und Neuerungen oft dann angehen, wenn die Zeit reif war. Das war beim K7 schon so, den man wegen der zu kurzen Pipeline und dem darum gestrickten Rest neu entwickeln musste und wurde mit dem K8 wieder so, als man sogar externes KnowHow zukaufte.

So war der K8 damals ein durchaus großer Wurf. Die darunterliegende Technik nahm Entwicklungen von Transmeta vorweg. Der Prozessor war so konstruiert, dass man mit relativ wenig Neuentwicklung jede andere Prozessor-Architektur hätte darüberstülpen können. (Das perfektionierte Transmeta dann damit, dass man sogar via Software die Architektur festlegte.)

Auch setzte AMD mit dem Sockel 940/939 die Grundzüge, die man bis heute beibehalten hat: Lange Sockelkompatibilitäten mit Einführung des AM2, der technisch auf dem 939/940 basierte, allerdings darüber DDR2-Speicher ansprach. (Es gab sogar Boards, die die alten Chipsätze weiter nutzten.)

Mit der Grundlage war man lange gerüstet. - Bis der Pentium M kam.

Also begann man bei AMD zu überlegen, wie es weitergehen könnte. Damals hieß die Strategie "Rechenzentrum first". Man hatte mit den K8-Opterons -sie liefen vom P/L her Kreise um die Xeons - den Markt für Rechenzentrumshardware mit befeuert. Überall wurden Serverinstanzen und RZs hochgezogen, um zentraler Daten verarbeiten zu können. Allerdings liefen die Core-basierten Xeons spätenstens im Multi-Prozessor-Setup den AMDs davon. Neben aktueller Singlecore-Leistung kam jedoch auch so langsam das Konzept der Micro-Services (anders als heute definiert). Einzelne Leute - und davon Millionen - wollten Webseiten abrufen, die einzeln wenig Leistung benötigten. Das konnte man entweder mit vielen Prozessen je Kern lösen oder - deutlich billiger und näher an Moore's Law - mit mehr Kernen.

Ergo wurden die Prozessoren für maximalen Durchsatz entwickelt. Das war dann Bulldozer. Die Modul"bauweise" nahm vorweg, was man heute mit ManyCore-Ansätzen ebenfalls nutzt. Nur eben deutlich zu früh. Und auch, wenn die neuen Kerne dadurch kleiner waren (und weniger IPC lieferten), konnte man nicht die Frequenzen beliebig erhöhen. Insbesondere im Desktop-Bereich war der starke Single-Core noch das Maß aller Dinge. AMD vergaß wohl, dass man in 2 Benchmarks so gut sein kann, wie man will. Wenn man nicht (mehr) den Ruf hat, wirklich rundum gute Prozessoren zu bauen, setzt sich das auch im Management nicht durch.

AMD hatte lange damit zu kämpfen, wieder auf die Füße zu kommen. Viele AMD-User haben ihre Systeme seit den letzten A64-x6 nicht mehr aufgerüstet oder sind zur Konkurren gewechselt.

Bis... tja... bis 2017.