ShadowGamer97

Cadet 2nd Year

- Registriert

- Apr. 2023

- Beiträge

- 19

Hey liebe Community,

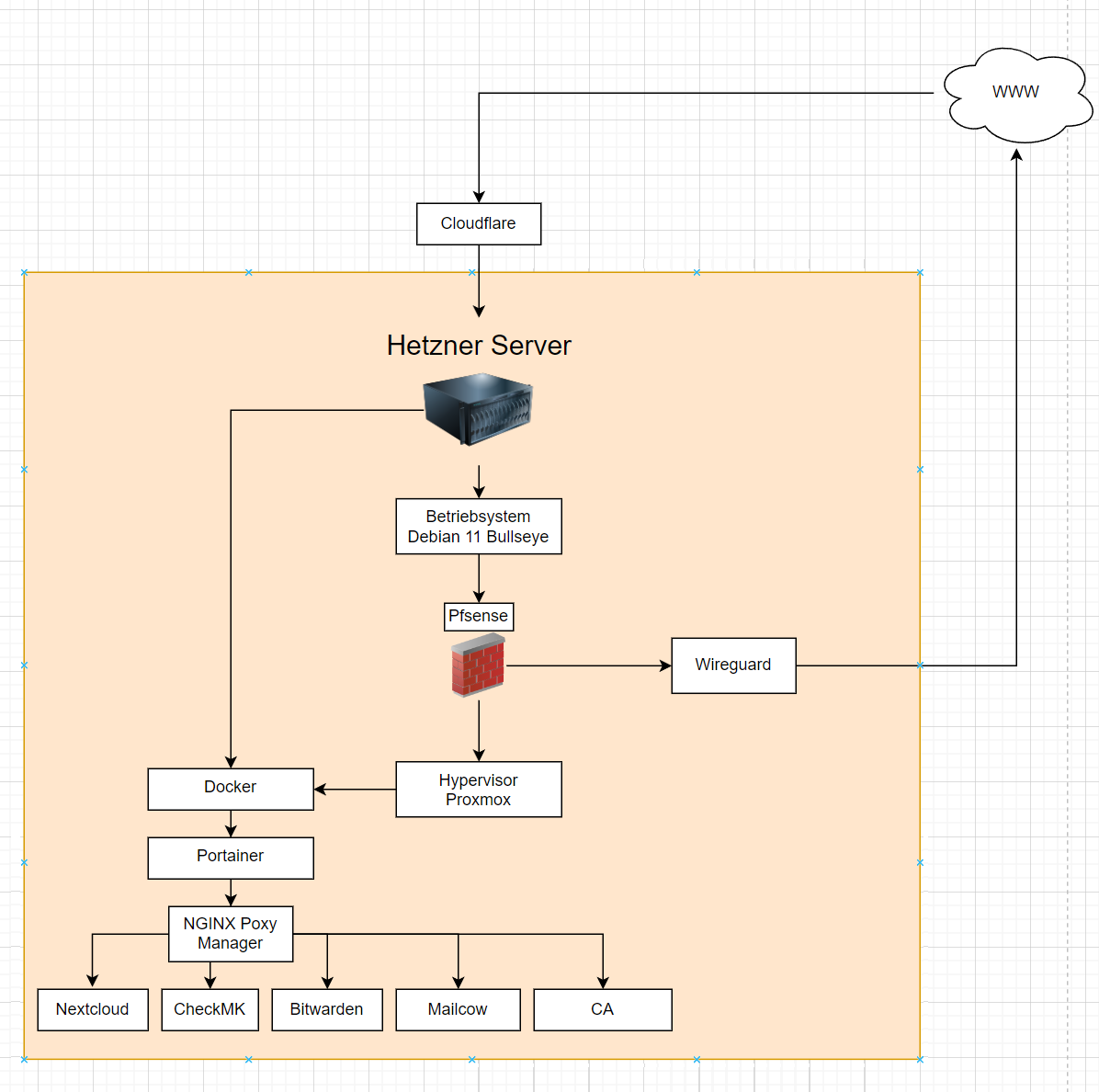

ich habe vor, auf meinem Dedizierten Server mehrere Sachen zu realisieren und habe dieses Mal grafisch dargestellt.

PfSense:

Mit einer PfSense habe ich noch nie gearbeitet. Ich frage mich, ob Sie auf Debian 11 Baremetal richtig liegt und dort installiert werden soll, oder soll ich woanders platzieren? Geht mir darum, einfach mal bestimmte Sachen einzurichten, Firewall regeln, evtl. Routing usw usw.

Zu Proxmox:

Mein Gedanke war es, auf meinem dedizierten Server von Hetzner wo Debian 11 drauf läuft, Proxmox zu installieren. Somit sollte ich die Möglichkeit haben eine VM zu erstellen, wo alles über Docker läuft und mir auch die Option übrig lässt, andere VM´s für einen Games-Server beispielsweise zu erstellen oder aber auch mit Windows Server etwas herumhantiere.

Docker:

Unter Docker möchte ich Portainer installieren. Es sollen mehrere Container laufen wie Nextcloud, Checkmk, Bitwarden, Mail, eine CA und evtl. in Zukunft noch mehr. Den Reverse Proxymanager von Nginx Proxy Manager möchte ich für Nextcloud benutzen sowie Checkmk. Bin mir nicht sicher, ob Bitwarden und Mailcow auch den Proxy Manager brauchen?

Cloudflare:

Zusätzlich war der Gedanke, Cloudflare noch mit ins Boot zu holen, weiß aber nicht so recht wie man das am besten implementiert bzw. ob ich mir das richtig vorstelle wie es funktioniert. Gedacht war, dass der Weg von WWW über Cloudflare läuft, und Cloudflare auf den Proxy Manager zeigt, wo es mich dann zu den jeweiligen Diensten wieder führt.

Wireguard:

Soll als Site so Site Tunnel von mir Zuhause nach Hetzner dienen.

Mailcow,Nextcloud,Checkmk,CA

Ich glaube zu den Systemen muss ich nicht viel sagen, alle sollen jeweils in einen Container.

Falls ich das ganze total falsch betrachte, klärt mich bitte, wie ich es am besten richtig implementieren sollte.

Bin für jeden Tipp sehr dankbar!

ich habe vor, auf meinem Dedizierten Server mehrere Sachen zu realisieren und habe dieses Mal grafisch dargestellt.

PfSense:

Mit einer PfSense habe ich noch nie gearbeitet. Ich frage mich, ob Sie auf Debian 11 Baremetal richtig liegt und dort installiert werden soll, oder soll ich woanders platzieren? Geht mir darum, einfach mal bestimmte Sachen einzurichten, Firewall regeln, evtl. Routing usw usw.

Zu Proxmox:

Mein Gedanke war es, auf meinem dedizierten Server von Hetzner wo Debian 11 drauf läuft, Proxmox zu installieren. Somit sollte ich die Möglichkeit haben eine VM zu erstellen, wo alles über Docker läuft und mir auch die Option übrig lässt, andere VM´s für einen Games-Server beispielsweise zu erstellen oder aber auch mit Windows Server etwas herumhantiere.

Docker:

Unter Docker möchte ich Portainer installieren. Es sollen mehrere Container laufen wie Nextcloud, Checkmk, Bitwarden, Mail, eine CA und evtl. in Zukunft noch mehr. Den Reverse Proxymanager von Nginx Proxy Manager möchte ich für Nextcloud benutzen sowie Checkmk. Bin mir nicht sicher, ob Bitwarden und Mailcow auch den Proxy Manager brauchen?

Cloudflare:

Zusätzlich war der Gedanke, Cloudflare noch mit ins Boot zu holen, weiß aber nicht so recht wie man das am besten implementiert bzw. ob ich mir das richtig vorstelle wie es funktioniert. Gedacht war, dass der Weg von WWW über Cloudflare läuft, und Cloudflare auf den Proxy Manager zeigt, wo es mich dann zu den jeweiligen Diensten wieder führt.

Wireguard:

Soll als Site so Site Tunnel von mir Zuhause nach Hetzner dienen.

Mailcow,Nextcloud,Checkmk,CA

Ich glaube zu den Systemen muss ich nicht viel sagen, alle sollen jeweils in einen Container.

Falls ich das ganze total falsch betrachte, klärt mich bitte, wie ich es am besten richtig implementieren sollte.

Bin für jeden Tipp sehr dankbar!