Floppy5885 schrieb:

Aber dafür bringt das Legion bereits ein WQHD+, 500 Nits 165 Hz HDR Display mit.

Und nicht ein Full HD 300Nits. WQHD gibt es hier bei Asus auch nur mit Aufpreis.

Bei der Displaygröße braucht kein Mensch eine höhere Auflösung, zumal du dich mal richtig informieren solltest, denn bei dem gequetschten Format musst noch mal unnötig Pixel berechnen. Ich sag nur 16:10. (wirst selber merken)

Weder die 500 Nits noch HDR sind hier herausragend, das sind mehr Gimmicks. In der Sonne zockt eh kein Gamer und da tun es auch andere Displays.

Sind sogar alles Gründe warum dem Ding noch eher als eh schon der Saft ausgeht. Schalt da mal auf 500 Nits... die Realität ist das man weit unter 300 agieren wird im Alltag. Das ist nur wegen HDR und da sind die Nits schon wieder alles andere als überragend.

Lenovo hat da übrigens sehr viele im Angebot, kp welches du mit FullHD meinst, da gibt es selbst in aktuell abverkauften noch ältere und auch aktuelle mit 144 Hz die sehr gut sind.

Hab die tatsächlich so gut wie alle schon mal in echt gesehen und bei 15 Zoll ist es total egal außer man nimmt ein Display welches wirklich keines der Features hat. Allerdings würde ich selbst bei einem 17 Zoller nicht unbedingt über FullHD gehen (am Notebook!) das sieht man bei Games sowieso dann nicht bei den kleinen Displays (ist ja auch logisch)

Am TV lohnen sich höhere Auflösungen auch er bei der entsprechenden Diagonale. Was willst am TV mit 4k auf 32 Zoll?

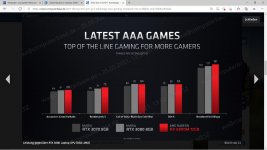

Mal abgesehen davon das es eine Leistungsgeschichte ist, die meisten Notebooks haben eine abgespeckte 3070 / 3060 drin mit weit weniger TDP, da geht dann die Luft aus.

Informieren ist hier angesagt.

Und deine Definition von "Mist" ist lustig, denn genau genommen ist das HDR im Pro auch "Mist" da es natürlich nicht mithalten kann mit gescheitem HDR eines High-End TVs. Ist eben ein Notebook ^^