Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

News Ryzen Threadripper 2000: AMD kontert Intels 28-Kerner mit 32 Kernen

- Ersteller Volker

- Erstellt am

- Zur News: Ryzen Threadripper 2000: AMD kontert Intels 28-Kerner mit 32 Kernen

Banned

Fleet Admiral

- Registriert

- Sep. 2014

- Beiträge

- 10.943

MK one schrieb:langweilig wird 2019 eigentlich nur für Intel Fanboys ... ,

Kann sein. Aber für AMD-Fanboys u.U. dafür sehr traurig.

Das Herausragendste war eigentlich der Release von Ryzen 1000. Das hätte so kaum einer erwartet und so kam der Achtkerner in den Mainstream. Und CL ist halt ein Sechskerner im Mainstream (auch was Neues), der dafür aber sehr gute Taktraten erreicht.

Aber rein technisch konnte man in etwa die gleiche Leistung schon drei bis vier Jahre zuvor bekommen (im HEDT). Und was jetzt gerade abgeht ist, dass Server-CPUs für den HEDT aufgebohrt werden.

Hill Ridge

Banned

- Registriert

- Mai 2018

- Beiträge

- 1.142

Weil man damit die Boards grillen würde?Agent500 schrieb:Habt ihr irgendeinen Hinweis warum der 28 Kerner von Intel nicht im S.2066 mit Quad Channel erscheinen soll?

Vielleicht kommt auch noch 14FF++++:OMK one schrieb:außer 14 +++ und wieviel das bringen mag ?

10nm hat Intel bis 2020 sicher nicht in der Massenfertigung, da können sie auch gleich auf 7nm warten.

MK one

Banned

- Registriert

- März 2017

- Beiträge

- 4.889

Banned schrieb:Und was jetzt gerade abgeht ist, dass Server-CPUs für den HEDT aufgebohrt werden.

Das war schon mit dem 12 - 18 Skylake -X Kerner so ...

HEDT war von Intel nur bis 10 Kerne vorgesehen , Mainstream nur bis 7700 K Quad Core

Ryzen 1 ist das was es ist , die 1 Generation , mit allen kleinen Schwächen und Macken die das so mit sich bringt

Ryzen 2 ist ein Refresh , Schwachstellen ( Latenzen ) gesenkt , kleinere Fehler behoben ( DDR 4 Speicher )

Ryzen 3 + 7 nm , da braucht AMD keine zusätzlichen Kerne mehr , weil der Takt auf gleicher Höhe ist , zudem gehe ich von PCIe4.0 beim Ryzen 3xxx aus , was auf PCIe 4.0 MoBo s von Vorteil sein wird

Ryzen 5 + 7 nm+ in 2020 , tja da wird wohl nen neues Board fällig , DDR5 steht vor der Tür

Umsonst hat ja keiner gesagt.MK one schrieb:umsonst ist der Sockel nicht so groß

Ist eben vermutlich nur der Bauform des Intel Xeon Platinum 8180 und damit der Verfügbarkeit von 28 Kernen geschuldet. Der Sockel selbst ist nur so groß wegen dem Speicherinterface.

Sockelgröße und Kernanzahl hat ja nicht direkt was miteinander zu tun. Siehe bspw. alle Sockel der letzten 10 Jahre.

Im S.1151 gibt es dank Coffee-Lake jetzt auch 50% mehr Kerne ohne das auch nur ein Pin dazugekommen wäre.

Zuletzt bearbeitet:

yummycandy

Commodore

- Registriert

- März 2005

- Beiträge

- 4.373

PCIe-Lanes und Stromversorgung haben auch Einfluß auf die größe. Also indirekt hat die Kernzahl schon damit zu tun.

Krautmaster

Fleet Admiral

- Registriert

- Feb. 2007

- Beiträge

- 24.408

ja aber bei TR4 und dem großen Intel Sockel ist es in erster Linie PCIe Lanes + SI die die Größe vorgeben, das ist schon richtig.

@MK one

wie beide (ein 28C und ein 32C) nachher gegen Performance kannst du doch jetzt gar nicht sagen. Wenn AMD dem TR4 hier bis zu 250W TDP spendiert haben sie natürlich einen Vorteil was All Core Turbo Taktraten angeht.

Es hängt eben ganz stark davon ab was man damit tut

https://www.anandtech.com/show/11839/intel-core-i9-7980xe-and-core-i9-7960x-review/10

https://www.anandtech.com/show/11839/intel-core-i9-7980xe-and-core-i9-7960x-review/14

Wenn das Board den Verbrauch des 7980 XE (korrekt) limitiert geben sich der 16C TR und der 18C 7980 XE bei der Effizienz herzlich wenig. Aktuell hat da Intel von Vorteil von 2 Kernen mehr, nachher 4 Kerne weniger.

Dadurch dass AMD nun aber eine neue Fertigung einsetzt gehe ich von aus dass man bei der Peak Effizienz über alle Kerne vorn liegen wird. Mehr Kerne sind da fast immer effizienter.

Glaube aber nicht dass der Unterschied "gravierend" sein wird, und in normalen Workloads wie Games oder eben Alltäglichem wie App Launches, Kompile usw wird der Intel ggf seine Stärke haben da er eben bei weniger Threads einen deutlich höheren Maximal Takt fahren können wird. Und unter Vollast hängts wie gesagt ganz schwer von ab wie mit welcher App man seine knapp oder leicht über 30 Kerne auszulasten gedenkt.

Dass es bei P/L bei AMD besser aussehen wird, davon kann man auch ausgehen.

Edit. Was man nicht machen darf is den 28C Intel unter Prime AXV auszulasten ^^, da wird man denke ich recht niedrige Clocks sehen und massiven Verbrauch je nach Board.

Hier wären realistische Szenarien gut, eben sowas wie Blender, Handbrake, Lightroom Export, irgend sowas.

Edit2:

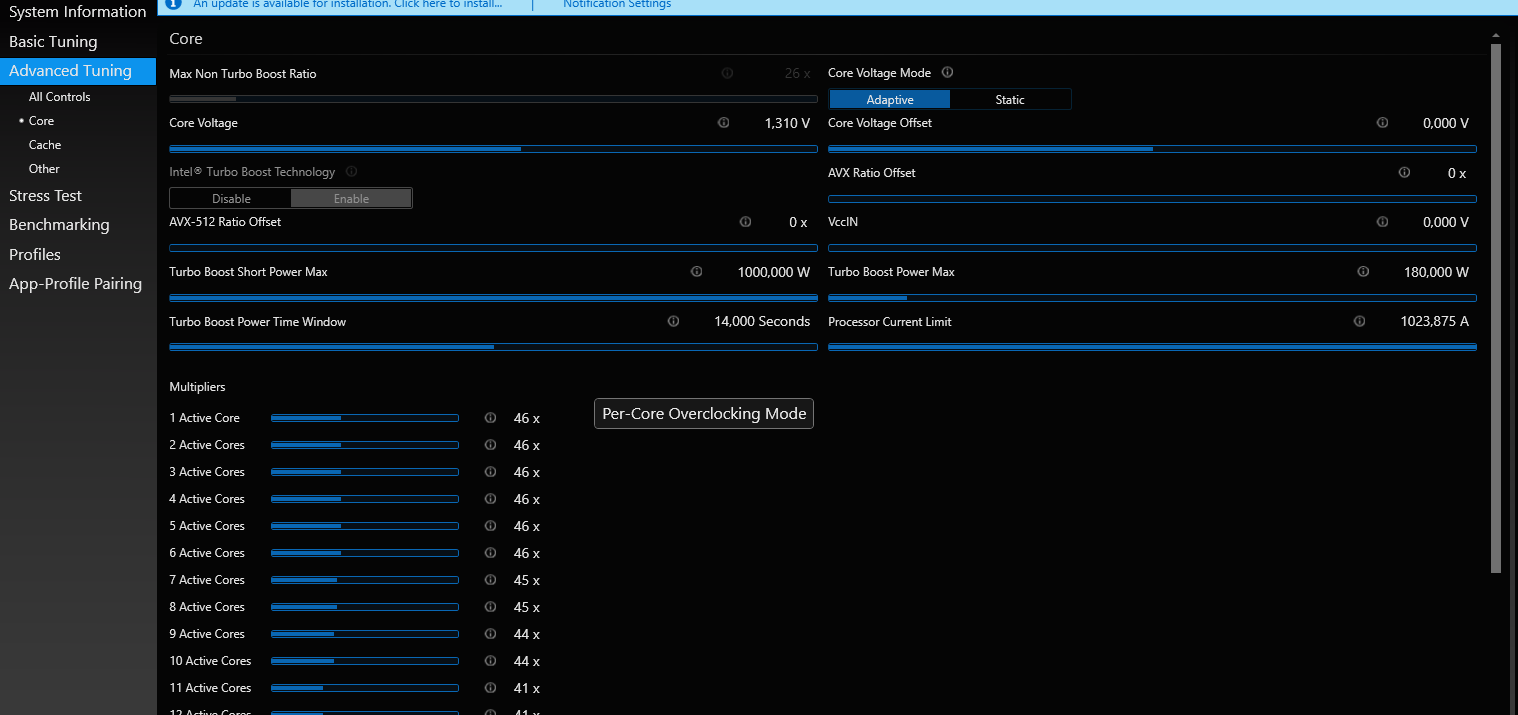

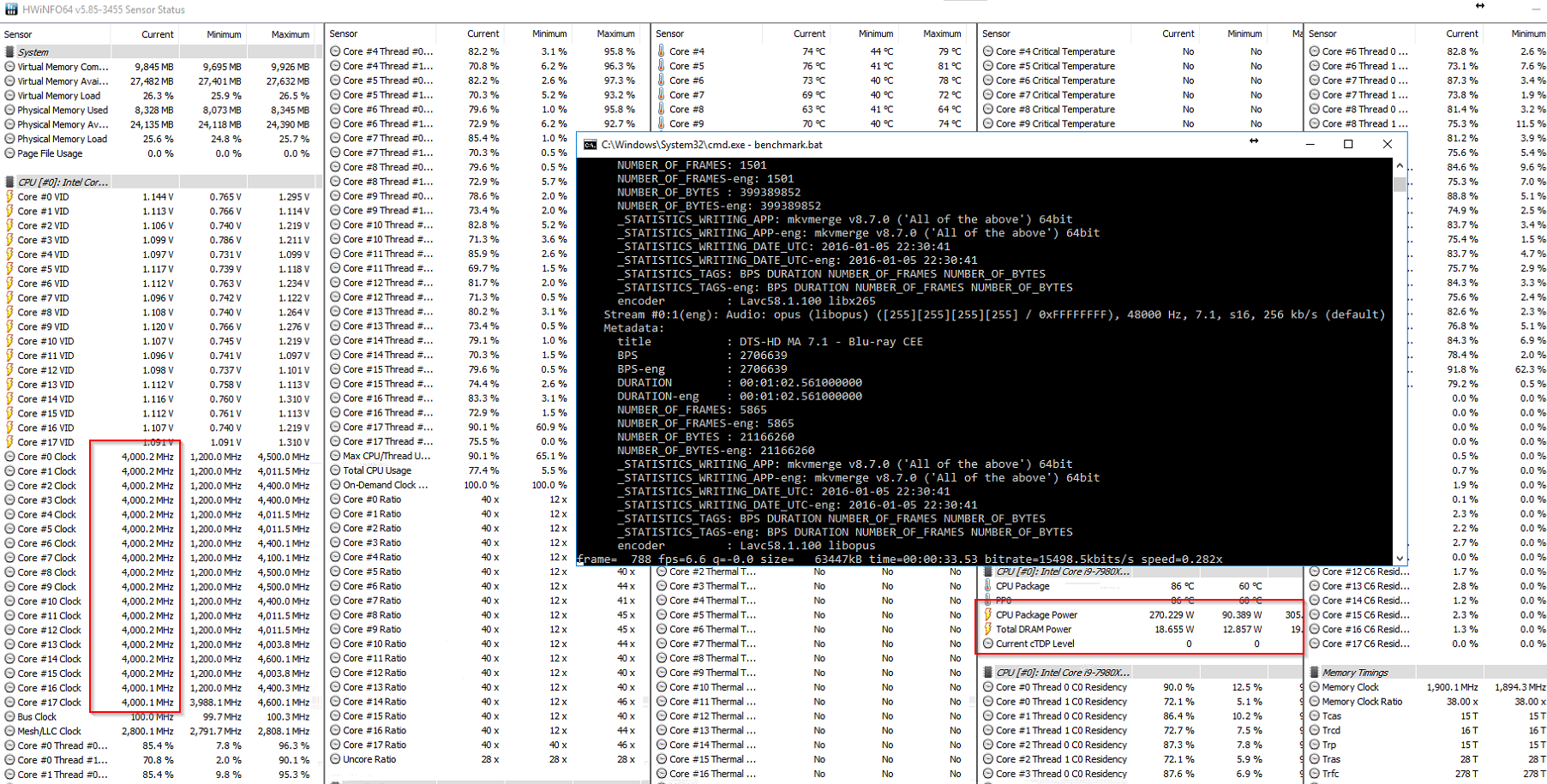

Hab bei meinem 7980 XE aktuell 180W als Long Limit eingestellt was er auch hält und mal Benches gemacht (in meinem FFMPEG HEVC Bench).

16x TR 1950 @ 3,8 Ghz @ ~180W - 6:25

18x 7980 XE @ 4,0 Ghz (unlimited, real denke ich um 300W) - 4:13

18x 7980 XE @ 3,0-3,3 Ghz (180W) - 5:19

Im Prinzip is es eig auch ganz cool dass man das so alles konfigurieren kann. Ich könnte eig auch 4,8 Ghz All Core Turbo mal einstellen mit dynamischen Voltages und dann rein über das Long Power Limit steuern wie viel W ich abführen will, das genau steuert auch die Temperatur der CPU. Je nachdem wie heftig dann ausgelastet wird, zb nur leicht in Game = 4,8 Ghz, oder ultra heftig wie Prime AVX (dann vllt nur noch 2,8ghz) wird eben so viel Takt gegeben wie innerhalb meines definierten Limits möglich.

Ich weiß dass aktuell etwa 350W CPU only bei meiner Kühlung mit leiser Lautstärke und recht warmem Wasser um 40°C mein Limit sind. Also stelle ich das ggf einfach mal ein und lass die CPU sich selbst limitieren.

Wenn ich n Benchmark mit 4,8 ghz durchjage wie diesen dann muss ich das Limit rausnehmen.

Edit: Hab mich damit nicht wirklich viel auseinander gesetzt aber es ist schon interessant wie alles rein über SW gesteuert wird. Das fiel ja schon beim 8700T Modell auf. Gerade mal im XTU on the fly von 180W (gesetzt im BIOS) auf 300 W gesetzt und schon liegen im selben Test FFMPEG HEVC ink AVX wieder 4 Ghz an. Bei 110W für 18C sind es nur 2,2 Ghz.

@MK one

wie beide (ein 28C und ein 32C) nachher gegen Performance kannst du doch jetzt gar nicht sagen. Wenn AMD dem TR4 hier bis zu 250W TDP spendiert haben sie natürlich einen Vorteil was All Core Turbo Taktraten angeht.

Es hängt eben ganz stark davon ab was man damit tut

https://www.anandtech.com/show/11839/intel-core-i9-7980xe-and-core-i9-7960x-review/10

https://www.anandtech.com/show/11839/intel-core-i9-7980xe-and-core-i9-7960x-review/14

Wenn das Board den Verbrauch des 7980 XE (korrekt) limitiert geben sich der 16C TR und der 18C 7980 XE bei der Effizienz herzlich wenig. Aktuell hat da Intel von Vorteil von 2 Kernen mehr, nachher 4 Kerne weniger.

Dadurch dass AMD nun aber eine neue Fertigung einsetzt gehe ich von aus dass man bei der Peak Effizienz über alle Kerne vorn liegen wird. Mehr Kerne sind da fast immer effizienter.

Glaube aber nicht dass der Unterschied "gravierend" sein wird, und in normalen Workloads wie Games oder eben Alltäglichem wie App Launches, Kompile usw wird der Intel ggf seine Stärke haben da er eben bei weniger Threads einen deutlich höheren Maximal Takt fahren können wird. Und unter Vollast hängts wie gesagt ganz schwer von ab wie mit welcher App man seine knapp oder leicht über 30 Kerne auszulasten gedenkt.

Dass es bei P/L bei AMD besser aussehen wird, davon kann man auch ausgehen.

Edit. Was man nicht machen darf is den 28C Intel unter Prime AXV auszulasten ^^, da wird man denke ich recht niedrige Clocks sehen und massiven Verbrauch je nach Board.

Hier wären realistische Szenarien gut, eben sowas wie Blender, Handbrake, Lightroom Export, irgend sowas.

Edit2:

Hab bei meinem 7980 XE aktuell 180W als Long Limit eingestellt was er auch hält und mal Benches gemacht (in meinem FFMPEG HEVC Bench).

16x TR 1950 @ 3,8 Ghz @ ~180W - 6:25

18x 7980 XE @ 4,0 Ghz (unlimited, real denke ich um 300W) - 4:13

18x 7980 XE @ 3,0-3,3 Ghz (180W) - 5:19

Im Prinzip is es eig auch ganz cool dass man das so alles konfigurieren kann. Ich könnte eig auch 4,8 Ghz All Core Turbo mal einstellen mit dynamischen Voltages und dann rein über das Long Power Limit steuern wie viel W ich abführen will, das genau steuert auch die Temperatur der CPU. Je nachdem wie heftig dann ausgelastet wird, zb nur leicht in Game = 4,8 Ghz, oder ultra heftig wie Prime AVX (dann vllt nur noch 2,8ghz) wird eben so viel Takt gegeben wie innerhalb meines definierten Limits möglich.

Ich weiß dass aktuell etwa 350W CPU only bei meiner Kühlung mit leiser Lautstärke und recht warmem Wasser um 40°C mein Limit sind. Also stelle ich das ggf einfach mal ein und lass die CPU sich selbst limitieren.

Wenn ich n Benchmark mit 4,8 ghz durchjage wie diesen dann muss ich das Limit rausnehmen.

Edit: Hab mich damit nicht wirklich viel auseinander gesetzt aber es ist schon interessant wie alles rein über SW gesteuert wird. Das fiel ja schon beim 8700T Modell auf. Gerade mal im XTU on the fly von 180W (gesetzt im BIOS) auf 300 W gesetzt und schon liegen im selben Test FFMPEG HEVC ink AVX wieder 4 Ghz an. Bei 110W für 18C sind es nur 2,2 Ghz.

Zuletzt bearbeitet:

Schnitz schrieb:Ich habe bei der Einführung der Ersten Dualcore Prozessoren auch oft gefragt wozu, aber je mehr Kerne ich hatte umso mehr Wege habe ich gefunden die auszunutzen. Und nen billiger Homeserver auf dem ich dann acht oder mehr VMs ohne Abstriche laufen lassen kann ist doch traumhaft.

Ich würde gerne mein NAS, Webserver, Heimautomatisierungsmaschine, Owncloud-System, Entwicklungsserver und die Desktops für die Familie usw. gerne alles auf einem Gerät unter Proxmox laufen lassen, will dafür aber kein Vermögen ausgeben. 32 Threads zu nen gesunden Preis wären da schon nice.

Andere schaffen auch ohne Probs nen 2700X mit Alltagsaufgaben an den Rand zu bringen.

Dann kauf ne HEDT CPU. Und man bekommt alles an den Rand wenn mans will.

MK one

Banned

- Registriert

- März 2017

- Beiträge

- 4.889

@Krautmaster

Da der neue TR aus 2000er basis auf den Ryzen 2700x beruht , denke ich , er wird auch eine intelligente Boost Steuerung haben , nicht ein nur 2 Core Boost .

Bei Vollast auf allen Kernen kann man nichts machen , da geht der Takt auf Basistakt zurück , aber wie du schon sagtest , nicht alle Apps nutzen 32 Kerne - schätze mal das der Boost bis 4,4 gehen wird wenn es tatsächlich die besten 5 oder 10 % der Dies sind , unter 7 nm wird es bis 5 Ghz gehen beim Boost

Mich hat das aufstocken auf 32 Kerne schon bei 12 nm überrascht , das es im 180 W TDP Korsett auch gegangen wäre zeigt ja der EPYC - allerdings dann mit den entsprechend niedrigen Taktraten .. - welche im Desktopbereich halt nicht wirklich gut aussehen .

Aber 7 nm und 180 oder gar 250 W TDP ? und man sich dann vor Augen hält das dies 360w / 500w bei 14 nm entsprechen .... ( da 60 % weniger Verbrauch bei selben Takt vs 14 nm ) , dann kann man sich vorstellen sie sie die Sau rauslassen können bei Boost und Basistakt ... , das was du mit OC erreichen kannst , geht dann mit Standardtakt bei 7 nm

Da der neue TR aus 2000er basis auf den Ryzen 2700x beruht , denke ich , er wird auch eine intelligente Boost Steuerung haben , nicht ein nur 2 Core Boost .

Bei Vollast auf allen Kernen kann man nichts machen , da geht der Takt auf Basistakt zurück , aber wie du schon sagtest , nicht alle Apps nutzen 32 Kerne - schätze mal das der Boost bis 4,4 gehen wird wenn es tatsächlich die besten 5 oder 10 % der Dies sind , unter 7 nm wird es bis 5 Ghz gehen beim Boost

Mich hat das aufstocken auf 32 Kerne schon bei 12 nm überrascht , das es im 180 W TDP Korsett auch gegangen wäre zeigt ja der EPYC - allerdings dann mit den entsprechend niedrigen Taktraten .. - welche im Desktopbereich halt nicht wirklich gut aussehen .

Aber 7 nm und 180 oder gar 250 W TDP ? und man sich dann vor Augen hält das dies 360w / 500w bei 14 nm entsprechen .... ( da 60 % weniger Verbrauch bei selben Takt vs 14 nm ) , dann kann man sich vorstellen sie sie die Sau rauslassen können bei Boost und Basistakt ... , das was du mit OC erreichen kannst , geht dann mit Standardtakt bei 7 nm

Dark_Knight

Banned

- Registriert

- Nov. 2008

- Beiträge

- 3.150

AlphaKaninchen

Captain Pro

- Registriert

- Mai 2018

- Beiträge

- 3.665

Weyoun schrieb:Das verstehe ich immer noch nicht. Die Software rippt nach einem festen Algorithmus die Video- und Audiodaten von der Scheibe auf die Platte (ggf. mit geringer Kompression, was aber kein Muss ist). Und der Prozessor ist hier nur Werkzeug für die Software. Also sollte auch das Ergebnis bitidentisch ausfallen.

Cool Master schrieb:@Weyoun

Ist es aber nicht. Die CPU hat eben verschiedene En- und Decoder und die laufen nun mal auf alten CPUs, wenn überhaupt vorhanden, anders als auf neuen CPUs.

Kann es sein das der ein Hardware de/encoding meint (was eh nicht die beste Qualität bringt) und der ander Software?

Cool Master

Fleet Admiral

- Registriert

- Dez. 2005

- Beiträge

- 39.753

@AlphaKaninchen

Nein. Die Software greift auf die in der HW verbauten Befehlssätze zu und führt dann eben den entsprechenden Algorithmus aus. Dadurch dass aber durch jedes rippen eben auch Artefakte bzw. Rauschen rein kommt kann die Qualität nun mal eben von CPU zu CPU bzw. GPU zu GPU unterschiedlich sein.

Das sieht man z.B. sehr gut bei neueren CPUs die alle ein x264 De- und Encoder haben. Je neuer die CPU desto besser die Qualität weil sich eben die Algorithmen und die HW von Generation zu Generation verbessert haben.

Nein. Die Software greift auf die in der HW verbauten Befehlssätze zu und führt dann eben den entsprechenden Algorithmus aus. Dadurch dass aber durch jedes rippen eben auch Artefakte bzw. Rauschen rein kommt kann die Qualität nun mal eben von CPU zu CPU bzw. GPU zu GPU unterschiedlich sein.

Das sieht man z.B. sehr gut bei neueren CPUs die alle ein x264 De- und Encoder haben. Je neuer die CPU desto besser die Qualität weil sich eben die Algorithmen und die HW von Generation zu Generation verbessert haben.

AlphaKaninchen

Captain Pro

- Registriert

- Mai 2018

- Beiträge

- 3.665

Ich weiß das es De/encoder in der CPU gibt für h.264, h.265 etc aber seit wann greift ein software encoder darauf zurück diese benutzt man doch ehr wenn es vor allem schnell gehen muss, Live Streame oder Video abspielen also wenn mir die geschwindigkeit aber nicht wichtig ist nehme ich doch x.264 oder x.265 weil es eben nicht die Hardware De/eccoder nutzt (deshalb ist dort ja auch die CPU auf 100% und beim Live Streamen nicht)

MK one

Banned

- Registriert

- März 2017

- Beiträge

- 4.889

AVX und AVX512 stellen quasi nachbrenner für s encoden da , es sind Befehlssatzerweiterungen die vermutlich ( aber nicht ausschliesslich ) fürs encoden eingeführt wurden , jedenfalls profitiert das encoding über CPU sehr davon und zwar ohne qualitative Einbußen . Encoden uber GraKA ( Hardware ) ist nochmals etwas anderes , die encoder dort sind nicht so felxibel , da auf das Leistungsvermögen der Shader angewiesen , die Qualität , wenn auch in den letzten Jahren verbessert , reicht meiner Meinung nach nicht ans encoden mit CPU heran , auch wenn der Unterschied geringer geworden ist .

Handbrake nutzt übrigens noch mehr Erweiterungen der CPU (

HandBrake 1.1.0 (2018040700) - 64bit

x264 [info]: using cpu capabilities: MMX2 SSE2Fast SSSE3 SSE4.2 AVX FMA3 BMI2 AVX2 ) - beim Ryzen 1700X

die neuesten Intel haben AVX 512 das nochmals schneller ist , da 512 Bit in einem Rutsch bearbeitet werden statt AVX = 128 , AVX2 = 256 , nachteil ist , bei intensiver AVX Nutzung steigt die Leistungsaufnahme drastisch , deswegen mußte Intel den Takt bei AVX Nutzung senken , ein Teil der Mehrleistung wird davon wieder aufgefressen .

Handbrake nutzt übrigens noch mehr Erweiterungen der CPU (

HandBrake 1.1.0 (2018040700) - 64bit

x264 [info]: using cpu capabilities: MMX2 SSE2Fast SSSE3 SSE4.2 AVX FMA3 BMI2 AVX2 ) - beim Ryzen 1700X

die neuesten Intel haben AVX 512 das nochmals schneller ist , da 512 Bit in einem Rutsch bearbeitet werden statt AVX = 128 , AVX2 = 256 , nachteil ist , bei intensiver AVX Nutzung steigt die Leistungsaufnahme drastisch , deswegen mußte Intel den Takt bei AVX Nutzung senken , ein Teil der Mehrleistung wird davon wieder aufgefressen .

Zuletzt bearbeitet:

Cool Master

Fleet Admiral

- Registriert

- Dez. 2005

- Beiträge

- 39.753

AlphaKaninchen schrieb:seit wann greift ein software encoder darauf zurück

Das kommt halt auf das Programm an und wie es die HW benutzt. Gerade bei Apple ist das glaube ich so bei Final Cut Pro.

AlphaKaninchen

Captain Pro

- Registriert

- Mai 2018

- Beiträge

- 3.665

ok das kann sein ihr Postig oben lass sich so als würde x.254 darauf zurück greifen

Wäre Ja auch schade wenn nicht schlieslich sind all diese erweiterungen dazu da die CPU besser Auszulasten.

MK one schrieb:Handbrake nutzt übrigens noch mehr Erweiterungen der CPU (

HandBrake 1.1.0 (2018040700) - 64bit

x264 [info]: using cpu capabilities: MMX2 SSE2Fast SSSE3 SSE4.2 AVX FMA3 BMI2 AVX2 ) - beim Ryzen 1700X

die neuesten Intel haben AVX 512 das nochmals schneller ist , da 512 Bit in einem Rutsch bearbeitet werden statt AVX = 128 , AVX2 = 256 , nachteil ist , bei intensiver AVX Nutzung steigt die Leistungsaufnahme drastisch , deswegen mußte Intel den Takt bei AVX Nutzung senken , ein Teil der Mehrleistung wird davon wieder aufgefressen .

Wäre Ja auch schade wenn nicht schlieslich sind all diese erweiterungen dazu da die CPU besser Auszulasten.

Krautmaster

Fleet Admiral

- Registriert

- Feb. 2007

- Beiträge

- 24.408

Cool Master schrieb:Nein. Die Software greift auf die in der HW verbauten Befehlssätze zu und führt dann eben den entsprechenden Algorithmus aus. Dadurch dass aber durch jedes rippen eben auch Artefakte bzw. Rauschen rein kommt kann die Qualität nun mal eben von CPU zu CPU bzw. GPU zu GPU unterschiedlich sein.

Das sieht man z.B. sehr gut bei neueren CPUs die alle ein x264 De- und Encoder haben. Je neuer die CPU desto besser die Qualität weil sich eben die Algorithmen und die HW von Generation zu Generation verbessert haben.

da hätte ich schon gern ne Quelle dazu. GPU Seitig sind die Implementierungen höchst unterschiedlich und verschieden was die Quali angeht. Aber dass ne CPU zb ohne AVX andere Quali als eine mit liefert wäre mir neu.

Die Befehlssätze sind ja nur zur Beschleunigung da. Im Prinzip kann man alles auch mit ner CPU Ohne Befehlsatz rechnen, nur eben langsamer.

Zuletzt bearbeitet:

Schnitz

Admiral

- Registriert

- Nov. 2005

- Beiträge

- 8.196

fitsch84 schrieb:Dann kauf ne HEDT CPU. Und man bekommt alles an den Rand wenn mans will.

Dafür bin ich aber zu geizig, ich hab schließlich noch andere Hobbies

Cool Master

Fleet Admiral

- Registriert

- Dez. 2005

- Beiträge

- 39.753

Krautmaster schrieb:Aber dass ne CPU zb ohne AVX andere Quali als eine mit liefert wäre mir neu.

Sichtbar natürlich nicht. Das wird man in der Regel nur im direkten Frame-Vergleich bzw. Pixel peeping feststellen.

Ähnliche Themen

- Antworten

- 144

- Aufrufe

- 12.762

- Antworten

- 656

- Aufrufe

- 162.551

- Antworten

- 193

- Aufrufe

- 67.282

- Antworten

- 92

- Aufrufe

- 10.227