Folding@Home-Client bald auch für Nvidia-GPUs

Nachdem vor wenigen Wochen bereits die Besitzer einer AMD Radeon HD 2xxx/3xxx einen kleinen Grund zum feiern hatten, können nun auch die Besitzer von Nvidia-Grafikkarten jubeln. Im Rahmen einer Präsentation zeigte Vijay Pande, der Mann hinter dem Folding@Home-Projekt, erste Details zu einem F@H-GPU-Client für Nvidia-Grafikkarten.

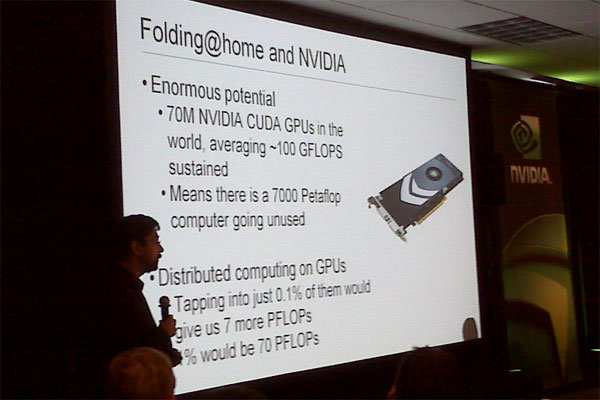

Bereits in der ersten fotografierten Folie wird deutlich, wie viel Rechenleistung dem Projekt durch den Mangel an Unterstützung für Nvidia-GPUs verloren geht. Würden lediglich 0,1% aller Nvidia-GPUs mit einer durchschnittlichen Rechenleistung von 100 GFLOP/s an dem Projekt arbeiten, würde sich die verfügbare Rechenleistung um satte sieben PetaFLOP/s (Mega, Giga, Tera, Peta,...) erhöhen. Aktuell besitzen alle aktiven Clients zusammen eine Leistung von etwa 1,85 PetaFLOP/s.

Die letzte Folie gibt zudem Aufschluss über die zu erwartende Performance der (neuen) Nvidia-Grafikkarten. Entsprechend der Grafik geht das Modell aus der Nvidia GT-200-Serie rund dreimal so schnell zu Werke wie eine aktuelle AMD Radeon HD 3870. Die Werte einer normalen CPU wirken hingegen geradezu lächerlich und auch die Playstation 3 kann trotz Cell-Broadband-Engine nur einen Blick auf die Rücklichter der GT200-Grafikbeschleuniger werfen. Wann und für welche Grafikkarten der neue GPU-Client für Nvidia-GPUs erscheinen soll, ist bislang noch nicht bekannt. Es ist jedoch durchaus möglich, dass Nvidia einen zusätzlichen Kaufanreiz für ihre neue GT200-Generation geben möchte, indem der GPU-Client lediglich Grafikchips aus der neuen Generation unterstützt und sämtliche aktuelle Lösungen auf Basis des G8x oder G9x außen vor bleiben.