Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

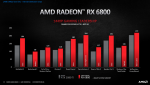

Bericht RX 6800 (XT) und 6900 XT: AMD greift Nvidia RTX 3070, 3080 und 3090 an

- Ersteller Wolfgang

- Erstellt am

- Zum Bericht: RX 6800 (XT) und 6900 XT: AMD greift Nvidia RTX 3070, 3080 und 3090 an

Metallsonic

Banned

- Registriert

- Nov. 2018

- Beiträge

- 368

Manchmal ist weniger mehr!Benni82 schrieb:Eig ist mir 659 Euro schon zuviel,aber 1000 Euro für ne Karte?!

Mein ganzer Rechner hat 1500 euro gekostet

Die 6800XT wird definitiv für 1440p gut reichen und dann werde ich den Rechner auch Minimum 2 jahre nicht aufrüsten.

Wenn du damit glücklich bist, freut mich das, dann mache das so!

Eine gebrauchte Karte zu kaufen ist momentan, auch eher sinnlos, zu den Mkndoreisen die die noch haben wollen zB, für eine gebrauchte RTX 2080TI.

TorgardGraufell

Lt. Commander

- Registriert

- Sep. 2017

- Beiträge

- 1.122

Das kann die garkeiner sagen.........nicht mal bei der 6900xt oder einer rtx3090....kommt immer aufs Game an Einstellungen.........und dauerhaft schon garnicht.Benni82 schrieb:Meint ihr die 6800 reicht für 1440p und dauerhaft 144fps in jedem Spiel mit max Details?

- Registriert

- Mai 2011

- Beiträge

- 22.755

Es werden zwar 750W empfohlen, aber wie immer werden damit Billig Netzteile und gleichzeitig Stromschluckende CPUs abgedeckt, da werden mal locker 150-200W für die CPU mit einberechnet, die du mit deinem 3700X nie erreichen wirst^^Benni82 schrieb:Das corsair RM650 Gold Plus sollte für die 6800XT reichen oder ?

Es wird wie bei der 3080 auch sein und man wird mit ca 400-450W für die Karte kalkulieren können um alle Spitzen abzudecken, für den 3700X kann man dann auch mal grob 100W inkl eventueller Spitzen rechnen, dann hast du alle Worst Case Szenarien abgedeckt und immer noch 100-150W frei für den Rest.

Zumal diese Netzteile auch kurze 750W Spitzen mitmachen.

ThirdLife

Captain

- Registriert

- Aug. 2019

- Beiträge

- 3.957

Stimmt, da ist natürlich was dran. Hat sicher gut geholfen.nekro1 schrieb:Das war bezogen um die Einahme der GPU Spalte. Ganz besonders durch Mining.

xXcanwriterXx

Banned

- Registriert

- Juli 2020

- Beiträge

- 903

Taxxor schrieb:... und gleichzeitig Stromschluckende CPUs abgedeckt, ...

Genau aus diesem Grund kam ein i9 10900K nicht in Frage!!

Ich werde mir eine "Sapphire Nitro+ RX 6800 XT" (so vermutlich die Bezeichnung) anschauen. Schon die Sapphire RX 5700 XT Nitro+ war eine tolle Karte und mit der Kühlung, so schreibt es Igor auch, kann Sapphire so schnell keiner was vor machen:

Zitat: "Eines muss man Sapphire ja wirklich zugestehen: in Sachen Kühlung macht ihnen kaum einer was vor, wenn es um AMD-Karten geht."

Quelle: https://www.igorslab.de/sapphire-rx...-mit-weniger-gewicht-sprintet-es-sich-besser/

GerryB

Rear Admiral

- Registriert

- Sep. 2016

- Beiträge

- 5.156

Ich denke, Das führt hier zu weit. Wurde eigentlich bei Ampere vs. Turing genügend erläutert, wie T gleichzeitig INT+FP32 ausführt.Teralios schrieb:Ähm, und der INT-Workflow liegt bei AMD dann magischerweise nicht an, sonder AMD muss nur FP berechnen.

Es ist viel einfacher nur das Endergebnis anzuschauen, wo ne 3070 nur auf ca. Ti-Niveau rauskommt.(Fps)

(6800 wohl mind. ähnlich; auch wenns nur indirekt vs Ti ist)

Aber nochmal für Dich alle theor. FP32 auf einen Blick, da sieht man die gewaltigen Unterschiede in der Arch.:

Anhänge

T

Teralios

Gast

@GerryB

Danke dafür, dass du mir eine Datei verlinkst, NICHT! Den Sachverhalt, denn du mir mit deinem »Bild« erläutern willst, kenne ich und ich habe dir für diesen Sachverhalt sogar mir noch die Mühe gemacht und dir die Erklärung geliefert! Dieses Bild ändert daher nichts daran, dass deine ursprüngliche Aussage - und man verzeihe mir nun die direkte Wortwahl, aber man wird es mir nun nach diesem Beitrag von dir auch zu gestehen - einfach nur unfundiert und damit falsch ist.

Da mir die Zeit nun auch zu Schade ist und ich weiß, dass eine erneute Erklärung nur Perlen vor die Säue ist, mache ich es mir einfach und geh schlafen.

Danke dafür, dass du mir eine Datei verlinkst, NICHT! Den Sachverhalt, denn du mir mit deinem »Bild« erläutern willst, kenne ich und ich habe dir für diesen Sachverhalt sogar mir noch die Mühe gemacht und dir die Erklärung geliefert! Dieses Bild ändert daher nichts daran, dass deine ursprüngliche Aussage - und man verzeihe mir nun die direkte Wortwahl, aber man wird es mir nun nach diesem Beitrag von dir auch zu gestehen - einfach nur unfundiert und damit falsch ist.

Da mir die Zeit nun auch zu Schade ist und ich weiß, dass eine erneute Erklärung nur Perlen vor die Säue ist, mache ich es mir einfach und geh schlafen.

SOTTR Benchmark Ergebnis mit einem R5 3500X @4.3GHz und mit einer RX 6800

https://twitter.com/TUM_APISAK

https://twitter.com/TUM_APISAK

DrFreaK666

Commodore

- Registriert

- Dez. 2011

- Beiträge

- 4.211

...

Aber dass die 3080Ti den GA102 "knapp als Vollausbau" bekommt, ist unwahrscheinlich, immerhin hat die 3090 ja schon nicht den Vollausbau, wenn sie dann noch 20GB hat, wie soll man sie dann bepreisen?

...

[/QUOTE]

Die 2060S war fast auf 2070 Niveau, hatte im Vergleich zur 2060 2GB mehr und der Preis ist nur unwesentlich gestiegen. Sie war jedenfalls noch günstiger wie die normale 2070.

Da AMD nun deutlich stärker ist, wird NV reagieren, und wenn man sich bei first adopter unbeliebt macht...

Vielleicht wollen sie keinen Blur-Filter á la DLSS 1 abliefern, oder die sind noch nicht so weit, weil NV in dem Bereich deutlich mehr Erfahrung hat

Da hast wohl aufs falsche Pferd gesetzt. Aber wer hätte schon gedacht dass AMD jemals aufholt? Ich jedenfalls nicht

Ein Freund von mir arbeitet im ML-Bereich und dank CUDA kommt für ihn nur eine RTX in Frage.

Er sagt dass je nach Anwendungsbereich 24GB hilfreich sein können.

Ich glaube ihm mehr als Tech-Youtuber, die sich nicht im jedem Bereich super auskennen können.

Hardware Unboxed hat meines Wissens noch keine Hardware im ML-Bereich gebencht

Dieses Jahr gibt es aber niemanden, der sich für Cyberpunk eine 3060 holt

Die Frage war ob 6800 oder 6800XT, und da ist die Antwort: ganz klar 6800XT für den geringen Aufpreis.

Wieso du hier mit der 6900XT kommst, verstehst wahrscheinlich nur du.

Aber dass die 3080Ti den GA102 "knapp als Vollausbau" bekommt, ist unwahrscheinlich, immerhin hat die 3090 ja schon nicht den Vollausbau, wenn sie dann noch 20GB hat, wie soll man sie dann bepreisen?

...

[/QUOTE]

Die 2060S war fast auf 2070 Niveau, hatte im Vergleich zur 2060 2GB mehr und der Preis ist nur unwesentlich gestiegen. Sie war jedenfalls noch günstiger wie die normale 2070.

Da AMD nun deutlich stärker ist, wird NV reagieren, und wenn man sich bei first adopter unbeliebt macht...

Ergänzung ()

aappleaday schrieb:...

Aber allein das eine DLSS Alternative erst etwas später kommt macht mich schon stutzig.

...

Vielleicht wollen sie keinen Blur-Filter á la DLSS 1 abliefern, oder die sind noch nicht so weit, weil NV in dem Bereich deutlich mehr Erfahrung hat

Ergänzung ()

elwu schrieb:Vielversprechend, was AMD da abliefert. Leider nutzt mir das nichts, da mein Monitor zwar 165 Hz kann und mir die WQHD-Auflösung völlig reicht - das Ding aber nun mal G-Sync hat. An einer AMD-Karte nutzt das leider nix.

Da hast wohl aufs falsche Pferd gesetzt. Aber wer hätte schon gedacht dass AMD jemals aufholt? Ich jedenfalls nicht

Ergänzung ()

Dittsche schrieb:arum hat sie dann keine professionellen treiber wie die titans? (die diese auch nur widerwillig nach amds vega frontier bekommen haben)...

Ein Freund von mir arbeitet im ML-Bereich und dank CUDA kommt für ihn nur eine RTX in Frage.

Er sagt dass je nach Anwendungsbereich 24GB hilfreich sein können.

Ich glaube ihm mehr als Tech-Youtuber, die sich nicht im jedem Bereich super auskennen können.

Hardware Unboxed hat meines Wissens noch keine Hardware im ML-Bereich gebencht

Ergänzung ()

foo_1337 schrieb:Und genau deshalb gibt es dank DLSS , dass auch Kunden, die zB ne ne 3060 für 399(?) kaufen, in den genuss von RT kommen.

Dieses Jahr gibt es aber niemanden, der sich für Cyberpunk eine 3060 holt

Ergänzung ()

Metallsonic schrieb:Es kommt immer dafauf an, wenn dir weniger FPS ausreichen dann nimm die RX 6800, wenn du aber, die maximale Leistung haben willst mit AMD, tja dann nimm die RX 6900!...

Die Frage war ob 6800 oder 6800XT, und da ist die Antwort: ganz klar 6800XT für den geringen Aufpreis.

Wieso du hier mit der 6900XT kommst, verstehst wahrscheinlich nur du.

Zuletzt bearbeitet:

Zertruemmerdog

Lt. Junior Grade

- Registriert

- Sep. 2018

- Beiträge

- 367

Amd ist nicht nvidia.Gagapa schrieb:Leute was denkt ihr über die Verfügbarkeit, ich denke 1 Tag Zeit hat man maximal bis alles leer ist , vll sogar länger :O

Gehe davon aus, dass im gegensatz zu nvidia wesentlich mehr auf lager ist und auch zu msrp.

zombie

Captain

- Registriert

- Aug. 2004

- Beiträge

- 3.867

Wie wird der Inifnity Cache denn gesteuert ? Direkt von GPU und Treiber oder muß auch die Software, also Spiele dafür optimiert sein ? Weil es ja oft so war in der Vergangenheit das AMDs Radeons auf dem Papier toll waren und solche Features aber dann auch nur von den Spielen wirklich optimal genutzt werden konnten wenn drauf eingestellt und da das oft nicht der Fall war und dann diese Papiertigerfeatures in kalten Rauch verpufften.

Zuletzt bearbeitet:

- Registriert

- Mai 2007

- Beiträge

- 2.974

Das ist ein einfacher Cache für die GPU nur halt größer. Quasi sowas wie Level 3 Cache.zombie schrieb:Wie wird der Inifnity Cache denn gesteuert ?

Genauzombie schrieb:Direkt von GPU

MFG Piet

Ähnliche Themen

- Antworten

- 185

- Aufrufe

- 34.470

- Antworten

- 973

- Aufrufe

- 319.934

- Antworten

- 457

- Aufrufe

- 69.738

- Antworten

- 584

- Aufrufe

- 106.394

- Antworten

- 2.288

- Aufrufe

- 351.046