Klaus_Vielleser

Cadet 2nd Year

- Registriert

- Juni 2023

- Beiträge

- 29

Folge dem Video um zu sehen, wie unsere Website als Web-App auf dem Startbildschirm installiert werden kann.

Anmerkung: Diese Funktion ist in einigen Browsern möglicherweise nicht verfügbar.

@Klaus_Vielleser noch generation info dazu geben. ich poste gerne auch mal n vögelchen, die tagepainomatic schrieb:@Klaus_Vielleser welches Tool hast du genutzt?

Ich spiele erst jetzt mit Stable Diffusion ein wenig. Ich fotografiere gerne und wollte mal schauen, was da geht. Erst mal so zu sehen, was man damit anstellen kann. Jetzt noch ein wenig in Inpaint einarbeiten. Und mal schauen, ob das was wird. Habe auch schon mal Photoshop Beta mit der neuen KI ausprobiert. Ja, es ist nett und manche Ergebnisse sind da auch ganz nett. Ob und inwieweit ich es bei meinen Fotos einsetzen werde, wird sich noch zeigen.leboef schrieb:Ich bin bei der KI-Geschichte jedenfalls wieder raus. Am Anfang war ich auch total begeistert und habe einige Bilder generiert. Aber es bedeutet mir mehr, wenn ich ein richtiges Foto auf der Strasse mache, wirklich das Fotografieren erlebe und nicht zuhause ein Textprompt bediene.

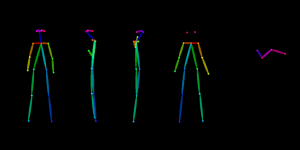

Das kenne ich gar nicht, ist es ein KI Bilderstellungsprogramm auf dem PC oder eine Onlinesache?Rickmer schrieb:Ich habe mir immer mal wieder Wallpaper gemacht auf Basis von diesem Openpose Template:

Das ist ein Template für Controlnet, was eine Erweiterung für Stable Diffusion (ich nutze die Automatic1111 Variante) ist.Klaus_Vielleser schrieb:Das kenne ich gar nicht, ist es ein KI Bilderstellungsprogramm auf dem PC oder eine Onlinesache?

Absolut beeindruckend, was du damit so anstellst.Rickmer schrieb:Das ist ein Template für Controlnet, was eine Erweiterung für Stable Diffusion (ich nutze die Automatic1111 Variante) ist.

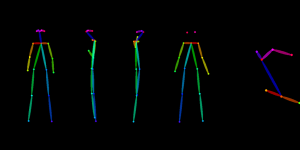

Controlnet gibt verschiedene Möglichkeiten, das entstehende Bild zu steuern - in diesem Fall habe ich Openpose genutzt, welches sich besonders dafür eignet, die generelle Körperhaltung vorzugeben, ohne die äußeren Konturen zu definieren.

Deshalb nutze ich für viele Sachen lieber eine Openpose Vorlage als z.B. andere Controlnets wie Depth (Tiefen-Mapping), welches signifikanten Einfluss auf das Aussehen der entstehenden Kleidung hätte.

Siehe Eingangsposting, da wird die Installation von A1111 erklärt (hab ich heute auch mal ein Update gemacht; Update der "weiterführenden Links" folgt noch).Klaus_Vielleser schrieb:Das kenne ich gar nicht, ist es ein KI Bilderstellungsprogramm auf dem PC oder eine Onlinesache?

Aber die Ergebnisse gefallen!

Das bedeutet für mich: Man installiert Stable Diffussion und dann noch A1111 als Vorlagenerweiterung sozusagen? Gut, ich werde mir die Mühe jetzt auf meinem Rechner nicht mehr machen, weil schlechte GPU Leistung bzw. es ist ein Notebook und dort verwendet SD nur die CPU. Damit braucht ein Bild ca. 5 Minuten für die Berechnung. Ich wollte mir einmal einen speziellen KI-Bilder Rechner bauen, aber hab die Idee wieder verworfen, weil ich doch lieber fotografieren würde.MechanimaL schrieb:Du benötigst noch weiter entwickelte Models als das Base 1.5 Model, welche Du bspw. auf CivitAI kostenlos runterladen kannst. In den Prompt-Infos hier im Thread stehen die verwendeten Parameter und Models drin. Die kannst du per Copy und Paste in A1111 einfügen (ins Positiv-Prompt fenster kopieren und den blauen Pfeil oben rechts klicken und die Einstellungen werden übernommen ,nur das gewünschte Model musst Du noch selbst laden, nachdem Du's in den Model Ordner des UI kopiert hast). Ein wenig mit den Grundlagen beschäftigen ist natürlich schon nötig, aber von den verwendeten Mitteln her, ist die Qualität für jeden erreichbar - und reproduzierbar.

Hier noch ein paar EisvögelMan erreicht eine gute fotografische Qualität mit SD, meiner Ansicht nach.

Das ist 1 Package: Mit der Installation von A1111 benutzt Du SD. Aber wie Du selbst bemerkt hast, lohnt es sich erst ab einer gewissen Grafikkarten-Leistung, das auf dem eigenen Rechner zu verwenden. Fotografieren ist ein wunderbares Hobby, das würde ich auch nicht hinten anstellen. Wenn in Zukunft das Geld übrig ist, kannst Du ja immer noch einen gebrauchten PC kaufen, der dafür ausreichend ist, wenn das Interesse vorhandne ist. Bis dahin kann man auch die Rechenleistung Online verwenden, das ist glaube ich auch nicht so teuer. (Bspw: 0,69$ für eine 4090/Stunde; 0,44$ für eine 3090). Muss dazu auch mal noch was in den Eingangspost schreiben, hab ich bisher nicht dran gedacht.Klaus_Vielleser schrieb:Das bedeutet für mich: Man installiert Stable Diffussion und dann noch A1111 als Vorlagenerweiterung sozusagen? Gut, ich werde mir die Mühe jetzt auf meinem Rechner nicht mehr machen, weil schlechte GPU Leistung bzw. es ist ein Notebook und dort verwendet SD nur die CPU.

Openpose full, soft edge und reference wäre mein tipp ^^Rickmer schrieb:Ratet mal, welche Controlnets ich letztendlich genutzt habe um aus diesem Bild:

Mond und Nacht liegt am Model. Säbelzähne beim Meerschweinchen wird kein Model freiwillig machen, das ist nicht teil des Dataset, mit dem es gefüttert wurde.MechanimaL schrieb:Warum Du nicht direkt das richtige bekommst, weiß ich nicht genau, ich denke es liegt am Model..