SaxnPaule

Admiral

- Registriert

- Okt. 2010

- Beiträge

- 8.892

Hallo Community,

ich habe heute mal ein wenig mit Windows Storage Pools rumgespielt, da ich das Konzept von verteilter Datenhaltung mit Parität ohne RAID ganz interessant finde.

Allerdings verstehe ich nicht ganz, wie sich der effektiv nutzbare Speicherplatz errechnet.

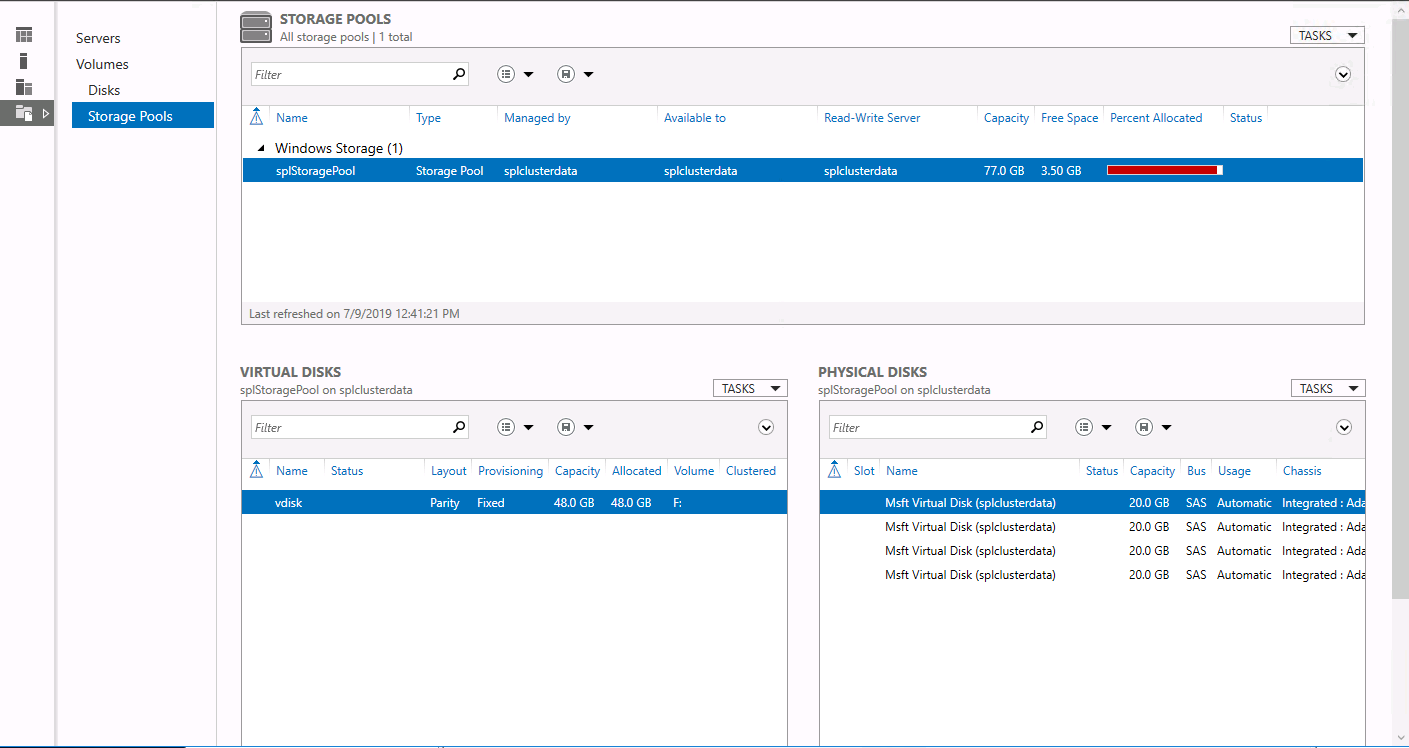

Ich habe mir dazu im Azure eine 2016 Datacenter Instanz hochgezogen, welcher ich 4 x 20GB HDDs spendiert habe.

Diese habe ich zu einem Storage Pool zusammengefasst. Kapazität beträgt 77GB. Soweit alles nachvollziehbar.

Jetzt habe ich auf dem Storage Pool ein Virtuelles Laufwerk mit Parität angelegt, welches mir bei maximaler Größe jedoch nur 48GB anbietet. Bei einfacher Parität müsste doch irgendwas um 58GB und bei zweifacher ca. 39GB bereitstehen.

Das mutwillige "Zerstören" einer Platte und das ersetzen durch eine neue habe ich getestet und es funktioniert wirklich gut. Fraglich ist nur, wie lange der ganze Prozess bei echten Größen im TB Bereich dauert.

Ich habe ja schonmal das Windows Software Raid5 getestet, was nach knapp zwei Tagen das Volume auch vernünftig bereitgestellt hat.

Allerdings war nach einem abgebrochenen Windows Update das Array schon wieder degraded und hätte wieder zwei Tage durchlaufen müssen.

Auf solche Schluckaufs habe ich keine Lust und daher frage ich mich, ob Storage Pools da eine geeignete, zuverlässigere Alternative zu dem Windows Software Raid sind, da ja erst beim Schreiben die Daten intelligent verteilt werden, wenn ich das richtig verstanden habe und nicht bereits vorab alle HDDs "vorformatiert" werden.

EDIT1: Ich habe das Thema bewusst unter Heimnetzwerke aufgehangen, da es prinzipiell zur NAS Konfiguration gedacht ist. Ob es tatsächlich zur Anwendung kommt hängt natürlich von eventuellen Erfahrungswerten ab.

EDIT2:

Bei einem Storage Pool aus 4 x 20GB (77GB) hat die vDisk 48GB (62%)

Bei einem Storage Pool aus 4 x 120GB (476GB) hat die vDisk 316GB (66%)

Bei einem Storage Pool aus 4 x 500GB (1,95TB) hat die vDisk 1,328TB (68%)

Bei einem Storage Pool aus 4 x 1023GB (3,99TB) hat die vDisk 2,66TB (67%)

Es wäre schon schön, wenn man irgendwie grob in Richtung 75% gelangen könnte.

ich habe heute mal ein wenig mit Windows Storage Pools rumgespielt, da ich das Konzept von verteilter Datenhaltung mit Parität ohne RAID ganz interessant finde.

Allerdings verstehe ich nicht ganz, wie sich der effektiv nutzbare Speicherplatz errechnet.

Ich habe mir dazu im Azure eine 2016 Datacenter Instanz hochgezogen, welcher ich 4 x 20GB HDDs spendiert habe.

Diese habe ich zu einem Storage Pool zusammengefasst. Kapazität beträgt 77GB. Soweit alles nachvollziehbar.

Jetzt habe ich auf dem Storage Pool ein Virtuelles Laufwerk mit Parität angelegt, welches mir bei maximaler Größe jedoch nur 48GB anbietet. Bei einfacher Parität müsste doch irgendwas um 58GB und bei zweifacher ca. 39GB bereitstehen.

Das mutwillige "Zerstören" einer Platte und das ersetzen durch eine neue habe ich getestet und es funktioniert wirklich gut. Fraglich ist nur, wie lange der ganze Prozess bei echten Größen im TB Bereich dauert.

Ich habe ja schonmal das Windows Software Raid5 getestet, was nach knapp zwei Tagen das Volume auch vernünftig bereitgestellt hat.

Allerdings war nach einem abgebrochenen Windows Update das Array schon wieder degraded und hätte wieder zwei Tage durchlaufen müssen.

Auf solche Schluckaufs habe ich keine Lust und daher frage ich mich, ob Storage Pools da eine geeignete, zuverlässigere Alternative zu dem Windows Software Raid sind, da ja erst beim Schreiben die Daten intelligent verteilt werden, wenn ich das richtig verstanden habe und nicht bereits vorab alle HDDs "vorformatiert" werden.

EDIT1: Ich habe das Thema bewusst unter Heimnetzwerke aufgehangen, da es prinzipiell zur NAS Konfiguration gedacht ist. Ob es tatsächlich zur Anwendung kommt hängt natürlich von eventuellen Erfahrungswerten ab.

EDIT2:

Bei einem Storage Pool aus 4 x 20GB (77GB) hat die vDisk 48GB (62%)

Bei einem Storage Pool aus 4 x 120GB (476GB) hat die vDisk 316GB (66%)

Bei einem Storage Pool aus 4 x 500GB (1,95TB) hat die vDisk 1,328TB (68%)

Bei einem Storage Pool aus 4 x 1023GB (3,99TB) hat die vDisk 2,66TB (67%)

Es wäre schon schön, wenn man irgendwie grob in Richtung 75% gelangen könnte.

Zuletzt bearbeitet: