@schkai

So einfach wie du dir das ausmalst sind Computer eben doch nicht.

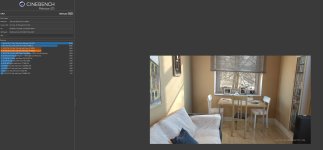

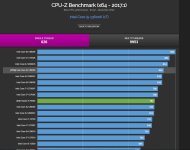

Rein von der Leistung her müsste ich ja im Cinebench am Test vorbei ziehen allein schon weil ich eben nicht den mittelmäßigen Speicher des CB Testsetups habe.

Meine Werte decken sich eher mit dem was Guru3D ermittelt hat.

Stellt sich die Frage ob die Ergebnisse falsch sind oder Asus im Hintergrund automatisch manipuliert um schicker auszusehen, deswegen sind Benchmarks in meinen Augen nicht nachvollziehbar aktuell.

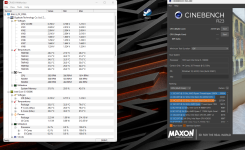

So wie die Software sich im Augenblick preisgibt würde ich das bestenfalls noch als Beta beschreiben. Beim MSI Afterburner fehlen mir auch nötige Anzeigen im Overlay. Normalerweise kann man den Takt der Kerne anzeigen lassen, fehlt aber aktuell.

Meine Vermutung dahinter ist eher dass die Software erst noch reifen muss und mit Z790 nicht gänzlich umgehen kann.

Wenn sogar Intel XTU nicht sauber funktioniert ist das Thema erstmal gegessen.

Der 13600k tut übrigens exakt das was ich bzgl Leistung erwartet habe, ich hab auf den 700 oder gar 900K verzichtet weil diese ganzen Ecores absolut nutzlos sind im Augenblick beim Zocken und an dem Tag wo die Software davon nutzen erzielt, sind diese Prozessoren wieder von Mittelklasse eingestampft und überholt worden.

Genau das ist nämlich die aktuelle Entwicklung seit Ryzen, man stelle sich vor, man hätte nen Threadripper damals gekauft zum zocken, ders jetzt fast schon obsolet bzgl Gamingleistung bzw. wars schon seit Release und kommt bis zum heutigen Tag nicht dazu seine gesamte Multithreadleistung auszutoben. Gleicht so ein bisschen der Bulldozer Vishera Architektur, war auch schwach pro Kern und damit trotz 8 Threads nie brauchbar beim zocken, aber sah toll aus in Benchmarks die man eben nicht spielen kann.

Macht aktuell keinen Sinn die Highend CPUs zu kaufen, die Zeiten wo ein 2500K mal Ewigkeiten hielt sind ja auch vorbei seitdem Ryzen da ist.

Der für mich perfekte Prozessor hätte 10 Pcores, (davon 2 nur als reinster Puffer) gehabt ohne Hyperthreading und 0 Ecores, gibts aber nicht. Blieb der 13600K übrig mit nem vernünftigen Preis und wäre relativ gut zu übertakten um dann beim Gaming mit dem 13900K gleichziehen zu dürfen für viel weniger Geld.

Die Realität in der Zukunft wird aber wohl wieder so sein, zu dem Zeitpunkt wo der i5 zu langsam wird ists der i7 und i9 ebenfalls und wird wieder von Mittelklasse abgezogen.

Ist doch beim 12900K auch so aktuell, was bringt der beim Zocken an Mehrleistung? Nix.

Mein 9900k, der 6800K... die waren schneller unbrauchbar als erwartet, hat sich ja in der Software nie was geändert, ein Kern limitiert die ganze Anwendung und den Rest des Prozessors wegen zu wenig Singlethreadleistung (Softwareoverhead) und schon darfste eh wieder in 2-4 Generationen neu kaufen.

Schaut man sich das aktuelle Warzone an, dann sieht mans dort auch 1-2 CPU Kerne laufen im Anschlag, der Rest des Prozessors ist purer Ballast und die Threads wo alles machen bestimmen die FPS aufgrund der Singlethreadleistung.

Im dortigen Benchmark aber ein ähnliches Bild, der Benchmark entspricht nicht dem realen Anwendungsfall, jegliche Rechenleistung die vom Netzwerkchip über die CPU laufen sind dort auch nicht enthalten, folglich besseres Ergebnis als die Realität im Multiplayer. Benchmark Top, Realität Flop.