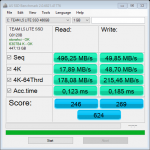

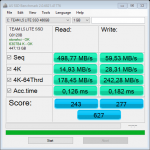

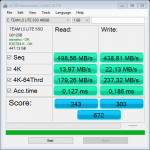

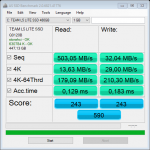

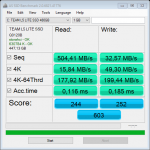

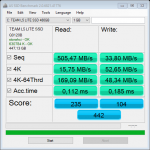

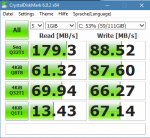

Wie voll die SSD ist, kannst Du den Anhängen entnehmen, CDM zeigt dies nämlich an und was sollte bitten einen Austausch auf Garantie begründen? Wo siehst Du hier einen Defekt oder ein S.M.A.R.T. Attribut welches dies rechtfertigen würde? Was der TE hier sind die Eigenschaften der SSD, die eben keine konstant hohe Schreibrate bietet, wie es bei vielen SSDs mit TLC NAND und sogar bei welchen mit MLC NAND (da gibt es auch welche die Pseudo-SLC als Schreibcache nutzen, z.B. bei Micron Dynamic Write Acceleration genannt und in einigen M600 und MX200 verwendet) und erst recht denen mit QLC NAND der Fall ist. Bei einigen ist dies stärker ausgeprägt als bei anderen und bei den Billig-SSDs darf man nicht erwarten das diese eine besonders tolle Performance in allen Lebenslagen liefern, die sind dazu gemacht billig zu sein und wer sowas kauft, bekommt eine billige SSD, eben genau das was er gekauft hat.

Da sowas nicht in den Datenblättern steht, sondern allenfalls in anständigen und aufwendiger gemachten Reviews erkennbar ist, sollten die Leute die Produkte abseits des Main-Streams kaufen, eben auf solche Reviews mit entsprechenden Tests achten und wenn sie es nicht tun oder, wie meist bei den Billig-SSDs, solche Reviews nicht existieren (dies sollte jedem schon mal als Warnung dienen, wer ein gutes Produkt hat möchte dies auch publik machen), dann muss man eben damit leben dies selbst herausfinden zu müssen, auch wenn es dann eine Enttäuschung ist.

Ein Test mit

TrimCheck kann nicht schaden, aber der TE hat ein Haswell System und ein

Board welches nur die SATA Ports des Z87 Chipsatzes besitzt, auf dem läuft der alter Intel RST vor 9.6 der noch kein TRIM unterstützt hatte, gar nicht und wie man außerdem am Screenshot im ersten Post sieht, ein ausreichend aktuelles Windows welches TRIM unterstützt. Wenn TRIM nicht geht, dann also nur weil es deaktiviert wurde, sonst muss es laufen.