Zu allerst: DPI?

Einige kennen diese Angabe sicherlich aus dem Bereich von Scannern, Druckern und Digitalkameras.

Dort sagt diese Angabe etwas über die Feinheit aus, über die Pixeldichte um genauer zu sein.

Das trifft im Peripheriebereich, speziell der Computermäuse, auch durchaus zu, allerdings wohl nicht so, wie erwartet. Der Sensor, oder sagen wir die Abtasteinheit einer Maus hat in der Tat mit mehr DPI eine feinere Abtastung, wenn man so will, allerdings sind hier ganz andere Aspekte ausschlaggebend.

Betrachten wir unseren Monitor. Was ist das kleinste Bildsegment, was er darstellen kann, bzw. was wir ansteuern können? Ein Pixel. Ganz egal, wie hoch die Auflösung oder wie groß der Monitor ist. Wir arbeiten nicht genauer als im Pixelbereich, da wir ja nichts zwischen zwei Pixeln ansteuern können. Dieses Pixelraster, bei einem 24“ üblicherweise 1920*1200 oder bei einem 22“ 1680*1050, bietet für uns also die Ausgangssituation.

Also was bewirkt dann die Angabe Dots per Inch?

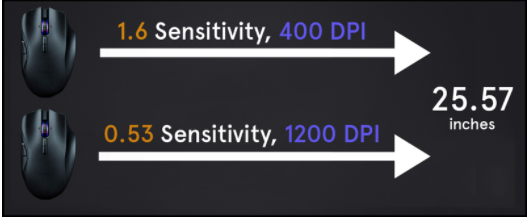

„Dots pro 25,4mm(1 inch)“ beschreibt das Verhältnis zwischen den Pixeln, die der Mauszeiger auf dem Bildschirm zurücklegt für jede 25,4mm Mausbewegung auf dem Mousepad oder Tisch, oder was auch immer. Das heißt im Endeffekt:

Nicht je höher die DPI-Leistung, desto präziser, sondern…

… je höhere die DPI-Leistung, desto mehr Pixel legt der Mauszeiger pro Mausbewegung zurück.

Heißt also im Klartext: Nicht die ansteuerbare Pixeldichte wird genauer, denn die wird vom Monitor respektive von den Windowseinstellungen bestimmt, sondern nur die Geschwindigkeit des Mauszeigers wird höher.

Der Sinn steckt darin, dass sich daraus ein Komfort ergibt. Wenn man die Entwicklung der Perispheriegeräte betrachtet, sind 200DPI oder meinetwegen schon 400DPI für Kugelmäuse damals zu 486er-Zeiten durchaus ausreichend gewesen. Der Grund: Bei einer Arbeitsumgebung von 640*480 oder 800*600 ist die gefühlte Strecke im letzten Fall nicht kleiner als bei 1680*1050 mit einer 800DPI-Maus beispielsweise. Mit steigender Auflösung machen Mäuse mit mehr DPI-Leistung also durchaus Sinn.

Welchen Sinn hat dann die Mauszeigergeschwindigkeit in Windows oder im Maustreiber?

Was machen Windows oder der entsprechende Treiber eigentlich, wenn man die Zeigergeschwindigkeit erhöht oder senkt?

Die einen könnten ja auf die kluge Idee kommen und sagen, es sei ja alles nur Marketing. Ich kann doch einfach die Sensitivity erhöhen und schon habe ich meine höhere Geschwindigkeit. Andersrum gibt es Leute, die festgestellt haben, dass ihnen beispielsweise 2000DPI zu schnell sind. Aber auf „Präzision“ verzichten will auch niemand, also wird stattdessen die Sensitivity in Windows gesenkt oder in beiden Fällen mit mit Beschleunigung gearbeitet.

In beiden Fällen ist das Resultat identisch: Es ist nahezu sinnlos. Hierzu muss man wissen, was die Sensitivity in Windows oder im Treiber genau macht. Angenommen, meine Maus hat 1600DPI, was mittlerweile zum gängigen Standard avancierte. Ich gehe also hin und senke die Geschwindigkeit in Windows um die Hälfte, also ungefähr ein Viertel des gesamten Schiebereglers.

Soweit so gut, die Maus wird langsamer, aber was ist passiert? Das Verhältnis zwischen zurückgelegter Strecke mit der Maus und der Zeigergeschwindigkeit auf dem Bildschirm hat sich geändert. Wir arbeiten aber immer noch pixelgenau. Wie kann es sein, dass ich dann bei 1600DPI die Maus 50,8 statt 25,4mm bewegen muss?

Die Antwort kann nur lauten: Es kann nicht sein. Und es ist auch nicht so.

Wir bewegen die Maus mit 1600DPI also einen Inch, also 25,4mm von links nach rechts über das Pad.

Der Zeiger sollte sich jetzt bei Defaultsettings und einem 22“ mit nativer Auflösung von 1680*1050 von der linken Monitorseite zur Rechten bewegen (natürlich mit 80Pixeln weniger). Ganz klar, die Maus hat 1600DPI. Also 1600Pixel pro bewegten 25,4mm.

Wie kann es dann sein, dass ich mit 1600DPI und halbierter Windows-Sensitivity die Maus 50,8mm bewegen muss?

Die Schieberregler für Zeigergeschwindigkeit lassen bei einer Senkung der Geschwindigkeit Signale, sprich Bewegungsinformationen, weg oder um evtl. genauer zu sein: Windows hat eine Art Delay, welches dann wartet, bis der Bewegungscount voll ist. Angenommen, die Maus sendet 1600 Signale an Windows. Windows sagt dann, das ist schön, aber zu viel des Guten. Der Anwender will um die Hälfte weniger. Also lässt Windows oder der entsprechende Treiber die Hälfte der Signale einfach weg, bzw. ein Bewegungscount will dann mit der doppelten Menge an Signaldaten gefüttert werden, bis sich der Zeiger dazu entschließt, sich zu bewegen.

Daraus folgt, dass der Schieberregler in Windows auf ca. 1/4-Stelleung (Mitte, also 6 von 11 oder 1/2 ist default) das Verhältnis auf 800 statt 1600 gedrosselt hat.

Umgekehrt verhält es sich bei einer Erhöhung. 1600 Signale erreichen Windows und selbiges denkt sich… Hm, was mach ich jetzt? Das ist zu wenig! Der Anwender will aber mindestens das Doppelte an Speed! Die Maus sagt: Pech, ich kann nicht mehr.

Windows geht also hin und improvisiert. Die Signale werden gestreckt, wie man Saft mit Wasser streckt um das Glas vollzubekommen. Nur Saft schmeckt dann verdünnt und nicht so intensiv. Genau ist es auch mit den Signaldaten. Das Resultat:

Bei jeder Bewegung wird ein Pixel übersprungen. Zwei Pixel statt einem Pixel pro Bewegungscount bedeutet natürlich, dass sich die Geschwindigkeit verdoppelt und sich das Verhältnis von 1600DPI auf 3200DPI erhöht. Bei diesem Vorgang arbeiten wir logischerweise nicht mehr Pixelgenau.

Beschleunigung macht nichts anderes. Verlangsamt oder fügt Bewegungssignale hinzu hinzu. Und das auch noch unlinear, je nach Beschleunigung des Mauskörpers respektive der abtastenden Einheit!

Jedoch kann man so ein wenig tricksen. Da Windows bei der Verlangsamung mit Delays arbeitet, kann man mit erhöhter Sensitivity und aktivierter Beschleunigung trotzdem bis zu einem bestimmten Punkt Pixelgenau arbeiten. Natürlich ist dann die Präzision bei hoher Geschwindigkeit traurig. Muss man eben abwägen, ob man diesen Weg geht. Ein Pixel daneben kann das Treffen eines Buttons negieren, dessen sollte sich jeder bewusst sein.

Was heißt das jetzt für den Endanwender? Wieviel DPI brauche ich?

Nicht zu wenig! Die DPI-Leistung der Maus ist egal, solange sie nicht zu wenig hat. Senken kann man immer. Draufpacken geht nur mit Verlust an Pixelgenauigkeit. Das ist das Wichtigste, was es zu beachten gilt.