- Registriert

- März 2001

- Beiträge

- 8.787

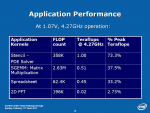

Intels Forschungsabteilung hat mit dem Ziel die Rechenleistung eines Supercomputers auf einen Chip zu packen einen Prozessor mit insgesamt 80 Rechenkernen mit dem Codenamen Polaris entwickelt. Er erreicht eine Rechenleistung von einer Billion Fließkommaoperationen pro Sekunde (Teraflops).

Zur News: Intel Polaris: 80 Kerne, 1 Teraflop bei 62 Watt

Zur News: Intel Polaris: 80 Kerne, 1 Teraflop bei 62 Watt