C

C0rteX

Gast

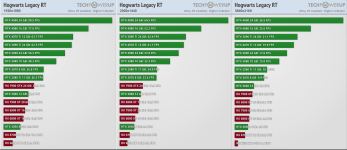

Okay, du hast weder richtig gelesen, noch verstanden. Ich kritisierere AMD in meinem Beitrag davor und es wird als Bauch streicheln bezeichnet. Ich beziehe mich auf Aussagen von etablierten Quellen und andere nennen es Quark. Nobel geht die Welt zu Grunde. 😂

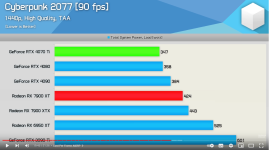

Das du ernsthaft auf den 19 fps ohne upscaling herum reitest, obwohl die Nvidia Karten da genauso schlecht abschneiden, definiert deine Objektivität. Auf Argumente wird gar nicht eingegangen und realistische Vergleiche werden gar nicht erst betrachtet.

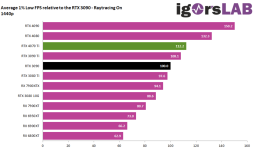

Ist auch völlig egal was wir glauben. Für mich zählen nur möglichst unabhängige etablierte Quellen. Die sprechen da eine eindeutige Sprache, die ich bereits dargelegt habe.

Das du ernsthaft auf den 19 fps ohne upscaling herum reitest, obwohl die Nvidia Karten da genauso schlecht abschneiden, definiert deine Objektivität. Auf Argumente wird gar nicht eingegangen und realistische Vergleiche werden gar nicht erst betrachtet.

Ist auch völlig egal was wir glauben. Für mich zählen nur möglichst unabhängige etablierte Quellen. Die sprechen da eine eindeutige Sprache, die ich bereits dargelegt habe.

Zuletzt bearbeitet von einem Moderator: