BunkerKillar

Cadet 3rd Year

- Registriert

- Dez. 2016

- Beiträge

- 56

Hallo ich möchte in den nächsten Wochen, vermutlich Anfang März mein PC Upgraden

Will mein Ryzen 3700x gegen ein 5800X3D aufrüsten und auch meine GTX 1070 in Rente schicken.

Mein Budget für die GPU wären so 700€ - 900€

Dabei schwanke ich zwischen der 4070ti und der 7900xt weil es die einzigen die dreistellig kosten.

Im moment zocke ich noch auf 1080p @144Hz möchte aber auch mein Monitor gegen Sommer für 1440p @165Hz - 240Hz ersetzen.

Zocke auch öfters auf einem 4k TV

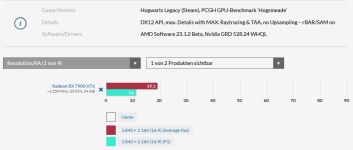

Die 7900xt liefert mehr FPS und mehr Speicher, sollen aber Spulenfiepen haben, sind schlechter in Raytracing und AMD hat schlechte Treiber

Die 4070ti ist besser bei Raytracing, Verbraucht weniger Strom und hat bessere Treiber, dafür weniger Speicher und langsamer als AMD

Welche GPU sollte ich mir holen? und welches Custom design?

Mein Bauch tendiert zu AMD, fürchte mich aber vor Coil Whine

Meine Specs:

Ryzen 3700x

Gigabyte X570 Aourus Pro

32GB Crucial Ballistix 3200Mhz OC auf 3600Mhz

Be Quiet Straight Power 750W

Samsung 970 Evo Plus SSD`s

Be Quiet Dark Base 700

Be Quiet Dark Rock Pro 4

Will mein Ryzen 3700x gegen ein 5800X3D aufrüsten und auch meine GTX 1070 in Rente schicken.

Mein Budget für die GPU wären so 700€ - 900€

Dabei schwanke ich zwischen der 4070ti und der 7900xt weil es die einzigen die dreistellig kosten.

Im moment zocke ich noch auf 1080p @144Hz möchte aber auch mein Monitor gegen Sommer für 1440p @165Hz - 240Hz ersetzen.

Zocke auch öfters auf einem 4k TV

Die 7900xt liefert mehr FPS und mehr Speicher, sollen aber Spulenfiepen haben, sind schlechter in Raytracing und AMD hat schlechte Treiber

Die 4070ti ist besser bei Raytracing, Verbraucht weniger Strom und hat bessere Treiber, dafür weniger Speicher und langsamer als AMD

Welche GPU sollte ich mir holen? und welches Custom design?

Mein Bauch tendiert zu AMD, fürchte mich aber vor Coil Whine

Meine Specs:

Ryzen 3700x

Gigabyte X570 Aourus Pro

32GB Crucial Ballistix 3200Mhz OC auf 3600Mhz

Be Quiet Straight Power 750W

Samsung 970 Evo Plus SSD`s

Be Quiet Dark Base 700

Be Quiet Dark Rock Pro 4