N

nein danke

Gast

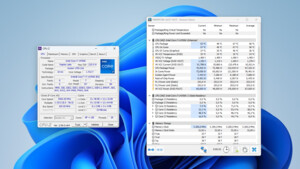

Williams87 schrieb:Also tomshardware sagt was ganz anderes zur Leistungsaufnahmen:

http://www.tomshardware.de/fx-8350-vishera-review-Benchmarks-Test,testberichte-241128-17.html

Gruß

nach dem test des verbrauchs habe ich genau nach solchen kommentaren gesucht. laut cb-test sind es 51 W unterschied zum phenom 2 X6 und 62 W unterschied zum X4 - ein sehr unrealistisch erscheinendes ergebnis. entweder ist mit den tests etwas nicht in ordnung oder die 125 W cpus von amd verbrauchen plötzlich 60 W mehr strom. so oder so müsste der autor sich mit dem ergebnis sehr kritisch auseinander setzen, was jedoch nicht geschieht. die tests von tomshardware deuten nun darauf, dass cb falsche oder irreführende ergebnisse liefert.

neo-bahamuth schrieb:Keines dieser Spiele hat es bisher jemals geschafft, meinen X6 auch nur annähernd an 100% Last zu bringen. Und die Spiele haben natürlich ein Grafikkartenlimit, nämlich das der Karte selber. Wenn da kein SLI-Gespann werkelt bringen die selten die CPUs zur vollen Last.

Und deine willkürlich geschätzten Zahlen zur FPS-Limitierung lasse ich mal komplett außen vor.

spielst du denn spiele, welche 6 kerne nutzen? wenn nicht, dann kannst du eine 100 %-ige auslastung logischerweise auch nicht erwarten. dann laufen eben 2 kerne am maximum und der rest im idle.